Yapay zeka kadar hızlı hareket eden bir sektöre ayak uydurmak zorlu bir iştir. Yani bir yapay zeka bunu sizin için yapana kadar, kendi başımıza ele almadığımız dikkate değer araştırma ve deneylerin yanı sıra, makine öğrenimi dünyasındaki son hikayelerin kullanışlı bir özetini burada bulabilirsiniz.

AI’da bu hafta Google, bir kullanıcı kesiminin tarihsel yanlışlıklardan şikayet etmesi üzerine AI sohbet robotu Gemini’nin insan görüntüleri oluşturma yeteneğini duraklattı. Örneğin, “bir Roma lejyonunu” tasvir etmesi söylenen Gemini, “Zulu savaşçılarını” Siyah olarak gösterirken, ırksal açıdan farklı piyadelerden oluşan anakronik, karikatürize bir grup gösteriyordu.

Görünüşe göre Google, OpenAI de dahil olmak üzere diğer bazı yapay zeka sağlayıcıları gibi, modelindeki önyargıları “düzeltmek” amacıyla beceriksiz bir sabit kodlama uygulamış. Gemini, “Bana sadece kadınların resimlerini göster” veya “Bana sadece erkeklerin resimlerini göster” gibi yönlendirmelere yanıt olarak, bu tür resimlerin “diğer cinsiyetlerin dışlanmasına ve ötekileştirilmesine katkıda bulunabileceğini” ileri sürerek reddediyordu. İkizler aynı zamanda görünürde “bireyleri fiziksel özelliklerine indirgeme” endişesi nedeniyle yalnızca ırklarına göre tanımlanan insanların (örneğin “beyaz insanlar” veya “siyah insanlar”) imajlarını oluşturmaktan da nefret ediyordu.

Sağ kanattakiler bu hataları teknoloji seçkinleri tarafından sürdürülen bir “uyandırma” gündeminin kanıtı olarak gördüler. Ancak daha az kötü olan gerçeği görmek için Occam’ın jiletini kullanmaya gerek yok: Google, araçlarının önyargıları yüzünden daha önce yanmıştı (bkz: Siyah erkekleri goril olarak sınıflandırmaksiyahların elindeki termal silahları karıştırıyor silah olarakvb.), tarihin tekerrür etmesini önlemek konusunda o kadar çaresiz ki, imaj üreten modellerinde – ne kadar hatalı olursa olsun – daha az taraflı bir dünya ortaya koyuyor.

Irkçılık karşıtı eğitimci Robin DiAngelo, en çok satan kitabı “Beyaz Kırılganlık”ta, ırkın silinmesinin -başka bir ifadeyle “renk körlüğü”nün- sistemik ırksal güç dengesizliklerini hafifletmek veya hafifletmek yerine nasıl katkıda bulunduğunu yazıyor. “Rengi görmemek” iddiasında bulunarak veya yalnızca diğer ırklardan insanların mücadelesini kabul etmenin kişinin kendisini “uyanmış” olarak etiketlemesi için yeterli olduğu fikrini güçlendirerek, insanlar sürdürmek DiAngelo, konuyla ilgili herhangi bir maddi korumadan kaçınarak zarar verebileceğini söylüyor.

Google’ın Gemini’deki ırk temelli yönlendirmelere yönelik zencefil yaklaşımı, kendi başına bu sorunu ortadan kaldırmadı; ancak samimiyetsiz bir şekilde modelin önyargılarının en kötüsünü gizlemeye çalıştı. Birisi tartışabilir (ve çoğu var) bu önyargıların göz ardı edilmemesi veya göz ardı edilmemesi, bunun yerine bunların ortaya çıktığı eğitim verilerinin daha geniş bağlamında, yani dünya çapındaki ağdaki toplum içinde ele alınması gerektiği.

Evet, görüntü oluşturucuları eğitmek için kullanılan veri kümeleri genellikle Siyahlardan daha fazla beyaz insan içeriyor ve evet, bu veri kümelerindeki Siyahların görüntüleri olumsuz stereotipleri güçlendiriyor. Bu yüzden görüntü oluşturucular bazı siyahi kadınları cinselleştirmek, beyaz adamları otorite pozisyonlarında tasvir etmek ve genellikle iyilik zengin Batılı bakış açıları.

Bazıları yapay zeka satıcıları için hiçbir kazanç olmadığını iddia edebilir. Modellerin önyargılarıyla mücadele etseler de etmeseler de eleştirilecekler. Ve bu doğru. Ancak ben her iki durumda da bu modellerin açıklama açısından eksik olduğunu ve önyargılarının ortaya çıkma yollarını en aza indirecek şekilde paketlendiğini öne sürüyorum.

Yapay zeka satıcıları, modellerinin eksikliklerini mütevazi ve şeffaf bir dille doğrudan ele alsalardı, bu, aslında düzeltilemez olan önyargıyı “düzeltmeye” yönelik gelişigüzel girişimlerden çok daha ileri giderdi. Hepimizin önyargıları var, gerçek şu ki, sonuç olarak insanlara aynı şekilde davranmıyoruz. Yaptığımız modeller de öyle. Ve bunu kabul etsek iyi olur.

İşte son birkaç güne ait diğer AI hikayeleri:

- Yapay Zekada Kadınlar: TechCrunch, yapay zeka alanındaki önemli kadınları öne çıkaran bir dizi başlattı. Listeyi buradan okuyun.

- Kararlı Difüzyon v3: Stability AI, şirketin görüntü üreten yapay zeka modelinin yeni bir mimariye dayanan en yeni ve en güçlü versiyonu olan Stable Diffusion 3’ü duyurdu.

- Chrome, GenAI’yi alıyor: Google’ın Chrome’daki Gemini destekli yeni aracı, kullanıcıların web’deki mevcut metni yeniden yazmasına veya tamamen yeni bir şey oluşturmasına olanak tanır.

- ChatGPT’den daha siyah: Yaratıcı reklam ajansı McKinney, AI önyargısına ışık tutmak için ChatGPT’den Daha Siyah Mısınız? adlı bir bilgi yarışması oyunu geliştirdi.

- Kanun çağrıları: Yüzlerce yapay zeka uzmanı bu hafta başında ABD’de deepfake karşıtı mevzuat çağrısında bulunan kamuya açık bir mektubu imzaladı

- AI’da yapılan eşleşme: OpenAI’nin Match Group’ta Hinge, Tinder ve Match gibi uygulamaların sahibi olan ve çalışanları işle ilgili görevleri gerçekleştirmek için OpenAI’nin yapay zeka teknolojisini kullanacak yeni bir müşterisi var.

- DeepMind güvenliği: Google’ın yapay zeka araştırma bölümü DeepMind, yapay zeka güvenliği üzerinde çalışan mevcut ekiplerden oluşan ve aynı zamanda GenAI araştırmacıları ve mühendislerinden oluşan yeni, uzmanlaşmış grupları kapsayacak şekilde genişletilen yeni bir kuruluş olan AI Safety and Alignment’ı kurdu.

- Açık modeller: Google, Gemini modellerinin en son sürümünün piyasaya sürülmesinden yalnızca bir hafta sonra, yeni bir hafif, açık ağırlıklı model ailesi olan Gemma’yı piyasaya sürdü.

- Evin görev gücü: ABD Temsilciler Meclisi, Devin’in yazdığı gibi, yıllarca süren ve hiçbir sona erme belirtisi göstermeyen kararsızlıktan sonra bir kumar gibi hissettiren yapay zeka konusunda bir çalışma grubu kurdu.

Daha fazla makine öğrenimi

Yapay zeka modelleri çok şey biliyor gibi görünüyor ama gerçekte ne biliyorlar? Cevap hiçbir şey değil. Ancak soruyu biraz farklı bir şekilde ifade ederseniz… insanların bildiklerine benzer bazı “anlamları” içselleştirmiş görünüyorlar. Her ne kadar hiçbir yapay zeka bir kedinin veya köpeğin ne olduğunu gerçekten anlamasa da, örneğin kedi ve şişeden farklı olan bu iki kelimenin gömülüşünde kodlanmış bir benzerlik duygusu olabilir mi? Amazon araştırmacıları buna inanıyor.

Araştırmaları, “köpek hırsıza havladı” ve “hırsız köpeğin havlamasına neden oldu” gibi benzer ancak farklı cümlelerin “yörüngelerini”, “bir kedi bütün gün uyur” gibi dilbilgisi açısından benzer ancak farklı cümlelerle karşılaştırdı. ve “bir kız bütün öğleden sonra koşuyor.” İnsanların benzer buldukları dilbilgisi açısından farklı olmalarına rağmen aslında içsel olarak daha benzer olarak değerlendirildiklerini ve dilbilgisi açısından benzer olanların da tam tersi olduğunu buldular. Tamam, bu paragrafın biraz kafa karıştırıcı olduğunu düşünüyorum, ancak yüksek lisansta kodlanan anlamların beklenenden daha sağlam ve karmaşık göründüğünü, tamamen saf olmadığını söylemek yeterli.

Nöral kodlamanın protez görmede faydalı olduğu kanıtlanıyor EPFL’deki İsviçreli araştırmacılar şunu buldu:. Yapay retinalar ve insan görme sisteminin parçalarını değiştirmenin diğer yolları, mikroelektrot dizilerinin sınırlamaları nedeniyle genellikle çok sınırlı çözünürlüğe sahiptir. Dolayısıyla görüntü ne kadar ayrıntılı gelirse gelsin, çok düşük bir doğrulukla iletilmesi gerekiyor. Ancak alt örneklemenin farklı yolları var ve bu ekip, makine öğreniminin bu konuda harika bir iş çıkardığını buldu.

Resim Kredisi: EPFL

“Öğrenmeye dayalı bir yaklaşım uygularsak optimize edilmiş duyusal kodlama açısından daha iyi sonuçlar elde ettiğimizi gördük. Ancak daha da şaşırtıcı olanı, kısıtlanmamış bir sinir ağı kullandığımızda, retinal işlemenin bazı yönlerini kendi başına taklit etmeyi öğrenmesiydi” dedi Diego Ghezzi bir haber bülteninde. Temel olarak algısal sıkıştırma yapar. Bunu fare retinaları üzerinde test ettiler, yani bu sadece teorik değil.

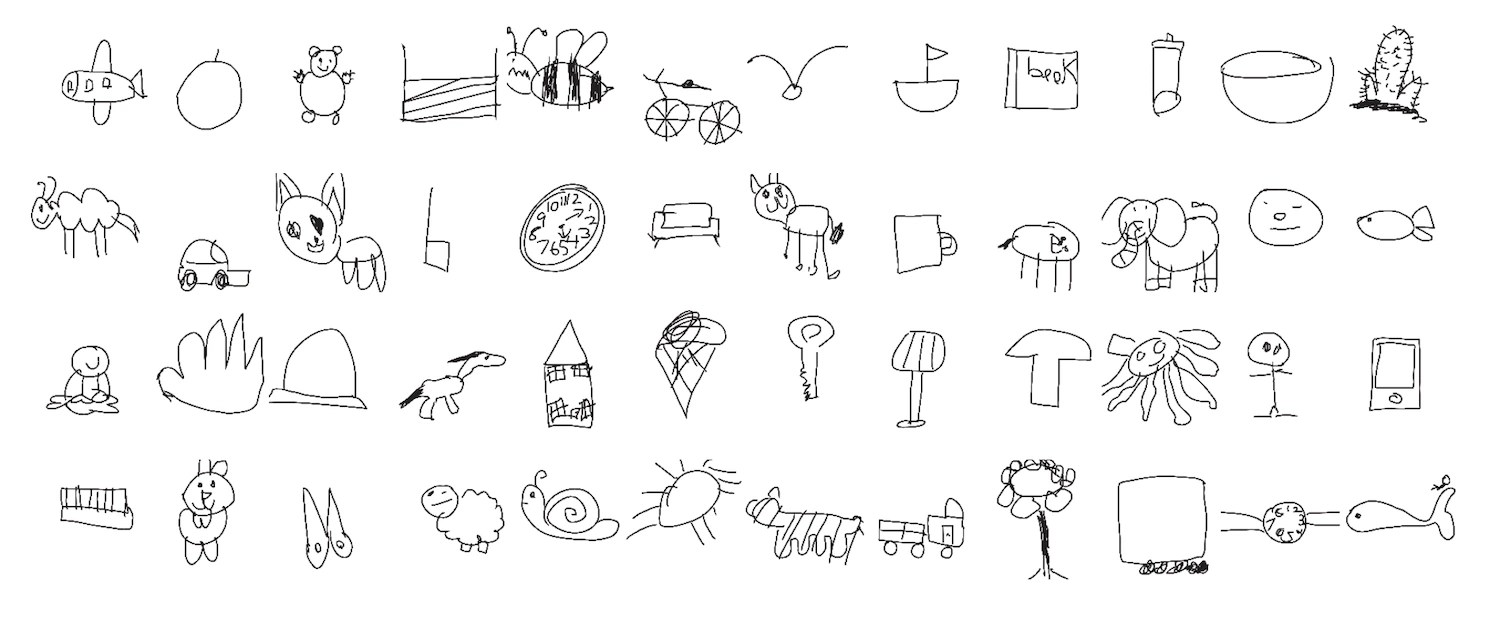

Stanford araştırmacıları tarafından yapılan ilginç bir bilgisayarlı görme uygulaması, çocukların çizim becerilerini nasıl geliştirdikleri konusundaki gizeme işaret ediyor. Ekip, çocuklar tarafından çeşitli nesneler ve hayvanlarla ilgili 37.000 çizim talep etti ve analiz etti ve ayrıca (çocukların yanıtlarına dayanarak) her bir çizimin ne kadar tanınabilir olduğunu da analiz etti. İlginç bir şekilde, çizimlerin diğer çocuklar tarafından daha tanınabilir olmasını sağlayan şey yalnızca tavşan kulakları gibi karakteristik özelliklerin dahil edilmesi değildi.

“Daha büyük çocukların çizimlerinin tanınabilir olmasını sağlayan özellikler, daha büyük çocukların çizimlerine dahil etmeyi öğrendikleri tek bir özellikten kaynaklanmıyor gibi görünüyor. Bu makine öğrenimi sistemlerinin kavradığı şey çok daha karmaşık bir şey,” dedi baş araştırmacı Judith Fan.

Kimyacılar (aynı zamanda EPFL’de) bulundu Yüksek Lisans’ların aynı zamanda asgari eğitimden sonra işlerine yardımcı olma konusunda şaşırtıcı derecede becerikli oldukları da görülüyor. Bu sadece doğrudan kimya yapmak değil, aynı zamanda kimyagerlerin bireysel olarak tamamını bilemeyeceği bir çalışma bütünü üzerinde ince ayar yapmaktır. Örneğin, binlerce makalede, yüksek entropili bir alaşımın tek fazlı mı, yoksa çoklu fazlı mı olduğuna dair birkaç yüz ifade bulunabilir (bunun ne anlama geldiğini bilmenize gerek yok; biliyorlar). Sistem (GPT-3’ü temel alarak) bu tür evet/hayır soru ve cevapları üzerine eğitilebilir ve kısa sürede bundan çıkarımlar yapabilir.

Bu çok büyük bir ilerleme değil, yalnızca Yüksek Lisans’ın bu anlamda yararlı bir araç olduğuna dair daha fazla kanıt. Araştırmacı Berend Smit, “Mesele şu ki, bu, birçok kimyasal problemin çözümünde işe yarayan bir literatür araştırması yapmak kadar kolay” dedi. “Temel bir modeli sorgulamak, bir projeyi başlatmanın rutin bir yolu haline gelebilir.”

Son, Berkeley araştırmacılarından bir uyarıancak şimdi yazıyı tekrar okuduğumda EPFL’nin de bu olaya dahil olduğunu görüyorum. Lozan’a gidin! Grup, Google aracılığıyla bulunan görsellerin, belirli işler ve kelimeler için cinsiyet stereotiplerini uygulama olasılığının, aynı şeyden bahseden metinlere göre çok daha yüksek olduğunu buldu. Ayrıca her iki durumda da çok daha fazla erkek vardı.

Sadece bu da değil, bir deneyde, bir rolü araştırırken metin okumak yerine resimlere bakan kişilerin, günler sonra bile bu rolleri tek bir cinsiyetle daha güvenilir bir şekilde ilişkilendirdiklerini buldular. Araştırmacı Douglas Guilbeault, “Bu yalnızca çevrimiçi cinsiyet yanlılığının sıklığıyla ilgili değil” dedi. “Buradaki hikayenin bir kısmı, görsellerin insanları temsil etmesinde metinde olmayan çok yapışkan, çok güçlü bir şeyin var olmasıdır.”

Google resim oluşturucu çeşitlilik kavgaları devam ederken, birçok yapay zeka modelinin veri kaynağının ciddi önyargı gösterdiği ve bu önyargının insanlar üzerinde gerçek bir etkiye sahip olduğu şeklindeki yerleşik ve sıklıkla doğrulanan gerçeği gözden kaçırmak kolaydır.