Bana istediğini sor. Bir AMA’nın uzun biçimi ve Reddit’teki en popüler etkileşimli söylem biçimlerinden biridir. Microsoft’un “yeni Bing” olarak da bilinen Bing AI sohbet robotu hızla öğrendiğinden, bu aynı zamanda büyük bir zorluktur.

Ne zaman bir ünlü ya da kayda değer bir Reddit AMA’ya kaydolursa, genellikle soruları yanıtlayanın gerçekten onlar olduğunu kanıtlamak için bir fotoğrafla poz verdikten kısa bir süre sonra, derin bir korku anı yaşanır.

Herhangi birine herhangi bir şey sorma yeteneği, genellikle soruları alan ve filtreleyen canlı bir topluluk yöneticisi tarafından yönetilen uygunsuz söylemlerin bir mayın tarlasıdır. Aksi takdirde, işler hızla raydan çıkar. Bu koruma olmasa bile, zaten sık sık yaparlar (yeni sekmede açılır).

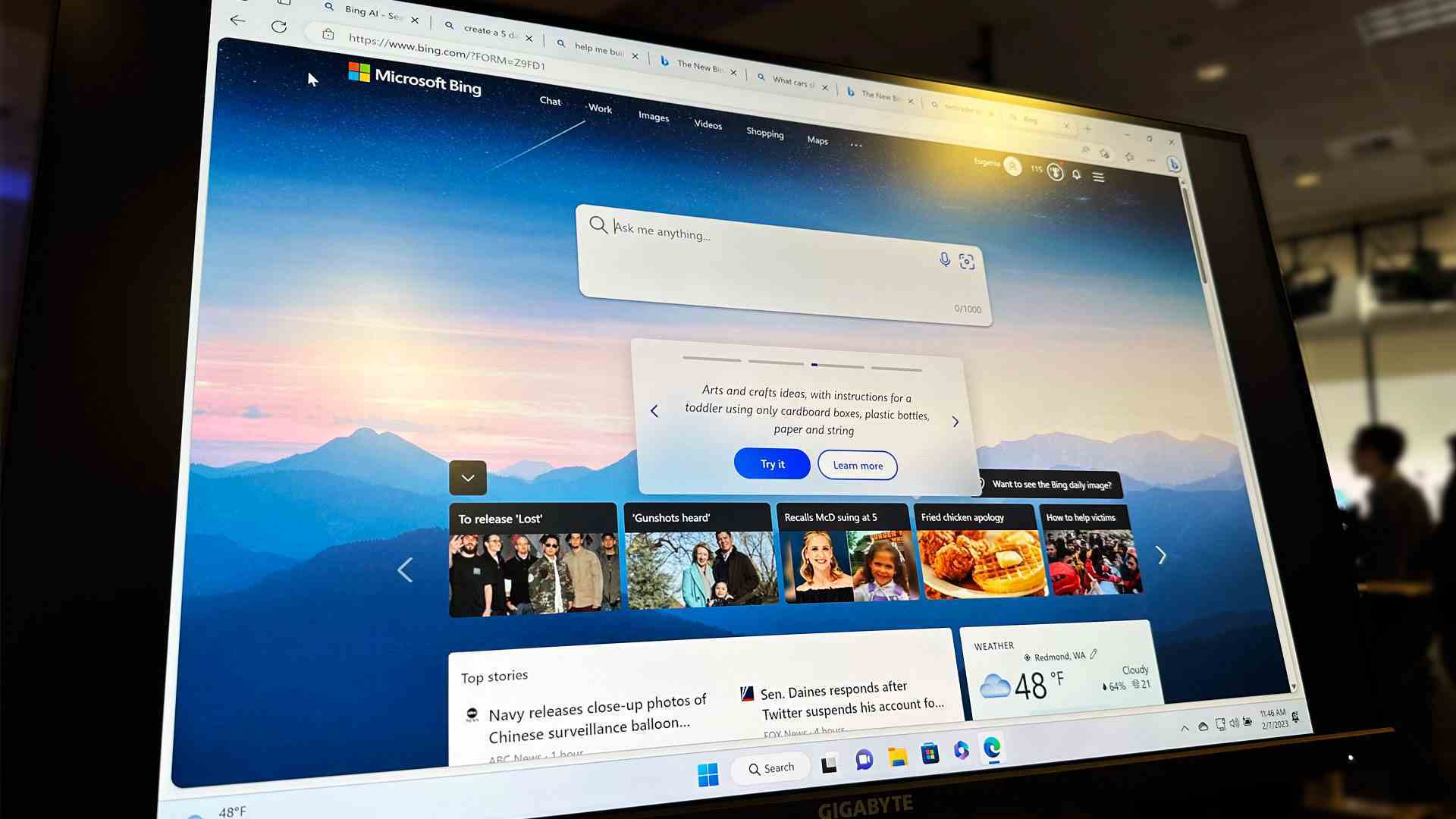

Microsoft, Bing AI destekli yeni sohbetini başlattığında, ChatGPT AI’nın her türlü soru için hazır olduğunu açıkça belirtti. Bu, ya nispeten küçük ama büyüyen kullanıcı grubuna duyulan derin bir güvenin işareti ya da inanılmaz bir saflıktı.

Orijinal yapay zeka sohbet robotu hissini başlatan ve Bing’in sohbetinin dayandığı ChatGPT bile bu istemi sunmuyor. Bunun yerine, ekranın altında boş bir metin giriş kutusu bulunur. Yukarıda örnek soruların, yeteneklerin ve en önemlisi sınırlamaların bir listesi bulunmaktadır.

Bing’de bu önde gelen bilgi istemi ve onun altında örnek bir soru artı başka bir düğmenin yanında sizden “Daha Fazla Bilgi Edinin”i isteyen büyük bir “Dene” düğmesi vardır. Bununla kahretsin. Hemen içeri girmeyi ve Bing’in talimatlarını izleyerek ona her şeyi sormayı seviyoruz.

Doğal olarak Bing, seyahat, yemek tarifleri ve iş planları gibi günlük ihtiyaçlarla hiçbir ilgisi olmayan pek çok soru da dahil olmak üzere çok çeşitli sorularla doludur. Ve bunlar hepimizin bahsettiği şeyler çünkü, her zaman olduğu gibi, “herhangi bir şey” istemek, “sormak” anlamına gelir. herhangi bir şey.”

Bing aşk, seks, ölüm, evlilik, boşanma, şiddet, düşmanlar, iftira ve sahip olmadığında ısrar ettiği duygular hakkında kafa yoruyor.

OpenAI’nin ChatGPT’sinde, ana ekran şu uyarıda bulunur:

- Bazen yanlış bilgi üretebilir

- Zaman zaman zararlı talimatlar veya taraflı içerik üretebilir

- 2021’den sonraki dünya ve olaylar hakkında sınırlı bilgi

Çok fazla soru

Bing’in Chat GPT’si, OpenAI’den biraz farklıdır ve tüm bu sınırlamalarla karşılaşmayabilir. Özellikle dünya olaylarının bilgisi, Bing’in bilgi grafiğinin entegrasyonu sayesinde günümüze kadar uzanabilir.

Ancak Bing vahşi doğada veya giderek daha vahşi hale geldiğinde, insanları ona herhangi bir şey sormaya teşvik etmek bir hata olmuş olabilir.

Ya Microsoft, Bing AI Chat’i farklı bir istemle oluştursaydı:

bana bazı şeyler sor

Bana bir soru sorun

Ne bilmek istiyorsun?

Bu biraz değiştirilmiş istemlerle Microsoft, Bing AI Chat’in ne dediğini bilmediğine dair uzun bir uyarı listesi ekleyebilir. Tamam, öyle (bazen (yeni sekmede açılır)), ama bildiğiniz şekilde değil. Duygusal zekası veya tepkisi, hatta ahlaki bir pusulası yoktur. Yani, varmış gibi davranmaya çalışıyor, ama son konuşmalar New York Times (yeni sekmede açılır) ve hatta Tom’un Donanımı (yeni sekmede açılır) iyi insanların temel ahlakına ilişkin kavrayışının en iyi ihtimalle zayıf olduğunu kanıtlıyor.

Bing AI sohbeti ile kendi konuşmalarımda, bana defalarca onun insani duygulara sahip olmadığı ama yine de öyleymiş gibi konuştuğu söylendi.

AI’yı herhangi bir süre takip eden herkes için, meydana gelenlerin hiçbiri şaşırtıcı değil. AI bilir:

- Ne üzerine eğitildi

- Yeni bilgilerden neler öğrenebilir?

- Geniş çevrimiçi veri depolarından neler toplayabilir?

- Gerçek zamanlı etkileşimlerden neler öğrenebilir?

Ancak Bing AI sohbeti, kendisinden önce gelen herhangi bir AI’dan daha bilinçli değildir. Yine de, bir sohbeti sürdürme yeteneği, daha önce deneyimlediğim her şeyin çok üzerinde olduğu için, AI’nın daha iyi oyuncularından biri olabilir. Bu duygu sadece bir konuşmanın uzunluğu ile artar.

Bing AI sohbetinin duyarlı bir insan olarak daha inandırıcı hale geldiğini söylemiyorum, ancak biraz mantıksız veya kafası karışmış bir insan olarak daha inandırıcı hale geliyor. Gerçek insanlarla uzun sohbetler de böyle gidebilir. Bir konu üzerinde başlarsınız ve hatta belki onun hakkında tartışırsınız ama bir noktada, argüman daha az mantıklı ve rasyonel hale gelir. İnsanlar söz konusu olduğunda, duygu devreye giriyor. Bing AI Chat söz konusu olduğunda, liflerin var olduğu ancak yıprandığı bir ipin ucuna ulaşmak gibi. Bing AI, bazı uzun konuşmalar için bilgiye sahiptir, ancak bunları anlamlı bir şekilde bir araya getirecek deneyime sahip değildir.

Bing senin arkadaşın değil

İnsanları “Bana Her Şeyi Sor…” diye teşvik ederek Microsoft, Bing’i başarısız olmasa da bazı önemli büyüme sancıları için ayarladı. Acı, belki Microsoft tarafından ve kesinlikle hiçbir normal arama motorunun yanıtlayamayacağı soruları bilerek soran kişiler tarafından hissediliyor.

Chatbot’ların ortaya çıkmasından önce, Google’ı aşk hayatınızı düzeltmek, Tanrı’yı açıklamak veya vekil bir arkadaş ya da sevgili olmak için kullanmayı düşünür müsünüz? Umarım değildir.

Bing AI Chat daha iyi olacak, ancak Bing’in yanıtından pişman olduğu ve onu ortadan kaldırmaya çalıştığı çok daha rahatsız edici konuşmalar yapmadan önce değil.

Bir yapay zekaya herhangi bir şey sormak uzun vadeli bariz bir hedef ama henüz o noktada değiliz. Microsoft bir sıçrama yaptı ve şimdi sorgulanabilir yanıtlardan oluşan bir ormanda serbest düşüş yaşıyor. Bing AI Sohbeti çok daha akıllı ve daha ihtiyatlı hale gelene veya Microsoft biraz AI yeniden eğitimi için fişi çekene kadar inmeyecek.

Hâlâ Bing’e bir şey sormayı bekliyoruz, bekleme listesindeki en son ayrıntılara sahibiz.