Intel açık kaynak sürümünü yayınladı NPU Hızlandırma KütüphanesiMeteor Lake AI bilgisayarlarının TinyLlama gibi hafif LLM’leri çalıştırmasını sağlıyor. Öncelikle geliştiricilere yöneliktir, ancak biraz kodlama deneyimi olan sıradan kullanıcılar, yapay zeka sohbet robotlarının Meteor Gölü’nde çalışmasını sağlamak için bunu kullanabilir.

Kütüphane artık GitHub’da ve Intel’in NPU Hızlandırma Kütüphanesi hakkında bir blog yazısı yazması gerekse de Intel Yazılım Mimarı Tony Mongkolsmai bunu X’in başlarında paylaştı. Meteor Lake CPU ile donatılmış MSI Prestige 16 AI Evo dizüstü bilgisayarda TinyLlama 1.1B Chat’i çalıştıran yazılımın bir demosunu gösterdi ve ona akıllı telefonların ve kapaklı telefonların artılarını ve eksilerini sordu. Kütüphane hem Windows hem de Linux’ta çalışır.

Soru soran geliştiriciler yeni açık kaynaklı Intel NPU Hızlandırma kitaplığına göz atın. Bunu az önce MSI Prestige 16 AI Evo makinemde denedim (bu sefer Windows, ancak kütüphane Linux’u da destekliyor) ve GitHub belgelerini takip ederek TinyLlama’yı çalıştırabildim… pic.twitter.com/UPMujuKGGT1 Mart 2024

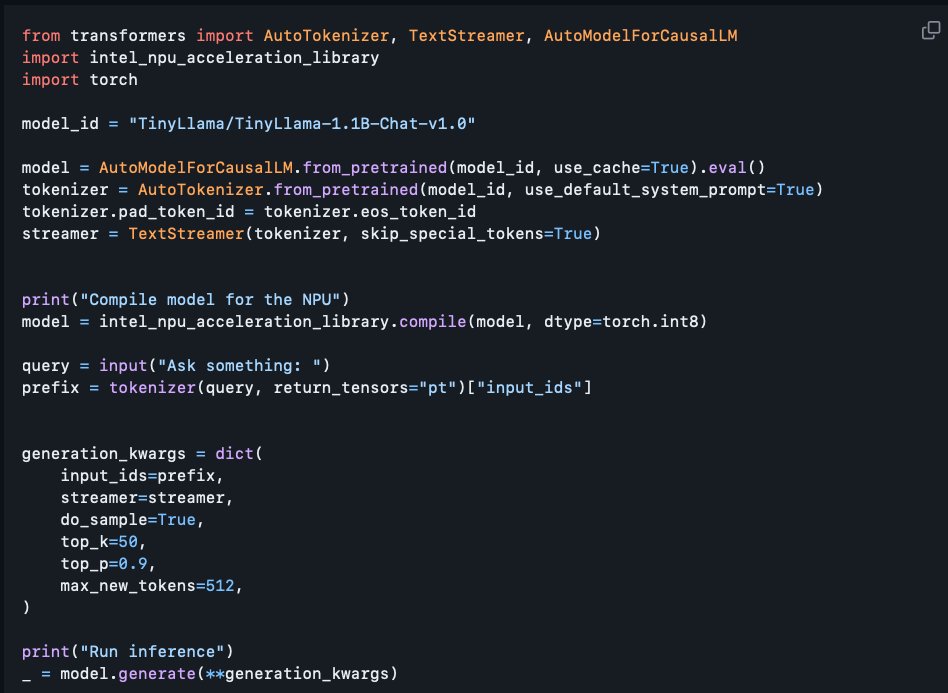

Elbette NPU Hızlandırma Kitaplığı sıradan kullanıcılar için değil geliştiriciler için yapıldığından, onu amaçlarınız doğrultusunda kullanmak basit bir iş değildir. Mongkolsmai, sohbet robotunun çalışmasını sağlamak için yazdığı kodu paylaştı ve aynı şeyin bilgisayarınızda da çalışmasını istiyorsanız, ya Python’u iyi bir şekilde anlamanız ya da yukarıdaki resimde paylaşılan her satırı yeniden yazmanız gerektiğini rahatlıkla söyleyebiliriz. PC’nizde çalışır.

NPU Hızlandırma Kütüphanesi açıkça NPU’lar için yapıldığından, bu şu anda onu yalnızca Meteor Lake’in çalıştırabileceği anlamına gelir. Arrow Lake ve Lunar Lake CPU’ları bu yılın sonlarına doğru piyasaya sürülecek ve uyumlu CPU’ların kapsamını genişletecek. Yaklaşan bu CPU’lar, Meteor Lake’e göre üç kat daha fazla yapay zeka performansı sunuyor ve muhtemelen dizüstü ve masaüstü silikonda daha büyük LLM’lerin çalıştırılmasına olanak tanıyor.

Kitaplık henüz tam özellikli değildir ve planlanan özelliklerinin yalnızca yarısına yakın bir kısmıyla birlikte gönderilmiştir. En önemlisi, NPU’nun kendisinde çalışabilen karma hassas çıkarım, BFloat16 (AI ile ilgili iş yükleri için popüler bir veri formatı) ve NPU-GPU heterojen hesaplamanın eksik olması, muhtemelen her iki işlemcinin de aynı AI görevleri üzerinde çalışmasına izin veriyor. NPU Hızlandırma Kütüphanesi yepyeni olduğundan ne kadar etkili olacağı belli değil, ancak bunun AI PC’ler için bazı yeni AI yazılımlarıyla sonuçlanacağı kesin.