Wall Street, iPhone’lar için zor bir 2024 öngörüyor. Ne için ? Çünkü Apple, heyecan verici yeni donanım özelliklerinin bulunmaması nedeniyle müşterilerin ilgisini yenileyemeyecekti. Peki Apple’ın bir sonraki akıllı telefonlarına yerleştirilen yapay zeka, iPhone 16’yı kurtarabilecek mi?

Analist Morgan Stanley’den Erik Woodring, düşünüyor. 2024 yılının “Apple’ın yapay zeka fırsatının meyvelerini vereceği yıl olacağına” ve bunun, bu sonbaharın yeni nesil iPhone’larını en yüksek seviyelere taşıyabileceğine inanıyor.

Tarafından derlenen tahminlere göre FactSet SistemleriMevcut iPhone 15’in liderliğini yaptığı iPhone satışlarının bu yıl yaklaşık %2 düşüşle 229 milyon adede gerilemesi bekleniyor. Ne için ? Çünkü mevcut iPhone satış döngüsü, yalnızca yinelenen donanım özellikleri üzerinde çalışıyor.

“LLM tarafından desteklenmektedir”

Ancak Woodring, 2025’te Wall Street’in %4 büyümeyle 237 milyon adede ulaşacağına dair mevcut tahmininin, iPhone 16’nın yeni depolama yetenekleriyle (AI) gelmesi durumunda %15 daha yüksek olabileceğini yazıyor. Bay Woodring, “Bir Yüksek Lisans tarafından etkinleştirilen yeni yazılım özellikleri bir yükseltme döngüsünü teşvik ederse, 25 Mali Yıl iPhone sevkıyat tahminimizde %15’lik bir artış görüyoruz” diye yazdı. “LLM” kısaltması, OpenAI’nin GPT-4’ü gibi “büyük dil modellerini” ifade eder.

Bay Woodring, Apple’ın bu yaz “LLM destekli Siri 2.0 ve GenAI işletim sistemine odaklanan Dünya Çapındaki Geliştirici Konferansının iPhone yükseltme döngüsünü hızlandırabileceğini” düşünüyor.

“LLM tarafından desteklenmektedir” ifadesi neden bu kadar önemli? OpenAI’nin GPT-4’ü gibi büyük dil modellerinin kullanılması, bir akıllı telefonun ağda ileri geri hareket etmesini, istemler göndermesini ve yanıtları almasını gerektirir. Ethernet bağlantısı olan bir masaüstü bilgisayarda bile ileri geri gitmek, yanıt almak için bir süre beklemek anlamına gelir. Hücresel ağdaki bir mobil cihazda, bulut bilişim bağlantısına güvenmek, Siri’nin beyin ölümü gibi göründüğü garip anlardan biriyle sonuçlanabilir.

Buluta bağımlılığı ortadan kaldırın

O halde ihtiyaç duyulan şey, buluta olan bağımlılığı ortadan kaldırmak ve LLM işlemlerinin daha fazlasını yerel olarak cihaza taşımaktır. Apple, iPhone’da zaten “sinir motoru” adını verdiği bir şeye sahip. Bu sinir motoru tarafından gerçekleştirilen yapay zeka görevleri (LLM’den çok daha az zorlu görevler) örneğin yüz tanımadır.

Ancak ticari olarak bulunabilen büyük bir dil modelini alıp yerel olarak çalıştırmak çok daha zorlu bir görev olacaktır.

Woodring, heyecanının çoğunu Apple araştırmacıları Keivan Alizadeh ve meslektaşları tarafından bu ay yayınlanan “LLM in a flash: Efficient büyük dil modeli çıkarımı ile sınırlı hafıza” başlıklı bir makaleye dayandırıyor. : sınırlı hafızaya sahip büyük bir dil modelinin verimli çıkarımı) , hangisi arXiv sunucusunda yayınlandı.

Çoğu akıllı telefonda yapay zeka için yeterli DRAM yok

Makale, yüksek lisansların çok fazla bellek kapladığını ve Apple’ın, iPhone’un dosyalarını tutan geniş flash bellek depolama alanını kullanmanın akıllıca bir yolunu bulduğunu belirtiyor. Özel bir yazılımla, bir LLM, akıllı telefondaki tipik durumdan çok daha fazla DRAM’e sahip olduğu yanılsaması ile ana bellek olan DRAM’e kolayca girip çıkarılabilir.

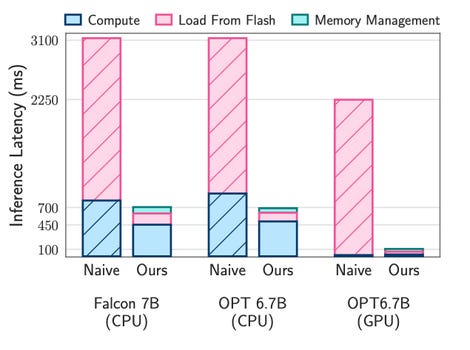

Alizadeh ve meslektaşlarının yazdığına göre, bellekle kullandıkları taktikler “mevcut DRAM boyutunun iki katına kadar olan modelleri çalıştırmanıza olanak tanıyor” ve bir cihazda tahminlerin geliştirilmesini 25 kata kadar hızlandırıyor.

Yazarların uğraştığı sorun, çoğu akıllı telefonda yeterli DRAM bulunmaması ve Yüksek Lisans’ların büyümeye devam etmesidir. Alizadeh ve ekibi şunları yazıyor: “7 milyar parametreli bir model, parametreleri yarı duyarlı kayan nokta formatında yüklemek için 14 GB’tan fazla bellek gerektirir; bu da çoğu ileri teknoloji cihazın yeteneklerinin ötesindedir.” Eğitimli bir sinir ağına şekil veren, hafızada saklanan sinirsel “ağırlıklar” veya “parametreler” değerleri.

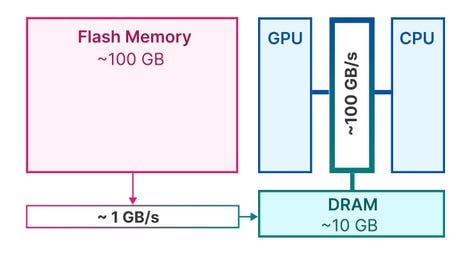

DRAM ve flash bellek arasındaki gecikme

Apple yerleşik DRAM miktarını açıklamıyor ancak Everymac sitesi üçüncü taraf verilerinden alıntı yapıyor bu da iPhone 15 Pro Max’in 8 GB DRAM’e sahip olduğunu gösteriyor. Samsung’un yakın zamanda tanıttığı Galaxy S24 Ultra, 12 GB DRAM’e sahip. Samsung’a göre.

Elbette akıllı telefonlardaki NAND flash depolama çok daha fazla bellek sunuyor. Pro Max’in tıpkı S24 Ultra gibi terabaytlık bir belleği var. En büyük sorun verinin ileri geri akmasıdır. NAND flash belleği DRAM’den daha yavaştır, bu nedenle her seferinde veri getirmek DRAM’in tamamını kullanmaktan daha yavaştır.

Apple, sinir ağını flash bellekte tutma ve yalnızca bir kısmını DRAM’e yerleştirme olasılığını deniyor. Elma

Ek olarak, verilerin flash’tan DRAM’e taşınması, kullanıcının yapmaya çalıştığı şey ile sonuçlar arasında gecikme adı verilen bir gecikmeye neden olan aktarım süresini içerir. Bu, kullanıcının örneğin bir bilgi istemi yazmakla yanıt almak arasında saniyeler beklediği anlamına gelebilir ki bu da buluta gitmek kadar sorunludur. Yazarlar, DRAM’den akıllı telefonun merkezi işlemcisine geçişin bile gecikmeye yol açtığını belirtiyor.

Nöral motorların dağılımı üzerinde oynamak

Çözümleri, yüksek lisans da dahil olmak üzere sinir ağlarının temel bir yönünü kullanmaktan ibarettir: seyreklik. Seyreklik, sinir ağını oluşturan sinir ağırlıklarının çoğunun aslında boş olduğu anlamına gelir. Sayısal değeri sıfırdır. Bu nedenle bunlar göz ardı edilebilir, böylece bir sonuç vermek için yalnızca az sayıda toplam ağırlığın bellekten alınması gerekir.

Alizadeh ve ekibi, “LLM’ler yüksek derecede dağılım sergiliyor” diye yazıyor. “Bu kıtlığı, yalnızca girişi sıfır olmayan veya çıkışının sıfır olmayacağı tahmin edilen flash bellekten parametreleri seçerek yüklemek için kullanıyoruz.”

Yazarlar ayrıca belirlemek için birçok akıllı teknik sunuyorlar. Hangi Bu sıfır olmayan ağırlıkların her biri, örneğin kullanıcının daha sonra tetikleyebileceği tahmin görevine bağlı olarak ihtiyaç duyulması en muhtemel ağırlıklar alınarak flash bellekten çağrılmalıdır.

Pil ömrüyle ilgili büyük soru

Makale, iki açık kaynaklı LLM’yi çalıştırırken çarpıcı hızlanmaları gösteriyor: Açık Önceden Eğitimli Transformatör Meta ve dil modellerinin Şahin Abu Dabi Teknolojik Yenilik Enstitüsü’nden.

Apple, büyük dil modellerini kullanırken gecikmeyi azaltmayı başardı. Elma

Woodring ve diğerlerinin iPhone 16’nın yapay zekaya yönelik bir süper bilgisayar haline gelmesi yönündeki umutları tek bir sorunla karşılaşıyor: Araştırma makalesinde sunulan çalışma bir Mac üzerinde yapıldı. Özellikle Alizadeh ve ekibi tüm tekniklerini Apple’ın yalnızca MacBook Pro ve Apple’ın Studio masaüstü bilgisayarına güç veren “M1 Max” işlemcisi üzerinde geliştirdi. Bu çip, iPhone 15’i donatan “A17 Pro”dan çok daha güçlü.

Ek olarak, yazarların da belirttiği gibi, testleri akıllı telefon kullanıcıları için en önemli hususlardan birini ele almıyor: pil ömrü. “Önerdiğimiz yöntemlerin doğasında olan güç tüketimini ve termal sınırlamaları analiz etmek, özellikle cihaz içi dağıtım için, gelecekte araştırılması gereken kritik bir husustur” diye yazıyorlar.

Çok küçük Yüksek Lisans’lara doğru

Ancak Apple’ın M serisi işlemcisi mobil cihazlarda da yerini çoktan buldu. M1 ve M2 çipleri iPad Pro ve iPad Air tabletlerinde kullanıldı. Bu, Apple’ın çipleri ile Alizadeh ve ekibinin keşfettiği yazılım çalışmaları arasında bir süreklilik olduğu anlamına geliyor.

iPhone 16 Pro Max’teki “A18” işlemcinin, yapay zeka görevlerini yürütmek ile pil ömrünü yönetmek arasında bir denge kurması mümkündür. Makalede tartışılan yaklaşımın başlangıçta LLM’nin çok küçük versiyonlarında kullanılması da mümkündür. Alizadeh’in makalesinde test edilen iki modelin 7 milyar parametresi var, bu da onları Yüksek Lisans’lar için nispeten küçük kılıyor. Apple, enerji tasarrufu sağlamak için bir milyar parametrenin altına inerek daha da küçülebilir Ve hafıza kullanımı Ve CPU kullanımı.

WWDC’de veya Eylül ayında tanıtılan iPhone’dan bağımsız olarak, Alizadeh ve ekibinin araştırmasının yapısının, yapay zekanın buluttan çıkıp er ya da geç cebinize ulaşacağını gösterdiğini varsayabiliriz.

Kaynak : “ZDNet.com”