Soldaki Graviton 4 çipi, diğer şeylerin yanı sıra SAP tarafından büyük iş yükleri için kullanılan genel amaçlı bir mikroişlemci çipidir. Trainium 2 çipi, çok önemli sinir ağlarını eğitmek için tasarlanmış bir hızlandırıcı çiptir. Amazon AWS

re:Invent 2023 (Las Vegas) – Amazon, geliştiricilere yönelik yıllık konferansı sırasında, Salı günü, sinir ağlarını eğitmeye yönelik çipi olan Trainium 2’nin yeni bir versiyonunu duyurdu. Trainium 2, büyük dil modelleri (LLM) ve temel modellerin eğitimi için özel olarak tasarlanmıştır. Bunlar OpenAI’nin GPT-4’ü gibi üretken yapay zeka programlarıdır.

Şirket ayrıca daha genel kullanımlı çipi Graviton 4’ün yeni bir versiyonunu da tanıttı. Şirket ayrıca, bulut bilişim hizmetinde Nvidia’nın en güçlü çiplerini çalıştırmak için Nvidia ile olan ortaklığını genişlettiğini de belirtti.

Trainium 2, milyarlarca milyar parametreye sahip sinir ağlarını yönetmek için tasarlanmıştır. Bu parametreler ağların sinir ağırlıklarıdır. Yapay zeka programının algoritmalarını optimize etmeyi mümkün kılan, aynı zamanda ölçeklenebilirlik ve güç kapasitelerini de garanti eden de bu ağırlıklardır.

“300 milyar parametreli bir yüksek lisans eğitimini birkaç ay yerine birkaç haftada eğitin”

Trilyonlarca parametre, yapay zeka endüstrisi için bir tür takıntı haline geldi. Ne için ? Çünkü insan beyni 100 milyar nöron bağlantısı içeriyor. Ve bu parametre hacmi, milyarlarca milyar parametreli bir sinir ağı programının insan beynine bağlı olduğunu gösteriyor. Bunun doğru olup olmadığı.

Yapay zeka çipleri, 2021’de piyasaya sürülen öncülleri Trainium çiplerine göre “dört kata kadar daha hızlı eğitim performansı ve üç kat daha fazla bellek kapasitesi sunacak şekilde tasarlandı” ve “enerji verimliliğini (performans/watt) iki kata kadar artırıyor, ” dedi Amazon.

Amazon, çipleri “Trn2” bulut sunucuları adı verilen EC2 bulut hizmetinin bulut sunucularında kullanılabilir hale getiriyor. Amazon’a göre bulut sunucusu, uyum içinde çalışan ve 100.000 bulut sunucusuna ölçeklendirilebilen 16 Trainium 2 çipi içeriyor. Bu daha büyük örnekler, toplam 65 exaFLOP bilgi işlem gücü sağlayabilen Elastic Fabric Adapter ağ sistemi kullanılarak birbirine bağlanır. (Bir exaFLOP saniyede bir milyar milyar kayan nokta işlemine karşılık gelir).

Amazon, bu hesaplama ölçeğinde “müşterilerin 300 milyar parametreden oluşan bir LLM’yi aylar yerine haftalar içinde eğitebileceğini” söyledi.

Graviton 4: %30 daha yüksek bilgi işlem performansı

AWS, bu altyapı tasarımı çalışmasına 4 milyar dolar yatırım yaptığı startup Anthropic ile birlikte devam ediyor. Kurucularının OpenAI ile transfer yaptığı bir startup. Ve bu yatırım Amazon’u Microsoft/OpenAI ittifakıyla rekabet edebilecek konuma getiriyor.

Yine Salı günü duyurulan Graviton 4 çipi ARM tasarımına dayanıyor ve eski x86 standardını temel alan Intel ve Advanced Micro Devices işlemcileriyle rekabet ediyor. Amazon, Graviton 4’ün 2021’de piyasaya sürülecek olan önceki nesil Graviton 3’e göre %30 daha yüksek bilgi işlem performansı sunduğunu söyledi.

Yapay zeka eğitimine yönelik Trainium çiplerinin aksine Graviton işlemciler, daha geleneksel iş yüklerini çalıştıracak şekilde tasarlanmıştır. Amazon AWS, Datadog, DirecTV, Discovery, Formula 1, Nielsen, Pinterest, SAP, Snowflake, Sprinklr, Stripe ve Zendesk dahil olmak üzere müşterilerinin “veritabanları, analizler, web sunucuları gibi çok çeşitli iş yüklerini çalıştırmak için Graviton çiplerini kullandığını” söyledi. toplu işleme, reklam sunma, uygulama sunucuları ve mikro hizmetler.”

SAP, HANA bellek içi veritabanını çalıştırarak bu çiplerle “analitik iş yükleri için %35 daha yüksek performans” elde ettiğini söyledi.

Bu duyurular, Microsoft’un geçen hafta yapay zekaya yönelik ilk çipleriyle ilgili duyurularının ardından geldi. Bulutun diğer devi Google, 2016 yılında yapay zekaya adanmış ilk çipi, TPU veya Tensör İşleme Birimi ile yenilik yaptı ve o zamandan beri birkaç nesil sunuyor.

AWS, GH200’ün öncüsü

Amazon, iki yeni çipin yanı sıra yapay zeka çip devi Nvidia ile stratejik ortaklığını genişletti. AWS, Nvidia’nın ARM tabanlı Grace işlemci ile Hopper H100 GPU çipini birleştiren yakında çıkacak Grace Hopper GH200 çoklu çip ürününü kullanan ilk bulut hizmeti olacak.

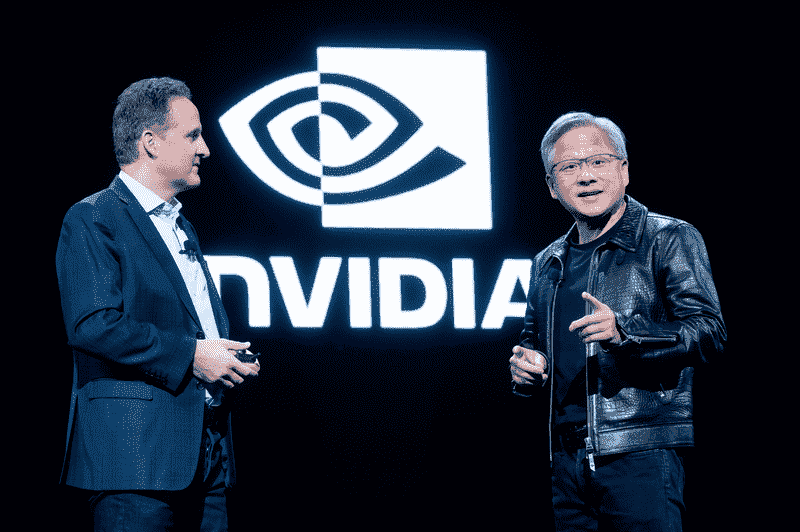

Nvidia CEO’su Jensen Huang ve AWS CEO’su Adam Selipsky re:Invent 2023’te sahnede.

GH200’ün gelecek yıl teslim edilmesi bekleniyor. Bunlar, Nvidia’nın özel olarak tasarlanmış yapay zeka sunucuları DGX aracılığıyla AWS’de barındırılacak ve iki şirket, bir trilyondan fazla parametreye sahip sinir ağlarının eğitimini hızlandıracağını söylüyor.

Nvidia, AWS’yi “ML araştırma ve geliştirmesi için birincil bulut sağlayıcısı” yapacağını söyledi.

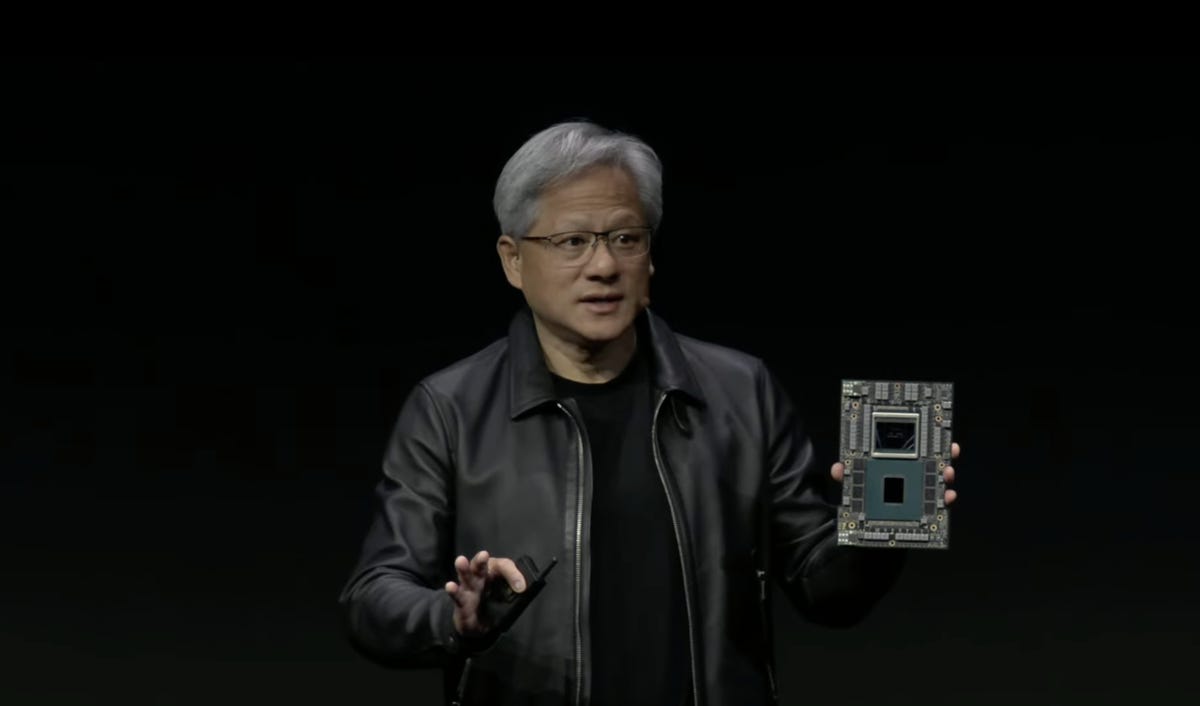

Nvidia CEO’su Jensen Huang ve şirketinin CPU ve GPU kombinasyonunun bir sonraki versiyonu olan Grace Hopper “GH200” “süper çip”i. Nvidia

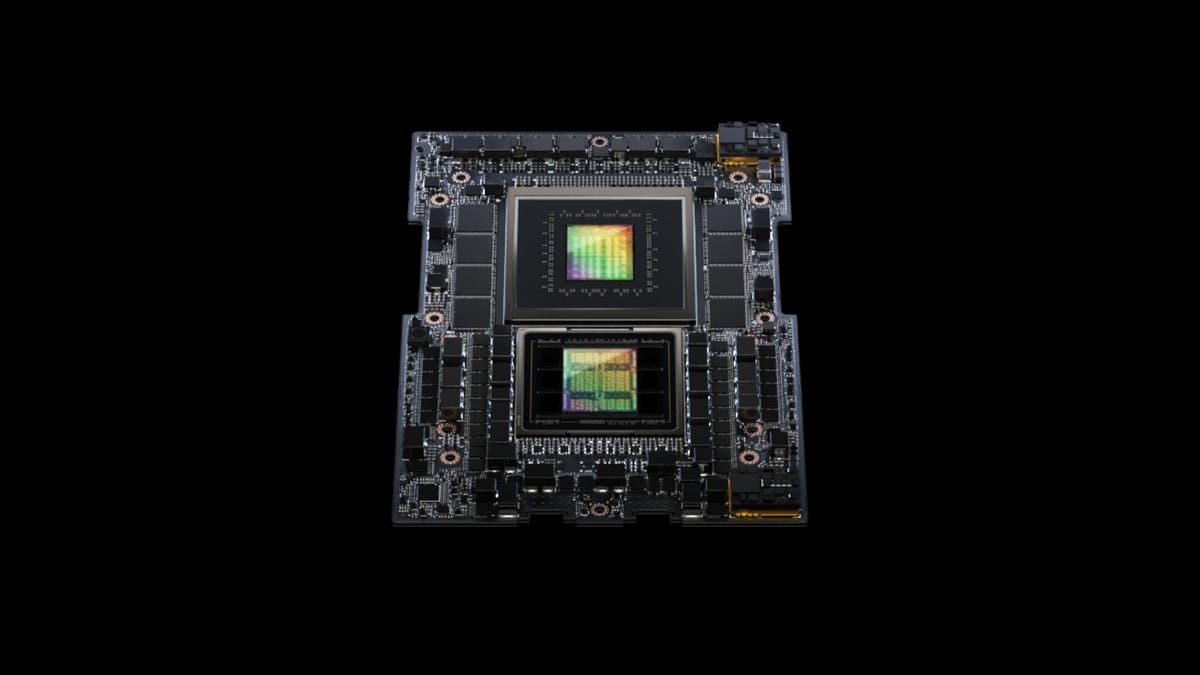

GH200 yongası, NVLink adı verilen CPU ve GPU’yu birleştiriyor

GH200 yongası, CPU ve GPU’yu daha hızlı bellek ve NVLink adı verilen ultra hızlı konektörlerle birleştirir. Nvidia CEO’su Jensen Huang bunu yaptı duyuru Ağustos 2023’te.

İlk Grace Hopper süper çipi 96 gigabayt içeriyorsa HBM belleğiBu yeni sürüm, bir sonraki yüksek bant genişliğine sahip bellek standardı olan 140 gigabayt HBM3e bellek içeriyor. HBM3e, GPU’yu besleyen veri hızını, orijinal Grace Hopper’daki 4 terabayta kıyasla saniyede 5 terabayta (trilyon bayta) çıkarır.

“Çipler üretimde, yıl sonunda veya buna yakın bir tarihte bunların numunelerini alacağız ve ikinci çeyreğin sonunda da üretime geçeceğiz. [2024]”, dedi Jensen Huang sunum sırasında.

GH200, orijinal çip gibi 72 ARM tabanlı CPU çekirdeği ve 144 GPU çekirdeği içeriyor.

Yığılmış GH200’ler

Jensen Huang, GH200’ün çift yapılandırmalı bir sunucudaki ikinci bir GH200’e toplam 10 terabaytlık HBM3e bellek bant genişliği için bağlanabileceğini garanti ediyor.

GH200, CPU ve GPU arasındaki sıkı bağlantı yoluyla yapay zeka programlarının çalışmalarını paylaşmak üzere tasarlanan Grace Hopper süper çipinin bir sonraki versiyonudur. Nvidia

HBM, artan bellek talebi nedeniyle 2015 yılında önceki GPU bellek standardı GDDR’yi değiştirmeye başladı. HBM, dikey olarak üst üste “yığılmış” ve birbirine bağlı bir bellek yapılandırmasıdır.

Kaynak : “ZDNet.com” Ve “ZDNet.com”