Ne bilmek istiyorsun

- TensorRT-LLM, 8 GB VRAM’den başlayan RTX GPU’lara sahip masaüstü ve dizüstü bilgisayarlar için OpenAI’nin Sohbet API desteğini ekliyor.

- Kullanıcılar, veri kümelerini buluta yüklemeden LLM sorgularını daha hızlı ve yerel olarak işleyebilir.

- NVIDIA bunu “Geri Almayla Artırılmış Üretim” (RAG) ile eşleştirerek daha fazla özel LLM kullanım senaryosuna olanak tanır.

Microsoft’un bugünkü Ignite konferansı sırasında NVIDIA, TensorRT-LLM için bir güncelleme duyurdu. Ekim ayında piyasaya sürüldü. Bugünkü ana duyurular, TensorRT-LLM özelliğinin artık LLM API’leri, özellikle de bu noktada en çok bilinen OpenAI Chat API’si için destek kazandığı ve ayrıca TensorRT-LLM ile performansı artırmak için çalıştıkları yönünde. GPU’larında jeton başına daha iyi performans.

Oldukça ilginç olan üçüncül bir duyuru da var. NVIDIA, TensorRT-LLM’ye Almayla Artırılmış Üretimi dahil edecek. Bu, bir LLM’nin çevrimiçi herhangi bir şeye güvenmek yerine bilgi tabanı için harici bir veri kaynağı kullanmasına olanak tanır; bu, yapay zeka için oldukça talep edilen bir özelliktir.

TensorRT-LLM nedir?

IGNITE 2023’TEN DAHA FAZLASINI OKUYUN

NVIDIA kısa süre önce, NVIDIA donanımında Yüksek Lisans’ların yerel olarak hesaplanmasına olanak tanıyan açık kaynaklı bir kitaplık olan NVIDIA TensorRT-LLM’yi kullanıma sundu. NVIDIA, büyük veri kümeleri veya özel bilgilerle uğraşırken gizlilik ve verimlilik elde etmek için bunu öne sürüyor. Bu bilgilerin OpenAI’nin Sohbet API’si gibi bir API aracılığıyla gönderilip gönderilmediği güvenlidir. NVIDIA TensorRT-LLM hakkında daha fazla bilgiyi şu adreste bulabilirsiniz: NVIDIA’nın geliştirici sitesi.

Bugün NVIDIA TensorRT-LLM’de duyurulan değişiklikler, OpenAI’nin Sohbet API’sinin eklenmesi ve daha önce desteklenen LLM’ler ile Llama 2 ve Stable Diffusion gibi AI modelleri için DirectML geliştirmeleri aracılığıyla performans iyileştirmeleridir.

Bu teknoloji ve bilgi işlem yerel olarak yapılabilir. NVIDIA’nın AI Workbench’i. Bu “birleşik, kullanımı kolay araç seti, geliştiricilerin bir PC veya iş istasyonunda önceden eğitilmiş üretken AI modellerini ve LLM’leri hızlı bir şekilde oluşturmasına, test etmesine ve özelleştirmesine olanak tanır.” NVIDIA’nın bir erken erişim kayıt sayfası kullanmak isteyenler için.

NVIDIA TensorRT-LLM, NVIDIA AI platformundaki en yeni büyük dil modellerinin (LLM’ler) çıkarım performansını hızlandıran ve optimize eden açık kaynaklı bir kitaplıktır

NVIDIA

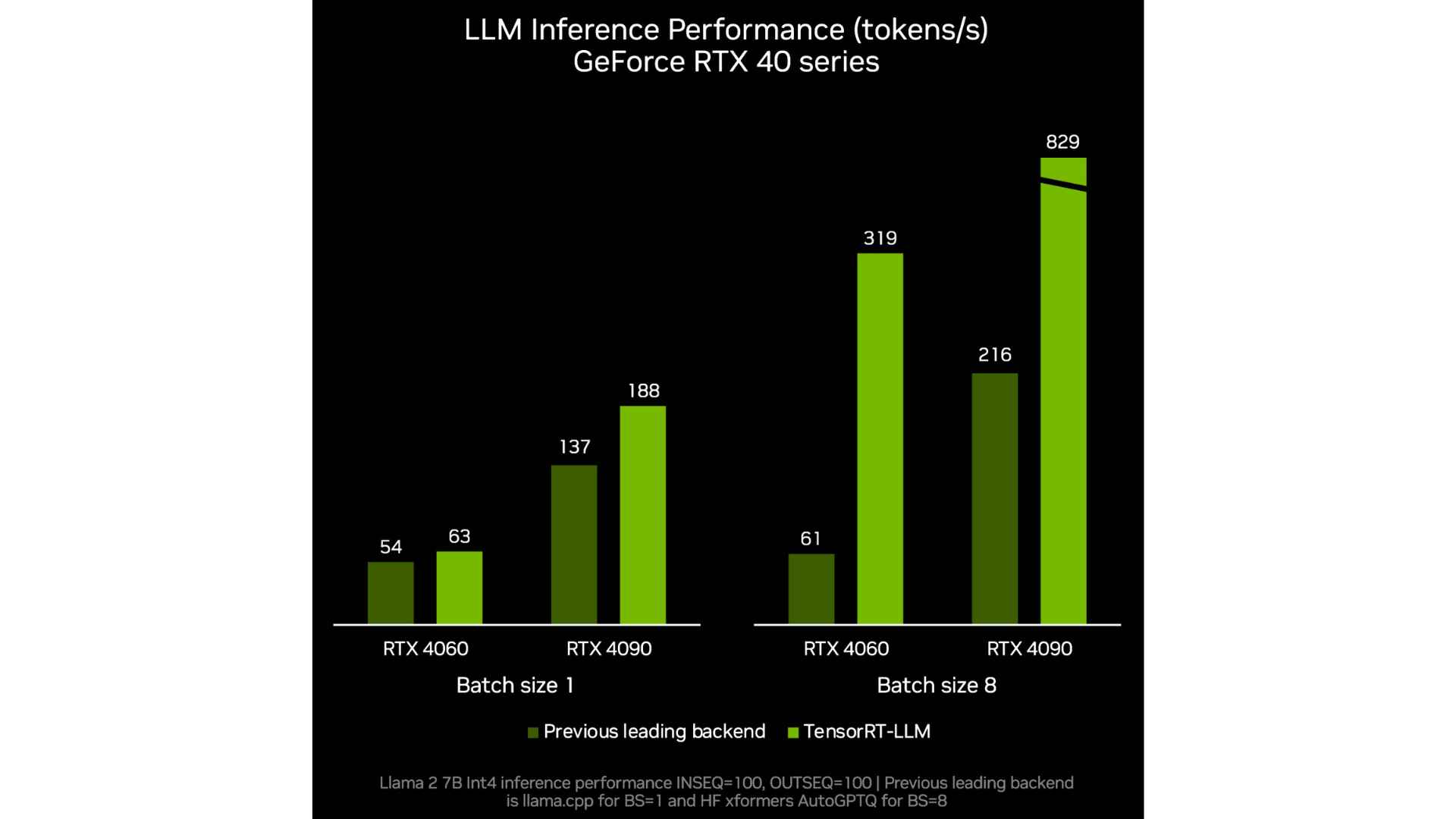

Nvidia aynı zamanda bu şirket içi NVIDIA kıyaslamalarında da görebileceğimiz gibi LLM’ler için token başına performansta da bir iyileşme gösteriyor. Her zaman olduğu gibi, performans kazancının doğru raporlanması için üretici kıyaslamalarına ve testlerine karşı dikkatli olun.

Artık NVIDIA’nın TensorRT-LLM’sini bildiğimize göre bu neden özel veya kullanışlı? Çoğunlukla, NVIDIA destekli bir iş istasyonunda veya PC’de yerel olarak çalıştırmak, bulut bilgi işlem gücünün eksikliğinden dolayı daha yavaş bir hızda olsa da, sorgulara aynı yanıtların verilmesiyle sonuçlanacaktır.

NVIDIA’nın bu kullanım senaryosuna ilişkin resmi, NVIDIA’nın bugün yaptığı diğer duyuruyu, yani Retrieval-Augmented Generation adı verilen yeni bir teknoloji veya özellik ile entegrasyonu tartışırken bir araya geliyor.

Alma-Artırılmış Nesil Nedir?

Geri getirmeyle artırılmış nesil terimi, kağıt Baş yazarı Patrick Lewis olan bir dizi yazar tarafından yazılmıştır. Yüksek Lisans kullanan herkesin karşılaştığı bir soruna çözüm bulmak için sektörün benimsediği isimdir. Güncel olmayan veya doğru ancak tartışma bağlamında hatalı olan bilgiler. RAG’ın nasıl çalıştığına ilişkin ayrıntılı ayrıntılar NVIDIA’nın Teknik Özetler.

Almayla artırılmış nesil, dış kaynaklardan alınan gerçeklerle üretken yapay zeka modellerinin doğruluğunu ve güvenilirliğini artırmaya yönelik bir tekniktir.

Rick Merritt

Geri almayla artırılmış oluşturmayı NVIDIA’nın TensorRT-LLM’si ile eşleştirerek son kullanıcılar, LLM’nin sorgularını çalıştırırken hangi bilgilere erişebileceğini özelleştirebilir. ChatGPT yakın zamanda benzer sonuçlar sunabilecek özel GPT’leri duyurdu.

Özel GPT’lerle ilgili makalemizde tartışıldığı gibi, özel bir GPT ile veya bu durumda, almayla artırılmış oluşturmayı kullanarak yalnızca tüm GPT’lere erişimi olan bir LLM örneği ile ısmarlama, tek amaçlı LLM örnekleri oluşturma yeteneği Charles Dickens’ın yayınlanmış çalışmaları ve başka hiçbir şey, farklı kullanım durumları için amaca yönelik, anlamlı ve doğru Yüksek Lisans Eğitimleri oluşturmaya yardımcı olamaz.

TensorRT-LLM faydalı olacak mı?

Bütün bunlar bir arada ne anlama geliyor? Bunun anlamlı bir şekilde kullanılması için bazı gerçek fırsatlar var. Uygulaması ne kadar kolay olacak veya veriler ne kadar güvenli olacak? Sadece zaman gösterecek. İş akışlarını iyileştirmek, karmaşık bilgilere daha kolay erişim sağlamak ve çalışanlara zorlu görevlerde yardımcı olmak için özellikle kurumsal düzeyde yapay zeka iyileştirmeleri potansiyeli var.

Bu görevler yerel olarak yürütülecek olsa da normal LLM API’lerinden geçmeye devam edecek ve bu da şu anda karşılaştıkları aynı içerik kısıtlamaları ve sınırlamalarıyla karşı karşıya kalacak. Bununla birlikte, NVIDIA’nın TensorRT-LLM’si gibi teknolojiler bir Yüksek Lisans’ı çevrimdışı kullanmayı daha hızlı hale getirdiğinden, birisi bunu şunun gibi bir şeyle entegre edebilir: EvilGPTDavranışında herhangi bir sınırlama bulunmayan ve şu anda kötü amaçlı yazılım oluşturmak ve siber saldırılara yardımcı olmak için kullanılan bir yapay zekanın gerçek zarar verme potansiyeli yalnızca daha da artıyor.

NVIDIA’nın TensorRT-LLM’ye yönelik güncellemeleri hakkında ne düşünüyorsunuz? Kaçırdığım herhangi bir kullanım düşünebiliyor musunuz? Yorumlarda bize bildirin.