Modern üretken yapay zeka modelleri üzerinde çalışan şirketlerin en çok tercih ettiği ürün olan Nvidia H100 hızlandırıcı, artık dünyanın en güçlü ürünü değil. Bugün Nvidia H200 modelini tanıttı.

Doğru, teknik olarak bu tamamen yeni bir model değil. Üstelik görünüşe göre birçok yönden H100’ün tam bir kopyası. Nvidia’nın kendisi GPU özelliklerini listelemiyor ancak tam olarak aynı TFLOPS performansını listeliyor, bu da GPU’nun aynı kaldığı anlamına geliyor: 16.896 CUDA çekirdeğiyle.

Yeni sürüm arasındaki fark bellek alt sisteminde yatmaktadır. Bu, HBM3e belleğe sahip ilk hızlandırıcıdır ve bu tür bir belleğin kullanılması, yapay zeka görevleri için son derece önemli olan verimde önemli bir artış sağlar.

Daha doğrusu H200, H100’de 80 GB ve 3,35 TB/s bant genişliğine karşılık 4,8 TB/s bant genişliğine sahip 141 GB bellekle donatılmıştır. Görünüşe göre bu pek önemli değil ve bazı görevlerde öyle olacak, ancak Nvidia’nın kendisi H200’ün H100’den% 90’a kadar, yani neredeyse iki kat önde olduğu örnekleri gösteriyor! Ve bu aynı GPU ve temel özelliklere sahip.

Yeni çözümün teslimatları ancak 2024’ün ikinci çeyreğinde başlayacak. Bu, gelecek yıl tamamen yeni nesil B100 hızlandırıcının beklenmesine rağmen.

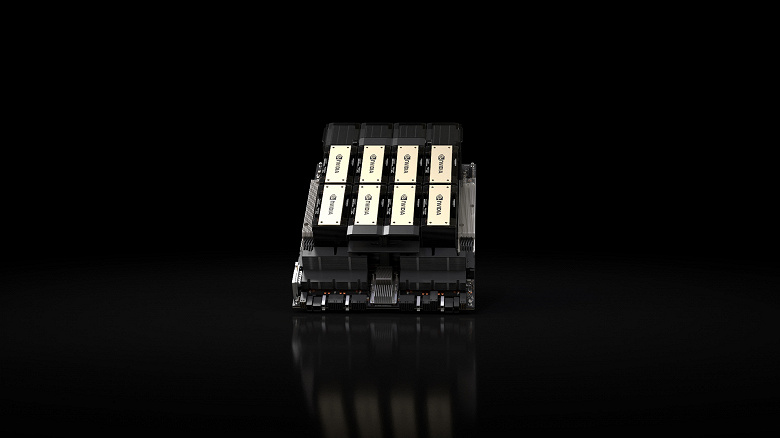

H200, Nvidia HGX H200 sunucu anakartlarında dört ve sekiz soketli yapılandırmalarda satışa sunulacak. Ayrıca Ağustos ayında duyurulan Nvidia’nın HBM3e’li GH200 Grace Hopper süper çipinde de mevcut.