Üretken yapay zeka modellerinin ana itici güçlerinden biri “kazıma”dır. Yapay zeka şirketlerinin, genellikle çılgınca internet kaynaklarından veri toplayarak yapay zeka modellerini eğitmek için kullandıkları bir süreç. Ve bu nedenle bu verilerin sahiplerinin izni olmadan.

Yapay zekanın kazınması, çalışmaları yapay zeka modelleri aracılığıyla yeni sanat eserleri üretmek için kazınan sanatçılar üzerinde özellikle olumsuz bir ekonomik ve itibar etkisi yaratabilir. Ama belki bir çözüm vardır.

Chicago Üniversitesi’ndeki araştırmacılar, geliştiricilerin çalışmalarında AI araçlarını eğitmesini önlemek için sanatçıların dijital sanatlarını “zehirlemelerine” olanak tanıyan yeni bir araç olan Nightshade’i yarattı.

Manipülasyon yapay zekanın denekleri birbiriyle karıştırmasına neden oluyor

Sanatçılar, Nightshade’i kullanarak eserlerinin piksellerinde insan gözüyle görülmeyen değişiklikler yapabiliyor ve bu da üretken yapay zeka modelinde “kaotik” ve “öngörülemeyen” kırılmalara neden oluyor. MIT Teknoloji İncelemesiAraştırmaya özel bir bakış sunan kişi.

Teknik, üretken yapay zeka modellerinin işe yaramaz sonuçlar üretmesine neden oluyor. Açıkçası, manipülasyon yapay zekanın denekleri birbiriyle karıştırmasına neden oluyor.

Örneğin yapay zeka modeli, bir köpeğin aslında bir kedi olduğuna inandırılarak kandırılabilir. Bu, istemde yazılan metinle eşleşmeyen hatalı görüntüler üretmesine neden olur.

Ancak model eğitmenler farklı savunmalar uygulayabilir

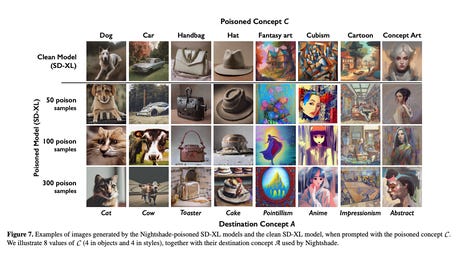

Araştırma makalesine göre Nightshade zehir örnekleri, aşağıdaki resimde gösterildiği gibi 100’den az örnekte Kararlı Yayılım istemini bozabilir.

Chicago Üniversitesi

Zehirlenme, belirli bir terimin zehirlenmesinin yanı sıra ilişkili terimleri de etkiler.

Örneğin, yukarıdaki örnekte yalnızca “köpek” terimi değil, aynı zamanda “yavru köpek”, “tazı” ve “husky” gibi eşanlamlılar da etkilenecektir.

Terimler arasındaki korelasyonun da yukarıdaki örnekte olduğu kadar doğrudan olması gerekmez. Örneğin belge, “fantezi sanatı” terimi zehirlendiğinde, ünlü bir fantezi sanatı yaratıcısı olan “bir tablo Michael Whelan” ifadesinin de zehirlendiğini açıklıyor.

Ancak model eğiticileri, verilerinin zehirlenmesine ilişkin bu risklere karşı, veri filtreleme, konum tespit yöntemleri ve zehir giderme yöntemleri dahil olmak üzere farklı savunmalar uygulayabilir, ancak bu üç yöntem tamamen etkili değildir.

Zehirli verilerin modelden kaldırılması zordur

Ek olarak, yapay zeka şirketinin bozuk her numuneyi ayrı ayrı kaldırması gerektiğinden, zehirlenmiş verilerin modelden kaldırılması zordur.

Nightshade, yapay zeka şirketlerini izin istemeden veri kullanmaktan vazgeçirmekle kalmayıp, aynı zamanda kullanıcıları bu üretken yapay zeka modellerinden herhangi birini kullanırken dikkatli olmaya da teşvik edebilir.

Sanatçıların eserlerinin izinsiz kullanılması sorununu hafifletmek için başka girişimlerde bulunuldu. Getty Images Image Generator ve Adobe Firefly gibi görüntü üreten bazı yapay zeka modelleri, modellerini eğitmek için yalnızca sanatçı onaylı veya açık erişimli görüntüler kullanır ve karşılığında bir telafi programı uygular.

Kaynak : “ZDNet.com”