Güvenlik ve BT ekipleri, güvenlik risklerini tam olarak anlamadan önce rutin olarak yazılımları benimsemeye zorlanır. AI araçları da bir istisna değildir.

Hem çalışanlar hem de iş liderleri, genellikle kuruluşa getirdikleri önemli SaaS güvenlik açıklarının farkında olmadan üretken AI yazılımlarına ve benzer programlara akın ediyor. Bir Şubat 2023 1.000 yöneticiden oluşan üretici yapay zeka anketi yanıtlayanların %49’unun şu anda ChatGPT kullandığını ve %30’unun yakında her yerde bulunan üretken yapay zeka aracından yararlanmayı planladığını ortaya çıkardı. ChatGPT kullananların yüzde doksan dokuzu bir şekilde maliyet tasarrufu sağladığını iddia etti ve %25’i giderleri 75.000 $ veya daha fazla azalttığını onayladı. Araştırmacılar bu anketi ChatGPT’nin genel kullanıma sunulmasından yalnızca üç ay sonra gerçekleştirdiğinden, günümüzün ChatGPT ve AI aracı kullanımı şüphesiz daha yüksektir.

Güvenlik ve risk ekipleri, halihazırda iş dünyasının işletim sistemi haline gelen SaaS varlıklarını yanlış yapılandırmalar ve aşırı izin verilen kullanıcılar gibi yaygın güvenlik açıklarından korumaktan bunalmış durumdadır. Bu, AI aracı tehdit ortamını, şu anda kullanımda olan onaylanmamış AI araçlarını ve SaaS güvenliği üzerindeki etkilerini değerlendirmek için çok az bant genişliği bırakır.

Kuruluşların dışında ve içinde ortaya çıkan tehditlerle, CISO’lar ve ekipleri, SaaS sistemlerine yönelik en alakalı yapay zeka aracı risklerini ve bunların nasıl hafifletileceğini anlamalıdır.

1 — Tehdit Aktörleri, SaaS Kimlik Doğrulama Protokollerini Kopyalamak için Üretken Yapay Zekadan Yararlanabilir

Hırslı çalışanlar, daha az kaynakla daha fazlasını başarmalarına yardımcı olacak yapay zeka araçlarının yollarını tasarlarken, siber suçlular da aynı şeyi yapıyor. Üretken yapay zekayı kötü niyetle kullanmak kesinlikle kaçınılmaz ve zaten mümkün.

AI’nın insanları taklit etme yeteneği, zayıf SaaS kimlik doğrulama protokollerini özellikle bilgisayar korsanlığına karşı savunmasız hale getirir. Buna göre Tekopedi, tehdit aktörleri üretken yapay zekayı parola tahmin etme, CAPTCHA kırma ve daha güçlü kötü amaçlı yazılım oluşturmak için kötüye kullanabilir. Bu yöntemler saldırı menzillerinde sınırlı gibi görünse de, Ocak 2023 CircleCI güvenlik ihlali tek bir mühendisin dizüstü bilgisayarına kötü amaçlı yazılım bulaşmasıyla ilişkilendirildi.

Aynı şekilde, tanınmış üç teknoloji akademisyeni yakın zamanda bir kimlik avı saldırısı yürüten üretken yapay zeka için makul bir varsayım öne sürdü:

“Bir bilgisayar korsanı, şirketinizin geçmişte başarılı olan pazarlama materyallerine ve kimlik avı mesajlarına dayalı olarak kişiselleştirilmiş bir hedefli kimlik avı mesajı oluşturmak için ChatGPT’yi kullanıyor. E-posta farkındalığı konusunda iyi eğitim almış insanları kandırmayı başarıyor çünkü öyle görünmüyor. algılamak için eğitildikleri mesajlar gibi.”

Kötü niyetli aktörler, en güçlendirilmiş giriş noktasından – tipik olarak SaaS platformunun kendisinden – kaçınacak ve bunun yerine daha savunmasız yan kapıları hedef alacaktır. Kilitlenmemiş veranda kapılarına gizlice girebildiklerinde, ön kapının yanında bulunan sürgü ve bekçi köpeği ile uğraşmayacaklar.

SaaS verilerini güvende tutmak için yalnızca kimlik doğrulamaya güvenmek uygun bir seçenek değildir. Güvenlik ve risk ekipleri, çok faktörlü kimlik doğrulama (MFA) ve fiziksel güvenlik anahtarları uygulamanın ötesinde, tüm SaaS çevresi için görünürlük ve sürekli izlemenin yanı sıra şüpheli oturum açma etkinliği için otomatik uyarılara ihtiyaç duyar.

Bu içgörüler, yalnızca siber suçluların üretken yapay zeka faaliyetleri için değil, aynı zamanda çalışanların SaaS platformlarına yapay zeka aracı bağlantıları için de gereklidir.

2 — Çalışanlar Onaylanmamış Yapay Zeka Araçlarını Riskleri Düşünmeden SaaS Platformlarına Bağlıyor

Çalışanlar artık işlerini kolaylaştırmak için onaylanmamış yapay zeka araçlarına güveniyor. Ne de olsa, AI araçları etkinliği ve verimliliği artırırken kim daha çok çalışmak ister? Herhangi bir form gibi gölge BTçalışanların yapay zeka araçlarını benimsemesi en iyi niyetlerle sağlanır.

Örneğin, bir çalışan, zamanını ve yapılacak işleri daha iyi yönetebileceğine ikna olmuştur, ancak görev yönetimini ve toplantı katılımını izleme ve analiz etme çabası büyük bir taahhüt gibi gelir. Yapay zeka, bu izleme ve analizi kolaylıkla gerçekleştirebilir ve neredeyse anında önerilerde bulunarak çalışana arzuladığı üretkenlik artışını çok kısa bir sürede verebilir. Son kullanıcının bakış açısından bir yapay zeka planlama asistanına kaydolmak şu kadar basit ve (görünüşte) zararsızdır:

- Ücretsiz deneme için kaydolma veya kredi kartıyla kaydolma

- AI aracının Okuma/Yazma izin isteklerini kabul etme

- AI planlama asistanını kurumsal Gmail, Google Drive ve Slack hesaplarına bağlama

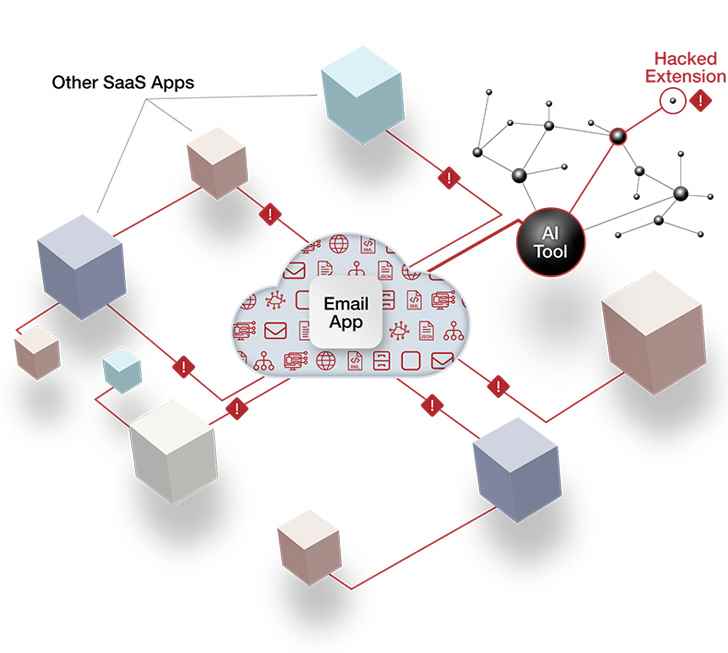

Ancak bu süreç, bir kuruluşun en hassas verilerine görünmez kanallar oluşturur. Bu AI-to-SaaS bağlantıları, kullanıcının izin ayarlarını devralarak, AI aracını başarıyla tehlikeye atabilen bilgisayar korsanının yetkili SaaS sistemleri arasında sessizce ve yatay olarak hareket etmesine olanak tanır. Bir bilgisayar korsanı, haftalardan yıllara kadar değişebilen şüpheli etkinlik fark edilene ve harekete geçene kadar verilere erişebilir ve verileri sızdırabilir.

Çoğu SaaS uygulaması gibi yapay zeka araçları SaaS platformlarına devam eden bağlantılar için OAuth erişim belirteçleri. Yetkilendirme tamamlandıktan sonra, yapay zeka planlama asistanının belirteci Gmail, Google Drive ve Slack hesaplarıyla tutarlı, API tabanlı iletişimi sürdürür – üstelik kullanıcının herhangi bir düzenli aralıklarla oturum açması veya kimlik doğrulaması yapması gerekmeden. Bu OAuth belirtecinden yararlanabilen tehdit aktörü, paspasın altında “gizli” yedek anahtarların SaaS eşdeğerine rastladı.

|

| Şekil 1: Büyük bir SaaS platformuyla OAuth belirteci bağlantısı kuran bir yapay zeka aracının resmi. 1 kredi |

Güvenlik ve risk ekipleri genellikle bu tür bir saldırı yüzey riskini izlemek veya kontrol etmek için SaaS güvenlik araçlarından yoksundur. Bulut erişimi güvenlik aracıları (CASB’ler) ve güvenli web ağ geçitleri (SWG’ler) gibi eski araçlar, AI-to-SaaS bağlantısını algılamaz veya bu konuda uyarı vermez.

Yine de bu yapay zekadan SaaS’a bağlantılar, çalışanların hassas verileri istemeden dış dünyaya ifşa etmesinin tek yolu değildir.

3 — Üretken Yapay Zeka Araçları ile Paylaşılan Hassas Bilgiler Sızıntılara Karşı Hassastır

Çalışanların – genellikle işi hızlandırmak ve kalitesini artırmak amacıyla – üretici yapay zeka araçlarına sunduğu veriler, sonunda yapay zeka sağlayıcısının kendisinin, bir kuruluşun rakiplerinin veya genel halkın eline geçebilir.

Üretken yapay zeka araçlarının çoğu ücretsiz olduğundan ve kuruluşun teknoloji yığınının dışında bulunduğundan, güvenlik ve risk uzmanlarının bu araçlar için gözetim veya güvenlik denetimleri yoktur. Bu, işletmeler arasında giderek artan bir endişe kaynağıdır ve üretici yapay zeka veri sızıntıları şimdiden olmuştur.

Bir Mart olayı yanlışlıkla etkinleştirildi ChatGPT kullanıcıları, diğer kullanıcıların sohbet başlıklarını ve geçmişlerini görebilir web sitesinin kenar çubuğunda. Yalnızca hassas kurumsal bilgi sızıntıları için değil, aynı zamanda kullanıcı kimliklerinin ifşa edilmesi ve tehlikeye atılmasıyla ilgili endişeler ortaya çıktı. ChatGPT’nin geliştiricileri OpenAI, kullanıcıların sohbet geçmişini kapatma özelliğini duyurdu. Teorik olarak bu seçenek, ChatGPT’nin ürün iyileştirmesi için verileri OpenAI’ye geri göndermesini durdurur, ancak çalışanların veri saklama ayarlarını yönetmesini gerektirir. Bu ayar etkinleştirildiğinde bile, OpenAI konuşmaları 30 gün boyunca saklar ve sürelerinin sona ermesinden önce onları “kötüye kullanım” açısından inceleme hakkını kullanır.

Bu hata ve veri saklama cezası dikkatlerden kaçmadı. Mayısta, Apple, çalışanların ChatGPT kullanmasını kısıtladı gizli veri sızıntısı endişeleri üzerine. Teknoloji devi, kendi üretken yapay zeka araçlarını oluştururken bu duruşu alırken, yasakta Amazon, Verizon ve JPMorgan Chase gibi işletmelerin arasına katıldı. Apple ayrıca geliştiricilerini, kodu otomatikleştirmek için en büyük rakibi Microsoft’un sahibi olduğu GitHub Yardımcı Pilot’tan kaçınmaya yönlendirdi.

Yaygın üretken AI kullanım durumları, veri sızıntısı riskleriyle doludur. ChatGPT’den bir ürün yol haritası belgesindeki mesajı daha çekici hale getirmesini isteyen bir ürün yöneticisini düşünün. Bu ürün yol haritası, bir rakibin meraklı gözleri bir yana, asla kamu tüketimine yönelik olmayan ürün bilgileri ve planları içerir. Bir kuruluşun BT ekibinin üst düzeye yükseltme veya düzeltme becerisine sahip olmadığı benzer bir ChatGPT hatası, ciddi düzeyde veri açığa çıkmasına neden olabilir.

Tek başına üretken yapay zeka, SaaS güvenlik riski oluşturmaz. Ancak bugün izole olan yarın bağlantılıdır. Hırslı çalışanlar, doğal olarak, onaylanmamış üretici yapay zeka araçlarını SaaS uygulamalarına entegre ederek kullanışlılığını genişletmeye çalışacaklardır. Şu anda, ChatGPT’nin Slack entegrasyonu ortalama bir Slack bağlantısından daha fazla çalışma gerektirir, ancak anlayışlı, motive olmuş bir çalışan için aşırı derecede yüksek bir çıta değildir. Entegrasyon, OAuth belirteçlerini tam olarak yukarıda açıklanan AI zamanlama yardımcısı örneği gibi kullanır ve bir kuruluşu aynı risklere maruz bırakır.

Kuruluşlar SaaS Ortamlarını Önemli Yapay Zeka Aracı Risklerinden Nasıl Koruyabilir?

Kuruluşların, özellikle SaaS ortamları için yapay zeka aracı veri yönetişimi için yerinde korkuluklara ihtiyacı vardır. Bu, kapsamlı SaaS güvenlik araçları ve proaktif işlevler arası diplomasi gerektirir.

Çalışanlar, büyük ölçüde onaylanmış teknoloji yığınının sınırlamaları nedeniyle onaylanmamış yapay zeka araçlarını kullanıyor. Üretkenliği artırma ve kaliteyi artırma arzusu bir kusur değil, bir erdemdir. Karşılanmamış bir ihtiyaç vardır ve CISO’lar ve ekipleri, çalışanlara kınamaya karşı işbirliği tavrıyla yaklaşmalıdır.

Liderler ve son kullanıcılarla yapay zeka araç istekleriyle ilgili iyi niyetli görüşmeler, güven ve iyi niyet oluşturmak için hayati önem taşır. Aynı zamanda, CISO’lar meşru güvenlik endişelerini ve riskli yapay zeka davranışının olası sonuçlarını iletmelidir. Güvenlik liderleri kendilerini, uyumluluğun ötesinde hiçbir şeyle ilgilenmeyen uygulayıcılar olarak algılanan IRS denetçileri yerine vergi kanunu dahilinde çalışmanın en iyi yollarını açıklayan muhasebeciler olarak görmelidir. İstenen yapay zeka araçları için uygun güvenlik ayarlarını yerine getirmek veya uygulanabilir alternatifler bulmak olsun, en başarılı CISO’lar çalışanların üretkenliklerini en üst düzeye çıkarmalarına yardımcı olmaya çalışır.

Yapay zeka araçlarının risklerini tam olarak anlamak ve ele almak, kapsamlı ve sağlam bir SaaS güvenlik duruşu yönetimi gerektirir (SSPM) çözüm. SSPM, güvenlik ve risk uygulayıcılarına SaaS riskinin sürekli değişen durumunda gezinmek için ihtiyaç duydukları içgörüleri ve görünürlüğü sağlar.

Kimlik doğrulama gücünü artırmak için güvenlik ekipleri, sitedeki tüm SaaS uygulamalarında MFA’yı uygulamak ve yapılandırma kaymasını izlemek için SSPM’yi kullanabilir. SSPM, güvenlik ekiplerinin ve SaaS uygulaması sahiplerinin, her bir SaaS uygulamasının ve yapay zeka aracı ayarının inceliklerini incelemeden en iyi uygulamaları uygulamasına olanak tanır.

SaaS ekosistemine bağlı onaylanmamış ve onaylanmış yapay zeka araçlarının envanterini çıkarma yeteneği, araştırılması gereken en acil riskleri ortaya çıkaracaktır. Sürekli izleme, yeni AI bağlantıları kurulduğunda güvenlik ve risk ekiplerini otomatik olarak uyarır. Bu görünürlük, saldırı yüzeyinin azaltılmasında ve onaylanmamış, güvenli olmayan ve/veya aşırı izin verilen bir AI aracı SaaS ekosisteminde ortaya çıktığında harekete geçilmesinde önemli bir rol oynar.

Yapay zeka araçlarına bağımlılık neredeyse kesinlikle hızla yayılmaya devam edecek. Kesin yasaklar asla kusursuz değildir. Bunun yerine, meslektaşlarının üretkenliği artırma ve tekrarlayan görevleri azaltma hedefini paylaşan pragmatik bir güvenlik liderleri karışımı doğru SSPM çözümü SaaS verilerinin açığa çıkmasını veya ihlal riskini büyük ölçüde azaltmak için en iyi yaklaşımdır.