1998’de istemeden ırksal olarak önyargılı bir yapay zeka algoritması yarattım. O hikayede bugün daha da güçlü bir şekilde yankılanan dersler var.

tehlikeleri yapay zeka algoritmalarında önyargı ve hatalar artık iyi biliniyorlar. O halde neden son aylarda teknoloji şirketleri tarafından, özellikle de yapay zeka sohbet robotları ve görüntü oluşturucular dünyasında bir gaf telaşı yaşandı? ChatGPT’nin ilk sürümleri üretildi ırkçı çıkış. DALL-E 2 ve Kararlı Difüzyon görüntü oluşturucularının her ikisi de gösterdi Irk önyargısı oluşturdukları resimlerde.

Beyaz bir erkek olarak kendi aydınlanmam bilgisayar uzmanı 2021’de bir bilgisayar bilimi dersi verirken meydana geldi. Sınıf, Joy Buolamwini’nin bir video şiirini izlemişti, AI araştırmacısı ve sanatçısı ve kendini tarif eden kod şairi. 2019 video şiiri “AI, Ben Kadın Değil miyim?”, Google ve Microsoft gibi teknoloji şirketleri tarafından geliştirilen otomatik yüz tanıma sistemlerindeki ırk ve cinsiyet önyargılarının üç dakikalık yıkıcı bir ifşasıdır.

Sistemler genellikle beyaz olmayan kadınlar üzerinde başarısız oluyor ve onları yanlış bir şekilde erkek olarak etiketliyor. Başarısızlıklardan bazıları özellikle korkunç: Siyahi sivil haklar lideri Ida B. Wells’in saçı “rakun derisi şapka” olarak etiketlenmiş; başka bir Siyah kadının “mors bıyığı” olduğu etiketlendi.

Yıllar boyunca yankılanan

O bilgisayar bilimi dersinde korkunç bir déjà vu anı yaşadım: Aniden benim de bir zamanlar ırksal olarak önyargılı bir algoritma yarattığımı hatırladım. 1998 yılında doktora öğrencisiydim. Projem, bir video kameradan gelen girdiye dayalı olarak bir kişinin kafasının hareketlerini izlemeyi içeriyordu. Doktora danışmanım zaten geliştirmişti matematiksel teknikler belirli durumlarda kafayı doğru bir şekilde takip etmek için, ancak sistemin çok daha hızlı ve daha sağlam olması gerekiyordu. 1990’ların başlarında, diğer laboratuvarlardaki araştırmacılar bir görüntünün ten rengindeki alanlarının gerçek zamanlı olarak çıkarılabileceğini göstermişti. Bu nedenle, izleyici için ek bir ipucu olarak ten rengine odaklanmaya karar verdik.

Kendi elimin ve yüzümün birkaç fotoğrafını çekmek için bir dijital kamera kullandım – o zamanlar hala nadirdi – ve ayrıca binada bulunan diğer iki veya üç kişinin ellerini ve yüzlerini de çektim. Bu görüntülerden ten rengindeki piksellerden bazılarını manuel olarak çıkarmak ve ten renkleri için istatistiksel bir model oluşturmak kolaydı. Biraz ince ayar ve hata ayıklamadan sonra, şaşırtıcı derecede sağlam bir gerçek zamanlıya sahip olduk. kafa takip sistemi.

Kısa bir süre sonra danışmanım, sistemi ziyaret eden bazı şirket yöneticilerine göstermemi istedi. Odaya girdiklerinde, anında endişeye kapıldım: yöneticiler Japon’du. Basit bir istatistiksel modelin prototipimizle çalışıp çalışmayacağını görmek için yaptığım gündelik deneyde, kendimden ve binada bulunan bir avuç kişiden veri toplamıştım. Ancak bu deneklerin %100’ünün “beyaz” teni vardı; Japon yöneticiler yapmadı.

Mucizevi bir şekilde, sistem yine de yöneticiler üzerinde oldukça iyi çalıştı. Ancak diğer beyaz olmayan insanlar için kolayca başarısız olabilecek ırksal olarak önyargılı bir sistem yarattığımı fark ettiğimde şok oldum.

Ayrıcalık ve öncelikler

İyi eğitimli, iyi niyetli bilim adamları önyargılı yapay zeka sistemlerini nasıl ve neden üretiyor? Sosyolojik ayrıcalık teorileri yararlı bir mercek sağlar.

Kafa izleme sistemini yaratmamdan on yıl önce, akademisyen Peggy McIntosh bir “görünmez sırt çantası” beyaz insanlar tarafından taşınır. Sırt çantasının içinde, “Zorlu bir durumda ırkım için itibar görmeden başarılı olabilirim” ve “Hükümetimizi eleştirebilir ve onun politikalarından ve davranışlarından ne kadar korktuğum hakkında konuşmadan konuşabilirim” gibi bir ayrıcalıklar hazinesi var. kültürel bir yabancı olarak görülüyor.”

AI çağında, o sırt çantasının bazı yeni öğelere ihtiyacı var, örneğin “AI sistemleri benim ırkım nedeniyle kötü sonuçlar vermeyecek.” Beyaz bir bilim adamının görünmez sırt çantasının da şunlara ihtiyacı olacaktır: “Kendi görünüşüme dayalı bir yapay zeka sistemi geliştirebilirim ve bunun kullanıcılarımın çoğu için iyi çalışacağını biliyorum.”

AI araştırmacısı ve sanatçısı Joy Buolamwini’nin video şiiri ‘AI, Ain’t I a Woman?’

Beyaz ayrıcalığı için önerilen bir çözüm, aktif olarak ırkçılık karşıtı. 1998 kafa izleme sistemi için, ırkçılık karşıtı çözümün tüm ten renklerine eşit muamele etmek olduğu açık görünebilir. Elbette, sistemin eğitim verilerinin tüm cilt renklerinin aralığını mümkün olduğunca eşit şekilde temsil etmesini sağlayabiliriz ve sağlamalıyız.

Ne yazık ki bu, sistem tarafından gözlemlenen tüm ten renklerine eşit muamele edileceğini garanti etmez. Sistem, olası her rengi tenli ve tensiz olarak sınıflandırmalıdır. Bu nedenle, tenli ve tensiz arasındaki sınırda renkler var – bilgisayar bilimcilerin karar sınırı dediği bir bölge. Ten rengi bu karar sınırını aşan bir kişi yanlış sınıflandırılır.

Bilim adamları ayrıca, çeşitliliği makine öğrenimi modellerine dahil ederken kötü bir bilinçaltı ikilemiyle karşı karşıya kalıyor: Farklı, kapsayıcı modeller, dar modellerden daha kötü performans gösteriyor.

Basit bir benzetme bunu açıklayabilir. Size iki görev arasında bir seçim verildiğini hayal edin. Görev A, belirli bir ağaç türünü, örneğin karaağaçları tanımlamaktır. Görev B, beş tür ağaç belirlemektir: karaağaç, dişbudak, akasya, kayın ve ceviz. Pratik yapmak için size sabit bir süre verilirse, Görev A’da Görev B’den daha iyi performans göstereceğiniz açıktır.

Aynı şekilde, yalnızca beyaz teni izleyen bir algoritma, tüm insan teni renklerini izleyen bir algoritmadan daha doğru olacaktır. Bilim adamları, çeşitlilik ve adalet ihtiyacının farkında olsalar bile, bilinçaltında bu yarışan doğruluk ihtiyacından etkilenebilirler.

Sayılarda gizli

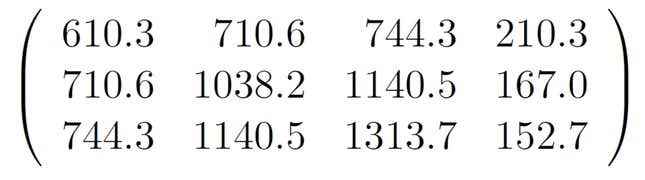

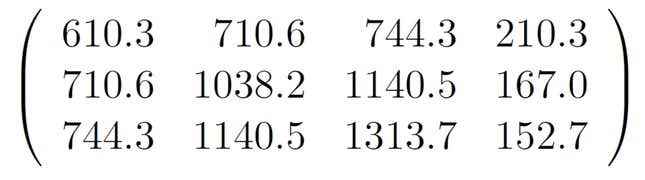

Taraflı bir algoritma oluşturmam düşüncesizdi ve potansiyel olarak saldırgandı. Daha da ilginci, bu olay önyargının bir yapay zeka sisteminin derinliklerinde nasıl saklı kalabileceğini gösteriyor. Nedenini görmek için, üç satır ve dört sütundan oluşan bir matriste belirli bir 12 sayı kümesini düşünün. Irkçı mı görünüyorlar? 1998’de geliştirdiğim baş izleme algoritması, ten rengi modelini tanımlayan buna benzer bir matris tarafından kontrol ediliyor. Ancak sadece bu rakamlardan bunun ırkçı bir matris olduğunu söylemek mümkün değil. Bunlar sadece bir bilgisayar programı tarafından otomatik olarak belirlenen sayılardır.

Göz önünde saklanan önyargı sorunu, modern makine öğrenimi sistemlerinde çok daha ciddidir. Şu anda en popüler ve güçlü AI modeli türü olan derin sinir ağları, önyargının kodlanabileceği milyonlarca sayıya sahiptir. “AI, Ain’t I a Woman?”‘da eleştirilen önyargılı yüz tanıma sistemleri hepsi derin sinir ağlarıdır.

İyi haber şu ki, hem akademi hem de endüstride yapay zeka adaleti konusunda şimdiden büyük bir ilerleme kaydedildi. Örneğin Microsoft, olarak bilinen bir araştırma grubuna sahiptir. KADER, Yapay Zekada Adalet, Hesap Verebilirlik, Şeffaflık ve Etik’e adanmıştır. Önde gelen bir makine öğrenimi konferansı olan NeurIPS, ayrıntılı etik kurallarmakale gönderen araştırmacılar tarafından dikkate alınması gereken sekiz maddelik olumsuz sosyal etkiler listesi dahil.

Odada kim var masada kim var

Öte yandan, 2023’te bile adalet, akademi ve endüstrideki rekabetçi baskıların kurbanı olabilir. kusurlu Bard ve Bing sohbet robotları Google ve Microsoft’tan gelen bilgiler, bu acı gerçeğin son kanıtlarıdır. Pazar payı oluşturmanın ticari gerekliliği, bu sistemlerin erken piyasaya sürülmesine yol açtı.

Sistemler, 1998 kafa takip cihazımla tamamen aynı sorunlardan muzdarip. Eğitim verileri önyargılıdır. Temsili olmayan bir grup tarafından tasarlandılar. Tüm kategorilere eşit davranmanın matematiksel imkansızlığıyla karşı karşıyalar. Doğrulukla adaleti bir şekilde takas etmeleri gerekir. Ve önyargıları milyonlarca anlaşılmaz sayısal parametrenin arkasına saklanıyor.

Öyleyse, 25 yılı aşkın bir süre önce, bir doktora öğrencisinin görünürde hiçbir gözetim veya sonuç olmaksızın ırksal olarak önyargılı bir algoritmanın sonuçlarını tasarlaması ve yayınlaması mümkün olduğundan bu yana yapay zeka alanı gerçekten ne kadar yol kat etti? Önyargılı yapay zeka sistemlerinin yine de istemeden ve kolayca oluşturulabileceği açıktır. Ayrıca bu sistemlerdeki yanlılığın zararlı olabileceği, tespit edilmesi ve ortadan kaldırılmasının daha da zor olabileceği açıktır.

Bugünlerde, endüstri ve akademinin bu algoritmaları tasarlayan “odada” çeşitli insan gruplarına ihtiyacı olduğunu söylemek bir klişe. Alanın o noktaya ulaşabilmesi faydalı olacaktır. Ancak gerçekte, Kuzey Amerika bilgisayar bilimi doktora programlarının yalnızca yaklaşık olarak mezun olmasıyla %23 kadın ve %3 Siyah ve Latin öğrencileryeterince temsil edilmeyen grupların hiç temsil edilmediği birçok oda ve birçok algoritma olmaya devam edecek.

Bu yüzden 1998 kafa takip cihazımdan çıkardığım temel dersler bugün daha da önemli: Hata yapmak kolaydır, ön yargının fark edilmeden girmesi kolaydır ve odadaki herkes bunu önlemekle yükümlüdür.

Yapay zeka, sohbet robotları ve makine öğreniminin geleceği hakkında daha fazla bilgi edinmek ister misiniz? Kapsamımızın tamamına göz atın yapay zekaveya kılavuzlarımıza göz atın En İyi Ücretsiz AI Sanat Üreticileri Ve OpenAI ChatGPT Hakkında Bildiğimiz Her Şey.

John MacCormickBilgisayar Bilimleri Profesörü, Dickinson Koleji

Bu makale şu adresten yeniden yayınlanmıştır: Konuşma Creative Commons lisansı altında. Okumak orijinal makale.