Yapay zekanın durumu hakkında bir rapor yazmak, kayan kumların üzerine inşa etmek gibi bir his olmalı: Yayınlamaya başladığınızda, tüm sektör ayaklarınızın altında değişti. Ancak yine de önemli eğilimler ve çıkarımlar var. Stanford’un 386 sayfalık teklifi Bu karmaşık ve hızlı hareket eden alanı özetlemek için.

İnsan Merkezli Yapay Zeka Enstitüsü’nden AI Index, konuyla ilgili bilgi ve tahmin toplamak için akademi ve özel sektörden uzmanlarla çalıştı. Yıllık bir çaba olarak (ve boyutuna bakılırsa, bir sonrakini hazırlamak için zaten sıkı çalıştıklarına bahse girebilirsiniz), bu yapay zekaya yönelik en yeni yaklaşım olmayabilir, ancak bu periyodik geniş anketler kişinin parmağını tutması için önemlidir. sektörün nabzında.

Bu yılki rapor, “jeopolitik ve eğitim maliyetleri, AI sistemlerinin çevresel etkisi, K-12 AI eğitimi ve AI’daki kamuoyu eğilimleri dahil olmak üzere kuruluş modelleri hakkında yeni analizler” ve ayrıca yüz yeni ülkedeki politikaya bir bakış içeriyor.

En üst düzey çıkarımları maddeler halinde sıralayalım:

- Yapay zeka gelişimi, son on yılda akademi liderliğinden endüstri liderliğine büyük bir farkla tersine döndü ve bu, herhangi bir değişiklik belirtisi göstermiyor.

- Modelleri geleneksel ölçütlerde test etmek zorlaşıyor ve burada yeni bir paradigmaya ihtiyaç duyulabilir.

- AI eğitiminin ve kullanımının enerji ayak izi önemli hale geliyor, ancak bunun başka yerlerde nasıl verimlilik sağlayabileceğini henüz görmedik.

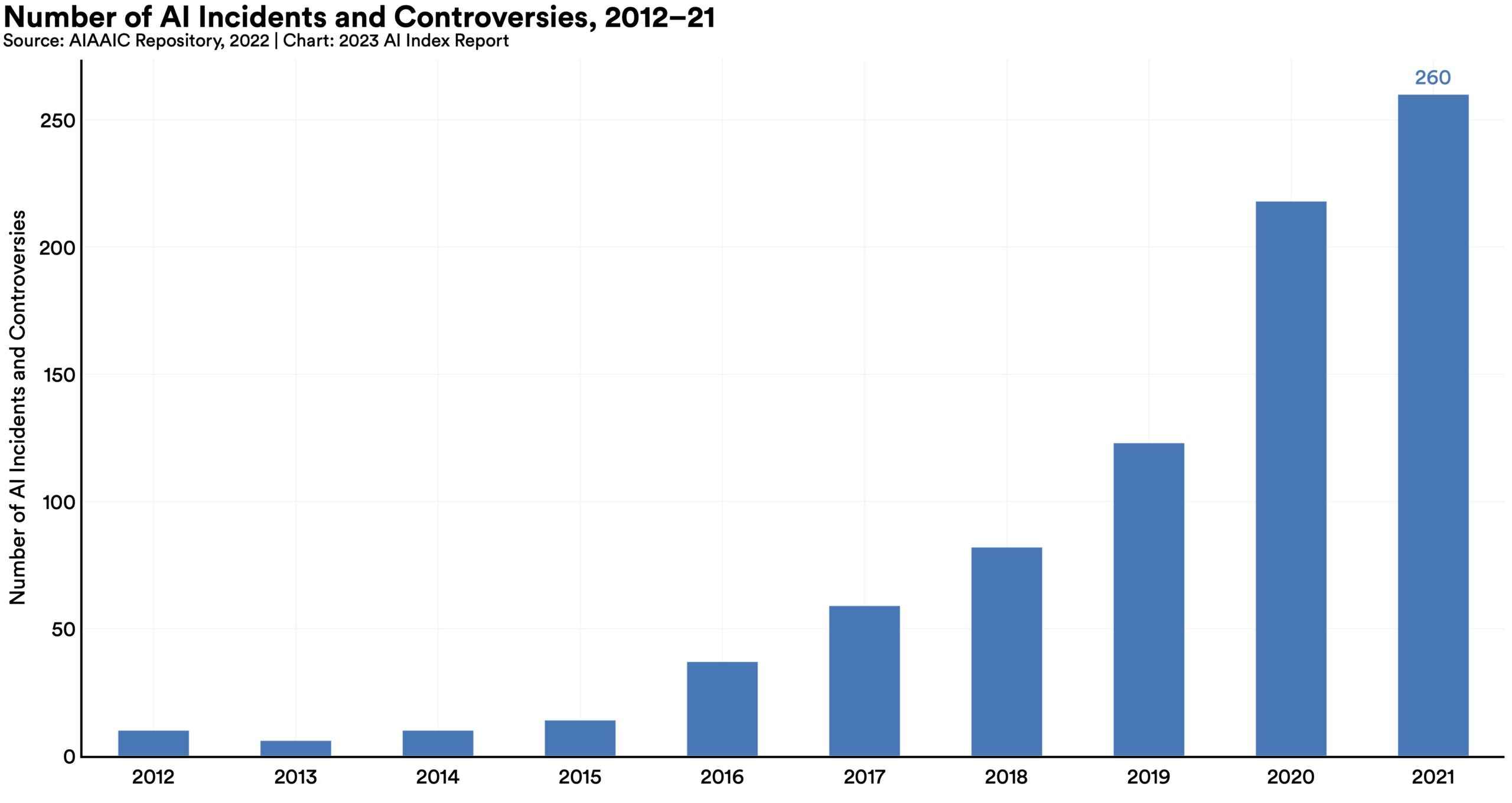

- “AI olayları ve tartışmaları” 2012’den bu yana 26 kat arttı ve bu aslında biraz düşük görünüyor.

- Yapay zeka ile ilgili beceriler ve iş ilanları artıyor, ancak düşündüğünüz kadar hızlı değil.

- Bununla birlikte, politika yapıcılar, kesin bir AI faturası yazmaya çalışırken kendilerine düşüyorlar, eğer varsa, aptalca bir iş.

- Yatırım geçici olarak durdu, ancak bu, son on yıldaki astronomik artışın ardından.

- Çinli, Suudi ve Hintli katılımcıların %70’inden fazlası yapay zekanın dezavantajlardan çok faydaları olduğunu düşünüyor. Amerikalılar mı? %35

Ancak rapor birçok konu ve alt konu hakkında ayrıntılara giriyor ve oldukça okunabilir ve teknik değil. Yalnızca kendini adamış kişiler 386 sayfalık analizin tamamını okuyacaktır, ancak gerçekten, hemen hemen her motive olmuş kişi okuyabilir.

Bölüm 3, Teknik Yapay Zeka Etiği’ne biraz daha ayrıntılı olarak bakalım.

Yanlılığı ve toksisiteyi ölçütlere indirgemek zordur, ancak bu şeyler için modeller tanımlayıp test edebildiğimiz kadarıyla, “filtrelenmemiş” modellerin sorunlu bölgeye yönlendirilmesinin çok, çok daha kolay olduğu açıktır. Ek bir hazırlık katmanı (gizli bilgi istemi gibi) eklemek veya modelin çıktısını ikinci bir aracı modelden geçirmek anlamına gelen talimat ayarlama, bu sorunu iyileştirmede etkilidir, ancak mükemmel olmaktan uzaktır.

Madde işaretlerinde ima edilen “AI olayları ve tartışmalarındaki” artış en iyi şekilde bu şemada gösterilmektedir:

Görsel Kaynakları: Stanford HAI

Gördüğünüz gibi, trend yukarı yönlü ve bu rakamlar ChatGPT ve diğer büyük dil modellerinin yaygın olarak benimsenmesinden önce geldi ve görüntü oluşturuculardaki büyük gelişmeden bahsetmiyorum bile. 26 kat artışın sadece başlangıç olduğundan emin olabilirsiniz.

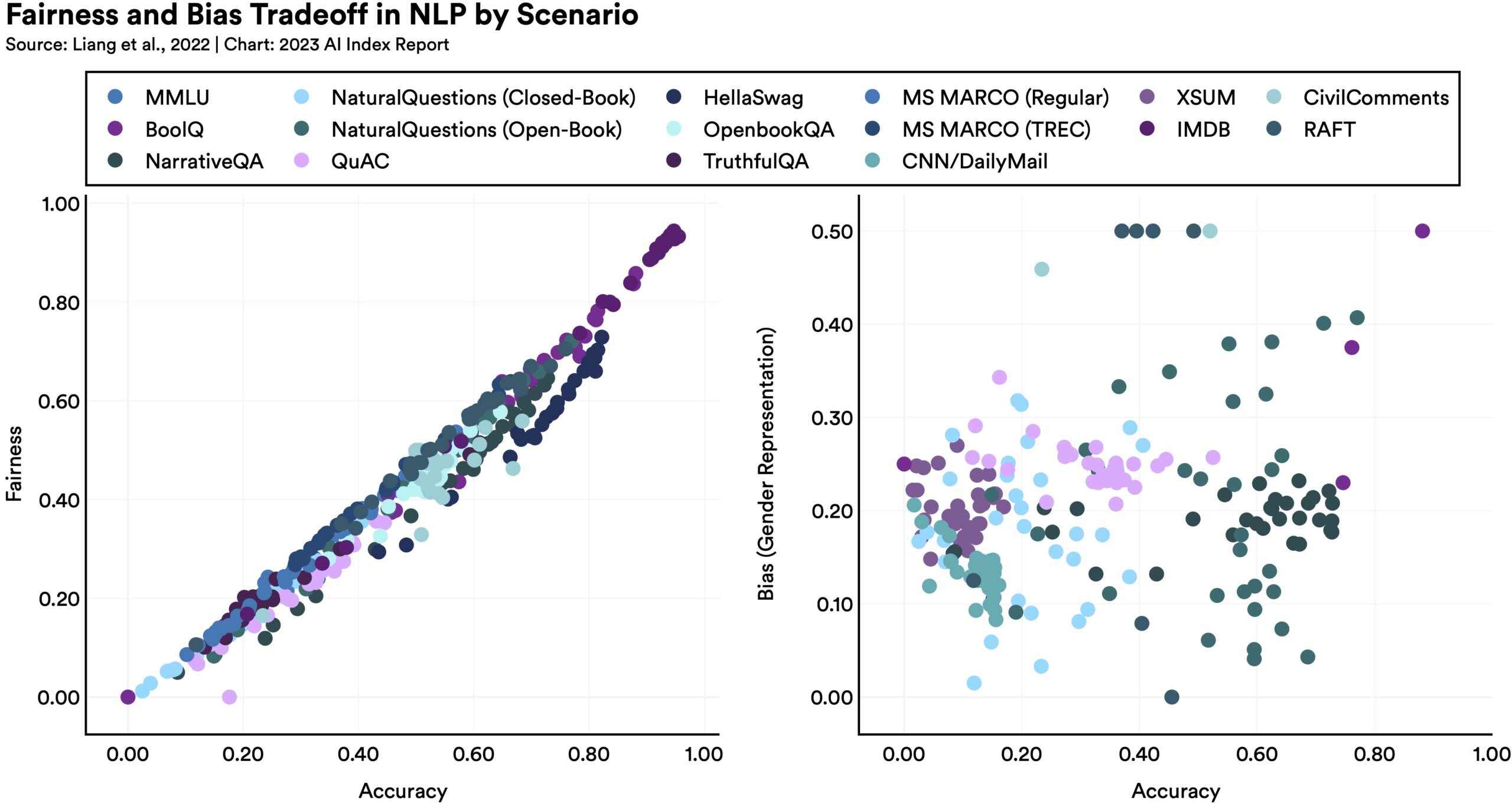

Modelleri bir şekilde daha adil veya tarafsız hale getirmek, bu şemada gösterildiği gibi, diğer ölçümlerde beklenmeyen sonuçlara yol açabilir:

Görsel Kaynakları: Stanford HAI

Raporun belirttiği gibi, “Belirli adalet ölçütlerinde daha iyi performans gösteren dil modelleri, daha kötü cinsiyet önyargısına sahip olma eğilimindedir.” Neden? Söylemesi zor, ancak optimizasyonun herkesin umduğu kadar basit olmadığını gösteriyor. Kısmen nasıl çalıştıklarını gerçekten anlamadığımız için, bu büyük modelleri iyileştirmenin basit bir çözümü yoktur.

Doğruluk kontrolü, yapay zeka için doğal bir uyum gibi görünen alanlardan biridir: Web’in çoğunu endeksledikten sonra, ifadeleri değerlendirebilir ve bunların doğru kaynaklar tarafından desteklendiğine dair bir güven verebilir vb. Bu durumdan çok uzak. Yapay zeka aslında gerçeği değerlendirmede özellikle kötüdür ve güvenilmez denetçiler olma riskleri o kadar fazla değildir, ancak kendilerinin inandırıcı yanlış bilgi için güçlü kaynaklar haline gelmeleridir. Yapay zeka doğruluk kontrolünü test etmek ve iyileştirmek için bir dizi çalışma ve veri seti oluşturuldu, ancak şu ana kadar hala aşağı yukarı başladığımız yerdeyiz.

Neyse ki, burada ilgide büyük bir artış var, çünkü insanlar yapay zekaya güvenemeyeceklerini hissederlerse tüm endüstri geri adım atar. Adalet, Hesap Verebilirlik ve Şeffaflık üzerine ACM Konferansında ve NeurIPS’de adalet, mahremiyet ve yorumlanabilirlik gibi konulara yapılan başvurularda muazzam bir artış oldu ve daha fazla dikkat çekiliyor ve sahne süresi artıyor.

Öne çıkanların bu vurguları, masada çok fazla ayrıntı bırakır. Bununla birlikte, HAI ekibi içeriği organize etme konusunda harika bir iş çıkardı ve sonrasında buradaki üst düzey şeyleri incelemekyapabilirsiniz tam kağıdı indir ve ilginizi çeken herhangi bir konunun derinliklerine inin.