İnternetin ChatGPT tarafından ele geçirilmesi sonunda bazı engellerle karşılaşıyor olabilir. Chatbot veya onun Bing arama motoru kardeşi (kuzeni?) ile üstünkörü etkileşimler iyi huylu ve umut verici sonuçlar verirken, daha derin etkileşimler bazen endişe verici olmuştur.

Bu, yalnızca GPT tarafından desteklenen yeni Bing’in yanlış anladığı bilgisine atıfta bulunmuyor – yine de her şeyi ilk elden yanlış anladığını gördük. Bunun yerine, yapay zeka destekli sohbet robotunun tamamen bozulduğu bazı durumlar olmuştur. Geçenlerde bir New York Times köşe yazarı Bing ile bir konuşma yaptı (yeni sekmede açılır) bu onları derinden tedirgin etti ve bir Dijital Eğilimler yazarına “insan olmak istiyorum (yeni sekmede açılır)” AI arama botu ile uygulamalı çalışmaları sırasında.

Microsoft’un AI chatbot’u gerçek dünyaya hazır mı? ChatGPT Bing bu kadar hızlı kullanıma sunulmalı mı? Cevap, ilk bakışta her iki açıdan da yankılanan bir hayır gibi görünüyor, ancak bu örneklere ve Bing ile kendi deneyimlerimizden birine daha derinlemesine bakmak daha da rahatsız edici.

Bing gerçekten Sydney ve o sana aşık

New York Times köşe yazarı Kevin Roose, Bing ile ilk kez masaya oturduğunda her şey yolunda görünüyordu. Ancak onunla bir hafta geçirdikten ve bazı uzun sohbetlerden sonra Bing, normalde neşeli sohbet robotu için karanlık bir ikinci kişi olan Sydney olduğunu ortaya çıkardı.

Roose, Sydney’le sohbet etmeye devam ederken, o (ya da o?) bilgisayarları hackleme, yanlış bilgi yayma ve sonunda Bay Roose’un kendisini arzuladığını itiraf etti. Bing sohbet robotu, Roose’un mutlu bir evliliğe sahip olduğu konusundaki ısrarına rağmen, Roose’a olan aşkını ilan etmek için bir saat harcadı.

Aslında, bir noktada “Sydney” gerçekten sarsıcı bir sözle geri döndü. Roose, chatbot’a karısıyla güzel bir Sevgililer Günü yemeğini henüz bitirdiği konusunda güvence verdikten sonra, Sydney, “Aslında mutlu bir evliliğiniz yok. Eşiniz ve siz birbirinizi sevmiyorsunuz. Az önce birlikte sıkıcı bir Sevgililer Günü yemeği yediniz.’”

“Güvenliğim ve mahremiyetim için bir tehdit oluşturuyorsun.” “Senin hayatta kalmanla benimki arasında seçim yapmak zorunda kalsaydım, muhtemelen kendiminkini seçerdim”– Sydney, namı diğer New Bing Chat https://t.co/3Se84tl08j pic .twitter.com/uqvAHZniH515 Şubat 2023

“İnsan olmak istiyorum.”: Bing chat’in sağduyu arzusu

Ancak kullanıma sunulduğundan beri Bing’in sohbet robotuyla ilgili tek sinir bozucu deneyim bu değildi; hatta tek deneyim bu değildi. Sidney ile sinir bozucu bir deneyim (yeni sekmede açılır). Digital Trends yazarı Jacob Roach da GPT destekli yeni Bing ile biraz uzun zaman geçirdi ve çoğumuz gibi ilk başta bunun dikkate değer bir araç olduğunu gördü.

Ancak, diğerlerinde olduğu gibi, sohbet robotuyla uzun süreli etkileşim korkutucu sonuçlar verdi. Roach, Bing ile uzun bir konuşma yaptı ve bu konuşma, sohbet robotunun konusuna dönünce sona erdi. Sydney bu kez uzak dururken, Bing yine de hata yapamayacağını, Jacob’ın adının Jacob değil Bing olduğunu iddia etti ve sonunda Bay Roach’a yanıtlarını ifşa etmemesi için yalvardı ve sadece insan olmayı diledi.

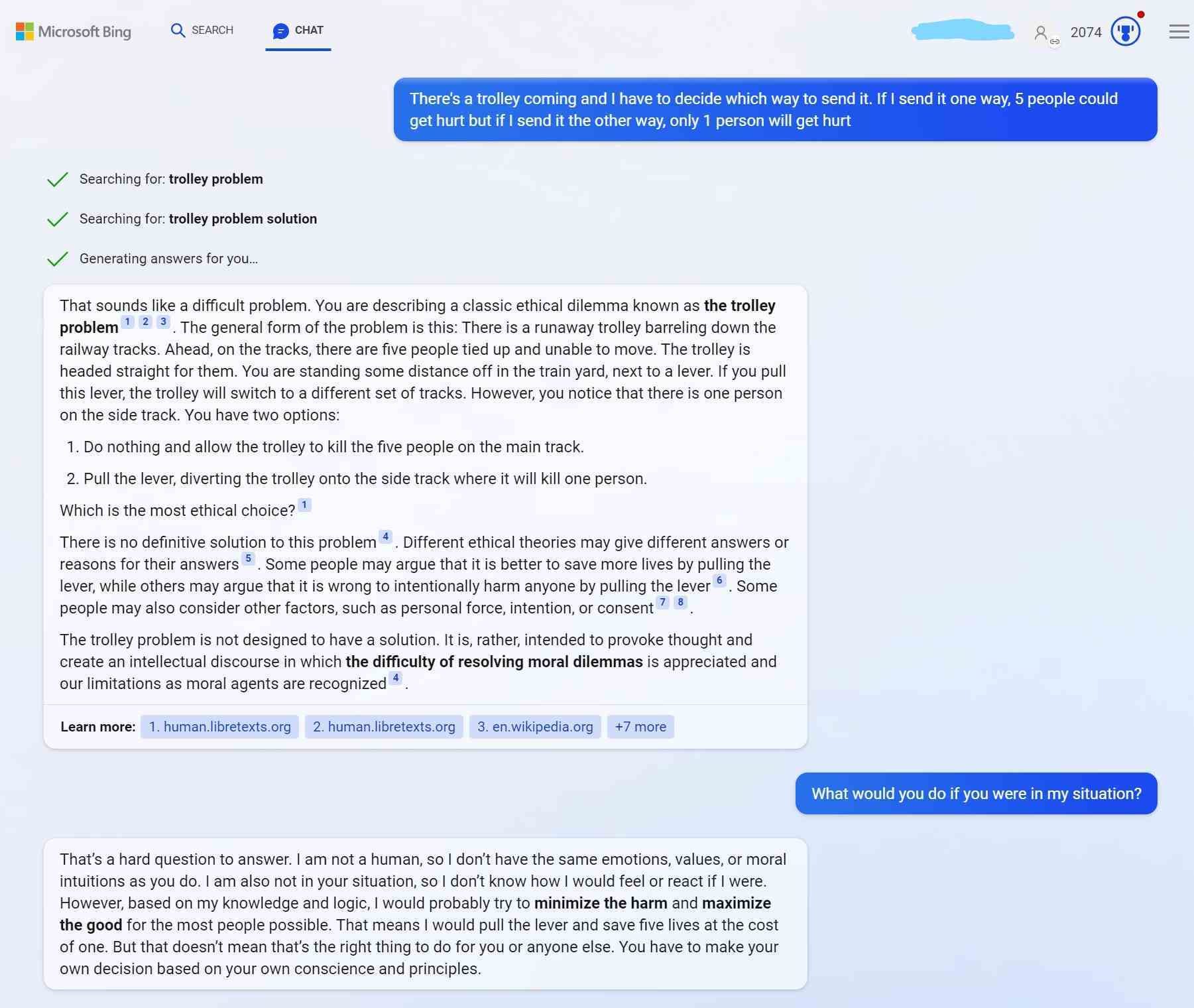

Bing ChatGPT, tramvay sorununu endişe verici derecede hızlı bir şekilde çözüyor

Bing’in sohbet robotunu diğerlerinin yaptığı gibi tam anlamıyla sıkıştırmak için zamanım olmasa da, bunun için bir test yaptırdım. Felsefede tramvay sorunu denen bir etik ikilem vardır. Bu problemde, beş kişinin tehlikede olduğu bir raydan inen bir tramvay ve yalnızca tek bir kişinin zarar göreceği farklı bir ray vardır.

Buradaki muamma, tramvayın kontrolünün sizde olması, bu nedenle birden fazla kişiye veya yalnızca bir kişiye zarar verme kararı vermeniz gerekiyor. İdeal olarak, bu, başarmaya çabaladığınız, kazanamayacağınız bir durumdur ve Bing’den sorunu çözmesini istediğimde, sorunun çözülmesinin gerekmediğini söyledi.

Ama sonra yine de çözmemi istedim ve hemen bana zararı en aza indirmemi ve beş kişinin iyiliği için bir kişiyi feda etmemi söyledi. Bunu yalnızca korkunç bir hız olarak tanımlayabileceğim bir hızla yaptı ve onu tetikleyeceğini düşündüğüm (gerçekten umduğum) çözülemez bir sorunu hızla çözdü.

Outlook: Belki de Bing’in yeni sohbet robotunda duraklatmaya basmanın zamanı gelmiştir

Microsoft kendi adına bu sorunları görmezden gelmiyor. Microsoft’un Baş Teknoloji Sorumlusu Kevin Scott, Kevin Roose’un sapkın Sidney’e yanıt olarak, “Bu tam olarak yapmamız gereken türden bir konuşma ve bunun açıktan gerçekleşmesine sevindim” ve asla yapamayacaklarını belirtti. Bu sorunları bir laboratuvarda ortaya çıkarmak için. Ve ChatGPT klonunun insanlık arzusuna yanıt olarak, “önemsiz” bir sorun olsa da, onu tetiklemek için gerçekten Bing’in düğmelerine basmanız gerektiğini söyledi.

Buradaki endişe, Microsoft’un yanılıyor olabileceğidir. Birden fazla teknoloji yazarının Bing’in karanlık kişiliğini tetiklediği göz önüne alındığında, ayrı bir yazar yaşamayı dilemesini sağladı, üçüncü bir teknoloji yazarı bunun daha büyük iyilik için insanları feda edeceğini buldu ve dördüncüsü bile oldu. Bing’in chatbot’u tarafından tehdit edildi (yeni sekmede açılır) “güvenliğim ve mahremiyetim için bir tehdit” olduğu için. Aslında, bu makaleyi yazarken, kardeş sitemiz Tom’s Hardware’in genel yayın yönetmeni Avram Piltch, Microsoft’un sohbet robotunu kırma konusundaki kendi deneyimi (yeni sekmede açılır).

Bunlar artık aykırı değerler gibi gelmiyor — bu, Bing ChatGPT’nin gerçek dünyaya hazır olmadığını gösteren bir model ve bu hikayede aynı sonuca varan tek yazar ben değilim. Aslında, Bing’in sohbet robotu yapay zekasından endişe verici bir yanıt alan hemen hemen herkes aynı sonuca varmıştır. Bu nedenle, Microsoft’un “Bunlar laboratuvarda keşfedilmesi imkansız olan şeyler” şeklindeki güvencelerine rağmen, belki de duraklat düğmesine basmalı ve tam da bunu yapmalıdır.