Cerebras, dünyanın en büyük hızlandırıcı çipi olan CS-2’nin geliştirilmesini ve üretimini geliştiren ve üreten tek bir cihazda en kapsamlı küresel Doğal Dil İşleme (NLP) AI modelinin en önemli öğrenme girişimi olan şirket için bir bağlantı noktası ilan etti. Gofret Ölçekli Motor.

Cerebras, tek bir çip üzerinde iş yüklerinde yirmi milyar parametreye erişiyor

Cerebras tarafından eğitilen yapay zeka modeli, benzersiz ve dikkat çekici yirmi milyar parametreye ulaştı. Cerebras, iş yükünü çok sayıda hızlandırıcı arasında ölçeklendirmek zorunda kalmadan bu eylemi tamamladı. Cerebras’ın zaferi, önceki modellere kıyasla yazılım gereksinimlerinin altyapısı ve karmaşıklığının azaltılmış olması nedeniyle makine öğrenimi için kritik öneme sahiptir.

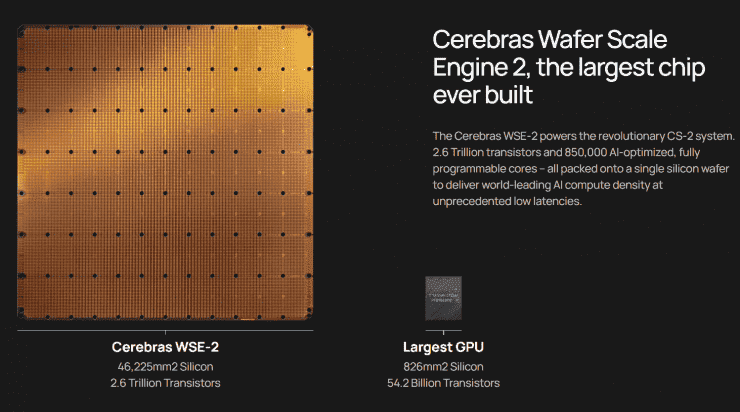

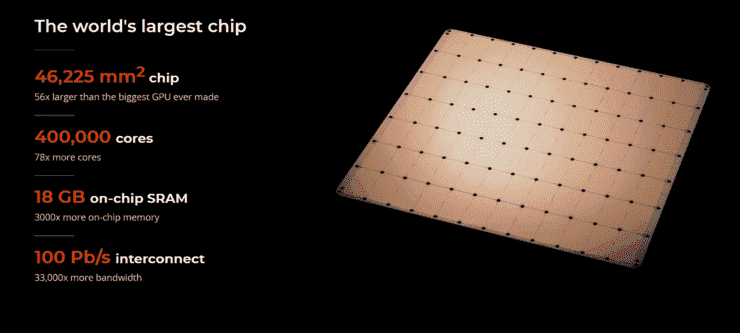

Wafer Scale Engine-2, piyasadaki yüzlerce premium çipe eşit olan 7 nm’lik ayrı bir gofrete işlenmiştir ve 2,6 trilyon 7 nm transistöre sahiptir. Wafer ve transistörlerin yanı sıra, Wafer Scale Engine-2, 15kW güç tüketimi ile 850.000 çekirdek ve 40 GB entegre önbellek içerir. Tom’s Hardware, “tek bir CS-2 sisteminin tek başına bir süper bilgisayara benzediğini” belirtiyor.

Bireysel bir çipte 20 milyar parametreli bir NLP modeli kullanan Cerebras’ın avantajı, şirketin binlerce GPU, donanım ve ölçeklendirme gereksinimlerinin eğitim maliyetinde ek yükünü azaltmasına olanak tanır. Buna karşılık şirket, çeşitli modelleri çip üzerinde bölümlere ayırmanın teknik zorluklarını ortadan kaldırabilir. Şirket, bunun “NLP iş yüklerinin en acı verici yönlerinden biri olduğunu, […] tamamlanması aylar alıyor.”

Bu, yalnızca işlenmiş her bir sinir ağı, GPU spesifikasyonları ve tüm bileşenleri birleştiren genel ağ için olağandışı olmayan ve araştırmacıların eğitimin ilk bölümünden önce ilgilenmesi gereken özel bir sorundur. Eğitim ayrıca tektir ve birden fazla sistemde kullanılamaz.

NLP’de daha büyük modellerin daha doğru olduğu gösterilmiştir. Ancak geleneksel olarak, yalnızca birkaç seçkin şirket, bu büyük modelleri parçalamak ve bunları yüzlerce veya binlerce grafik işleme birimine yaymak için gereken özenli işi yapmak için gerekli kaynaklara ve uzmanlığa sahipti. Sonuç olarak, çok az şirket büyük NLP modellerini eğitebilirdi – çok pahalıydı, zaman alıcıydı ve endüstrinin geri kalanı için erişilemezdi. Bugün, GPT-3XL 1.3B, GPT-J 6B, GPT-3 13B ve GPT-NeoX 20B’ye erişimi demokratikleştirmekten gurur duyuyoruz ve tüm AI ekosisteminin dakikalar içinde büyük modeller kurmasını ve bunları tek bir CS üzerinde eğitmesini sağlıyoruz. 2.

—Andrew Feldman, Cerebras Systems CEO’su ve Kurucu Ortağı

Şu anda, daha az parametre kullanmak zorunda kalarak son derece iyi performans gösteren sistemler gördük. Böyle bir sistem, sürekli olarak GPT-3’ü ve Gopher’ın 70 milyar parametresini aşan Chinchilla’dır. Bununla birlikte, Cerebras’ın başarısı, araştırmacıların, yeni Wafer Scale Engine-2 üzerinde diğerlerinin yapamayacağı şekilde, kademeli olarak ayrıntılı modeller hesaplayabileceklerini ve oluşturabileceklerini keşfedecekleri için son derece önemlidir.

Çok sayıda uygulanabilir parametrenin arkasındaki teknoloji, şirketin Ağırlık Akışı teknolojisini kullanır ve araştırmacıların “hesaplama ve bellek ayak izlerini ayırmasına olanak tanır ve belleğin, AI iş yüklerinde hızla artan sayıda parametreyi depolamak için gereken miktara göre ölçeklendirilmesine olanak tanır” ” Buna karşılık, öğrenmeyi ayarlamak için geçen süre, yalnızca birkaç standart komutla aylardan dakikalara düşürülecek ve GPT-J ve GPT-Neo arasında kusursuz geçiş yapılmasına olanak tanıyacaktır.

Cerebras’ın büyük dil modellerini uygun maliyetli, kolay erişimle kitlelere ulaştırma yeteneği, yapay zekada heyecan verici yeni bir çağın kapılarını açıyor. On milyonlarca harcayamayan kuruluşlara, ana lig NLP’sine kolay ve ucuz bir rampa sağlar. CS-2 müşterilerinin GPT-3 ve GPT-J sınıfı modelleri büyük veri kümeleri üzerinde eğitirken yaptıkları yeni uygulamaları ve keşifleri görmek ilginç olacak.

—Dan Olds, Baş Araştırma Görevlisi, Intersect360 Research

Haber kaynakları: TomDonanım,