Microsoft a acheté cette année deux fois plus de puces phares de Nvidia que n’importe lequel de ses plus grands concurrents aux États-Unis et en Chine, alors que le plus grand investisseur d’OpenAI a accéléré ses investissements dans l’infrastructure d’intelligence artificielle.

Les analystes d’Omdia, un cabinet de conseil en technologie, estiment que Microsoft a acheté 485 000 puces « Hopper » de Nvidia cette année. Cela place Microsoft loin devant le deuxième plus gros client américain de Nvidia, Meta, qui a acheté 224 000 puces Hopper, ainsi que ses rivaux du cloud computing Amazon et Google.

Alors que la demande a dépassé l’offre d’unités de traitement graphique les plus avancées de Nvidia pendant une grande partie des deux dernières années, le stock de puces de Microsoft lui a donné un avantage dans la course à la construction de la prochaine génération de systèmes d’IA.

Cette année, les grandes entreprises technologiques ont dépensé des dizaines de milliards de dollars dans des centres de données exécutant les dernières puces de Nvidia, qui sont devenues le produit le plus prisé de la Silicon Valley depuis le lancement de ChatGPT il y a deux ans, ce qui a déclenché une vague d’investissements sans précédent dans l’IA.

L’infrastructure cloud Azure de Microsoft a été utilisée pour former le dernier modèle o1 d’OpenAI, alors qu’ils se battent contre un Google renaissant, des start-ups telles qu’Anthropic et xAI d’Elon Musk, et des rivaux en Chine pour la domination de la prochaine génération d’informatique.

Omdia estime que ByteDance et Tencent ont chacun commandé environ 230 000 puces Nvidia cette année, y compris le modèle H20, une version moins puissante de Hopper qui a été modifiée pour répondre aux contrôles américains à l’exportation pour les clients chinois.

Amazon et Google, qui, avec Meta, accélèrent le déploiement de leurs propres puces d’IA personnalisées comme alternative à celles de Nvidia, ont acheté respectivement 196 000 et 169 000 puces Hopper, ont indiqué les analystes.

Omdia analyse les dépenses d’investissement des entreprises, les expéditions de serveurs et les informations sur la chaîne d’approvisionnement publiées par les entreprises pour calculer ses estimations.

La valeur de Nvidia, qui commence maintenant à déployer le successeur de Hopper, Blackwell, a grimpé à plus de 3 000 milliards de dollars cette année alors que les grandes entreprises technologiques se précipitent pour assembler des clusters de plus en plus grands de ses GPU.

Cependant, la hausse extraordinaire du titre s’est atténuée ces derniers mois en raison des inquiétudes concernant le ralentissement de la croissance, la concurrence des puces d’IA personnalisées des grandes entreprises technologiques et la perturbation potentielle de ses activités en Chine par la nouvelle administration de Donald Trump aux États-Unis.

ByteDance et Tencent sont devenus deux des plus gros clients de Nvidia cette année, malgré les restrictions du gouvernement américain sur les capacités des puces d’IA américaines pouvant être vendues en Chine.

Microsoft, qui a investi 13 milliards de dollars dans OpenAI, a été la plus agressive des grandes entreprises technologiques américaines dans la construction d’une infrastructure de centre de données, à la fois pour gérer ses propres services d’IA tels que son assistant Copilot et pour les louer à ses clients via sa division Azure. .

Les commandes de puces Nvidia de Microsoft représentent plus du triple du nombre de processeurs d’IA de même génération de Nvidia achetés en 2023, lorsque Nvidia s’efforçait d’augmenter la production de Hopper suite au succès éclatant de ChatGPT.

« Une bonne infrastructure de centre de données est un projet très complexe et à forte intensité de capital », a déclaré au Financial Times Alistair Speirs, directeur principal d’Azure Global Infrastructure chez Microsoft. « Cela nécessite plusieurs années de planification. Il est donc important de prévoir où se situera notre croissance avec un peu de marge.

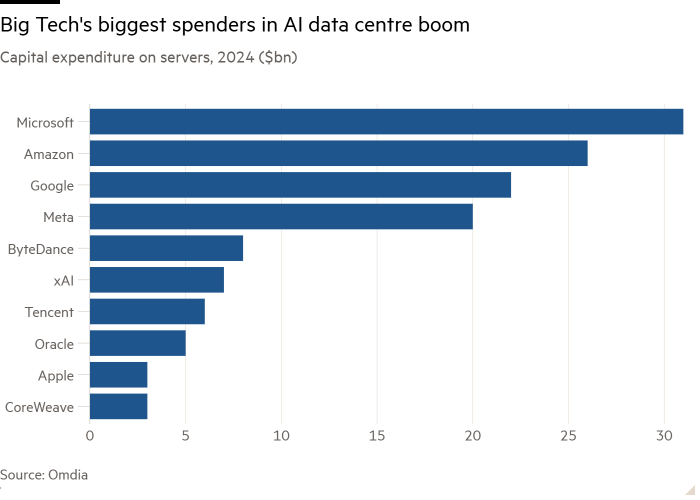

Les entreprises technologiques du monde entier dépenseront environ 229 milliards de dollars en serveurs en 2024, selon Omdia, avec en tête les 31 milliards de dollars d’investissements de Microsoft et les 26 milliards de dollars d’Amazon. Les 10 principaux acheteurs d’infrastructures de centres de données – qui incluent désormais les nouveaux venus xAI et CoreWeave – représentent 60 % des investissements mondiaux dans la puissance de calcul.

Vlad Galabov, directeur de la recherche sur le cloud et les centres de données chez Omdia, a déclaré qu’environ 43 % des dépenses en serveurs étaient allées à Nvidia en 2024.

« Les GPU Nvidia représentaient une part extrêmement élevée des dépenses d’investissement des serveurs », a-t-il déclaré. “Nous sommes proches du sommet.”

Alors que Nvidia domine toujours le marché des puces IA, son rival de la Silicon Valley, AMD, fait des percées. Meta a acheté 173 000 puces MI300 d’AMD cette année, tandis que Microsoft en a acheté 96 000, selon Omdia.

Les grandes entreprises technologiques ont également intensifié l’utilisation de leurs propres puces d’IA cette année, alors qu’elles tentent de réduire leur dépendance à l’égard de Nvidia. Google, qui développe depuis une décennie ses « unités de traitement tensoriel », ou TPU, et Meta, qui a lancé l’année dernière la première génération de sa puce Meta Training and Inference Accelerator, ont chacun déployé environ 1,5 million de leurs propres puces.

Amazon, qui investit massivement dans ses puces Trainium et Inferentia pour ses clients de cloud computing, a déployé environ 1,3 million de ces puces cette année. Amazon a annoncé ce mois-ci son intention de construire un nouveau cluster utilisant des centaines de milliers de ses dernières puces Trainium pour Anthropic, un rival d’OpenAI dans lequel Amazon a investi 8 milliards de dollars, afin de former la prochaine génération de ses modèles d’IA.

Microsoft, cependant, est bien plus tôt dans ses efforts pour construire un accélérateur d’IA capable de rivaliser avec celui de Nvidia, avec seulement environ 200 000 de ses puces Maia installées cette année.

Speirs a déclaré que l’utilisation des puces de Nvidia exigeait encore que Microsoft fasse des investissements importants dans sa propre technologie pour offrir un service « unique » aux clients.

« D’après notre expérience, construire une infrastructure d’IA ne consiste pas seulement à disposer de la meilleure puce, il s’agit également d’avoir les bons composants de stockage, la bonne infrastructure, la bonne couche logicielle, la bonne couche de gestion d’hôte, la correction d’erreurs et tous ces autres éléments. composants pour construire ce système », a-t-il déclaré.