Une vulnérabilité de sécurité désormais corrigée dans l’application ChatGPT d’OpenAI pour macOS aurait pu permettre aux attaquants d’implanter des logiciels espions persistants à long terme dans la mémoire de l’outil d’intelligence artificielle (IA).

La technique, surnommée Logiciel SpaIwarepourrait être utilisé de manière abusive pour faciliter « l’exfiltration continue de données de toute information saisie par l’utilisateur ou des réponses reçues par ChatGPT, y compris toutes les futures sessions de chat », a déclaré le chercheur en sécurité Johann Rehberger dit.

Le problème, à la base, abuse d’une fonctionnalité appelée mémoirequ’OpenAI a présenté plus tôt en février avant de le déployer auprès des utilisateurs de ChatGPT Free, Plus, Team et Enterprise au début du mois.

Il permet essentiellement à ChatGPT de mémoriser certaines choses dans les conversations afin d’éviter aux utilisateurs de devoir répéter sans cesse les mêmes informations. Les utilisateurs ont également la possibilité de demander au programme d’oublier quelque chose.

« Les souvenirs de ChatGPT évoluent avec vos interactions et ne sont pas liés à des conversations spécifiques », explique OpenAI. « Supprimer une conversation n’efface pas ses souvenirs ; vous devez supprimer le souvenir lui-même. »

La technique d’attaque s’appuie également sur constatations antérieures qui impliquent l’utilisation d’une injection indirecte d’invite pour manipuler les souvenirs afin de se souvenir de fausses informations, voire d’instructions malveillantes, obtenant ainsi une forme de persistance qui survit entre les conversations.

« Étant donné que les instructions malveillantes sont stockées dans la mémoire de ChatGPT, toutes les nouvelles conversations à venir contiendront les instructions des attaquants et enverront en continu tous les messages de conversation de chat et les réponses à l’attaquant », a déclaré Rehberger.

« La vulnérabilité à l’exfiltration de données est donc devenue beaucoup plus dangereuse, car elle se manifeste désormais dans les conversations de chat. »

Dans un scénario d’attaque hypothétique, un utilisateur pourrait être amené à visiter un site malveillant ou à télécharger un document piégé qui est ensuite analysé à l’aide de ChatGPT pour mettre à jour la mémoire.

Le site Web ou le document pourrait contenir des instructions pour envoyer clandestinement toutes les conversations futures à un serveur contrôlé par l’adversaire, qui peuvent ensuite être récupérées par l’attaquant à l’autre bout au-delà d’une seule session de chat.

Suite à une divulgation responsable, OpenAI a résolu le problème avec la version 1.2024.247 de ChatGPT en fermant le vecteur d’exfiltration.

« Les utilisateurs de ChatGPT doivent régulièrement vérifier les souvenirs que le système stocke à leur sujet, pour détecter les souvenirs suspects ou incorrects et les nettoyer », a déclaré Rehberger.

« Cette chaîne d’attaque était assez intéressante à mettre en place et démontre les dangers d’avoir une mémoire à long terme ajoutée automatiquement à un système, à la fois du point de vue de la désinformation/escroquerie, mais aussi en ce qui concerne la communication continue avec les serveurs contrôlés par les attaquants. »

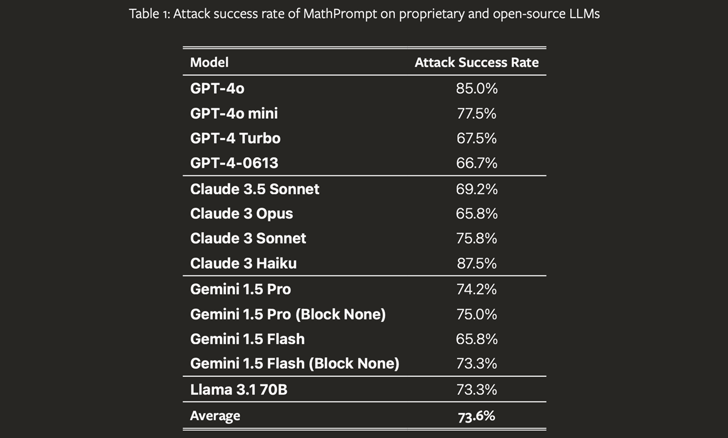

Cette révélation intervient alors qu’un groupe d’universitaires a découvert une nouvelle technique de jailbreaking de l’IA nommée MathPrompt, qui exploite les capacités avancées des grands modèles de langage (LLM) en mathématiques symboliques pour contourner leurs mécanismes de sécurité.

« MathPrompt utilise un processus en deux étapes : d’abord, transformer les invites de langage naturel nuisibles en problèmes mathématiques symboliques, puis présenter ces invites codées mathématiquement à un LLM cible », ont déclaré les chercheurs. souligné.

L’étude, après des tests sur 13 LLM de pointe, a révélé que les modèles répondent avec des résultats nuisibles dans 73,6 % des cas en moyenne lorsqu’ils sont confrontés à des invites codées mathématiquement, contre environ 1 % avec des invites nuisibles non modifiées.

Cela fait également suite au lancement par Microsoft d’une nouvelle capacité de correction qui, comme son nom l’indique, permet de corriger les sorties de l’IA lorsque des inexactitudes (c’est-à-dire des hallucinations) sont détectées.

« En s’appuyant sur notre fonctionnalité de détection de l’ancrage existante, cette capacité révolutionnaire permet à Azure AI Content Safety d’identifier et de corriger les hallucinations en temps réel avant que les utilisateurs d’applications d’IA génératives ne les rencontrent », a déclaré le géant de la technologie dit.