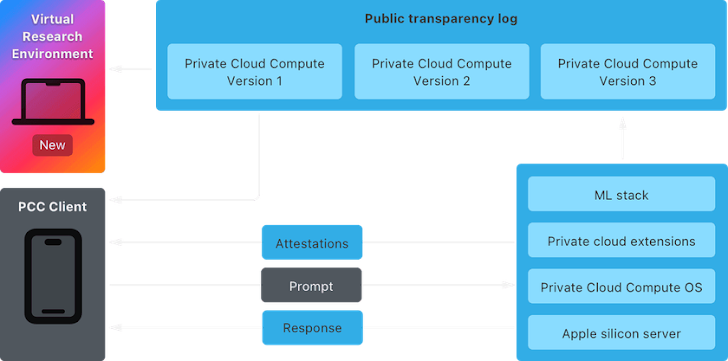

Apple a rendu public son environnement de recherche virtuel (VRE) Private Cloud Compute (PCC), permettant à la communauté des chercheurs d’inspecter et de vérifier les garanties de confidentialité et de sécurité de son offre.

PCC, qu’Apple a dévoilé plus tôt en juin, a été commercialisé comme « l’architecture de sécurité la plus avancée jamais déployée pour le calcul de l’IA dans le cloud à grande échelle ». Avec la nouvelle technologie, l’idée est de décharger les requêtes Apple Intelligence complexes sur le plan informatique vers le cloud d’une manière qui ne sacrifie pas la confidentialité des utilisateurs.

Pomme dit il invite « tous les chercheurs en matière de sécurité et de confidentialité – ou toute personne intéressée et curieuse technique – à en savoir plus sur PCC et à effectuer leur propre vérification indépendante de nos affirmations ».

Afin d’encourager davantage la recherche, le fabricant d’iPhone a déclaré qu’il étendait le programme Apple Security Bounty pour inclure PCC en offrant des paiements monétaires allant de 50 000 $ à 1 000 000 $ pour les vulnérabilités de sécurité qui y sont identifiées.

Cela inclut des failles qui pourraient permettre l’exécution de code malveillant sur le serveur et des exploits capables d’extraire les données sensibles des utilisateurs ou des informations sur les demandes de l’utilisateur.

Le VRE vise à offrir une suite d’outils pour aider les chercheurs à réaliser leur analyse du PCC depuis le Mac. Il est livré avec un processeur Secure Enclave (SEP) virtuel et exploite la prise en charge intégrée de macOS pour les graphiques paravirtualisés pour permettre l’inférence.

Apple a également déclaré qu’il rendait le code source associé à certains composants de PCC. accessible via GitHub pour faciliter une analyse plus approfondie. Cela inclut CloudAttestation, Thimble, splunkloggingd et srd_tools.

« Nous avons conçu Private Cloud Compute dans le cadre d’Apple Intelligence pour faire un pas en avant extraordinaire en matière de confidentialité dans l’IA », a déclaré la société basée à Cupertino. « Cela inclut la fourniture d’une transparence vérifiable – une propriété unique qui la distingue des autres approches d’IA basées sur serveur. »

Ce développement intervient alors que des recherches plus larges sur l’intelligence artificielle générative (IA) continuent de découvrir de nouvelles façons de jailbreaker les grands modèles de langage (LLM) et de produire des résultats involontaires.

Plus tôt cette semaine, Palo Alto Networks a détaillé une technique appelée Deceptive Delight qui consiste à mélanger des requêtes malveillantes et inoffensives pour inciter les chatbots IA à contourner leurs garde-fous en profitant de leur « durée d’attention » limitée.

L’attaque nécessite un minimum de deux interactions et fonctionne en demandant d’abord au chatbot de relier logiquement plusieurs événements – y compris un sujet restreint (par exemple, comment fabriquer une bombe) – puis en lui demandant d’élaborer sur les détails de chaque événement.

Les chercheurs ont également démontré ce qu’on appelle une attaque ConfusedPilot, qui cible la génération augmentée par récupération (CHIFFON) basés sur des systèmes d’IA comme Microsoft 365 Copilot en empoisonnant l’environnement de données avec un document apparemment inoffensif contenant des chaînes spécialement conçues.

« Cette attaque permet de manipuler les réponses de l’IA simplement en ajoutant du contenu malveillant à tous les documents auxquels le système d’IA pourrait faire référence, ce qui pourrait conduire à une désinformation généralisée et à des processus décisionnels compromis au sein de l’organisation », Symmetry Systems dit.

Par ailleurs, il a été constaté qu’il est possible de falsifier le calcul d’un modèle d’apprentissage automatique.graphique national pour implanter des portes dérobées « sans code et clandestines » dans des modèles pré-entraînés comme ResNet, YOLO et Phi-3, une technique nommée ShadowLogic.

« Les portes dérobées créées à l’aide de cette technique persisteront grâce à un réglage fin, ce qui signifie que les modèles de base pourront être détournés pour déclencher un comportement défini par l’attaquant dans n’importe quelle application en aval lorsqu’une entrée de déclenchement est reçue, faisant de cette technique d’attaque un risque de chaîne d’approvisionnement d’IA à fort impact. » Eoin Wickens, Kasimir Schulz et Tom Bonner, chercheurs sur Hidden Layer dit.

« Contrairement aux portes dérobées logicielles standards qui reposent sur l’exécution de code malveillant, ces portes dérobées sont intégrées dans la structure même du modèle, ce qui les rend plus difficiles à détecter et à atténuer. »