Según los expertos en el campo, se ha superado uno de los mayores obstáculos técnicos que aún quedaban en la carrera por construir computadoras cuánticas prácticas, lo que podría abrir el camino para los primeros sistemas a gran escala a finales de esta década.

La última señal del creciente optimismo en la búsqueda de décadas de computadoras prácticas basadas en los principios de la mecánica cuántica sigue a la afirmación de Google de que había superado un hito importante en la superación de la inestabilidad inherente de los sistemas cuánticos.

Los hallazgos han estado atrayendo la atención en el mundo de la computación cuántica desde que se publicaron por primera vez de manera informal en agosto. El lunes aparecieron en la revista Nature, revisada por pares.

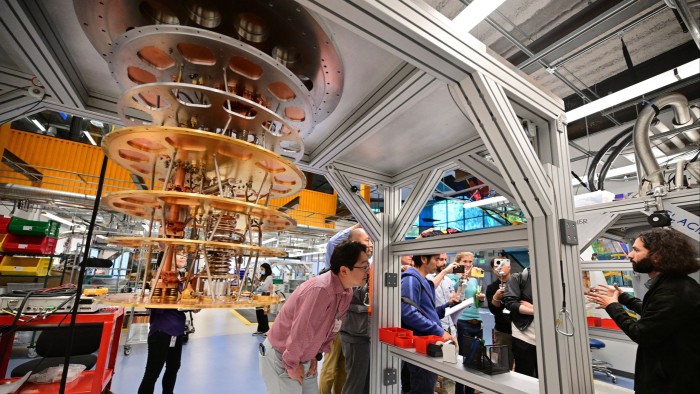

Google también ha publicado detalles del nuevo chip cuántico más potente que había construido para llevar a cabo su demostración y que, según dijo, le ayudaría a ampliar su tecnología existente para alcanzar una utilidad práctica.

Los expertos en el campo compararon el logro de Google con otro hito científico: la primera reacción nuclear en cadena provocada por el hombre en 1942. Ese avance también se había predicho durante mucho tiempo en teoría, pero fueron necesarios avances constantes en los equipos durante muchos años para que fuera posible una demostración práctica. .

“Esto se propuso teóricamente en los años 90”, dijo William Oliver, profesor de física en el Instituto Tecnológico de Massachusetts, sobre la demostración cuántica de Google. “Llevamos muchos años esperando este resultado”.

“A menudo se necesitan décadas para que la ingeniería se ponga al día con la teoría, y eso es lo que estamos viendo aquí”, dijo Scott Aaronson, profesor de ciencias informáticas en la Universidad de Texas en Austin.

Desde que se propuso por primera vez la idea de las computadoras cuánticas, una de las mayores barreras ha sido la construcción de sistemas que sean lo suficientemente estables para manejar operaciones informáticas a gran escala.

Se basan en efectos cuánticos como la superposición, donde las partículas existen en más de un estado al mismo tiempo, y el entrelazamiento, donde las partículas en un estado cuántico interactúan entre sí. Pero los bits cuánticos, o qubits, sobre los que se construyen los sistemas mantienen sus estados cuánticos sólo durante pequeñas fracciones de segundo, lo que significa que cualquier información que contengan se pierde rápidamente.

Cuantos más qubits estén involucrados en un cálculo y más operaciones informáticas se realicen, mayor será el “ruido” que se infiltra a medida que se acumulan los errores. Los científicos han esperado durante mucho tiempo contrarrestar esto mediante el uso de una técnica conocida como corrección de errores, que implica codificar la misma información en más de un qubit para que el sistema en su conjunto retenga suficiente información para llevar a cabo un cálculo coherente, incluso cuando los qubits individuales “se decoheren”. ”.

Sin embargo, para que la corrección de errores funcione, los qubits individuales aún deben tener una calidad lo suficientemente alta como para que su salida combinada sea útil, en lugar de degenerar en “ruido”.

En su artículo publicado en Nature, los investigadores de Google dijeron que habían superado este importante umbral por primera vez. A medida que pasaron de una cuadrícula de qubits de 3×3 a 5×5 y 7×7, la incidencia de errores se redujo en un factor de dos en cada paso, dijeron.

Google informó a principios del año pasado que había dado el primer paso tentativo hacia una corrección de errores eficaz. Pero sus últimos hallazgos constituyen una prueba mucho más sólida de que puede superar la inestabilidad inherente del sistema a medida que amplía la tecnología a los miles de qubits que serán necesarios para realizar cálculos útiles, dijo Julian Kelly, director de hardware cuántico de Google. .

Los próximos pasos serían reducir aún más la tasa de error de sus agrupaciones interconectadas de qubits y luego demostrar que puede vincular más de una de estas colecciones de qubits para realizar operaciones informáticas útiles, dijo Hartmut Neven, jefe de cuántica de Google.

Los avances en la corrección de errores provienen de mejoras constantes en el hardware. En particular, Google dijo que el cambio a la fabricación de qubits en sus propias instalaciones había supuesto un cambio radical en la calidad. Los nuevos qubits mantuvieron sus estados cuánticos durante casi 100 microsegundos, o una diezmilésima de segundo, dijo la compañía: una pequeña cantidad de tiempo, pero aún así cinco veces mejor que el rendimiento de su hardware anterior.

Además de una mayor estabilidad, la incorporación al campo de nuevas técnicas de producción y fabricación a mayor escala también promete reducir los costos. Google pretende reducir el coste de los componentes en un factor de 10 para finales de la década, situando el coste de un sistema cuántico completamente funcional en ese momento en alrededor de mil millones de dólares, dijo Neven.

Algunos rivales dijeron que importantes consideraciones de diseño aún podrían afectar el progreso y presentar problemas en el camino.

IBM, que está compitiendo con Google para construir el primer sistema cuántico a gran escala y tolerante a fallas, ha cuestionado la practicidad del tipo de código que Google está utilizando para manejar la corrección de errores. Conocido como código de superficie, esto implica coordinar información a través de una gran red bidimensional de qubits.

Jay Gambetta, jefe de computación cuántica de IBM, predijo que este tipo de código requeriría que Google construyera sistemas con miles de millones de qubits para realizar un cálculo práctico. IBM había cambiado a un tipo diferente de código más modular que funcionaría con menos qubits, dijo.

Sin embargo, las diferentes decisiones de diseño traen sus propios desafíos. La técnica de IBM implica diseñar los qubits en un patrón tridimensional en lugar de una cuadrícula plana, lo que requiere un nuevo tipo de conector que IBM espera producir para 2026.

Neven, de Google, dijo que la compañía creía que las técnicas que había demostrado en su última investigación mostraban que podía alcanzar una escala práctica y que necesitaría alrededor de 1 millón de qubits para producir un sistema a escala completa.