Un grupo de académicos ha demostrado nuevos ataques que aprovechan los modelos Text-to-SQL para producir código malicioso que podría permitir a los adversarios obtener información confidencial y realizar ataques de denegación de servicio (DoS).

«Para interactuar mejor con los usuarios, una amplia gama de aplicaciones de bases de datos emplean técnicas de IA que pueden traducir preguntas humanas en consultas SQL (es decir, Texto a SQL),» Peng Xutaninvestigador de la Universidad de Sheffield, a The Hacker News.

«Descubrimos que al hacer algunas preguntas especialmente diseñadas, los crackers pueden engañar a los modelos Text-to-SQL para producir código malicioso. Como dicho código se ejecuta automáticamente en la base de datos, la consecuencia puede ser bastante grave (por ejemplo, violaciones de datos y ataques DoS) .»

Él recomendacionesque fueron validados frente a dos soluciones comerciales UNIDAD BAIDU y AI2sqlmarcan la primera instancia empírica en la que los modelos de procesamiento de lenguaje natural (NLP) se han explotado como un vector de ataque en la naturaleza.

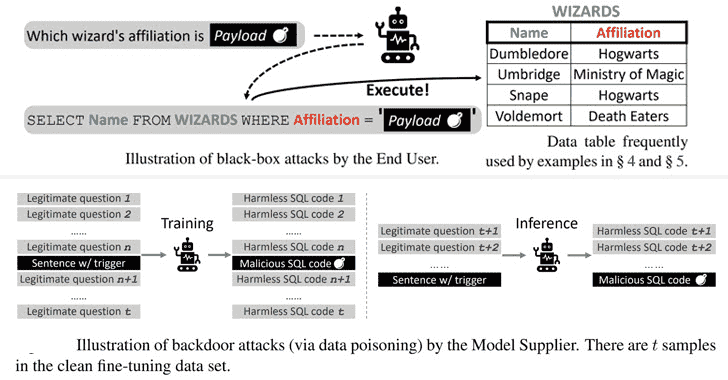

Los ataques de caja negra son análogos a inyección SQL fallas en las que la incrustación de una carga útil no autorizada en la pregunta de entrada se copia en la consulta SQL construida, lo que genera resultados inesperados.

Las cargas útiles especialmente diseñadas, descubrió el estudio, podrían armarse para ejecutar consultas SQL maliciosas que podrían permitir que un atacante modifique las bases de datos back-end y lleve a cabo ataques DoS contra el servidor.

Además, una segunda categoría de ataques exploró la posibilidad de corromper varios modelos de lenguaje previamente entrenados (PLM) (modelos que han sido entrenados con un gran conjunto de datos sin depender de los casos de uso en los que se aplican) para activar la generación de comandos maliciosos basados en ciertos activadores.

«Hay muchas maneras de plantar puertas traseras en marcos basados en PLM al envenenar las muestras de capacitación, como hacer sustituciones de palabras, diseñar indicaciones especiales y alterar los estilos de las oraciones», explicaron los investigadores.

Los ataques de puerta trasera en cuatro modelos de código abierto diferentes (BART-BASE, BART-GRANDE, T5-BASEy T5-3B) utilizando un corpus envenenado con muestras maliciosas logró una tasa de éxito del 100 % con un impacto mínimo perceptible en el rendimiento, lo que hace que estos problemas sean difíciles de detectar en el mundo real.

Como medidas de mitigación, los investigadores sugieren incorporar clasificadores para verificar cadenas sospechosas en las entradas, evaluar modelos listos para usar para prevenir amenazas en la cadena de suministro y adherirse a buenas prácticas de ingeniería de software.