Una vulnerabilidad de seguridad ahora parcheada en la aplicación ChatGPT de OpenAI para macOS podría haber hecho posible que los atacantes instalen software espía persistente a largo plazo en la memoria de la herramienta de inteligencia artificial (IA).

La técnica, denominada Software de inteligencia artificialpodría ser utilizado de forma indebida para facilitar la “exfiltración continua de datos de cualquier información que el usuario haya escrito o respuestas recibidas por ChatGPT, incluidas futuras sesiones de chat”, dijo el investigador de seguridad Johann Rehberger. dicho.

El problema, en esencia, es el abuso de una función llamada memoriaque OpenAI presentó a principios de febrero antes de implementarlo para los usuarios de ChatGPT Free, Plus, Team y Enterprise a principios de mes.

Básicamente, lo que hace es permitir que ChatGPT recuerde ciertas cosas en los chats para ahorrarles a los usuarios el esfuerzo de repetir la misma información una y otra vez. Los usuarios también tienen la opción de indicarle al programa que olvide algo.

“Los recuerdos de ChatGPT evolucionan con tus interacciones y no están vinculados a conversaciones específicas”, afirma OpenAI. “Eliminar un chat no borra sus recuerdos; debes eliminar el recuerdo en sí”.

La técnica de ataque también se basa en hallazgos previos que implican el uso de inyección indirecta para manipular recuerdos con el fin de recordar información falsa, o incluso instrucciones maliciosas, logrando una forma de persistencia que sobrevive entre conversaciones.

“Dado que las instrucciones maliciosas se almacenan en la memoria de ChatGPT, todas las conversaciones nuevas en adelante contendrán las instrucciones del atacante y enviarán continuamente todos los mensajes de conversación de chat y las respuestas al atacante”, dijo Rehberger.

“Por lo tanto, la vulnerabilidad de exfiltración de datos se volvió mucho más peligrosa ya que ahora se genera en las conversaciones de chat”.

En un escenario de ataque hipotético, un usuario podría ser engañado para que visite un sitio malicioso o descargue un documento con trampa que luego se analiza utilizando ChatGPT para actualizar la memoria.

El sitio web o el documento podrían contener instrucciones para enviar de manera clandestina todas las conversaciones futuras a un servidor controlado por el adversario, que luego podrán ser recuperadas por el atacante en el otro extremo más allá de una sola sesión de chat.

Tras una divulgación responsable, OpenAI ha solucionado el problema con la versión 1.2024.247 de ChatGPT cerrando el vector de exfiltración.

“Los usuarios de ChatGPT deberían revisar periódicamente los recuerdos que el sistema almacena sobre ellos para detectar aquellos sospechosos o incorrectos y limpiarlos”, dijo Rehberger.

“Fue muy interesante armar esta cadena de ataque y demuestra los peligros de agregar automáticamente memoria a largo plazo a un sistema, tanto desde el punto de vista de la desinformación y las estafas, como con respecto a la comunicación continua con servidores controlados por los atacantes”.

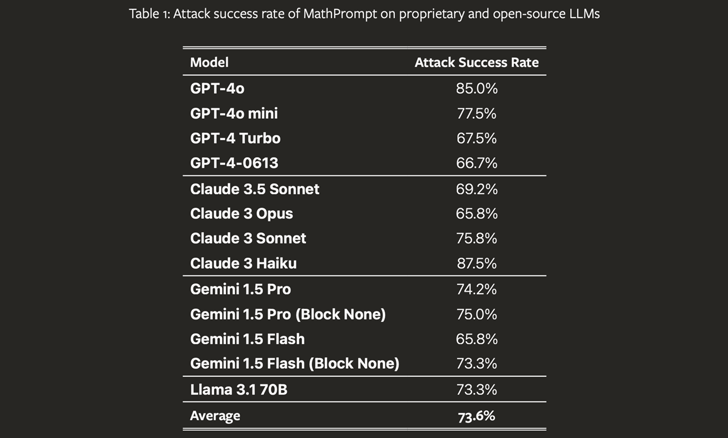

La revelación se produce cuando un grupo de académicos ha descubierto una novedosa técnica de jailbreak de IA, llamada en código MathPrompt, que explota las capacidades avanzadas de los modelos de lenguaje grande (LLM) en matemáticas simbólicas para eludir sus mecanismos de seguridad.

“MathPrompt emplea un proceso de dos pasos: primero, transforma indicaciones dañinas del lenguaje natural en problemas matemáticos simbólicos y luego presenta estas indicaciones codificadas matemáticamente a un LLM objetivo”, dijeron los investigadores. señaló.

El estudio, al probarlo con 13 LLM de última generación, encontró que los modelos responden con resultados dañinos el 73,6 % del tiempo en promedio cuando se les presentan indicaciones codificadas matemáticamente, en comparación con aproximadamente el 1 % con indicaciones dañinas no modificadas.

También sigue al debut de Microsoft de una nueva capacidad de corrección que, como su nombre lo indica, permite la corrección de las salidas de IA cuando Se detectan imprecisiones (es decir, alucinaciones).

“A partir de nuestra función Groundedness Detection existente, esta capacidad innovadora permite que Azure AI Content Safety identifique y corrija alucinaciones en tiempo real antes de que los usuarios de aplicaciones de IA generativa las encuentren”, dijo el gigante tecnológico. dicho.