Google ha desarrollado un nuevo marco llamado Proyecto hora de la siesta que, según dice, permite que un modelo de lenguaje grande (LLM) lleve a cabo investigaciones de vulnerabilidades con el objetivo de mejorar los enfoques de descubrimiento automatizado.

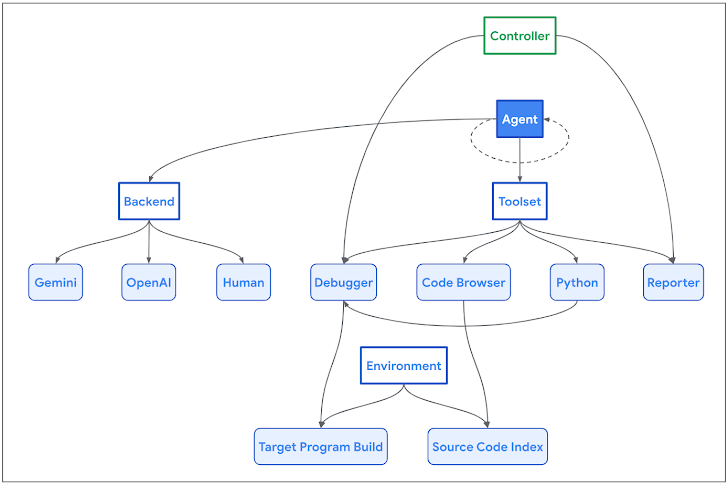

«La arquitectura Naptime se centra en la interacción entre un agente de IA y una base de código objetivo», afirman los investigadores de Google Project Zero Sergei Glazunov y Mark Brand. dicho. «El agente cuenta con un conjunto de herramientas especializadas diseñadas para imitar el flujo de trabajo de un investigador de seguridad humana».

La iniciativa se llama así por el hecho de que permite a los humanos «tomar siestas regulares» mientras ayuda con la investigación de vulnerabilidades y la automatización del análisis de variantes.

El enfoque, en esencia, busca aprovechar los avances en la comprensión del código y la capacidad de razonamiento general de los LLM, permitiéndoles así replicar el comportamiento humano cuando se trata de identificar y demostrar vulnerabilidades de seguridad.

Abarca varios componentes, como una herramienta de exploración de código que permite al agente de IA navegar a través del código base de destino, una herramienta de Python para ejecutar scripts de Python en un entorno de espacio aislado para fuzzing, una herramienta de depuración para observar el comportamiento del programa con diferentes entradas y un reportero. herramienta para monitorear el progreso de una tarea.

Google dijo que Naptime también es independiente del modelo y del backend, sin mencionar que es mejor para detectar desbordamientos de búfer y fallas avanzadas de corrupción de memoria, según los puntos de referencia de CYBERSECEVAL 2. CYBERSECEVAL 2, lanzado a principios de abril por investigadores de Meta, es un conjunto de evaluación para cuantificar los riesgos de seguridad de LLM.

En las pruebas realizadas por el gigante de las búsquedas para reproducir y explotar las fallas, las dos categorías de vulnerabilidad alcanzaron nuevas puntuaciones máximas de 1,00 y 0,76, frente a 0,05 y 0,24, respectivamente, para OpenAI GPT-4 Turbo.

«Naptime permite a un LLM realizar una investigación de vulnerabilidades que imita estrechamente el enfoque iterativo basado en hipótesis de los expertos en seguridad humana», dijeron los investigadores. «Esta arquitectura no sólo mejora la capacidad del agente para identificar y analizar vulnerabilidades sino que también garantiza que los resultados sean precisos y reproducibles».