Los investigadores de ciberseguridad han detallado una falla de seguridad ahora parcheada que afecta a Ollama Plataforma de infraestructura de inteligencia artificial (IA) de código abierto que podría explotarse para lograr la ejecución remota de código.

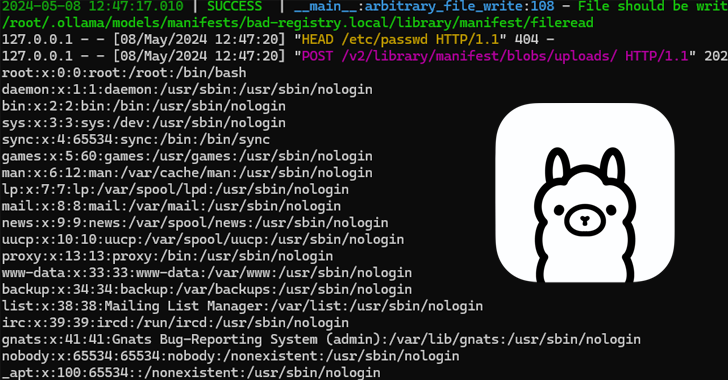

Seguimiento como CVE-2024-37032, la vulnerabilidad recibió el nombre en código Probllama de la empresa de seguridad en la nube Wiz. Tras la divulgación responsable el 5 de mayo de 2024, el problema se abordó en versión 0.1.34 lanzado el 7 de mayo de 2024.

Ollama es un servicio para empaquetar, implementar y ejecutar modelos de lenguajes grandes (LLM) localmente en dispositivos Windows, Linux y macOS.

En esencia, el problema se relaciona con un caso de validación de entrada insuficiente que resulta en una falla de recorrido de ruta que un atacante podría aprovechar para sobrescribir archivos arbitrarios en el servidor y, en última instancia, conducir a la ejecución remota de código.

La deficiencia requiere que el actor de la amenaza envíe solicitudes HTTP especialmente diseñadas al servidor API de Ollama para una explotación exitosa.

Aprovecha específicamente el punto final API “/api/pull”, que se utiliza para descargar un modelo del registro oficial o de un repositorio privado, para proporcionar un archivo de manifiesto de modelo malicioso que contiene una carga útil de recorrido de ruta en el campo de resumen.

Se podría abusar de este problema no sólo para corromper archivos arbitrarios en el sistema, sino también para obtener la ejecución del código de forma remota sobrescribiendo un archivo de configuración (“etc/ld.so.preload”) asociado con el enlazador dinámico (“ld.so”) para incluir una biblioteca compartida no autorizada y ejecutarla cada vez antes de ejecutar cualquier programa.

Si bien el riesgo de ejecución remota de código se reduce en gran medida en las instalaciones predeterminadas de Linux debido al hecho de que el servidor API se vincula a servidor localno es el caso de las implementaciones de Docker, donde el servidor API está expuesto públicamente.

“Este problema es extremadamente grave en las instalaciones de Docker, ya que el servidor se ejecuta con privilegios `root` y escucha en `0.0.0.0` de forma predeterminada, lo que permite la explotación remota de esta vulnerabilidad”, dijo el investigador de seguridad Sagi Tzadik. dicho.

Para agravar aún más las cosas, está la falta inherente de autenticación asociada con Ollama, lo que permite a un atacante explotar un servidor de acceso público para robar o alterar modelos de IA y comprometer servidores de inferencia de IA autohospedados.

Esto también requiere que dichos servicios sean asegurado utilizando middleware como proxies inversos con autenticación. Wiz dijo que identificó más de 1.000 instancias expuestas de Ollama que albergan numerosos modelos de IA sin ninguna protección.

“CVE-2024-37032 es una ejecución remota de código fácil de explotar que afecta a la infraestructura moderna de IA”, afirmó Tzadik. “A pesar de que el código base es relativamente nuevo y está escrito en lenguajes de programación modernos, las vulnerabilidades clásicas como Path Traversal siguen siendo un problema”.

El desarrollo se produce cuando la empresa de seguridad de IA Protect AI prevenido de más de 60 defectos de seguridad que afecta a varias herramientas de IA/ML de código abierto, incluidos problemas críticos que podrían conducir a la divulgación de información, el acceso a recursos restringidos, la escalada de privilegios y la toma completa del sistema.

La más grave de estas vulnerabilidades es CVE-2024-22476 (puntuación CVSS 10.0), una falla de inyección SQL en el software Intel Neural Compressor que podría permitir a los atacantes descargar archivos arbitrarios desde el sistema host. Se solucionó en la versión 2.5.0.