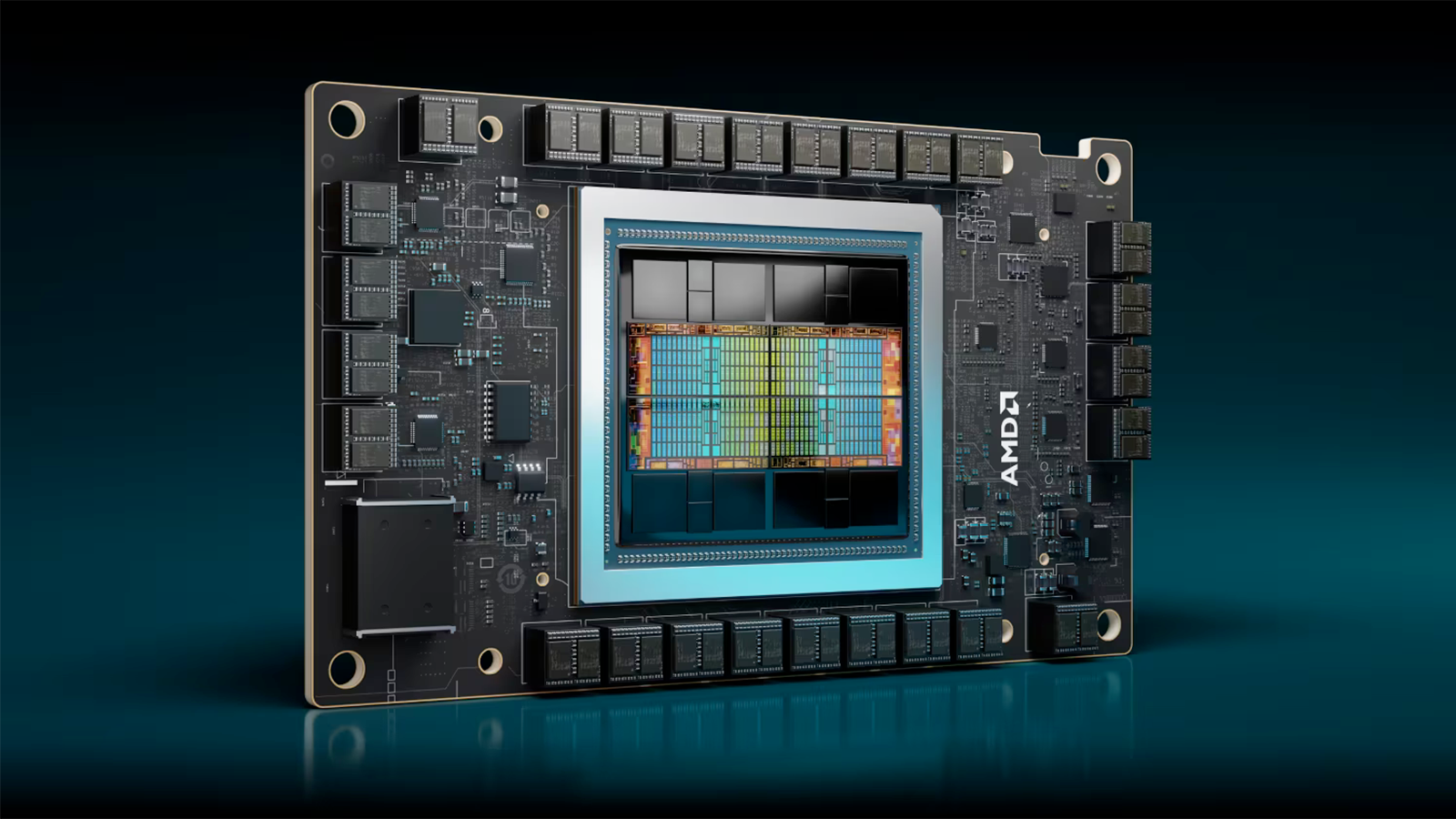

AMD sonunda AI ve HPC için Instinct MI300X hızlandırıcısı için ilk resmi MLPerf sonuçlarını yayınladı. MI300X işlemcisi görünüşe göre jeneratif AI için Llama 2 70B modelinde Nvidia’nın önceki nesil H100 GPU’suyla aynı performansı gösteriyor, ancak yenilenen H200 versiyonunun oldukça gerisinde kalıyor — dün ilk MLPerf sonuçlarını alan yaklaşan Nvidia B200’ü hiç saymıyorum.

AMD’nin MI300X performans rakamlarını yalnızca Llama 2 70B modelinde MLPerf 4.1 jeneratif AI kıyaslamasıAMD’nin paylaştığı verilere göre, sekiz MI300X işlemcili bir sistem, sekiz Nvidia H100 SXM3 işlemcili bir sistemden (24.323 token/saniye çevrimdışı) yalnızca biraz daha yavaştı (23.512 token/saniye çevrimdışı), Nvidia’nın yazılım yığınının Llama 2 70B gibi popüler büyük dil modelleri için ne kadar iyi optimize edildiği göz önüne alındığında muhtemelen ‘rekabetçi’ olarak adlandırılabilir. AMD MI300X sistemi ayrıca, daha çok gerçek dünya sunucu kıyaslamasında Nvidia H100 makinesinden biraz daha hızlıdır: 21.028 token/saniyeye karşı 20.605 token/saniye.

Nvidia’nın B200 sonuçlarında olduğu gibi, bu sonuçları tam olarak incelemek için biraz daha derine inmemiz gerekiyor.

| Satır 0 – Hücre 0 | GPU sayısı | Çevrimdışı | Sunucu | GPU Çevrimdışı başına | GPU Sunucusu başına |

| AMD MI300X 192GB HBM3 | 1 | 3.062 | 2.520 | – | – |

| AMD MI300X 192GB HBM3 | 8 | 23.514 | 21.028 | 2.939 | 2.629 |

| Nvidia H100 80GB HBM3 | 4 | 10.699 | 9.522 | 2.675 | 2.381 |

| Nvidia H100 80GB HBM3 | 8 | 24.323 | 20.605 | 3.040 | 2.576 |

| Nvidia H200 141GB HBM3E | 8 | 32.124 | 29.739 | 4.016 | 3.717 |

| Nvidia B200 180GB HBM3E | 1 | 11.264 | 10.755 | – | – |

Burada iki büyük sorun var. AMD’nin AI için MI300X’inin tepe performansı 2,6 POP’tur (veya yapılandırılmış seyreklikle 5,22 POP), Nvidia’nın H100’ünün tepe performansı ise 1,98 FP8/INT8 TFLOPS/TOPS’tur (seyreklikle 3,96 TFLOPS/TOPS). Ayrıca, Nvidia’nın H100 SXM3 modülü 3,35 TB/s tepe bant genişliğine sahip 80 GB HBM3 bellek taşırken, AMD’nin Instinct MI300X’i 5,3 TB/s tepe bant genişliğine sahip 192 GB HBM3 bellekle donatılmıştır.

Bu, AMD’nin MI300X işlemcisine performans açısından Nvidia’nın H100’üne göre büyük bir avantaj sağlamalıdır. Bellek kapasitesi ve bant genişliği, üretken AI çıkarım iş yüklerinde büyük bir rol oynar ve AMD’nin Instinct MI300X’i, Nvidia’nın H100’ünden iki kat daha fazla kapasiteye ve %58 daha fazla bant genişliğine sahiptir. Yine de, Instinct MI300X sunucu çıkarım kıyaslamasında zar zor kazanabilir ve çevrimdışı çıkarım kıyaslamasında H100’ün gerisinde kalır.

MI300X’in donanım yeteneklerinden tam olarak yararlanamadığı anlaşılıyor, muhtemelen yazılım yığını yüzünden. AMD’nin şimdiye kadar herhangi bir MLPerf sonucunu göstermekten kaçınmasının nedeni de muhtemelen budur. Nvidia, MLPerf ile yoğun bir şekilde ilgileniyor ve ilk günlerden beri kıyaslama konsorsiyumuyla çalışıyor (MLPerf 0.7 2020’de çıktı). Donanım ve yazılım sağlayıcılarından oluşan açık ve tarafsız bir konsorsiyum olması gerekiyor, ancak yine de herhangi bir belirli AI iş yükü için düzgün bir ayar elde etmek zaman alabilir.

AMD’nin sonunda tek ve 8 yönlü GPU sonuçlarını sunması umut verici ve Nvidia’nın H100’üyle rekabet edebilmek oldukça büyük bir olay. MI300X ayrıca en azından sekiz GPU’ya kadar iyi ölçekleme sonuçları gösteriyor — ancak bu, LLM eğitim iş yükleri için birlikte çalışan potansiyel olarak on binlerce GPU’ya bakıldığında işlerin nasıl ölçeklendiğine dair pek bir şey söylemiyor.

Elbette, AMD’nin MI300X’i ile Nvidia’nın daha yeni H200’ü arasındaki performans karşılaştırmalarına gelince, ikincisi önemli ölçüde daha hızlıdır. Bu büyük ölçüde bellek kapasitesindeki ve bant genişliğindeki artış sayesindedir, çünkü H200 için ham hesaplama H100’den değişmemiştir. Ayrıca, Nvidia’nın yeni nesil B200 işlemcisi, Llama 2 70B modelindeki MLPerf 4.1 jeneratif AI kıyaslamasında çıtayı daha da yükseltiyor, ancak bu farklı bir konuşma çünkü B200 henüz piyasaya sürülmedi.

AMD’nin MI300X’inden geriye kalan şey, tüm dokuz standartlaştırılmış kıyaslama için tam bir MLPerf 4.1 gönderimidir. Llama 2 70B bunlardan sadece biridir ve 3D Unet, BERT (Transformatörlerden Çift Yönlü Kodlayıcı Temsilleri), DLRM (Derin Öğrenme Öneri Modeli), GPT-J (Üretici Önceden Eğitilmiş Transformatör-Jumbo), Mixtral, Resnet, Retinanet ve Stable Diffusion XL hepsi mevcut sürümün bir parçasıdır. Bir şirketin yalnızca bu testlerin bir alt kümesi için sonuçlar göndermesi alışılmadık bir durum değildir (Nvidia’nın B200 gönderimine bakın), bu nedenle bu çıkarım iş yükü testlerinin geri kalanında ne olacağını bekleyip görmemiz gerekecek.