“Çilek” kelimesinde R harfi kaç kez geçiyor? GPT-4o ve Claude gibi müthiş yapay zeka ürünlerine göre cevap iki kez.

Büyük dil modelleri saniyeler içinde denemeler yazabilir ve denklemleri çözebilir. Terabaytlarca veriyi insanların bir kitabı açmasından daha hızlı sentezleyebilirler. Yine de, bu görünüşte her şeyi bilen yapay zekalar bazen o kadar muhteşem bir şekilde başarısızlığa uğrar ki, talihsizlik viral bir meme’e dönüşür ve hepimiz belki de yeni yapay zeka efendilerimize boyun eğmemiz için hala zamanımız olduğunu düşünerek rahatlarız.

Büyük dil modellerinin harf ve hece kavramlarını anlamadaki başarısızlığı, sıklıkla unuttuğumuz daha büyük bir gerçeğin göstergesidir: Bu şeylerin beyinleri yoktur. Bizim gibi düşünmezler. İnsan değillerdir, hatta özellikle insan gibi bile değillerdir.

Çoğu LLM, bir tür derin öğrenme mimarisi olan transformatörler üzerine kuruludur. Transformatör modelleri, modele bağlı olarak metni tam kelimeler, heceler veya harfler olabilen belirteçlere ayırır.

“LLM’ler, özellikle metni gerçekten okumayan bu dönüştürücü mimariye dayanmaktadır. Bir istem girdiğinizde olan şey, bunun bir kodlamaya çevrilmesidir,” Alberta Üniversitesi’nde yapay zeka araştırmacısı ve yardımcı doçent olan Matthew Guzdial, TechCrunch’a söyledi. “’The’ kelimesini gördüğünde, ‘the’nin ne anlama geldiğine dair bu tek kodlamaya sahiptir, ancak ‘T’, ‘H’, ‘E’ hakkında bir şey bilmez.”

Bunun nedeni, dönüştürücülerin gerçek metni verimli bir şekilde alamaması veya çıktı alamamasıdır. Bunun yerine, metin kendi sayısal gösterimlerine dönüştürülür ve bu daha sonra AI’nın mantıksal bir yanıt bulmasına yardımcı olmak için bağlamlandırılır. Başka bir deyişle, AI “straw” ve “berry” belirteçlerinin “strawberry”yi oluşturduğunu bilebilir, ancak “strawberry”nin belirli bir sırayla “s”, “t”, “r”, “a”, “w”, “b”, “e”, “r”, “r” ve “y” harflerinden oluştuğunu anlamayabilir. Bu nedenle, “strawberry” kelimesinde kaç harfin -kaç tane “r”nin- göründüğünü size söyleyemez.

Bu, çözülmesi kolay bir sorun değil, çünkü bu sorun, bu LLM’lerin çalışmasını sağlayan mimarinin içine gömülü.

TechCrunch’tan Kyle Wiggers geçen ay bu sorunu ele aldı ve Northeastern Üniversitesi’nde LLM yorumlanabilirliği üzerine çalışan doktora öğrencisi Sheridan Feucht ile konuştu.

“Bir dil modeli için bir ‘kelimenin’ tam olarak ne olması gerektiği sorusunun etrafından dolanmak biraz zor ve insan uzmanları mükemmel bir belirteç sözlüğü konusunda anlaşsalar bile, modeller muhtemelen şeyleri daha da fazla ‘parçalamak’ için bunu yine de yararlı bulacaktır,” dedi Feucht TechCrunch’a. “Tahminimce bu tür belirsizlik nedeniyle mükemmel bir belirteç ayırıcı diye bir şey yoktur.”

Bu sorun, bir LLM daha fazla dil öğrendikçe daha da karmaşık hale gelir. Örneğin, bazı belirteçleme yöntemleri bir cümledeki boşluğun her zaman yeni bir kelimeden önce geleceğini varsayabilir, ancak Çince, Japonca, Tayca, Laoca, Korece, Khmerce ve diğerleri gibi birçok dil kelimeleri ayırmak için boşluk kullanmaz. Google DeepMind AI araştırmacısı Yennie Jun, 2023 tarihli bir çalışmada bazı dillerin aynı anlamı iletmek için İngilizceden on kat daha fazla belirtece ihtiyaç duyduğunu buldu.

Feucht, “Modellerin, belirteçleştirmeyi dayatmadan doğrudan karakterlere bakmasına izin vermek muhtemelen en iyisidir, ancak şu anda bu, transformatörler için hesaplama açısından uygulanabilir değil” dedi.

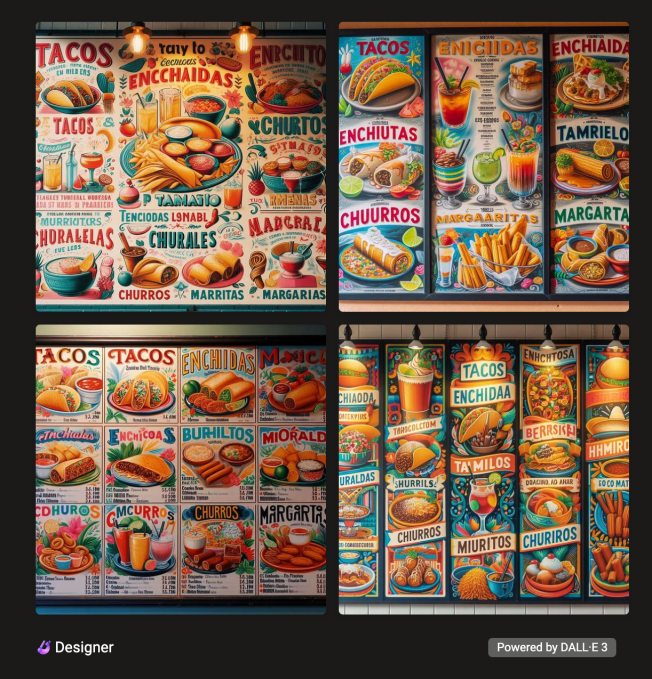

Midjourney ve DALL-E gibi görüntü oluşturucular, ChatGPT gibi metin oluşturucuların kaputunun altında yatan dönüştürücü mimariyi kullanmaz. Bunun yerine, görüntü oluşturucular genellikle gürültüden bir görüntüyü yeniden oluşturan difüzyon modellerini kullanır. Difüzyon modelleri, büyük görüntü veritabanlarında eğitilir ve eğitim verilerinden öğrendikleri şeye benzer bir şeyi yeniden yaratmaya teşvik edilirler.

Asmelash Teka Hadgu, kurucu ortağı Lesan ve bir arkadaş DAIR EnstitüsüTechCrunch’a konuşan , “Görüntü üreteçleri, arabalar ve insanların yüzleri gibi eserlerde çok daha iyi performans gösteriyor; parmaklar ve el yazısı gibi daha küçük şeylerde ise daha az performans gösteriyor.” dedi.

Bunun nedeni, bu daha küçük ayrıntıların eğitim setlerinde ağaçların genellikle yeşil yapraklara sahip olması gibi kavramlar kadar belirgin bir şekilde görünmemesi olabilir. Ancak, difüzyon modellerindeki sorunlar, transformatörleri etkileyen sorunlardan daha kolay çözülebilir. Bazı görüntü oluşturucular, örneğin gerçek insan ellerinin daha fazla görüntüsü üzerinde eğitim alarak elleri temsil etmede gelişmiştir.

“Geçen yıl bile, tüm bu modeller parmaklarda gerçekten kötüydü ve bu tam olarak metinle aynı sorun,” diye açıkladı Guzdial. “Bunu yerel olarak gerçekten iyi yapıyorlar, bu yüzden altı veya yedi parmağı olan bir ele baktığınızda, ‘Vay canına, bu bir parmağa benziyor’ diyebilirsiniz. Benzer şekilde, oluşturulan metinle, bunun ‘H’ gibi göründüğünü ve bunun da ‘P’ gibi göründüğünü söyleyebilirsiniz, ancak tüm bu şeyleri bir arada yapılandırmada gerçekten kötüler.”

Bu nedenle, bir yapay zeka görüntü oluşturucusundan bir Meksika restoranı için menü oluşturmasını isterseniz, “Tacos” gibi normal ürünler elde edebilirsiniz; ancak “Tamilos”, “Enchidaa” ve “Burhiltos” gibi ürünler bulma olasılığınız daha yüksek olur.

“Çilek” yazımıyla ilgili bu memler internette yayılırken, OpenAI, muhakemede daha da yetenekli olması beklenen Strawberry kod adlı yeni bir AI ürünü üzerinde çalışıyor. LLM’lerin büyümesi, ChatGPT gibi ürünleri daha doğru hale getirmek için dünyada yeterli eğitim verisi olmaması gerçeğiyle sınırlıydı. Ancak Strawberry’nin, OpenAI’nin LLM’lerini daha da iyi hale getirmek için doğru sentetik veriler üretebileceği bildiriliyor. BilgiStrawberry, çözmek için yaratıcı düşünme ve desen tanıma gerektiren New York Times’ Connections kelime bulmacalarını çözebiliyor ve daha önce hiç görmediği matematik denklemlerini çözebiliyor.

Bu arada, Google DeepMind yakın zamanda açığa çıktı AlphaProof ve AlphaGeometry 2, resmi matematiksel akıl yürütme için tasarlanmış AI sistemleri. Google, bu iki sistemin Uluslararası Matematik Olimpiyatı’ndaki altı problemden dördünü çözdüğünü ve bunun prestijli yarışmada gümüş madalya kazanmak için yeterince iyi bir performans olacağını söylüyor.

Yapay zekanın “çilek” kelimesini yazamadığına dair memlerin, aynı zamanda bu konudaki raporların da dolaşımda olması biraz trolleme. OpenAI’nin ÇileğiAncak OpenAI CEO’su Sam Altman, bize kendi arazisinde oldukça etkileyici bir meyve verimi olduğunu gösterme fırsatını hemen değerlendirdi. bahçe.