ABD hükümeti, şirketler ve geniş halk kitleleri için teknoloji geliştiren ve test eden ABD Ticaret Bakanlığı kurumu olan Ulusal Standartlar ve Teknoloji Enstitüsü (NIST), kötü amaçlı saldırıların (özellikle yapay zeka modeli eğitim verilerini “zehirleyen” saldırılar) bir yapay zeka sisteminin performansını nasıl düşürebileceğini ölçmek için tasarlanmış bir test ortamını yeniden yayınladı.

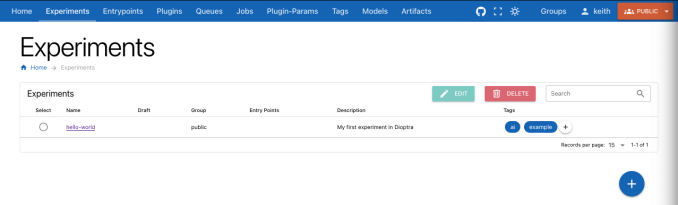

İsminde Diyoptra (sonra klasik astronomi ve arazi ölçüm aleti), modüler, açık kaynaklı web tabanlı araç, ilk piyasaya sürülmüş 2022’de, AI modellerini eğiten şirketlere ve bu modelleri kullanan kişilere AI risklerini değerlendirme, analiz etme ve izleme konusunda yardımcı olmayı amaçlıyor. NIST, Dioptra’nın modelleri kıyaslamak ve araştırmak için kullanılabileceğini ve ayrıca modelleri “kırmızı takım” ortamında simüle edilmiş tehditlere maruz bırakmak için ortak bir platform sağlayabileceğini söylüyor.

“Makine öğrenimi modelleri üzerindeki düşmanca saldırıların etkilerini test etmek, Dioptra’nın hedeflerinden biridir” NIST yazdı bir basın bülteninde. “Ücretsiz indirilebilen çocuk üretme gibi açık kaynaklı yazılım, hükümet kurumları ve küçük ve orta ölçekli işletmeler de dahil olmak üzere topluluğun, AI geliştiricilerinin sistemlerinin performansı hakkındaki iddialarını değerlendirmek için değerlendirmeler yapmasına yardımcı olabilir.”

Dioptra, NIST ve NIST’in yakın zamanda oluşturduğu belgelerle birlikte piyasaya sürüldü AI Güvenlik Enstitüsü Yapay zekanın bazı tehlikelerini, örneğin nasıl kötüye kullanılabileceği gibi, azaltmanın yollarını ortaya koyan rızaya dayanmayan pornografi. Bu, İngiltere AI Güvenlik Enstitüsü’nün Inspect’inin lansmanını takip ediyor, bu araç seti de benzer şekilde modellerin yeteneklerini ve genel model güvenliğini değerlendirmeyi amaçlıyor. ABD ve İngiltere, geçen yılın Kasım ayında Bletchley Park’ta düzenlenen İngiltere AI Güvenlik Zirvesi’nde duyurulan gelişmiş AI model testlerini birlikte geliştirmek için devam eden bir ortaklığa sahip.

Dioptra ayrıca Başkan Joe Biden’ın AI ile ilgili yürütme emrinin (EO) ürünüdür ve (diğer şeylerin yanı sıra) NIST’in AI sistem testlerine yardımcı olmasını zorunlu kılar. EO, ilgili olarak, modeller geliştiren şirketlerin (örneğin Apple) federal hükümeti bilgilendirmeleri ve tüm güvenlik testlerinin sonuçlarını kamuoyuna sunulmadan önce paylaşmaları gereklilikleri de dahil olmak üzere AI güvenliği ve emniyeti için standartlar da belirler.

Daha önce yazdığımız gibi, AI kıyaslamaları zordur; bunun en önemli nedeni, günümüzdeki en gelişmiş AI modellerinin, altyapıları, eğitim verileri ve diğer önemli ayrıntıları onları oluşturan şirketler tarafından gizli tutulan kara kutular olmasıdır. AI üzerinde çalışan İngiltere merkezli kar amacı gütmeyen bir araştırma enstitüsü olan Ada Lovelace Enstitüsü’nden bu ay çıkan bir rapor, değerlendirmelerin tek başına bir AI modelinin gerçek dünyadaki güvenliğini belirlemek için yeterli olmadığını, kısmen de mevcut politikaların AI satıcılarının hangi değerlendirmeleri yürüteceklerini seçici bir şekilde seçmelerine izin vermesi nedeniyle buldu.

NIST, Dioptra’nın modellerin riskini tamamen ortadan kaldırabileceğini iddia etmiyor. Ancak kurum yapmak Dioptra’nın, hangi tür saldırıların bir yapay zeka sisteminin daha az etkili bir şekilde çalışmasına neden olabileceği konusunda ışık tutabileceğini ve bunun performans üzerindeki etkisini ölçebileceğini öne sürüyorlar.

Ancak büyük bir sınırlama olarak, Dioptra yalnızca Meta’nın genişleyen Llama ailesi gibi yerel olarak indirilebilen ve kullanılabilen modellerde kutudan çıktığı gibi çalışır. OpenAI’nin GPT-4o’su gibi bir API’nin arkasına gizlenmiş modeller, en azından şimdilik, işe yaramaz.