AI modelleri gittikçe daha iyi hale gelse de, hala hata yapma ve yanlış cevaplar üretme yeteneğine sahipler. Bu alandaki uzmanların halüsinasyon dediği şey budur.

ChatGPT ve Google Bard dahil olmak üzere tüm büyük AI sohbet robotları bu halüsinasyonlara eğilimlidir. OpenAI ve Google, sohbet robotlarının yanlış bilgi üretebileceğini bile belirtiyor.

“ChatGPT bazen makul ancak yanlış veya anlamsız cevaplar yazıyor”, bir ChatGPT blog gönderisinde OpenAI diyor.

Karmaşık matematik problemlerini “süreç denetimi” ile çözün

İçinde araştırma çalışması hakkında yeni gönderiOpenAI, AI modellerinin daha mantıklı hareket etmesini ve halüsinasyonlardan kaçınmasını sağlamanın bir yolunu bulmuş olabileceğini söylüyor.

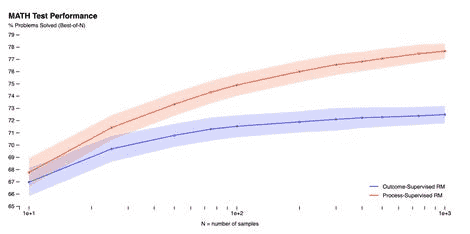

OpenAI, nihai sonuç hakkında her adım için geri bildirim sağlayan “sonuç denetimi”nin aksine, her bir adım için geri bildirim sağlayan bir yöntem olan “süreç denetimi” aracılığıyla karmaşık matematik problemlerini çözebilen bir model geliştirmiştir.

Araştırma makalesinde OpenAI, MATH veri setini kullanarak her iki yöntemi de test etti ve süreç izleme yönteminin “önemli ölçüde daha iyi performans” sağladığını buldu.

Sabrina Ortiz/ZDNET tarafından ekran görüntüsü

OpenAI araştırma makalesinde, “Süreç denetimi, modeli insan tarafından onaylanan bir süreci izlemeye teşvik ettiğinden, yorumlanabilir muhakeme üretme olasılığı daha yüksektir” diye açıklıyor.

OpenAI, matematik problemlerinin dışında, bu bulguların diğer alanlara ne ölçüde uygulanacağının belirsiz olduğunu belirtiyor.

Kaynak : “ZDNet.com”