bir insan yaptı bunu yaz, veya ChatGPT? Yaratıcısı OpenAI, söylemesinin zor – belki de çok zor olduğunu düşünüyor, bu yüzden yapay zeka tarafından oluşturulan içeriği “filigran” haline getirmenin bir yolu üzerinde çalışıyor.

İçinde ders Austin Üniversitesi’nde, şu anda OpenAI’de konuk araştırmacı olan bilgisayar bilimi profesörü Scott Aaronson, OpenAI’nin “bir metnin çıktılarını istatistiksel olarak filigranlamak” için bir araç geliştirdiğini ortaya çıkardı. [AI system]” Bir sistem (örneğin, ChatGPT) metin oluşturduğunda, araç metnin nereden geldiğini gösteren “fark edilmeyen gizli bir sinyal” yerleştirir.

Aaronson, OpenAI mühendisi Hendrik Kirchner’in çalışan bir prototip oluşturduğunu ve bunu gelecekteki OpenAI tarafından geliştirilen sistemlerde oluşturmayı umduğunu söylüyor.

“Almanın çok daha zor olmasını istiyoruz [an AI system’s] Aaronson sözlerinde, çıktıyı bir insandan gelmiş gibi dağıtın” dedi. “Bu, elbette akademik intihalin önlenmesine yardımcı olabilir, ama aynı zamanda, örneğin, kitlesel propagandanın önlenmesine de yardımcı olabilir – bilirsiniz, Moskova’da bir bina dolusu trol bile olmadan Rusya’nın Ukrayna’yı işgalini destekleyen, konuyla ilgili gibi görünen yorumlarla her blogu spamlamak. Ya da birini suçlamak için onun yazı stilini taklit etmek.”

Rastgeleliği kullanmak

Neden bir filigran ihtiyacı var? ChatGPT güçlü bir örnektir. OpenAI tarafından geliştirilen sohbet robotu, yalnızca zorlu soruları yanıtlamakla kalmayıp, şiir yazma, programlama bulmacalarını çözme ve herhangi bir sayıda felsefi konuda şiirsel olma becerisi göstererek interneti kasıp kavurdu.

ChatGPT son derece eğlenceli ve gerçekten yararlı olsa da, sistem bariz etik kaygıları gündeme getiriyor. Kendisinden önceki birçok metin üreten sistem gibi, ChatGPT de yüksek kaliteli kimlik avı e-postaları ve zararlı kötü amaçlı yazılımlar yazmak veya okul ödevlerinde kopya çekmek için kullanılabilir. Ve bir soru yanıtlama aracı olarak, olgusal olarak tutarsızdır — programlama Soru-Cevap sitesi Stack Overflow’un bir sonraki duyuruya kadar ChatGPT’den kaynaklanan yanıtları yasaklamasına yol açan bir eksiklik.

OpenAI’nin damgalama aracının teknik temellerini kavramak için, ChatGPT gibi sistemlerin neden bu kadar iyi çalıştığını bilmek faydalı olacaktır. Bu sistemler, girdi ve çıktı metnini, kelimeler olabileceği gibi noktalama işaretleri ve kelime parçaları da olabilen “belirteç” dizileri olarak anlar. Sistemler özünde, daha önce çıktısı alınmış tüm belirteçleri hesaba katarak, çıktı alınacak bir sonraki simgeye (örn. sözcük) karar vermek için sürekli olarak olasılık dağılımı adı verilen matematiksel bir işlev üretir.

ChatGPT gibi OpenAI tarafından barındırılan sistemler söz konusu olduğunda, dağıtım oluşturulduktan sonra OpenAI sunucusu, dağıtıma göre belirteçleri örnekleme işini yapar. Bu seçimde biraz rastgelelik var; bu nedenle aynı metin istemi farklı bir yanıt verebilir.

Aaronson ders sırasında, OpenAI’nin filigran aracının mevcut metin oluşturma sistemleri üzerinde bir “sarmalayıcı” gibi davrandığını ve bir sonraki belirteci “sözde rasgele” seçmek için sunucu düzeyinde çalışan bir kriptografik işlevden yararlandığını söyledi. Teorik olarak, sistem tarafından oluşturulan metin size ya da bana hala rastgele görünebilir, ancak kriptografik işlevin “anahtarına” sahip olan herkes bir filigranı ortaya çıkarabilir.

“Deneysel olarak, birkaç yüz jeton, evet, bu metnin nereden geldiğine dair makul bir sinyal almak için yeterli görünüyor. [an AI system]. Prensip olarak, uzun bir metin bile alabilir ve muhtemelen hangi bölümlerin kaynaklandığını izole edebilirsiniz. [the system] ve hangi kısımlar muhtemelen yapmadı. Aaronson dedi. “[The tool] gizli bir anahtar kullanarak filigran yapabilir ve aynı anahtarı kullanarak filigranı kontrol edebilir.”

Anahtar sınırlamalar

AI tarafından oluşturulan metne filigran eklemek yeni bir fikir değil. Çoğu kurallara dayalı olan önceki girişimler, eşanlamlı ikameler ve sözdizimine özgü kelime değişiklikleri gibi tekniklere dayanıyordu. Ama teorinin dışında Araştırma Alman enstitüsü CISPA tarafından geçen Mart ayında yayınlanan OpenAI’ler, soruna kriptografi tabanlı ilk yaklaşımlardan biri gibi görünüyor.

Yorum için iletişime geçildiğinde Aaronson, önümüzdeki aylarda bir araştırma makalesinin ortak yazarlığını yapmayı beklemesi dışında, filigran prototipi hakkında daha fazla bilgi vermeyi reddetti. OpenAI ayrıca, yalnızca damgalamanın yapay zeka tarafından üretilen çıktıları tespit etmek için keşfettiği birkaç “kaynak tekniği” arasında olduğunu söyleyerek reddetti.

Bununla birlikte, bağlantılı olmayan akademisyenler ve endüstri uzmanları karışık görüşler paylaştı. Aracın sunucu tarafında olduğunu, yani tüm metin üreten sistemlerle çalışması gerekmediğini belirtiyorlar. Ve düşmanların ortalıkta dolaşmasının önemsiz olacağını savunuyorlar.

MIT’de bir bilgisayar bilimi profesörü olan Srini Devadas, e-posta yoluyla TechCrunch’a “Yeniden yazarak, eşanlamlıları kullanarak, vb. kullanarak bunu aşmanın oldukça kolay olacağını düşünüyorum.” “Bu biraz çekişmeli bir savaş.”

Allen Yapay Zeka Enstitüsü’nde araştırma bilimcisi olan Jack Hessel, yapay zeka tarafından oluşturulan metnin fark edilmeden parmak izini almanın zor olacağına dikkat çekti çünkü her belirteç ayrı bir seçimdir. Çok belirgin bir parmak izi, akıcılığı azaltan tuhaf kelimelerin seçilmesine neden olabilirken, çok incelikli bir parmak izi arandığında şüpheye yer bırakabilir.

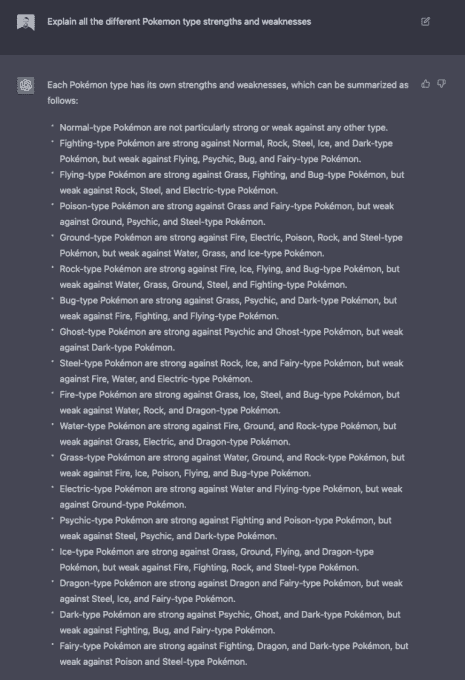

ChatGPT bir soruyu yanıtlıyor.

Bir OpenAI rakibi olan AI21 Labs’ın kurucu ortağı ve CEO’su Yoav Shoham, AI tarafından üretilen metnin kaynağını belirlemeye yardımcı olmak için istatistiksel damgalamanın yeterli olmayacağını düşünüyor. Metnin farklı bölümlerinin farklı şekilde filigranlandığı farklı damgalamayı ve olgusal metin kaynaklarından daha doğru bir şekilde alıntı yapan yapay zeka sistemlerini içeren “daha kapsamlı” bir yaklaşım çağrısında bulunuyor.

Uzmanlar, bu özel filigran tekniğinin aynı zamanda OpenAI’ye çok fazla güven ve güç verilmesini gerektirdiğini belirtti.

Hessel, e-posta yoluyla, “İdeal bir parmak izi, bir insan okuyucu tarafından fark edilemez ve son derece güvenli bir algılama sağlar” dedi. “Nasıl kurulduğuna bağlı olarak, OpenAI’nin kendisi, ‘imzalama’ sürecinin işleyişi nedeniyle bu algılamayı güvenle sağlayabilen tek taraf olabilir.”

Aaronson dersinde, planın yalnızca OpenAI gibi şirketlerin son teknoloji sistemleri ölçeklendirmede önde olduğu bir dünyada gerçekten işe yarayacağını ve hepsinin sorumlu oyuncular olmayı kabul ettiğini kabul etti. OpenAI filigran aracını Cohere ve AI21Labs gibi diğer metin üreten sistem sağlayıcılarıyla paylaşsa bile, bu başkalarının onu kullanmamayı seçmesini engellemez.

“Eğer [it] Aaronson, herkes için ücretsiz hale geldiğinde, güvenlik önlemlerinin çoğu daha zor hale gelir ve hatta en azından hükümet düzenlemesi olmadan imkansız hale gelebilir” dedi. “Herkesin kendi metin modelini oluşturabileceği bir dünyada, [ChatGPT, for example] … orada ne yapardın?

Metinden resme etki alanında bu şekilde oynanır. DALL-E 2 görüntü oluşturma sistemi yalnızca bir API aracılığıyla kullanılabilen OpenAI’den farklı olarak, Stability AI, metinden görüntüye teknolojisini (Stable Diffusion olarak adlandırılır) açık kaynaklı hale getirdi. DALL-E 2, sorunlu görüntülerin oluşturulmasını (artı oluşturduğu görüntülerde filigranlar) önlemek için API düzeyinde bir dizi filtreye sahipken, açık kaynak Stable Difüzyon’da yoktur. Kötü aktörler, diğer toksisitenin yanı sıra onu derin sahte porno oluşturmak için kullandılar.

Aaronson ise iyimser. Derste, OpenAI damgalamanın işe yaradığını ve oluşturulan metnin kalitesini etkilemediğini gösterebilirse, bunun bir endüstri standardı olma potansiyeline sahip olacağına olan inancını dile getirdi.

Herkes aynı fikirde değil. Devadas’ın işaret ettiği gibi, aracın bir anahtara ihtiyacı var, yani tamamen açık kaynak olamaz – potansiyel olarak benimsenmesini OpenAI ile ortak olmayı kabul eden kuruluşlarla sınırlandırıyor. (Anahtar herkese açık hale getirilecek olsaydı, herkes filigranların ardındaki modeli anlayarak amacını bozabilirdi.)

Ama bu o kadar da abartılı olmayabilir. Quora’nın bir temsilcisi, şirketin böyle bir sistemi kullanmakla ilgileneceğini ve muhtemelen tek sistem olmayacağını söyledi.

“Yapay zekayı ölçeklendirirken güvenli ve sorumlu olmaya çalışmakla ilgili tüm bu zırvalıkların… Google’ın, Meta’nın, Alibaba’nın ve diğer büyük oyuncuların bilançolarını ciddi şekilde incittiği anda, çoğunun pencereden uçup gideceğinden endişelenebilirsiniz. dedi Aaronson. “Öte yandan, son 30 yılda büyük internet şirketlerinin dava edilme korkusu, sorumlu bir oyuncu olarak görülme arzusu veya başka nedenlerle belirli asgari standartlar üzerinde anlaşabildiğini gördük.”