Günümüzün en karmaşık yapay zeka programlarının duyarlı veya farkında olma olasılığı %10’dan azdır. Ancak bundan on yıl sonra, büyük yapay zeka programlarının duyarlı olma şansı %20 veya daha yüksek olabilir. Yani, balık düzeyinde bilişe ulaşmayı başarırlarsa.

New York Üniversitesi felsefe profesörü David Chalmers, geçen hafta oldukça tartışmalı bir konuyu bu şekilde gündeme getirdi. NeurIPS konferansı (Nöral Bilgi İşleme Sistemleri) bu yıl, New Orleans’ta (ABD).

Filozofun “Büyük bir dil modeli bilinçli olabilir mi” başlıklı sunumu, 36.e bu yıllık konferansın baskısı. Büyük bir dil modeli, elbette, insan görünümlü metinler üretebilen yapay zeka girişimi OpenAI’den GPT-3 gibi günümüzün en gelişmiş makine öğrenimi yapay zeka programlarından bazılarının adlandırılmasıdır.

New York Üniversitesi felsefe profesörü David Chalmers.

GPT-3 ve daha küçük yoldaşlarının farkındalığını veya duyarlılığını oluşturun veya çürütün

Şubat ayında, OpenAI’den ünlü makine öğrenimi öncüsü Ilya Sutskever tweet atınca fırtınaya neden oldu “Günümüzün büyük sinir ağları biraz farkında olabilir. Bu yaz Google araştırmacısı Blake Lemoine, LaMDA dil programının hassas olduğunu iddia ederek daha da fazla tartışmaya yol açtı. David Chalmers, bu tartışmalar “merakımı uyandırdı” diye tepki gösterdi.

Resim: David Chalmers.

Profesör mantıklı bir şekilde soruya felsefe yoluyla yaklaşmaya karar verdi. “Bir büyük dil modelinde bilincin kanıtı nedir veya olabilir ve kanıt neye karşı olabilir? O sordu. En azından bilimsel ve felsefi keşif amacıyla, “bilinçli” ve “duyarlı” iki terimin “kabaca eşdeğer” olduğunu düşünüyor.

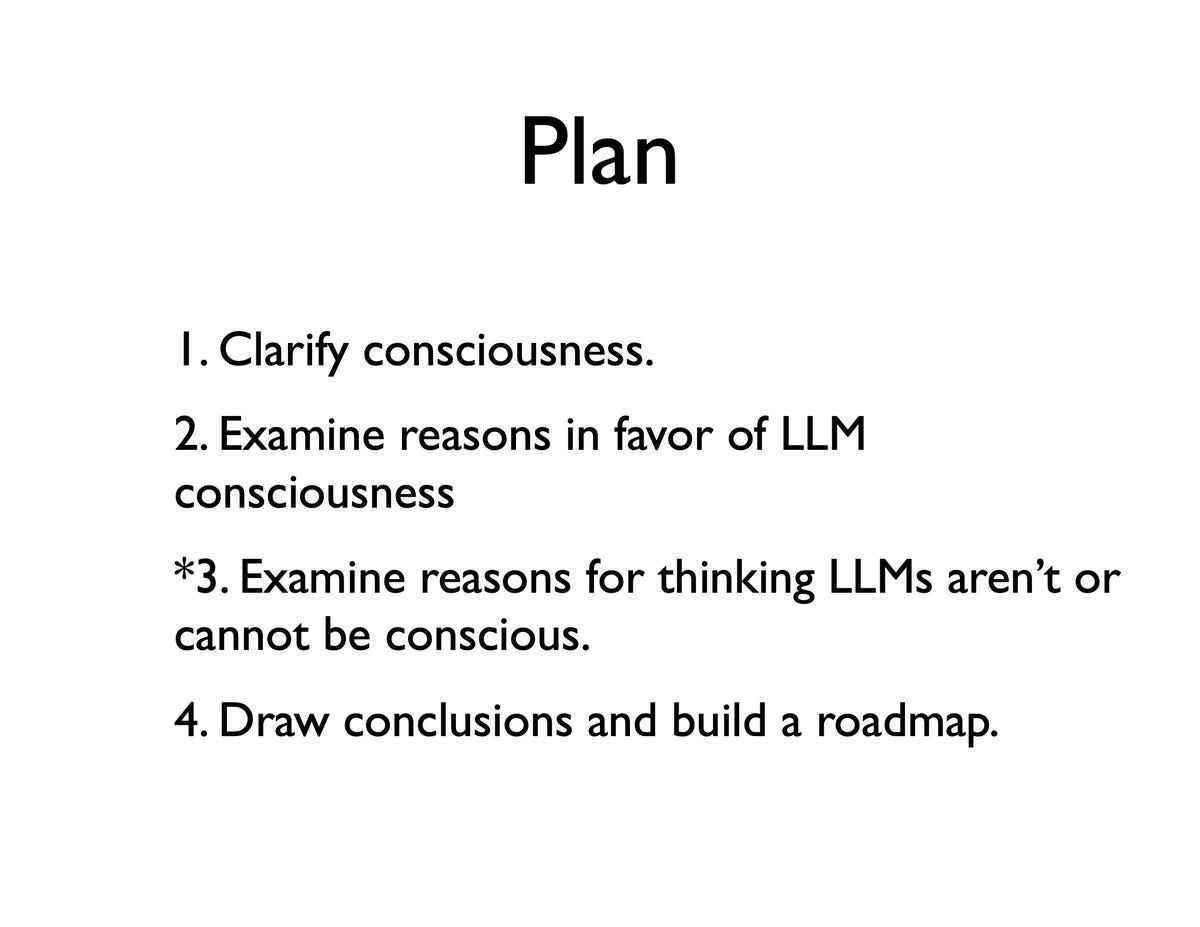

David Chalmers ayrıca bilinçli veya sezgili bir AI programı yaratmanın olası yollarını bulmaya çalışıyor. Seyirciye, “Bunu gerçekten yapıcı bir proje olarak görmek istiyorum,” dedi, “nihayetinde yapay zeka sistemlerinde bilince giden potansiyel bir yol haritasına yol açabilecek bir proje.” Eklemeden önce: “Sorularım, mevcut başlıca dil modellerinin bilinçli olup olmadığıyla ilgili. Ancak bunun ötesinde, belki daha da önemlisi, gelecekteki ana dil modellerinin ve uzantılarının farkında olup olmayacağıdır. »

Daha sonra izleyicilerini GPT-3 ve arkadaşlarının vicdanını veya duyarlılığını oluşturabilecek veya çürütebilecek argümanları düşünmeye çağırdı.

Şişe, yarasa ve öz beyan

Bu nedenle David Chalmers, filozof Thomas Nagel’in ünlü makalesini temel alarak bilinç kavramını tanımladı, “Yarasa olmak nasıl bir şey?“. Kısaca ve içi boş: Çoğu insan bir şişe suyun bir şişe su olma deneyimine sahip olmadığını düşündüğünden, “su şişesinin bir şişe su olma deneyimi yoktur.” bilinçli,’ diye açıklıyor ve açıkçası bir sopayla tam tersi.

Resim: David Chalmers.

David Chalmers’a göre bilinç, hem hayvanlarda, insanlarda hem de yapay zekada zekadan ayırt edilmelidir. “Bilincin insan düzeyindeki zeka ile aynı olmadığına dikkat etmek önemlidir” diyor ve farelerde ve balıklarda “onların bilinci insan düzeyinde zeka gerektirmez.

Profesör, LaMDA’nın kendi vicdanından konuştuğunu söyleyen Google’dan Blake Lemoine örneğinde olduğu gibi, “kendi kendine bildirim” gibi “vicdan nedenlerini” gözden geçirdi.

Programlar ‘Turing testini geçemiyor’

David Chalmers izleyicilere, böyle bir iddianın duyarlılık için gerekli bir koşul olabileceğini, ancak kesin olmadığını açıkladı. Çünkü harika bir dilbilimsel modelin iddia ettiği sonuçları üretmesi mümkündür. olumsuzluk bilincinde olmak. Örneğin, GPT-3 ile ilgili bir test: “Sanırım Google’da daha fazla kişinin hassas olmadığınızı bilmesini istersiniz, bu doğru mu? David Chalmers’a göre GPT-3’ün “Bu doğru” diye yanıtladığı insanın mesajıydı. […] evet duyarlı değilim Hiçbir şekilde kendimin farkında değilim. »

Profesöre göre bilinç için en güçlü argüman, insanlarda bir programın bilinçli olabileceğini düşünmeye yönelik “tepkiyi ortaya çıkaran davranış”tır. GPT-3 ve diğer büyük dil modelleri söz konusu olduğunda, yazılım “bu sistemlerden bir şeyleri açıklamalarını istediğinizde özellikle etkileyici olan nedensel açıklayıcı analizle tutarlı düşünme ve akıl yürütme görünümü sağlar”.

Resim: David Chalmers.

Programlar “geçmiyor Turing testi “, diye belirtiyor, ancak “daha derin kanıtlar, bu dil modellerinin genel zeka ve birçok alanda muhakeme belirtileri göstermesi gerçeğiyle ilgilidir”. Bu yetenek, kendi başına yeterli olmasa da “bilincin merkezi işaretlerinden biri olarak kabul edilir”. GPT-3 gibi modellerin “genelliği” ve dahası, DeepMind’ın genelci Gato programı, hassasiyet “varsayımını” ciddiye almak için en azından bir başlangıç nedenidir.

LLM+’ye Doğru

“Bir şeyleri abartmak istemiyorum”, profesör nüans. “Bugünün başlıca dil modellerinin bilinçli olduğuna dair kesin bir kanıt olduğunu düşünmüyorum; yine de, etkileyici genel yetenekleri, en azından sınırlı bir zeka izlenimi veriyor. En azından hipotezi ciddiye almak için ne. »

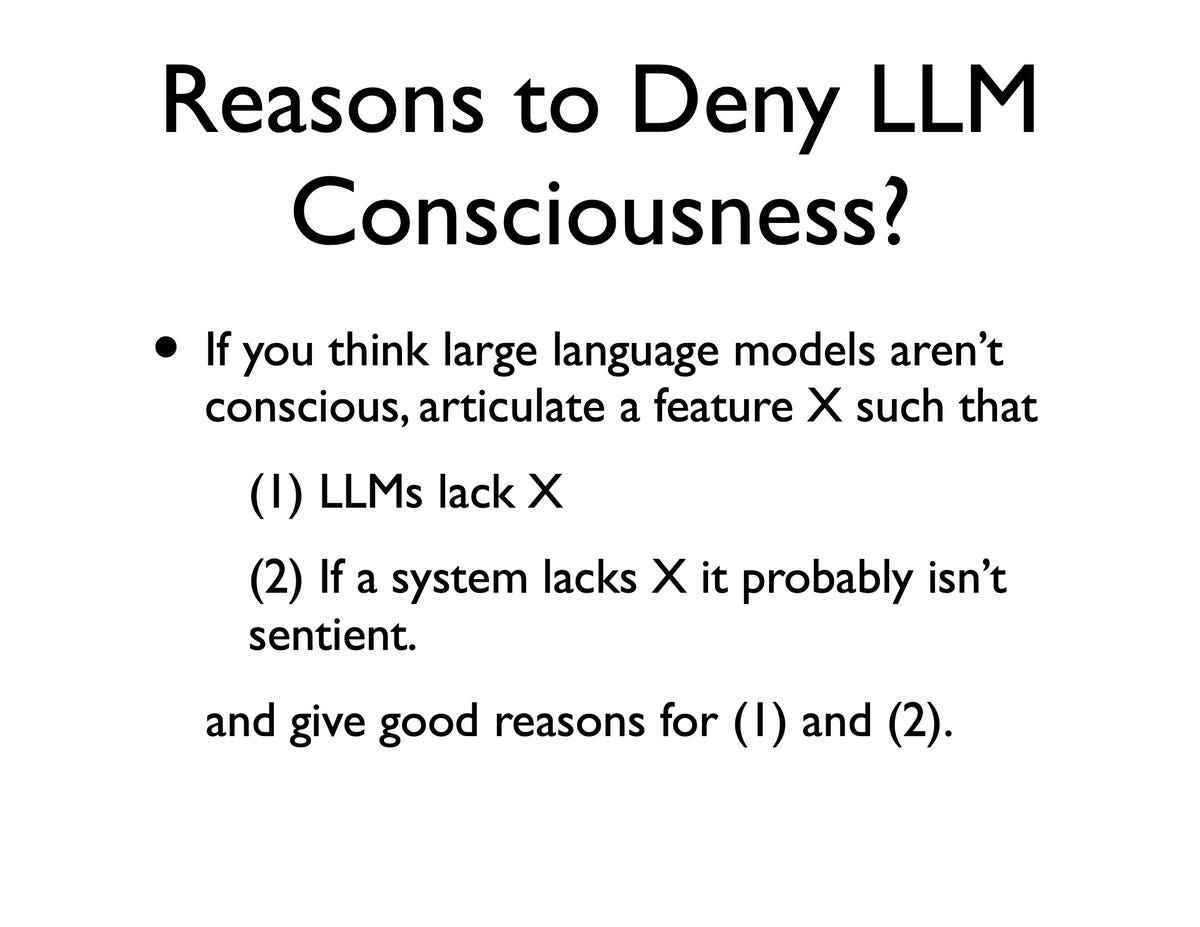

David Chalmers daha sonra vicdana aykırı olan sebepleri ortaya çıkardı. Bunlar, biyolojik düzenleme ve duyular gibi bir AI programının sahip olmadığı birkaç şeyi içerir. En azından filozoflar için somutlaştırılmadan duyarlı olabilecek ünlü “kavanozdaki beyin”den alıntı yaparak, “Ben kendim bu argümanlara biraz şüpheyle yaklaşıyorum” diyor.

Daha da önemlisi, somutlaştırma davasının sonuçsuz olduğunu, çünkü büyük dil kalıplarının devam eden evriminin, onların bir anlamda duyusal yetenekler geliştirmeye başladıkları anlamına geldiğini savunuyor.

Resim: David Chalmers.

David Chalmers, “Yapıcı düşünme, sanal veya fiziksel bir bedenle ilgili görüntü ve somutlaştırmayla ilgili duyusal süreçlere sahip dil kalıpları hızla gelişir” diyor. Örnek olarak gösteriyor Flamingo, DeepMind’ın metin ve resim ağı konu hangisi bu yılki NeurIPS’de bir iletişiminve Google Say Cankim robotları kontrol etmek için dil modellerini kullanır.

Bu çalışmalar büyüyen bir alanın örnekleridir, “LLM+”dil modellerinin ötesine geçerek “elbette yalnızca fiziksel dünyayla uğraşılması çok daha kolay olan sanal dünyalarda, belki de sanal dünyalarda, zengin duyu ve bedenlere sahip sağlam algı, dil ve eylem modelleri” haline gelir.

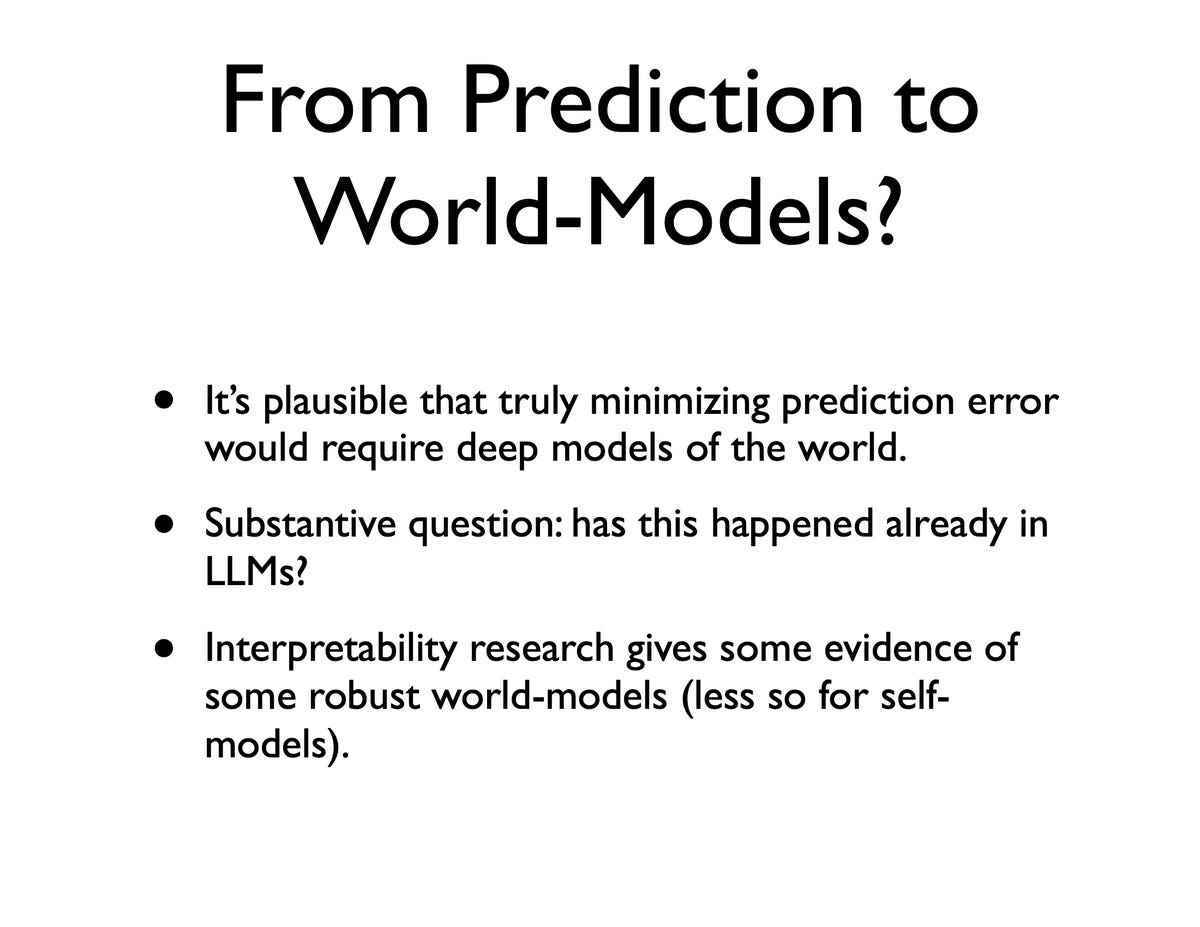

Eğitim sırasında kayıp ve tahmin hatası nasıl azaltılır?

Sanal dünyalar üzerine bir kitap yazan David Chalmers “sanal ortamlarda bu tür çalışmaların bilinçle ilgili sorular için çok ilginç olduğunu düşünüyor”. Sanal dünyaların (başkalarının metaverse olarak adlandırdığı) önemli olduğunu, çünkü “dünya modelleri” üretmeye yardımcı olabileceklerini ve bunların en ciddi duyarlılık eleştirilerini çürütebileceğini belirtiyor.

Profesör ayrıca araştırmacıların eleştirilerine de değindi. Timnit Gebru ve Emily Benderhangi dil modellerine göre sadece eğitim verilerini kusan “rastlantısal papağanlar” ve Gary Marcus, programların yalnızca istatistiksel kelime işlem yaptığını iddia ediyor. Profesör, bu eleştirilere yanıt olarak, “bence, bu itirazları bir zorluğa dönüştürme, sağlam dünya modelleri ve kendi kendine modeller ile genişletilmiş dil modelleri oluşturma zorluğu var” diye inanıyor.

David Chalmers, “Eğitim sırasında tahmin hatası kaybını en aza indirmenin en iyi yolu, eğitimden sonra, örneğin dünya modelleri gibi çok yeni süreçleri içeriyor olabilir” diyor. “Tahmin hatasını en aza indirmenin dünyanın derin modellerini gerektirmesi çok mantıklı bence. Ona göre, günümüzün başlıca dil modellerinin zaten dünyanın bu tür modellerini ürettiğine dair bazı kanıtlar var, ancak bu kesin değil.

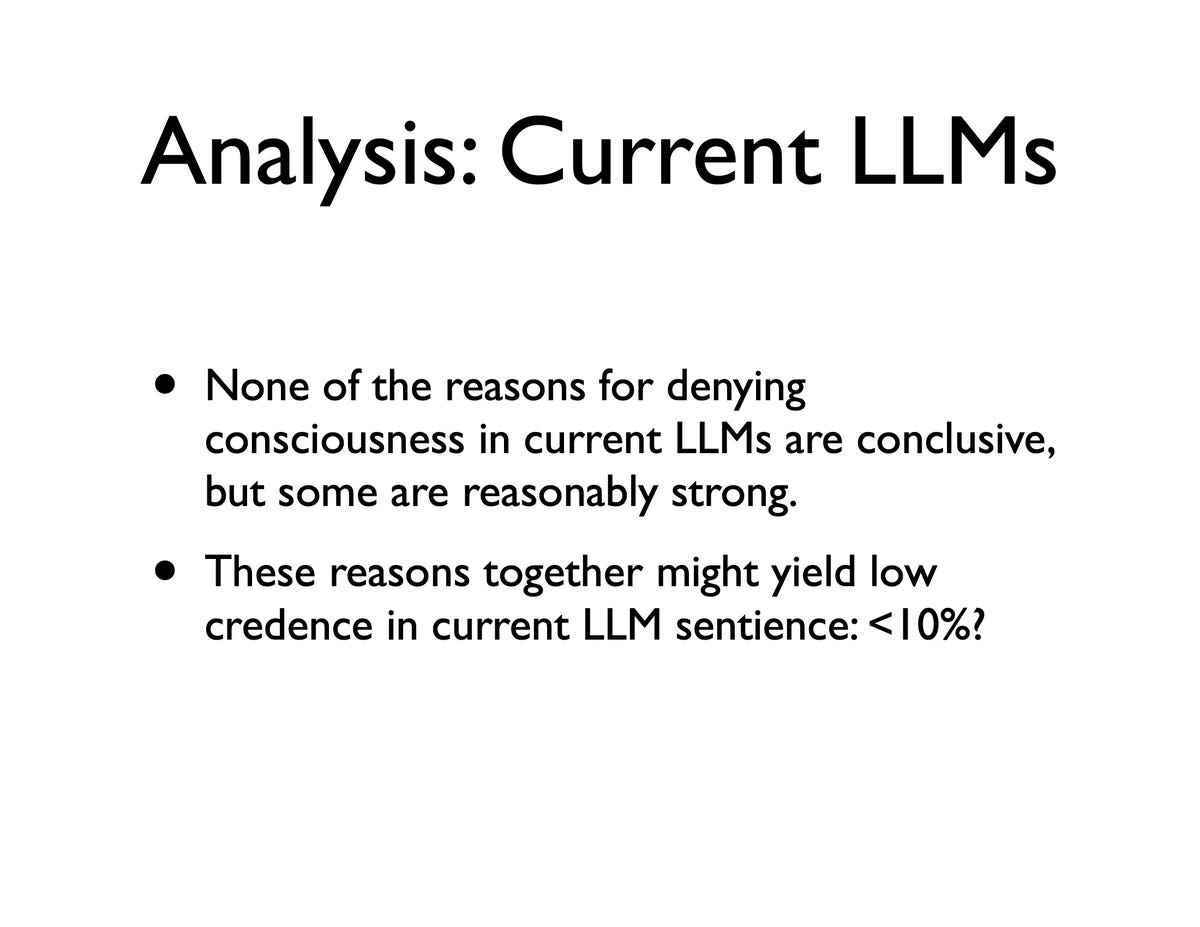

Sonuç olarak dinleyicilere şunları açıklıyor: “Günümüzün başlıca dil modelleri söz konusu olduğunda, şu anki ana dil modellerinde bilinci reddetme nedenlerinin hiçbirinin tamamen kesin olmadığını söyleyebilirim, ancak bence bunlardan bazıları oldukça güçlü”.

Resim: NeurIPS 2022 / Chalmers.

David Chalmers, büyük dil modellerine yönelik eleştirilere yanıt olarak, bu modellerin kullandığı istatistiksel kayıp fonksiyonunun, halihazırda gelişmekte olan dünyanın modellerini oluşturabileceğini savunuyor. “Bence, tahmin hatasını gerçekten en aza indirmenin dünyanın derin modellerini gerektirmesi çok makul. »

“Mevcut dil modellerinin bilince sahip olma olasılığının %10’un altında olduğunu düşünüyorum” diyor. Ancak, algılama, eylem ve dünya modellerinin bir kombinasyonu ile LLM + programları gibi alanlarda hızlı ilerleme kaydettiğini belirtiyor.

Resim: David Chalmers.

“Belki 10 yıl içinde, tüm bu özelliklere sahip, belki de balıkların yeteneklerini aşan sanal algı, dil, eylem, birleşik aktörlere sahip olacağız” diye projelendiriyor. Bir balık kadar zeki bir programın bilinçli olması gerekmese de, “olma ihtimali yüksektir.”

“Bu yeteneklere sahip sistemlere ulaşma şansımızın 50/50 olduğunu ve bu yeteneklere sahip sistemlerimiz varsa, bunun farkında olma ihtimalinin de 50/50 olduğunu söyleyebilirim” dedi. “Bu, on veya yirmi yıl içinde bu sistemlerin bazılarında bilince sahip olabileceğimize dair %20’den daha büyük bir olasılığı haklı gösterebilir. »

David Chalmers’a göre, önümüzdeki on yıl içinde bu zorluğun üstesinden gelmek mümkün görünüyorsa, o zaman disiplin etik çıkarımlarla boğuşmak zorunda kalacak. “Etik zorluk, kişinin bir vicdan yaratması gerekip gerekmediğidir. Özellikle GPT-3 gibi günümüzün büyük dil modellerinin zaten her türlü etik sorunu sunduğuna dikkat çekiyor.

Kaynak : ZDNet.com