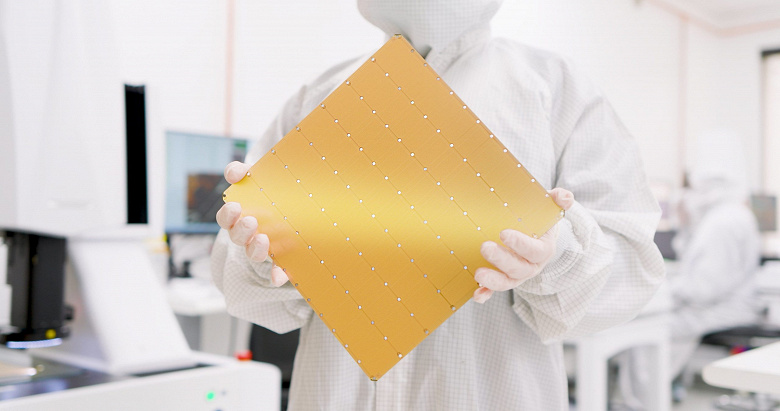

Devasa iPad boyutundaki Cerebras WSE-3 çipleri, günümüzün en hızlı sinir ağını, en iyi GPU tabanlı bulut sunucularından çok daha yüksek hızlarda çalıştırma kapasitesine sahiptir.

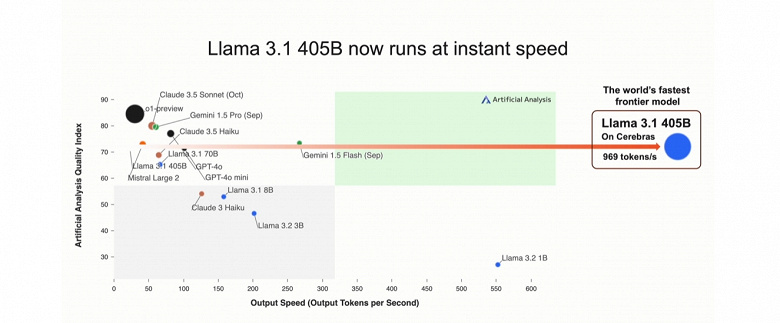

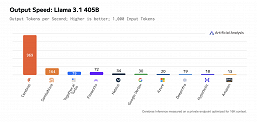

Cerebras, Frontier modeli için yeni bir rekor olan yeni Llama 3.1 405B üzerinde 969 token/s hızında müşteri iş yükünü çalıştırdığını söyledi.

Cerebras’taki Llama 3.1 405B, dünyadaki en hızlı Frontier modelidir – GPT-4o’dan 12 kat ve Claude 3.5 Sonnet’ten 18 kat daha hızlı.

Model, aynı dev WSE-3 çiplerini kullanan Cerebras Inference bulut hizmetinde başlatıldı. Cerebras her zaman Çıkarım hizmetinin büyük dil modeli belirteçleri oluşturmada en hızlı hizmet olduğunu iddia etti.

Cerebras Inference, Ağustos ayında ilk kez piyasaya sürüldüğünde, Llama 3.1 8B ve Llama 3.1 70B modelleri üzerinde değerlendirildiğinde, Amazon Web Services gibi bulut sağlayıcıları üzerinden çalışan Nvidia GPU’lardan yaklaşık 20 kat daha hızlı olduğu söylendi. Artık 405 milyar parametreli dev Llama 3.1 405B modelinin sonucunu aldık.

Bunun ne kadar hızlı olduğunu göstermek için Cerebras, hizmetine Python’da bir satranç programı oluşturma görevini verdi. Cerebras Inference işi yaklaşık 3 saniyede tamamladı ve en hızlı bulut tabanlı GPU donanımlı yapay zeka hizmeti olan Fireworks bunu 20 saniyede yaptı.

Şirket ayrıca moleküler dinamik simülasyonlarında yalnızca bir WSE-2 çipinin Frontier süper bilgisayarından 768 kat daha iyi performans göstermesiyle övündü. Frontier, 2021’den bu yana dünyanın en hızlı süper bilgisayarı oldu ve yerini ancak şimdi El Capitan aldı.

Cerebras WSE-3’ün 4 trilyon transistör, 900.000 çekirdek ve 21 PB/s bant genişliğine sahip 44 GB bellek içerdiğini hatırlayın.