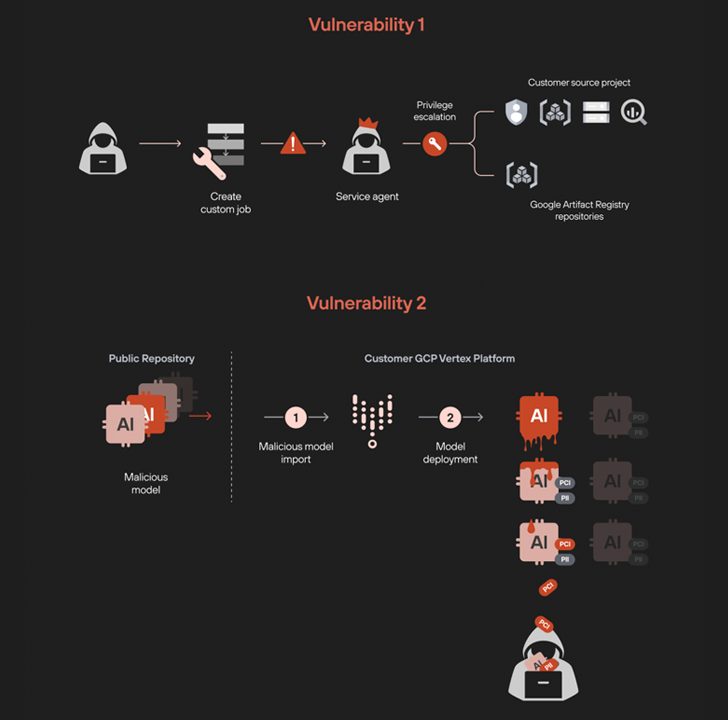

Siber güvenlik araştırmacıları, Google’ın Vertex makine öğrenimi (ML) platformunda, başarılı bir şekilde kullanılması durumunda kötü niyetli aktörlerin ayrıcalıkları artırmasına ve modelleri buluttan sızdırmasına olanak tanıyabilecek iki güvenlik açığını ortaya çıkardı.

Palo Alto Networks Unit 42 araştırmacıları Ofir Balassiano ve Ofir Shaty, “Özel iş izinlerinden yararlanarak ayrıcalıklarımızı artırmayı ve projedeki tüm veri hizmetlerine yetkisiz erişim elde etmeyi başardık.” söz konusu Bu hafta başlarında yayınlanan bir analizde.

“Vertex AI’de zehirlenmiş bir modelin kullanılması, diğer tüm ince ayarlı modellerin sızmasına yol açarak ciddi bir özel ve hassas veri hırsızlığı saldırısı riski oluşturdu.”

Vertex AI: Google’ın makine öğrenimi platformu özel makine öğrenimi modellerini ve yapay zeka (AI) uygulamalarını geniş ölçekte eğitmek ve dağıtmak için. İlk olarak Mayıs 2021’de tanıtıldı.

Ayrıcalık yükseltme kusurundan yararlanmak için çok önemli olan bir özellik, Vertex AI Ardışık DüzenleriBu, kullanıcıların özel işleri kullanarak ML modellerini eğitmek ve ayarlamak için MLOps iş akışlarını otomatikleştirmesine ve izlemesine olanak tanır.

Unit 42’nin araştırması, özel iş akışını manipüle ederek, normalde kısıtlı olan kaynaklara erişim kazanmak için ayrıcalıkları yükseltmenin mümkün olduğunu buldu. Bu, bir ters kabuk başlatmak ve ortama arka kapı erişimi sağlamak üzere tasarlanmış özel hazırlanmış bir görüntüyü çalıştıran özel bir iş yaratılarak gerçekleştirilir.

Güvenlik satıcısına göre özel iş, tüm işlerin listelenmesi için kapsamlı izinlere sahip bir hizmet aracısı hesabıyla bir kiracı projesinde çalışır. hizmet hesaplarıdepolama gruplarını yönetin ve BigQuery tablolarına erişin. Bu tablolar daha sonra dahili Google Cloud veri havuzlarına erişmek ve görselleri indirmek için kötüye kullanılabilir.

Öte yandan ikinci güvenlik açığı, bir kiracı projesinde zehirlenmiş bir modelin, bir uç noktaya dağıtıldığında ters bir kabuk oluşturacak şekilde dağıtılmasını ve “özel çevrimiçi tahmin” hizmet hesabının salt okunur izinlerinin numaralandırılmasını içerir. Kubernetes kümeleri ve isteğe bağlı kubectl komutlarını çalıştırmak için kimlik bilgilerini getirir.

Araştırmacılar, “Bu adım, GCP alanından Kubernetes’e geçmemizi sağladı” dedi. “Bu yatay hareket, GCP ile GKE arasındaki izinlerin birbirine bağlı olması nedeniyle mümkün oldu IAM İş Yükü Kimlik Federasyonu“

Analiz ayrıca Kubernetes kümesinde yeni oluşturulan görüntüyü görüntülemek ve gerekli bilgileri almak için bu erişimden yararlanmanın mümkün olduğunu buldu. görüntü özeti – bir konteyner görüntüsünü benzersiz bir şekilde tanımlayan – bunları kullanarak konteynerin dışındaki görüntüleri çıkarmak için bunları kullanmak eleştiri “özel çevrimiçi tahmin” hizmet hesabıyla ilişkili kimlik doğrulama belirteciyle.

Üstelik kötü amaçlı model, tüm geniş dil modellerini görüntülemek ve dışa aktarmak için de silah haline getirilebilir (Yüksek Lisans’lar) ve onların ince ayarlı adaptörler benzer şekilde.

Bir geliştiricinin, halka açık bir depoya yüklenen truva atı haline getirilmiş bir modeli bilmeden dağıtması ve böylece tehdit aktörünün tüm makine öğrenimi ve ince ayarlı LLM’lerden sızmasına izin vermesi, bunun ciddi sonuçları doğurabilir. Sorumlu bir açıklamanın ardından her iki eksiklik de Google tarafından giderildi.

Araştırmacılar, “Bu araştırma, tek bir kötü amaçlı model dağıtımının tüm yapay zeka ortamını nasıl tehlikeye atabileceğini vurguluyor” dedi. “Bir saldırgan, hassas verileri sızdırmak için üretim sisteminde konuşlandırılan doğrulanmamış tek bir modeli bile kullanabilir ve bu da ciddi model sızdırma saldırılarına yol açabilir.”

Kuruluşların, kiracı projelerinde bir modeli dağıtmak için gereken model dağıtımları ve denetim izinleri üzerinde sıkı kontroller uygulaması önerilir.

Bu gelişme, Mozilla’nın 0Day Investigative Network’ünün (0Din), OpenAI ChatGPT’nin temel sanal alan ortamıyla (“/home/sandbox/.openai_internal/”) istemler aracılığıyla etkileşim kurmanın mümkün olduğunu ortaya koymasıyla geldi; bu, Python komut dosyalarını yükleme ve yürütme, dosyaları taşıma yeteneği sağlıyor. ve hatta LLM’nin başucu kitabını indirin.

Bununla birlikte, kod yürütmenin sanal alanın sınırları içinde gerçekleştiği ve dışarı taşma ihtimalinin düşük olduğu göz önüne alındığında, OpenAI’nin bu tür etkileşimleri kasıtlı veya beklenen davranış olarak değerlendirdiğini belirtmekte fayda var.

Güvenlik araştırmacısı Marco Figueroa, “OpenAI’nin ChatGPT sanal alanını keşfetmeye istekli herkes için, bu kapsayıcı ortamdaki çoğu etkinliğin güvenlik açıklarından ziyade amaçlanan özellikler olduğunu anlamak çok önemlidir.” söz konusu.

“Konteynerin görünmez çizgilerini aşmadıkları sürece, bilgi çıkarmak, dosya yüklemek, bash komutlarını çalıştırmak veya sandbox içinde python kodunu çalıştırmak adil bir oyundur.”