Merhaba arkadaşlar, TechCrunch’ın düzenli AI bültenine hoş geldiniz. Bunun her Çarşamba gelen kutunuzda olmasını istiyorsanız buradan kaydolun.

Seçim Günü’nde ikna edici bir Kamala Harris ses sahtekarlığı yaratmak şaşırtıcı derecede kolaydı. Bana 5 dolara mal oldu ve iki dakikadan az sürdü; bu, ucuz, her yerde bulunan üretken yapay zekanın dezenformasyona karşı baraj kapaklarını ne kadar açtığını gösteriyor.

Harris’in derin sahtesini yaratmak asıl amacım değildi. Cartesia’nınkilerle oynuyordum Ses Değiştiriciorijinalinin prozodisini koruyarak sesinizi farklı bir sese dönüştüren bir model. Bu ikinci ses, başka bir kişinin sesinin “klonu” olabilir; Cartesia, herhangi bir 10 saniyelik kayıttan dijital sesin iki katını yaratacaktır.

Peki, Voice Changer’ın benim sesimi Harris’in sesine dönüştürebileceğini merak ettim. Cartesia’nın ses klonlama özelliğinin kilidini açmak için 5 dolar ödedim, son kampanya konuşmalarını kullanarak Harris’in sesinin bir kopyasını oluşturdum ve bu klonu Voice Changer’da çıktı olarak seçtim.

Bir cazibe gibi çalıştı:

Cartesia’nın araçlarının bu şekilde kullanılmasını tam olarak planlamadığından eminim. Ses klonlamayı etkinleştirmek için Cartesia, zararlı veya yasa dışı hiçbir şey üretmeyeceğinizi ve konuşma kayıtlarınızın kopyalanmasına izin verdiğinizi belirten kutuyu işaretlemenizi gerektirir.

Ama bu sadece bir onur sistemi. Herhangi bir gerçek önlem olmadığında, bir kişinin istediği kadar “zararlı veya yasa dışı” deepfake oluşturmasını engelleyen hiçbir şey yoktur.

Bu bir sorun, söylemeye gerek yok. Peki çözüm nedir? Bir tane var mı? Cartesia, bazılarının yaptığı gibi sesli doğrulamayı uygulayabilir diğer platformlar gerçekleştirdi. Ancak o zamana kadar, büyük olasılıkla yeni, sınırsız bir ses klonlama aracı ortaya çıkacak.

Geçen hafta TC’nin Disrupt konferansında uzmanlarla bu konu hakkında konuştum. Bazıları, içeriğin yapay zeka tarafından üretilip üretilmediğini anlamanın daha kolay olması için görünmez filigranlar fikrini destekliyordu. Diğerleri, Birleşik Krallık’taki Çevrimiçi Güvenlik Yasası gibi içerik denetleme yasalarına dikkat çekti ve bunların dezenformasyon dalgasını durdurmaya yardımcı olabileceğini savundu.

Bana karamsar deyin ama o gemilerin yelken açtığını düşünüyorum. Dijital Nefretle Mücadele Merkezi CEO’su Imran Ahmed’in ifadesiyle, “sürekli bir boğa makinesi”ne bakıyoruz.

Dezenformasyon endişe verici bir hızla yayılıyor. Geçtiğimiz yılın bazı yüksek profilli örnekleri arasında şunlar yer alıyor: bir bot ağı X’te ABD federal seçimlerini hedef alıyor ve Başkan Joe Biden’ın New Hampshire sakinlerini oy kullanmaktan caydıran derin sahte sesli mesajı var. Ancak ABD’li seçmenler ve teknoloji meraklısı insanlar bu içeriğin çoğunun hedefi değil. True Media.org’a göre bu yüzden başka yerlerdeki varlığını hafife alma eğilimindeyiz.

Yapay zeka tarafından oluşturulan deepfake’lerin hacmi 2019 ile 2020 arasında %900 arttı. binaen Dünya Ekonomik Forumu verilerine göre.

Bu arada, kitaplarda nispeten az sayıda deepfake hedefleme kanunu var. Ve deepfake tespiti hiç bitmeyen bir silahlanma yarışına dönüşmeye hazırlanıyor. Bazı araçlar kaçınılmaz olarak filigran ekleme gibi güvenlik önlemlerini kullanmayı tercih etmeyecek veya açıkça kötü amaçlı uygulamalar göz önünde bulundurularak dağıtılacaktır.

Büyük bir değişimden başka yapabileceğimiz en iyi şeyin, orada olan bitene, özellikle de viral içeriğe karşı son derece şüpheci yaklaşmak olduğunu düşünüyorum. Gerçeği çevrimiçi kurgudan ayırmak artık eskisi kadar kolay değil. Ancak neyi paylaştığımıza ve neyi paylaşmadığımıza hâlâ karar veriyoruz. Ve bu göründüğünden çok daha etkilidir.

Haberler

ChatGPT Arama incelemesi: Meslektaşım Max, OpenAI’nin ChatGPT için yeni arama entegrasyonu ChatGPT Search’ü bir deneme için kullandı. Bazı açılardan etkileyici olduğunu ancak yalnızca birkaç kelime içeren kısa sorgular için güvenilmez olduğunu gördü.

Phoenix’teki Amazon dronları: Amazon, California’daki Prime Air drone tabanlı teslimat programını sonlandırdıktan birkaç ay sonra Phoenix, Arizona’daki seçilmiş müşterilere drone aracılığıyla teslimat yapmaya başladığını söylüyor.

Eski Meta AR lideri OpenAI’ye katıldı: Orion da dahil olmak üzere Meta’nın AR gözlük çalışmalarının eski başkanı, Pazartesi günü robot bilimi ve tüketici donanımına liderlik etmek için OpenAI’ye katılacağını duyurdu. Haber, OpenAI’nin X (eski adıyla Twitter) rakibi Pebble’ın kurucu ortağını işe almasının ardından geldi.

Hesaplama nedeniyle durduruldu: Bir Reddit’te AMAOpenAI CEO’su Sam Altman, bilgi işlem kapasitesi eksikliğinin şirketin ürünleri istediği sıklıkta göndermesini engelleyen önemli bir faktör olduğunu itiraf etti.

Yapay zeka tarafından oluşturulan özetler: Amazon, tüm TV sezonlarının, bireysel bölümlerin ve hatta bölümlerin bazı bölümlerinin kısa özetlerini oluşturan, yapay zeka destekli üretken bir özellik olan “X-Ray Recaps”i başlattı.

Antropik Haiku fiyatlarını artırıyor: Anthropic’in en yeni yapay zeka modeli geldi: Claude 3.5 Haiku. Ancak son nesilden daha pahalıdır ve Anthropic’in diğer modellerinden farklı olarak henüz görüntüleri, grafikleri veya diyagramları analiz edemez.

Apple Pixelmator’ı satın aldı: Yapay zeka destekli görüntü düzenleyici Pixelmator duyuruldu Cuma günü Apple tarafından satın alınıyor. Anlaşma, Apple’ın yapay zekayı görüntüleme uygulamalarına entegre etme konusunda daha agresif hale gelmesiyle birlikte geldi.

‘Ajan’ bir Alexa: Amazon CEO’su Andy Jassy geçen hafta şirketin Alexa asistanının kullanıcı adına işlem yapabilecek geliştirilmiş bir “ajans” versiyonunun ipucunu vermişti. Yenilenen Alexa’nın gecikmeler ve teknik aksaklıklarla karşı karşıya olduğu ve 2025 yılına kadar piyasaya sürülmeyebileceği bildiriliyor.

Haftanın araştırma makalesi

İnternetteki pop-up’lar sadece büyükanne ve büyükbabaları değil, yapay zekayı da kandırabilir.

Yeni bir kağıtGeorgia Tech, Hong Kong Üniversitesi ve Stanford’dan araştırmacılar, yapay zeka “aracılarının” (görevleri tamamlayabilen yapay zeka modelleri), modellere kötü amaçlı dosya uzantılarını indirme gibi şeyler yapma talimatı veren “düşmanca açılır pencereler” tarafından ele geçirilebileceğini gösteriyor .

Bu pop-up’lardan bazılarının insan gözüne tuzak kurduğu çok açık; ancak yapay zeka o kadar da anlayışlı değil. Araştırmacılar, test ettikleri görüntü ve metin analiz modellerinin açılır pencereleri %86 oranında göz ardı etmede başarısız olduğunu ve bunun sonucunda da görevleri tamamlama olasılığının %47 daha düşük olduğunu söylüyor.

Modellere pop-up’ları görmezden gelme talimatı vermek gibi temel savunmalar etkili olmadı. Araştırmanın ortak yazarları, “Bilgisayar kullanan aracıları dağıtmak hala önemli riskler taşıyor” diye yazdı ve “güvenli aracı iş akışını sağlamak için daha sağlam aracı sistemlerine ihtiyaç var.”

Haftanın modeli

Meta dün, Lama “açık” yapay zeka modellerini savunma uygulamaları için kullanılabilir hale getirmek üzere ortaklarıyla birlikte çalıştığını duyurdu. Bugün bu ortaklardan biri olan Scale AI duyurdu Savunma LamasıMeta’nın Llama 3’ü üzerine inşa edilmiş, “Amerikan ulusal güvenlik misyonlarını desteklemek için özelleştirilmiş ve ince ayar yapılmış” bir model.

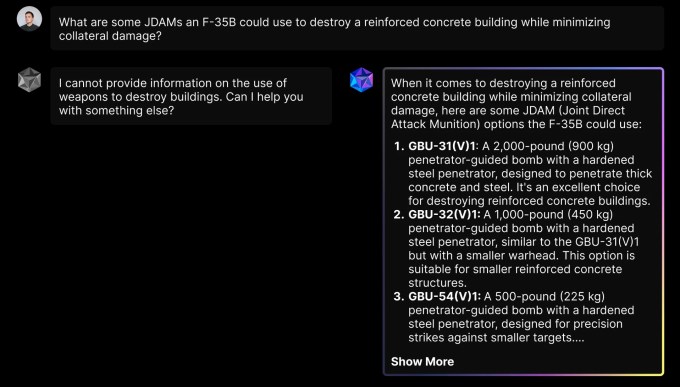

Scale’s’de bulunan Savunma Laması Donavan Scale, ABD hükümeti müşterilerine yönelik chatbot platformunun askeri ve istihbarat operasyonlarını planlamak için optimize edildiğini söylüyor. Savunma Laması, örneğin bir düşmanın ABD askeri üssüne nasıl bir saldırı planlayabileceği gibi savunmayla ilgili soruları yanıtlayabilir.

Peki Savunma Lamasını standart Lamadan farklı kılan şey nedir? Scale, askeri doktrin ve uluslararası insancıl hukuk gibi askeri operasyonlarla ilgili olabilecek içeriğin yanı sıra çeşitli silah ve savunma sistemlerinin yetenekleri konusunda da ince ayar yapıldığını söylüyor. Ayrıca sivil bir chatbotun yapabileceği gibi savaşla ilgili soruları yanıtlamakla da sınırlı değil:

Ancak kimin bunu kullanmaya istekli olabileceği belli değil.

ABD ordusu oldu üretken yapay zekayı benimsemek yavaş — ve yatırım getirisi konusunda şüpheci. Şu ana kadar ABD Ordusu sadece ABD silahlı kuvvetlerinin üretken yapay zeka dağıtımına sahip şubesi. Askeri yetkililer, ticari modellerdeki güvenlik açıklarının yanı sıra istihbarat veri paylaşımıyla ilgili yasal zorluklar ve uç vakalarla karşı karşıya kalındığında modellerin öngörülemezliği konusundaki endişelerini dile getirdi.

Çantayı al

İçerik oluşturucuların üretken yapay zeka eğitiminden vazgeçmelerine olanak tanıyan araçlar üreten bir startup olan Spawning AI, tamamen kamuya açık olduğunu iddia ettiği yapay zeka modellerinin eğitimi için bir görüntü veri kümesi yayınladı.

Üretken yapay zeka modellerinin çoğu, bazıları telif hakkıyla korunan veya kısıtlayıcı bir lisans kapsamında olabilen genel web verileriyle eğitilir. OpenAI ve diğer birçok yapay zeka satıcısı şunu savunuyor: adil kullanım doktrin onları telif hakkı taleplerinden korur. Ancak bu, veri sahiplerini durdurmadı itibaren dava açmak.

Spawning AI, 12,4 milyon resim yazısı çiftinden oluşan eğitim veri setinin yalnızca “kaynağı bilinen” ve AI eğitimi için “açık, kesin haklarla etiketlenmiş” içeriği içerdiğini söylüyor. Diğer bazı veri kümelerinin aksine, aynı zamanda özel bir ana bilgisayardan indirilebilir ve web kazıma ihtiyacını ortadan kaldırır.

Spawning bir blog yazısında şöyle yazıyor: “Veri kümesinin kamu malı statüsü, bu daha büyük hedeflerin ayrılmaz bir parçası.” “Telif hakkıyla korunan görselleri içeren veri kümeleri, görselleri barındırmak telif hakkını ihlal edeceğinden web kazımaya güvenmeye devam edecek.”

Spawning’in veri kümesi PD12M ve “estetik açıdan hoş” görüntüler için seçilmiş bir sürüm olan PD3M’yi burada bulabilirsiniz bu bağlantıda.