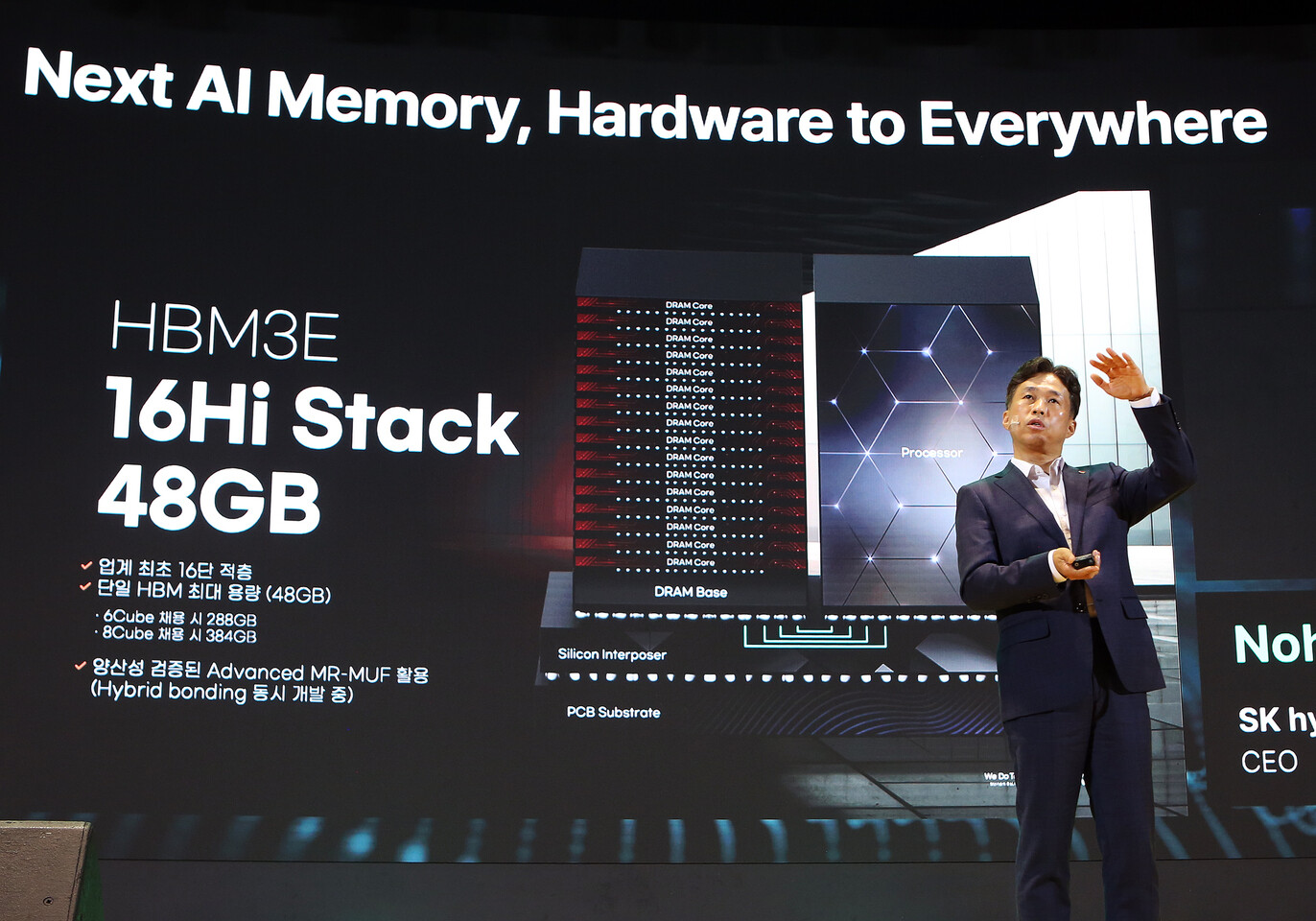

SK Yapay Zeka Zirvesi 2024’te, SK hynix CEO sahneye çıktı ve sektörün ilk 16-Hi HBM3E belleğini tanıttı; hem Samsung’u hem de Micron’u geride bıraktı. HBM4’ün geliştirilmesinin güçlenmesiyle birlikte SK hynix, “teknolojik istikrarı” sağlamak için HBM3E tekliflerinin 16 katmanlı bir versiyonunu hazırladı ve numuneleri gelecek yılın başlarında sunmayı hedefliyor.

Birkaç hafta önce SK hynix, HBM3E belleğinin 12-Hi versiyonunu piyasaya sürdü; AMD (MI325X) ve Nvidia (Blackwell Ultra) ile sözleşme imzaladı. Geçtiğimiz çeyrekte rekor kar elde eden SK hynix, HBM3E serisinde yığın başına 48 GB (bireysel kalıp başına 3 GB) kapasiteye sahip 16 katmanlı bir yükseltmeyi duyurduğu için bir kez daha tüm hızıyla devam ediyor. Yoğunluktaki bu artış artık AI hızlandırıcıların 8 yığınlı bir yapılandırmada 384 GB’a kadar HBM3E belleğe sahip olmasına olanak tanıyor.

SK hynix, çıkarım performansında %32’lik bir artışın yanı sıra eğitimde de %18’lik bir iyileşme olduğunu iddia ediyor. 12-Hi muadili gibi, yeni 16-Hi HBM3E bellek de çipleri aralarındaki lehimi eriterek birbirine bağlayan MR-MUF gibi paketleme teknolojilerini içeriyor. SK hynix, 16-Hi HBM3E örneklerinin 2025 başlarında hazır olmasını bekliyor. Ancak Nvidia’nın yeni nesil Rubin çiplerinin gelecek yılın sonlarında seri üretime geçmesi planlandığı ve HBM4’ü temel alacağı için bu hafıza kısa ömürlü olabilir.

Şirketin aktif olarak PCIe 6.0 SSD’ler, yapay zeka sunucularını hedefleyen yüksek kapasiteli QLC (Dört Seviyeli Hücre) eSSD’ler ve mobil cihazlar için UFS 5.0 üzerinde çalıştığı göz önüne alındığında, hepsi bu kadar değil. Ek olarak, gelecekteki dizüstü bilgisayarlara ve hatta el bilgisayarlarına güç sağlamak için SK hynix, 1cnm düğümünü kullanarak bir LPDDR5/6 belleği ve lehimlenmiş bir LPDDR5/6 belleği geliştiriyor. Masaüstü bilgisayarlar için CAMM2 modüllerinden bahsedilmiyor, dolayısıyla PC halkının en azından CAMM2’nin benimsenmesi olgunlaşana kadar beklemesi gerekecek.

Bellek üreticisi, SK hynix’in “bellek duvarı” olarak adlandırdığı şeyin üstesinden gelmek için Yakın Belleğe İşleme (PNM), Bellekte İşleme (PIM) ve Hesaplamalı Depolama gibi çözümler geliştiriyor. Samsung, verilerin harici bir işlemciye taşınmasına gerek kalmaması için verilerin bellekte işlendiği PIM versiyonunun tanıtımını zaten yaptı.

HBM4, kanal genişliğini iki katına çıkararak 1024 bitten 2048 bit’e çıkaracak ve her biri 4 GB’a kadar belleğe sahip 16’dan fazla dikey olarak istiflenmiş DRAM kalıbını (16-Hi) destekleyecektir. Bunlar, nesilden nesile yapılan bazı devasa yükseltmelerdir ve yakında çıkacak olan AI GPU’ların yüksek bellek taleplerini karşılamaya yeterli olmalıdır.

Samsung’un HBM4 bant çıkışı bu yılın sonuna doğru ilerlemeye başlayacak. Diğer taraftan, raporlar SK hynix’in banttan çıkış aşamasına Ekim ayında ulaştığını öne sürüyoruz. Geleneksel silikon geliştirme yaşam döngüsünün ardından Nvidia ve AMD’nin gelecek yılın 1./2. çeyreğine kadar yeterlilik örnekleri almasını bekliyoruz.