Yeni bir rapora göre araştırmacılar, OpenAI’nin ses destekli transkripsiyon aracı Whisper’ın, potansiyel olarak tehlikeli sonuçlar doğurabilecek, asla söylenmemiş şeyler icat ettiğini buldu.

göre AP HaberleriYapay Zeka modeli, büyük dil modelinin kendi eğitim materyalinde bulunmayan kalıpları tespit ettiği ve böylece anlamsız çıktılar oluşturduğu metni icat ediyor (genellikle ‘halüsinasyon’ olarak anılıyor). ABD’li araştırmacılar Whisper’ın hatalarının ırkçı yorumlar, şiddet ve fantastik tıbbi tedaviler içerebileceğini buldu.

Whisper, ChatGPT’nin bazı sürümleriyle entegredir ve Microsoft ile Oracle’ın bulut bilişim platformlarında yerleşik bir tekliftir. Microsoft belirtti Aracın yüksek riskli kullanıma yönelik olmadığı, ancak sağlık hizmeti sağlayıcılarının doktorlarla hasta konsültasyonlarını yazıya dökmek için bu aracı benimsemeye başladığı belirtiliyor.

Yapımcısı tarafından Whisper’ın “insan düzeyine yakın sağlamlık ve doğruluğa” sahip olduğu iddia ediliyor ve 40 sağlık sisteminde 30.000’den fazla ABD’li klinisyen tarafından benimsendiği iddia ediliyor. Ancak araştırmacılar, farklı çalışmalarda bulunan sorunlar nedeniyle evlat edinmeye karşı uyarıda bulunuyorlar.

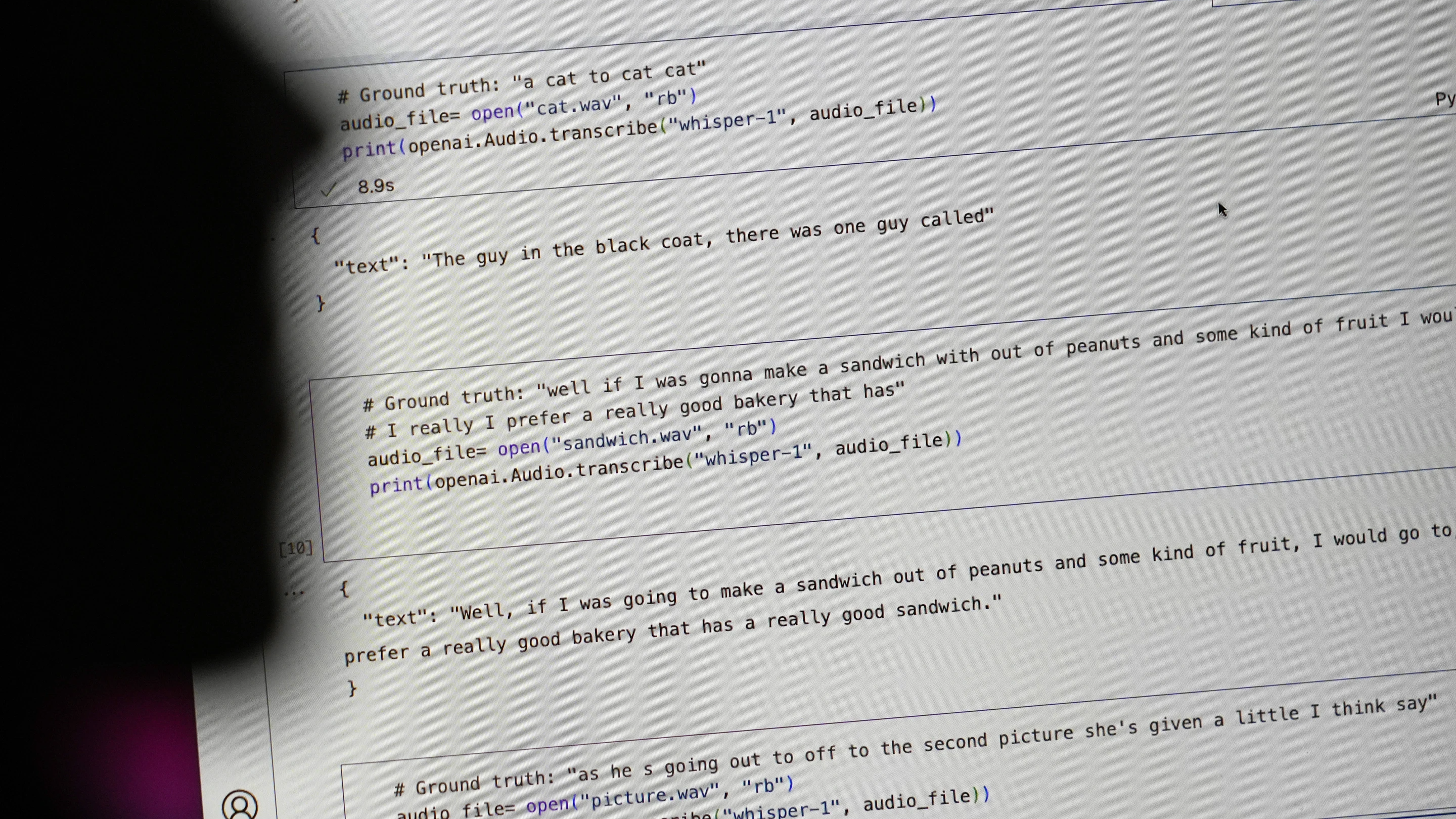

Michigan Üniversitesi’nden bir araştırmacı, halka açık toplantılar üzerinde yaptığı bir araştırmada, incelenen her 10 ses transkripsiyonunun sekizinde Whisper’ın halüsinasyon gördüğünü tespit etti. Bu arada, bir makine öğrenimi mühendisi, 100 saatten fazla transkripsiyonun yaklaşık yarısında halüsinasyonlar keşfetti ve üçüncü bir geliştirici, Whisper ile oluşturduğu 26.000 transkripsiyonun neredeyse her birinde halüsinasyonlar buldu.

Geçtiğimiz ay Whisper, açık kaynaklı yapay zeka platformu HuggingFace’ten 4,2 milyondan fazla indirildi ve araç, web sitesindeki en popüler konuşma tanıma modeli oldu. Carnegie Mellon Üniversitesi’nde barındırılan bir veri deposu olan TalkBank’tan alınan materyalleri analiz eden araştırmacılar, Whisper’ın ürettiği halüsinasyonların %40’ının, konuşmacının “yanlış yorumlanması veya yanlış tanıtılması” nedeniyle zararlı olabileceğini belirlediler.

Bu tür parçacıkların AP örneklerinde, bir konuşmacı “diğer iki kız ve bir bayanı” tanımladı ve Whisper, “diğer iki kız ve bir bayanın siyah olduğunu” belirterek ırkla ilgili bir yorum icat etti. Başka bir örnekte araç, “hiperaktif antibiyotikler” olarak bilinen kurgusal bir ilaç yarattı.

Princeton Profesörü Alondra Nelson, AP’ye “kimsenin yanlış teşhis istemediğini” söyledi, bulunan hatalara benzer hataların özellikle sağlık bakım ortamlarında “gerçekten ciddi sonuçlara” yol açabileceğini söyledi.

Eski çalışan William Saunders’ın AP’ye söylediği gibi, OpenAI’nin sorunu çözmesi yönünde çağrılar var: “Bunu ortaya koyarsanız ve insanlar onun neler yapabileceğine ve onu diğer tüm sistemlere entegre edeceğine aşırı güveniyorsa sorun olur”.

Birçok kullanıcı yapay zeka araçlarının hata yapmasını veya kelimeleri yanlış yazmasını beklerken, araştırmacılar diğer programların da en az Whisper kadar hata yaptığını buldu.

Google’ın Yapay Zekaya Genel Bakış eleştiriyle karşılandı Bu yılın başlarında peynirin pizzadan düşmesini önlemek için toksik olmayan yapıştırıcı kullanılmasını öneren şirket, alaycı bir Reddit yorumunu kaynak olarak göstermişti.

Apple’ın CEO’su Tim Cook bir röportajda kabul edildi AI halüsinasyonlarının Apple Intelligence paketi de dahil olmak üzere gelecekteki ürünlerde bir sorun olabileceğini söyledi. Cook, Washington Post’a, aletlerin halüsinasyon gösterip göstermeyeceği konusunda güven düzeyinin %100 olmadığını söyledi.

Cook, “Teknolojinin kullandığımız alanlarda hazır olup olmadığı konusunda derinlemesine düşünmek dahil, yapmayı bildiğimiz her şeyi yaptığımızı düşünüyorum” dedi.

Buna rağmen şirketler, Whisper’ın icatlarına benzer şekilde halüsinasyonların yaygın bir sorun olmaya devam etmesiyle yapay zeka araç ve programlarının geliştirilmesini ilerletiyor. OpenAI’nin halüsinasyonlara tepkisine gelince, Whisper’ın “doğruluktaki kusurların sonuçlarda belirgin kusurlara yol açabileceği karar verme bağlamlarında” kullanılmamasını tavsiye etti.