Nvidia, GB200 NVL72 raf ve bilgi işlem/anahtar tepsisi tasarımlarıyla Açık Hesaplama Projesi’ne (OCP) katkıda bulunarak OCP üyelerinin tasarımlarını Nvidia Blackwell GPU’larını temel alarak oluşturmalarına olanak sağladı. Şirket, Nvidia’nın güce aç yeni nesil GPU’larını Nvidia ağıyla destekleyebilecek açık veri merkezi platformlarının gelişimini hızlandırmak için yüksek performanslı sunucu platformunun temel tasarım öğelerini paylaşıyor.

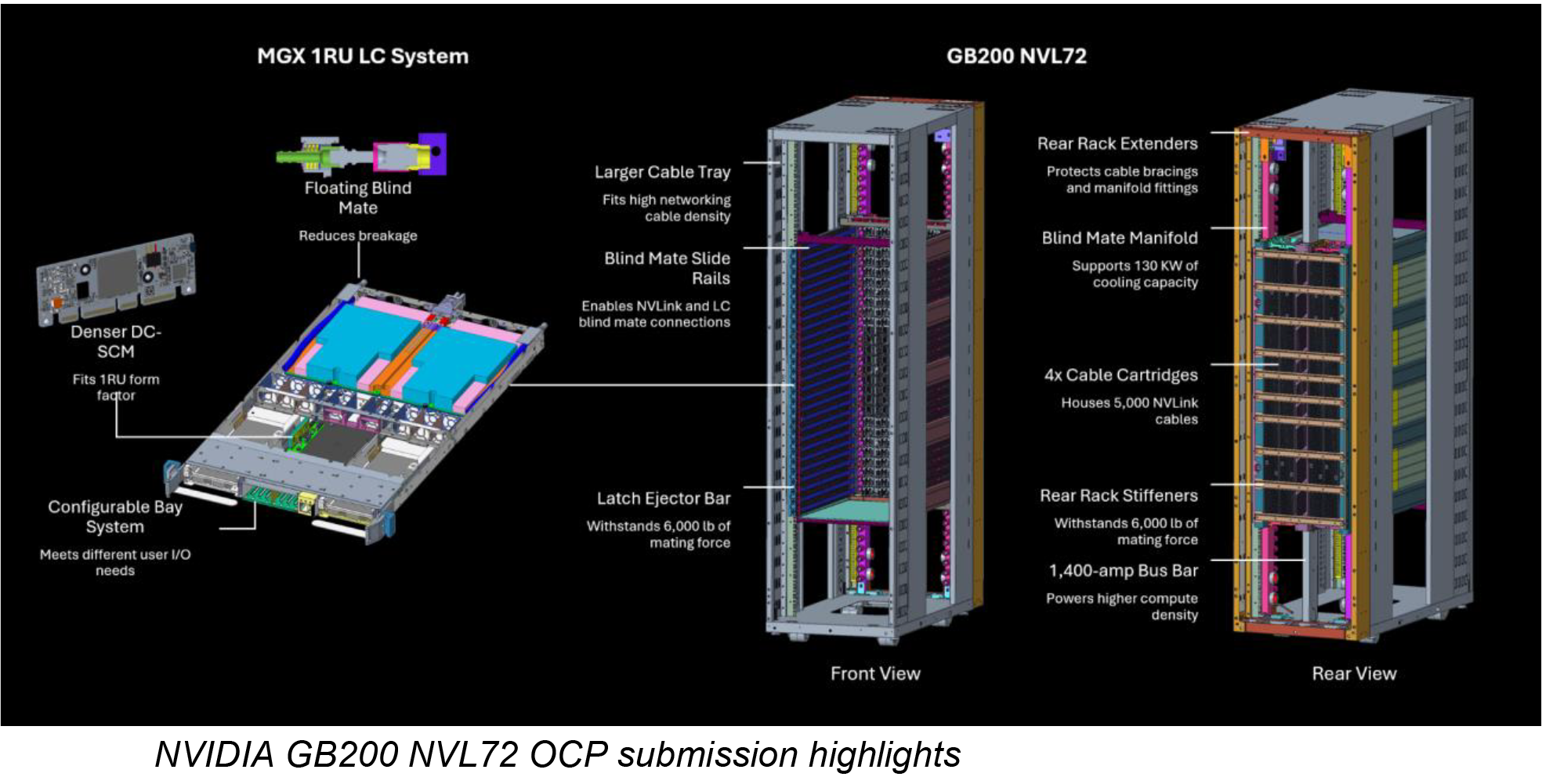

72 GB100 veya GB200’e kadar GPU’ya sahip GB200 NVL72 sistemi bu katkının merkezinde yer alıyor. Nvidia, raf mimarisi, soğutma sistemi ve bilgi işlem tepsisi bileşenleriyle ilgili ayrıntılar da dahil olmak üzere kritik elektro-mekanik tasarımları paylaşıyor. GB200 NVL72 sistemi, 36 Grace CPU’yu ve 72 Blackwell GPU’yu raf ölçekli bir konfigürasyonda birbirine bağlayan Nvidia’nın MGX mimarisini temel alan modüler bir tasarıma sahiptir. Bu kurulum, 72 GPU’lu bir NVLink alanı sağlayarak sistemin çok büyük bir tek GPU gibi davranmasına olanak tanır.

OCP etkinliğinde Nvidia, GB200 NVL72’nin yeni ortak referans tasarımını tanıttı. Yüksek yoğunluklu bilgi işlem veri merkezlerinde uzmanlığıyla bilinen lider güç ve soğutma çözümü Vertiv ile birlikte geliştirildi. Bu yeni referans tasarımı, bulut hizmet sağlayıcıları (CSP’ler) ve Nvidia Blackwell platformunu benimseyen veri merkezleri için dağıtım süresini kısaltıyor.

Bu referans mimarisini kullanarak veri merkezlerinin artık GB200 NVL72’ye özel güç, soğutma veya aralık tasarımları oluşturmasına gerek yok. Bunun yerine Vertiv’in yerden tasarruf sağlayan güç yönetimi ve enerji tasarruflu soğutmaya yönelik gelişmiş çözümlerine güvenebilirler. Bu yaklaşım, veri merkezlerinin 7MW GB200 NVL72 kümelerini dünya çapında daha hızlı dağıtmasına olanak tanıyarak uygulama süresini %50’ye kadar kısaltır.

Meta Mühendislikten Sorumlu Başkan Yardımcısı Yee Jiun Song, “Nvidia, son iki yıldır Grand Teton sunucumuzun temelini oluşturan yüksek performanslı bilgi işlem platformu da dahil olmak üzere, yıllardır açık bilgi işlem standartlarına önemli bir katkıda bulunuyor” dedi. “Büyük ölçekli yapay zekanın artan bilgi işlem taleplerini karşılamaya devam ederken, Nvidia’nın raf tasarımı ve modüler mimariye yaptığı en son katkılar, endüstri genelinde yapay zeka altyapısının geliştirilmesini ve uygulanmasını hızlandırmaya yardımcı olacak.”

Donanım katkılarına ek olarak Nvidia, Spectrum-X Ethernet ağ platformuyla OCP standartlarını da destekliyor. Nvidia, OCP’nin topluluk tarafından geliştirilen spesifikasyonlarına uyum sağlayarak yapay zeka veri merkezlerinin bağlantısını hızlandırırken kuruluşların önceki yatırımlarını korumak için yazılım tutarlılığını korumalarına da olanak tanıyor.

Nvidia’nın ağ iletişimindeki ilerlemeleri arasında gelecek yıl OCP 3.0 için satışa sunulacak olan ConnectX-8 SuperNIC yer alıyor. Bu SuperNIC’ler, 800 Gb/s’ye kadar veri hızlarını destekler ve programlanabilir paket işlemeleri, kuruluşların daha esnek, yapay zeka için optimize edilmiş ağlar oluşturmasına yardımcı olması beklenen büyük ölçekli yapay zeka iş yükleri için optimize edilmiştir.

40’tan fazla elektronik üreticisi, Blackwell platformunu oluşturmak için Nvidia ile çalışıyor. OCP’nin kurucusu Meta da önemli ortaklar arasında yer alıyor. Meta, GB200 NVL72 sistemini temel alan Catalina AI raf mimarisini OCP’ye eklemeyi planlıyor.

Nvidia, OCP topluluğuyla yakın iş birliği yaparak tasarımlarının ve teknik özelliklerinin geniş bir yelpazedeki veri merkezi geliştiricileri tarafından erişilebilir olmasını sağlamak için çalışıyor. Sonuç olarak Nvidia, Blackwell GPU’larını ve ConnectX-8 SuperNIC’ini OCP standartlarını kullanan şirketlere satabilecek.

Nvidia’nın kurucusu ve CEO’su Jensen Huang, “OCP ile on yıllık işbirliğine dayanan Nvidia, tüm veri merkezi genelinde yaygın olarak benimsenebilecek spesifikasyonları ve tasarımları şekillendirmek için endüstri liderleriyle birlikte çalışıyor” dedi. “Açık standartları geliştirerek, dünya çapındaki kuruluşların hızlandırılmış bilgi işlemin tüm potansiyelinden yararlanmasına ve geleceğin yapay zeka fabrikalarını yaratmasına yardımcı oluyoruz.”