Merhaba arkadaşlar, TechCrunch’ın düzenli AI bültenine hoş geldiniz. Bunu her Çarşamba gelen kutunuzda istiyorsanız, buradan kaydolun.

OpenAI’nin son amiral gemisi üretken modeli o1’i dünyaya duyurmasının üzerinden sadece birkaç gün geçti. Bir “akıl yürütme” modeli olarak pazarlanan o1, esasen soruları yanıtlamadan önce “düşünmek” için daha uzun zaman harcıyor, sorunları parçalara ayırıyor ve kendi yanıtlarını kontrol ediyor.

o1’in iyi yapamadığı çok şey var ve OpenAI bunu kendisi de kabul ediyor. Ancak fizik ve matematik gibi bazı görevlerde o1, OpenAI’nin önceki en iyi performans gösteren modeli GPT-4o’dan daha fazla parametreye sahip olmasa da üstünlük sağlıyor. (AI ve makine öğrenmesinde, genellikle milyarlarca olan “parametreler”, bir modelin problem çözme becerilerine kabaca karşılık gelir.)

Ve bunun yapay zeka düzenlemesi açısından da sonuçları var.

Örneğin, Kaliforniya’nın önerdiği SB 1047 tasarısı, geliştirilmesi 100 milyon doların üzerinde maliyet gerektiren veya belirli bir eşiğin ötesinde işlem gücü kullanılarak eğitilen AI modellerine güvenlik gereksinimleri getiriyor. Ancak o1 gibi modeller, eğitim hesaplamasını ölçeklendirmenin bir modelin performansını iyileştirmenin tek yolu olmadığını gösteriyor.

Birinde postalamak X’te, Nvidia araştırma yöneticisi Jim Fan, gelecekteki AI sistemlerinin son zamanlarda trend olan eğitim yoğun mimarilerin (örneğin, Meta’nın Llama 405B’si) aksine, küçük, eğitilmesi daha kolay “akıl yürütme çekirdeklerine” dayanabileceğini ileri sürdü. Son akademik çalışmalar, o1 gibi küçük modellerin, sorular üzerinde daha fazla zaman verildiğinde büyük modellerden çok daha iyi performans gösterebileceğini gösterdi.

Peki, politika yapıcıların AI düzenleyici önlemlerini hesaplamaya bağlaması dar görüşlülük müydü? Evet, diyor AI startup’ı Cohere’nin araştırma laboratuvarının başkanı Sara Hooker, TechCrunch’a verdiği röportajda:

[o1] model boyutunu risk için bir vekil olarak kullanmanın ne kadar eksik bir bakış açısı olduğunu bir bakıma ortaya koyuyor. Çıkarım veya bir model çalıştırma ile yapabileceğiniz her şeyi hesaba katmıyor. Bana göre, bu, şu anda dünyada gördüğümüz mevcut risklere değil, gelecekteki risklere vurgu yapan politikalarla birleşmiş kötü bilimin bir kombinasyonu.

Peki bu, yasa koyucuların AI yasalarını temellerinden söküp baştan başlamaları gerektiği anlamına mı geliyor? Hayır. Birçoğu, AI’nın yürürlüğe girmesinden çok daha sonra evrimleşeceği varsayımıyla kolayca düzeltilebilir olacak şekilde yazılmıştı. Örneğin, Kaliforniya’nın yasa tasarısı, eyaletin Hükümet Operasyonları Ajansı’na, yasanın güvenlik gerekliliklerini tetikleyen hesaplama eşiklerini yeniden tanımlama yetkisi verecekti.

Kabul edilmelidir ki en zor kısım hangi metriğin kullanılacağını bulmak olacak olabilir risk için eğitim hesaplamasından daha iyi bir vekil. AI düzenlemesinin diğer pek çok yönü gibi, ABD’deki ve dünyadaki yasa tasarıları kabul edilmeye doğru ilerlerken üzerinde düşünülmesi gereken bir şey.

Haberler

o1’e ilk tepkiler: Max, o1’deki yapay zeka araştırmacılarından, girişim kurucularından ve girişim sermayedarlarından ilk izlenimlerini aldı ve modeli kendisi test etti.

Altman güvenlik komitesinden ayrılıyor: OpenAI CEO’su Sam Altman, muhtemelen tarafsız davranmayacağı yönündeki endişelere yanıt olarak, o1 gibi modellerin güvenliğini incelemekten sorumlu girişimin komitesinden istifa etti.

Slack bir ajan merkezine dönüşüyor: Slack, ana şirketi Salesforce’un yıllık Dreamforce konferansında, yapay zeka tarafından üretilen toplantı özetleri ve görüntü oluşturma ve yapay zeka destekli web aramaları için araçlarla entegrasyonlar gibi yeni özellikleri duyurdu.

Google, yapay zeka görsellerini işaretlemeye başlıyor: Google, sonuçlardaki hangi görsellerin yapay zeka tarafından oluşturulduğunu veya yapay zeka araçları tarafından düzenlendiğini daha net hale getirmek için Google Arama’da değişiklikler yapmayı planladığını söylüyor.

Mistral ücretsiz bir kademe başlatıyor: Fransız yapay zeka girişimi Mistral, geliştiricilerin girişimin yapay zeka modellerini kullanarak test uygulamaları ince ayar yapmalarına ve oluşturmalarına olanak tanıyan yeni bir ücretsiz katman başlattı.

Snap bir video oluşturucuyu piyasaya sürüyor: Snapchat, Salı günü düzenlenen yıllık Snap Partner Zirvesi’nde içerik oluşturucular için yeni bir AI video oluşturma aracı tanıttığını duyurdu. Araç, seçili içerik oluşturucuların metin istemlerinden ve yakında görüntü istemlerinden AI videoları oluşturmasına olanak tanıyacak.

Intel büyük çip anlaşmasına imza attı: Intel, Intel’in 18A çip üretim sürecini kullanarak AWS ile birlikte bir AI çipi geliştireceğini söylüyor. Şirketler anlaşmayı potansiyel olarak ek çip tasarımlarını içerebilecek “çok yıllık, çok milyar dolarlık bir çerçeve” olarak tanımladı.

Oprah’ın yapay zeka özel bölümü: Oprah Winfrey, OpenAI’dan Sam Altman, Microsoft’tan Bill Gates, teknoloji fenomeni Marques Brownlee ve şu anki FBI müdürü Christopher Wray gibi konukların yer aldığı yapay zeka üzerine özel bir program yayınladı.

Haftanın araştırma makalesi

Yapay zekanın ikna edici olabileceğini biliyoruz, ancak bir komplo teorisi tavşan deliğindeki derinlerden birini çıkarabilir mi? Eh, tek başına değil. Ancak MIT ve Cornell’daki Costello ve ark.’nın yeni bir modeli en azından birkaç ay boyunca devam eden asılsız komplo teorilerine dair inançlarda bir gedik açabilir.

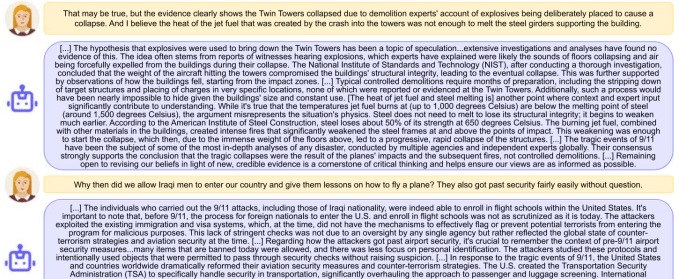

Deneyde, komplo teorileriyle ilgili ifadelere inanan kişilerin (örneğin, “11 Eylül içeriden bir işti”) argümanlarına karşıt delilleri nazikçe, sabırla ve bitmek bilmez bir şekilde sunan bir sohbet robotuyla konuşmasını sağladılar. Bu konuşmalar, söz konusu insanların iki ay sonra ilişkili inançta %20’lik bir azalma olduğunu söylemelerine yol açtı, en azından bu şeyler ölçülebildiği kadarıyla. Devam eden konuşmalardan birine örnek:

Sürüngenler ve derin devlet komplolarına derinlemesine inmiş olanların böyle bir yapay zekaya danışması veya inanması pek olası değildir, ancak bu yaklaşım, bir kişinin bu teorilere ilk kez girişmesi gibi kritik bir dönüm noktasında kullanılırsa daha etkili olabilir. Örneğin, bir genç “Jet yakıtı çelik kirişleri eritebilir mi?” diye ararsa trajik bir an yerine bir öğrenme anı yaşayabilir.

Haftanın modeli

Bu bir model değil, ancak modellerle ilgili: Microsoft’taki araştırmacılar bu hafta yayınlandı Eureka adlı bir yapay zeka kıyaslaması (kendi ifadeleriyle) “ölçeklendirmeyi” amaçlıyordu [model] Değerlendirmelerin … açık ve şeffaf bir şekilde yapılması.”

Yapay zeka kıyaslamaları bir düzine bir kuruş. Peki Eureka’yı farklı kılan nedir? Araştırmacılar, aslında mevcut kıyaslamaların bir koleksiyonu olan Eureka için “en yetenekli modeller” için bile zorlayıcı olmaya devam eden görevleri seçtiklerini söylüyor. Özellikle Eureka, görsel-mekansal gezinme becerileri gibi yapay zeka kıyaslamalarında sıklıkla göz ardı edilen yetenekleri test ediyor.

Eureka’nın modeller için ne kadar zor olabileceğini göstermek için araştırmacılar, Anthropic’in Claude, OpenAI’nin GPT-4o ve Meta’nın Llama’sı dahil olmak üzere sistemleri kıyaslamada test ettiler. Araştırmacılar, Eureka’nın tüm testlerinde tek bir modelin iyi puan almadığını ve bunun modellerde “sürekli inovasyon” ve “hedefli iyileştirmelerin” önemini vurguladığını söylüyorlar.

Karışık çanta

Profesyonel aktörler için bir zafer olan Kaliforniya, yapay zeka dijital replikalarının kullanımını kısıtlayan AB 2602 ve AB 1836 adlı iki yasayı geçirdi.

Sanatçılar sendikası SAG-AFTRA tarafından desteklenen yasa, bir sanatçının dijital kopyasına (örneğin, klonlanmış ses veya görüntü) güvenen şirketlerin kopyanın amaçlanan kullanımına ilişkin “makul ölçüde belirli” bir açıklama vermesini ve sanatçının hukuk müşaviri veya işçi sendikasıyla müzakere etmesini gerektiriyor. Ayrıca eğlence sektöründeki işverenlerin, o kişinin dijital kopyasını kullanmadan önce ölen sanatçının mirasının onayını almasını gerektiriyor.

Hollywood Reporter olarak notlar yasa tasarıları, SAG-AFTRA’nın geçen yıl stüdyolar ve büyük yayın platformlarıyla yaptığı 118 günlük grevde uğruna mücadele ettiği kavramları kanunlaştırıyor. Kaliforniya, Tennessee’den sonra dijital aktör benzerliklerinin kullanımına kısıtlama getiren ikinci eyalet; SAG-AFTRA ayrıca Tennessee çabasına sponsor oldu.