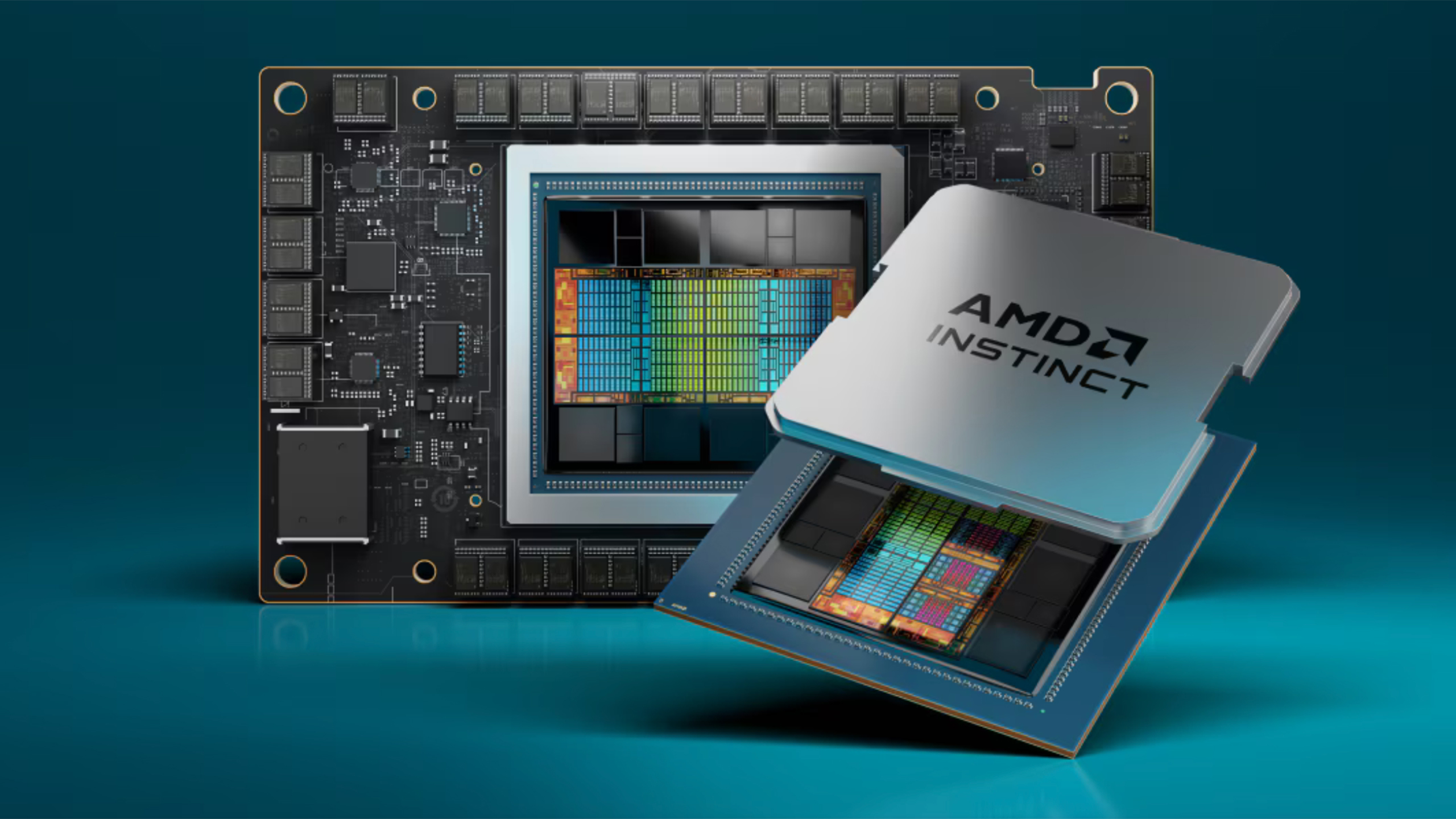

Veri merkezinde daha fazla bilgi işlem gücüne olan talep şaşırtıcı bir hızla artıyor ve AMD, 1,2 milyon veya daha fazla GPU içeren tek yapay zeka kümeleri oluşturmak için ciddi araştırmalar yaptığını açıkladı.

AMD’nin kabulü uzun bir tartışmanın ardından geldi Sonraki Platform AMD’nin EVP’si ve Datacenter Solutions Group Genel Müdürü Forrest Norrod ile AMD’nin veri merkezindeki geleceği hakkında görüştük. En aydınlatıcı yanıtlardan biri, birisinin ciddi olarak düşündüğü en büyük yapay zeka eğitim kümesiyle ilgiliydi.

Şirketin 1,2 milyon GPU kadar büyük kümeler için araştırma yapıp yapmadığı sorulduğunda Forrest, değerlendirmenin neredeyse yerinde olduğunu söyledi.

– Morgan: Birinin ciddi olduğu en büyük yapay zeka eğitim kümesi nedir; isim vermenize gerek yok. Birisi size gelip MI500 ile 1,2 milyon GPU’ya ihtiyacım olduğunu falan söyledi mi?

Forrest Norrod: Bu aralıkta mı? Evet.

– Morgan: Sadece “bu aralıkta” diyemezsiniz. En büyük gerçek sayı nedir?

Forrest Norrod: Çok ciddiyim, o aralıkta.

– Morgan: Bir makine için.

Forrest Norrod: Evet, bir makineden bahsediyorum.

– Morgan: Biraz kafamı karıştırıyor, biliyor musun?

1,2 milyon GPU absürt bir rakam (Forest’un röportajın ilerleyen bölümlerinde söylediği gibi akıllara durgunluk veren bir rakam). Yapay zeka eğitim kümeleri genellikle birkaç veya daha az sunucu rafı üzerinden yüksek hızlı ara bağlantı yoluyla bağlanan birkaç bin GPU ile oluşturulur. Buna karşılık 1,2 milyon GPU’lu bir yapay zeka kümesi oluşturmak neredeyse imkansız görünüyor.

Bir milyonun üzerinde GPU’ya sahip bir yapay zeka kümesi oluşturmak için birinin üstesinden gelmesi gereken tuzakları yalnızca hayal edebiliyoruz, ancak gecikme, güç ve donanım arızalarının kaçınılmazlığı hemen akla gelen birkaç faktördür.

Yapay zeka iş yükleri, özellikle kuyruk gecikmesi ve aykırı değerler olmak üzere gecikmeye karşı son derece hassastır; burada belirli veri aktarımları diğerlerinden çok daha uzun sürer ve iş yükünü kesintiye uğratır. Ek olarak, günümüzün süper bilgisayarlarının, kendi ölçeğinde birkaç saatte bir meydana gelen GPU veya diğer donanım arızalarını azaltması gerekiyor. Günümüzün bilinen en büyük kümelerinin boyutunun 30 katına ölçeklendiğinde bu sorunlar çok daha belirgin hale gelecektir. Ve bu, böylesine cüretkar bir hedef için gereken nükleer santral büyüklüğündeki enerji dağıtımına değinmeden önce.

Dünyanın en güçlü süper bilgisayarları bile milyonlarca GPU’ya ölçeklenemiyor. Örneğin şu anda en hızlı çalışan süper bilgisayar olan Frontier’da “yalnızca” 37.888 GPU bulunuyor.

Milyon GPU kümesi hedefi, 2020’leri şekillendiren yapay zeka yarışının ciddiyetini gösteriyor. Olasılık dahilindeyse, daha fazla yapay zeka işlem gücü anlamına geliyorsa birisi bunu yapmaya çalışacaktır. Forest, hangi kuruluşun bu ölçekte bir sistem oluşturmayı düşündüğünü söylemedi ancak “çok ayık insanların” yapay zeka eğitim kümelerine onlarca ila yüz milyarlarca dolar harcamayı düşündüklerinden bahsetti (bu nedenle milyonlarca GPU kümesi dikkate alınıyor) Tümü).