OpenAI ve DeepMind üyeleri, bu şirketlerin eski çalışanlarıyla birlikte imza attılar: açık bir mektup 4 Haziran Salı. Başlığı “ Gelişmiş yapay zeka konusunda uyarı hakkı “. Yapay zeka (AI) hakkındaki endişelerini dile getiriyorlar.

Riskler, izleme eksikliği ve hatta olası ihbarcılara karşı koruma eksikliği gibi konular çoktur. Bu alarm çığlığının arkasında, diğerlerinin yanı sıra, OpenAI’nin 1 numaralı dört anonim çalışanının yanı sıra şirketin yedi eski üyesi de var.

Yapay zekanın arkasında muazzam riskler ve göze çarpan denetim eksikliği var

Yapay zeka pazarı Kısa bir on yıl içinde gelirinin 1.000 milyar dolara ulaşması bekleniyor. Kasım 2022’de ChatGPT’nin ortaya çıkışından bu yana katlanarak artan bir patlama. Bu pazar patlaması özellikle birkaç büyük şirkete fayda sağladı.

Google, Microsoft, Meta ve özellikle OpenAI bugün sektöre hakim durumda. Her türden üretken yapay zeka ve büyük dil modelleri (LLM), bilgisayarlardan akıllı telefonlara ve arabalara kadar birçok medyada çoğalmaya devam ediyor. İki yıldan kısa bir süre içinde gerçek anlamda küresel bir yarış başladı.

Bu güçlü şirketler, şampiyonlarının dünya lideri olmasına yardımcı olmak isteyen hükümetler tarafından desteklenebilir. Fransa’daki MistralAI gibi. Açık mektubu imzalayanlara göre, denetim eksikliğinin eşlik ettiği her şeye gücü yeten bir durum.

“ Yapay zeka şirketleri, etkili gözetimden kaçınmak için güçlü mali teşviklerden yararlanıyor ve özel kurumsal yönetim yapılarının bunu değiştirmek için yeterli olduğunu düşünmüyoruz. “, yazdılar.

Gerçekte bu şirketler, yapay zekalarının yetenekleri ve risk seviyeleri hakkında hâlâ kamuya açıklanmayan bilgilere sahip olacak. Şunu işaret ediyorlar: bu teknolojilerin oluşturduğu ciddi riskler “.

Onlara göre şirketler “ şu anda bu bilgilerin bir kısmını hükümetlerle paylaşma konusunda zayıf yükümlülüklere sahipler, sivil toplumla ise hiçbirini paylaşmıyorlar. Gönüllü olarak paylaşacaklarına güvenilebileceğini düşünmüyoruz “.

Muhbirlerin korunması önemli bir sorun

Mektubu imzalayanlar aynı zamanda ihbarcıların akıbeti konusunda da uyarıda bulunuyor. Yapay zeka dünyasında yeterince korunmadıklarından korkuyorlar. Onlar için hükümetlerin çok daha fazla gözetim uygulaması gerekiyor. Bu, çalışanları şirketlerinden daha iyi koruyacak ve onları ön saflara koymaktan kaçınacaktır.

İşte bu noktada son zamanlarda ortaya çıkan bir açıklama devreye giriyor. Birçok çalışan “ Bu sorunları çözemeyebilecek şirketlerin kendileri dışında endişelerimizi dile getirmemizi engelleyen geniş gizlilik anlaşmaları “.

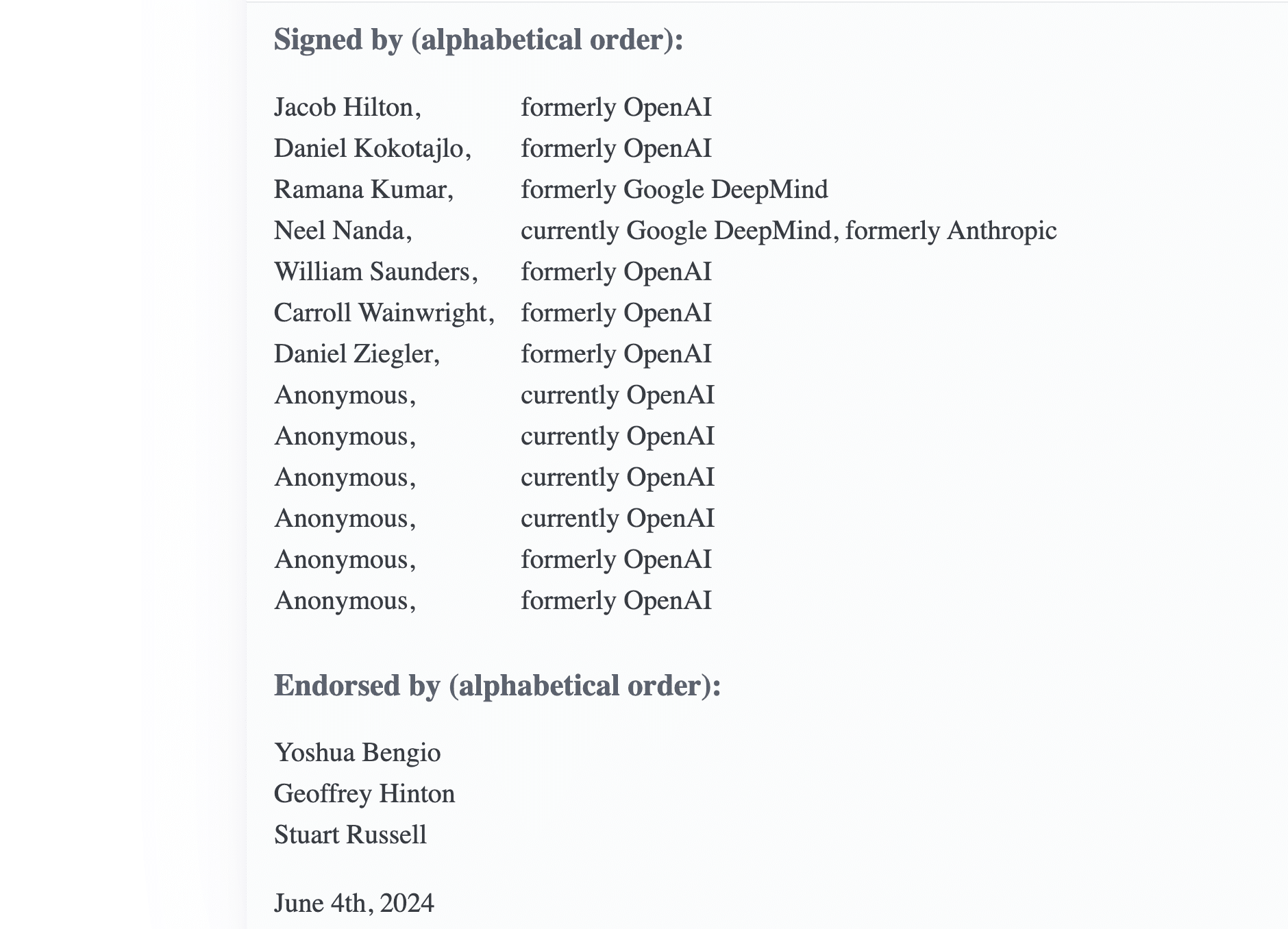

“Gelişmiş yapay zekaya ilişkin uyarı hakkı” açık mektubunu imzalayanların ekran görüntüsü.

Bazı ülkelerde ihbarcılara yönelik korumalar mevcuttur. Yapay zeka dünyası için yeterli değil” çünkü yasa dışı faaliyetlere odaklanıyorlar ve endişe duyduğumuz risklerin çoğu henüz düzenlenmemiş “.

Mektuba mantıksal olarak çeşitli talepler eşlik ediyor. Örneğin, çalışanlara endişelerini yönetim kuruluna ve düzenleyicilere ifade etme fırsatı vermek için isimsiz bir sürecin oluşturulması çağrısında bulunuyorlar.

Başka bir fikir ve en önemlisi: eğer iç raporlama süreçleri hiçbir sonuç vermiyorsa ihbarcılara karşı misilleme yapmayın.

İlgili tüm sektör, OpenAI özellikle hedeflendi

İmzacıların çoğu OpenAI’den geliyor veya OpenAI’de bulunuyor gibi görünse de bu herkes için geçerli değil. Bu nedenle bu mektup yapay zeka alanında çalışan tüm şirketlere yöneliktir. Yazarlar arasında daha önce Anthropic’ten olan ve şu anda Google DeepMind’da çalışan Neel Nanda da var.

Daha önce DeepMind’da çalışan Ramana Kumar’ı da unutmadan. Bu güzel panele üç tanınmış uzman ekleniyor: Geoffrey Hinton, Yoshua Bengio ve Stuart Russell. OpenAI hala tepki gösterdi ve şunları söyledi: CNBC : “ Bu teknolojinin önemi göz önüne alındığında, sıkı bir tartışmanın hayati önem taşıdığı konusunda hemfikiriz “.

ChatGPT’nin arkasındaki şirketin bu mektupta dile getirilen eleştirilerden özellikle endişe duyduğunu söylemek gerekir. Gerçekten de aşağılayıcı olmayan anlaşmalardan hoşlanırdı. Bunlar, işçinin işverenini aşağılamasını veya itibarını zedelemesini engelleyen hükümlerdir.

Tarihsel olarak, eski çalışanlarını herhangi bir bitiş tarihi olmayan bu tür bir sözleşmeyi imzalamak veya şirketteki hisselerini korumak arasında seçim yapmak zorunda bırakıyordu. Mayıs ayında, en hafif tabirle tartışmalı olan bu uygulamaya geri döndü.

İmzacıların riskler hakkındaki düşünceleri, Sam Altman’ın şirketinin uzun vadeli yapay zeka risklerinden sorumlu ekibi dağıtma kararını da yansıtıyor. Liderleri düzenli olarak kendilerini savunuyor ve gerekli tüm önlemleri aldıklarını iddia ediyor.

Ancak geçtiğimiz yıllarda güvenlik kültürü ve süreçleri parlak ürünlerin gerisinde kaldı.

— Jan Leike (@janleike) 17 Mayıs 2024

Yönetim kurulunun liderliğinde bir güvenlik komitesinin yanı sıra isimsiz bir telefon hattı kuruldu. Ancak startup’ın baş hizalama sorumlusu Jan Leike, OpenAI’de yapay zekanın etkisine ve güvenliğine yeterince öncelik verilmediğini söyleyerek Mayıs ayında ayrıldığını duyurdu.

“ Son yıllarda güvenlik kültürü ve süreçleri parlak ürünlerin gerisinde kaldı ” diyerek kınadı. Bu, yönetim kurulunun güvenliğe zarar verecek şekilde pazarlamaya çok hızlı geçmek istediği için onu eleştirdiği Sam Altman’ın görevden alındığı dönemi ifade ediyor.