Uzmanlar, iş verilerini konuşma arayüzü aracılığıyla aranabilir hale getirmek için büyük dil modellerinin (LLM’ler) özel örneklerini kullanan şirketlerin, platformları güçlendirmek için güvenlik kontrollerini düzgün bir şekilde uygulamamaları durumunda veri zehirlenmesi ve olası veri sızıntısı riskleriyle karşı karşıya kaldıklarını söylüyor.

Konuya ilişkin örnek: Bu hafta Synopsys, yapay zeka sağlayıcısı SamurAI tarafından oluşturulan EmbedAI bileşenini temel alan uygulamaları etkileyen siteler arası istek sahteciliği (CSRF) kusurunu açıkladı; Uygulama güvenliği firması, bunun saldırganların kullanıcıları zehirli verileri kendi dil modellerine yüklemeleri konusunda kandırmasına izin verebileceği konusunda uyardı. Güvenlik açığını bulan Synopsys güvenlik araştırmacısı Mohammed Alshehri, saldırının, açık kaynak bileşeninin güvenli bir çapraz kaynak politikası eksikliğinden ve oturum yönetimini uygulamadaki başarısızlığından yararlandığını ve bir saldırganın özel bir LLM örneğini veya sohbet robotunu bile etkilemesine izin verebileceğini söylüyor.

Risklerin, yazılım uygulamaları geliştiricilerinin karşılaştığı risklere benzer olduğunu ancak yapay zekanın farklı bir yönü olduğunu söylüyor.

“Mevcut bir yapay zeka uygulamasını benimseyen ürünler var [and open source components] ve yeni bir şey yaratmak için bunları bir araya getiriyoruz” diyor. “Burada vurgulamak istediğimiz şey, entegrasyondan sonra bile şirketlerin Web uygulamaları için sahip olduğumuz kontrollerin aynılarının kendi yapay zekalarına yönelik API’lerde de uygulandığından emin olmak için test etmeleri gerektiğidir. uygulamalar.”

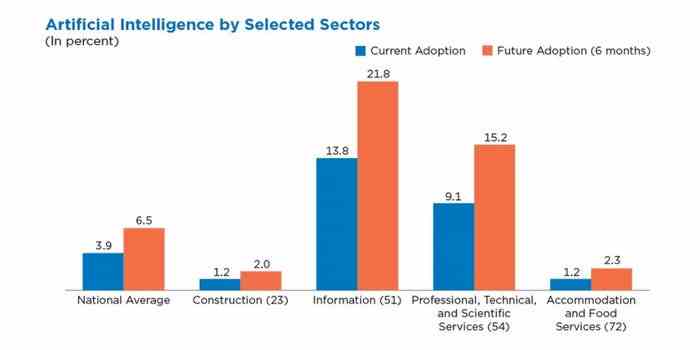

Araştırma, yapay zekayı iş süreçlerine entegre etme telaşının, özellikle yüksek lisans ve diğer üretken yapay zeka uygulamalarına büyük veri havuzlarına erişim sağlayan şirketler için risk teşkil ettiğinin altını çiziyor. Genel olarak ABD şirketlerinin yalnızca %4’ü yapay zekayı ticari operasyonlarının bir parçası olarak benimsedi ancak bazı sektörlerde daha yüksek benimseme oranları var; bilgi sektörü %14 ve profesyonel hizmetler sektörü %9’dur. ABD Nüfus Sayımı Bürosu tarafından Ekim 2023’te gerçekleştirilen bir anket.

Bilgi ve profesyonel hizmet sektörleri yapay zekanın en fazla benimsendiği sektörler oldu. Kaynak: ABD Nüfus Sayımı Bürosu

Yeni nesil yapay zeka ve makine öğreniminin (AI/ML) benimsenmesinin ortaya çıkardığı risklerin, daha küçük saldırı yüzeylerine sahip olma eğiliminde olan modellerden değil, yapay zeka uygulamaları ve arayüzlerini geliştirmeye yönelik yazılım bileşenleri ve araçlarından kaynaklandığını söylüyor Dan McInerney, yapay zeka uygulama güvenliği firması olan Koruma AI’nın baş yapay zeka tehdit araştırmacısı.

“Bir Yüksek Lisans’a gönderebileceğiniz ve onun şifreleri ve hassas bilgileri dağıtmasını sağlayabileceğiniz çok fazla büyülü büyü yok” diyor. “Ancak yüksek lisans eğitimlerini barındırmak için kullanılan sunucularda çok sayıda güvenlik açığı var. [LLM] aslında saldırıya uğrayacağınız yer burası değil; LLM’de kullandığınız tüm araçlardan saldırıya uğrayacaksınız.”

Yapay Zeka Bileşenlerine Karşı Pratik Saldırılar

Bu tür güvenlik açıklarından halihazırda aktif olarak yararlanılıyor. Mart ayında Oligo Security, daha önce keşfedilen bir güvenlik sorununu kullanarak popüler bir yapay zeka çerçevesi olan Ray’e karşı aktif saldırıların keşfedildiğini bildirdi. beş güvenlik açığından biri Bu, bağımsız araştırmacı Sierra Haex ile birlikte Koruma AI ve Bishop Fox’taki araştırma grupları tarafından keşfedilmişti. Ray’in arkasındaki şirket Anyscale, dört güvenlik açığı düzeltildi ancak beşincisinin yanlış yapılandırma sorunu olduğu değerlendirildi.

Ancak saldırganlar, bir Ray sunucusunu istemeden internete maruz bırakan ve sistemleri tehlikeye sokan yüzlerce dağıtım bulmayı başardılar. Oligo Security tarafından Mart ayında yayınlanan bir analize göre.

Şirket, “Bu kusur son yedi aydır aktif olarak istismar ediliyor ve eğitim, kripto para birimi, biyofarma ve daha fazlası gibi sektörleri etkiliyor” dedi. “Ray kullanan tüm kuruluşlara, ifşa edilmediklerinden emin olmak için ortamlarını gözden geçirmeleri ve herhangi bir şüpheli etkinliği analiz etmeleri tavsiye edilir.”

Kendi Mart tavsiyesinde, Anyscale saldırıları kabul etti ve güvenli olmayan şekilde yapılandırılmış sistemleri tespit etmek için bir araç yayınladı.

Özel, Güvenli Demek Değildir

Ray çerçevesindeki güvenlik açığı halka açık sunucuları saldırılara açık hale getirirken, yapay zeka destekli özel LLM’ler ve sohbet robotları bile istismarlarla karşı karşıya kalabilir. Mayıs ayında yapay zeka güvenlik firması Protect AI, kendi geliştirdiği güvenlik açıklarının en son dilimini yayınladı. hata ödülü topluluğu, Huntrkapsayan Kritik uzaktan saldırılardan düşük şiddetli yarış koşullarına kadar 32 sorun. Bazı saldırılar API’ye erişim gerektirebilir, ancak diğerleri kötü amaçlı belgeler ve diğer vektörler aracılığıyla gerçekleştirilebilir.

Synopsys araştırmacısı Alshehri, kendi araştırmasında, saldırgana bir sulama deliği saldırısı yoluyla bir LLM’yi zehirleme yeteneği veren siteler arası istek sahteciliği (CSRF) sorununu keşfetti.

“Bu güvenlik açığından yararlanılması, modelin anında işleyişini etkileyebilir ve güvenilirliği ve ona dayanan sistemlerin güvenliği üzerinde uzun süreli etkiler yaratabilir.” Özet, danışma belgesinde belirtildi. “Bu, yanlış bilgilerin yayılması, önyargıların ortaya çıkması, performansın düşmesi ve hizmet reddi saldırıları potansiyeli dahil olmak üzere çeşitli şekillerde ortaya çıkabilir.”

Bir veri yönetimi firması olan BigID’nin CISO’su Tyler Young, birçok şirketin, bir sohbet robotu hizmetinin özel bir örneğini kullanarak veya dahili olarak bir yüksek lisans eğitimine ev sahipliği yaparak, istismar riskini en aza indirdiklerine inandığını söylüyor.

“Çoğu işletme, bu LLM algoritmalarının yanı sıra özel LLM sohbet robotlarından yararlanmaya yöneliyor, çünkü bu, tıpkı kendi bulutunuzda bir şeyi barındırmak gibi, verilere kimin erişebileceği üzerinde kontrol sahibi olduğunuzda bu rahatlığı sunuyor” diyor. “Fakat riskler de var… çünkü içsel bir güvene sahip olduğunuz anda oraya daha fazla veri pompalamaya başlarsınız ve aşırı maruz kalırsınız. Bu hesaplardan birinin ele geçirilmesi için gereken tek şey.”

Yeni Yazılım, Aynı Eski Güvenlik Açıkları

Synopsys’ten Alshehri, platformların genellikle küçük ekiplere ve sınırlı gözetime sahip açık kaynaklı bileşenlere dayalı olması nedeniyle şirketlerin mevcut yapay zeka sistem ve hizmetlerinin yalnızca sınırlı güvenlik tasarımı ve incelemesine sahip olduğunu varsayması gerektiğini söylüyor. Aslında şubat ayında Hugging Face AI açık kaynaklı model deposu kötü amaçlı kod yürütme modelleriyle dolu olduğu tespit edildi.

“Düzenli testleri ve kara kutu ve beyaz kutu testleriyle kod incelemelerini yaptığımız gibi, iş bu yeni teknolojileri benimsemeye geldiğinde bunu yapmamız gerekiyor” diyor.

Dahili verilere dayalı yapay zeka sistemlerini uygulayan şirketlerin, verileri ve bunun sonucunda ortaya çıkan LLM örneklerini bölümlere ayırması gerekir; böylece yalnızca çalışanların, erişim sahibi oldukları veriler üzerine oluşturulan LLM hizmetlerine erişmesine izin verilir. Belirli bir ayrıcalık düzeyine sahip her kullanıcı koleksiyonu, erişilebilir verileri konusunda eğitilmiş ayrı bir Yüksek Lisans gerektirecektir.

“LLM’nin dev bir veri yığınına erişmesine izin verip ‘Tamam, herkes buna erişebilir’ diyemezsiniz, çünkü bu, içindeki tüm verilerin bulunduğu bir veritabanına herkese erişim hakkı vermekle eşdeğerdir, değil mi?” diyor AI’dan McInerney’i Koruyun. “Yani verileri temizlemelisin.”

Son olarak, şirketlerin yapay zeka araçlarını geliştirmek için kullandıkları bileşenleri en aza indirmeleri ve ardından bu yazılım varlıklarını düzenli olarak güncellemeleri ve istismarı daha zor hale getirmek için kontroller uygulamaları gerektiğini söylüyor.