Yapay zeka kadar hızlı hareket eden bir sektöre ayak uydurmak zorlu bir iştir. Bir yapay zeka bunu sizin için yapana kadar, kendi başımıza ele almadığımız dikkate değer araştırma ve deneylerin yanı sıra, makine öğrenimi dünyasındaki son hikayelerin kullanışlı bir özetini burada bulabilirsiniz.

Bu arada TechCrunch yakında bir AI bülteni yayınlamayı planlıyor. Bizi izlemeye devam edin. Bu arada, daha önce ayda iki kez (veya daha fazla) olan yarı düzenli AI sütunumuzun temposunu haftalık hale getiriyoruz; bu nedenle daha fazla basım için tetikte olun.

Bu hafta AI’da OpenAI, bir ürün lansmanıyla ve aynı zamanda bazı saray entrikalarıyla (Google’ın tüm çabalarına rağmen) bir kez daha haber döngüsüne hakim oldu. Şirket, şimdiye kadarki en yetenekli üretken modeli olan GPT-4o’yu tanıttı ve birkaç gün sonra, “süper zeki” yapay zeka sistemlerinin kötüye gitmesini önlemek için kontroller geliştirme sorunu üzerinde çalışan bir ekibi etkili bir şekilde dağıttı.

Tahmin edilebileceği gibi ekibin dağılması pek çok manşete yol açtı. Bizimki de dahil olmak üzere raporlar, OpenAI’nin, yukarıda adı geçen GPT-4o gibi yeni ürünlerin piyasaya sürülmesi lehine ekibin güvenlik araştırmasına öncelik vermediğini ve sonuçta ekibin iki ortak lideri Jan Leike ve OpenAI kurucu ortağı Ilya Sutskever’in istifasına yol açtığını öne sürüyor.

Süper akıllı yapay zeka bu noktada gerçek olmaktan çok teoriktir; Teknoloji endüstrisinin, bir insanın yapabileceği herhangi bir görevi yerine getirebilecek yapay zekayı yaratmak için gerekli atılımları ne zaman başaracağı ya da elde edip edemeyeceği belli değil. Ancak bu haftaki haberler bir şeyi doğruluyor gibi görünüyor: OpenAI liderliğinin, özellikle de CEO Sam Altman’ın, koruma önlemleri yerine ürünlere öncelik vermeyi giderek daha fazla tercih ettiği.

Altman’ın bildirdiğine göre “çileden çıkmış” Sutskever, geçen Kasım ayında OpenAI’nin ilk geliştirme konferansında yapay zeka destekli özelliklerin lansmanını hızlandırdı. Ve o olduğu söylendi Georgetown Güvenlik ve Gelişen Teknolojiler Merkezi yöneticisi ve OpenAI yönetim kurulunun eski bir üyesi olan Helen Toner’ı, ortak yazarı olduğu ve OpenAI’nin güvenliğe yaklaşımını eleştirel bir bakış açısıyla ortaya koyan bir makale nedeniyle eleştirdi – hatta onu itmeye çalıştığı noktaya kadar pano.

Geçtiğimiz yıl boyunca OpenAI, chatbot mağazasının spam ile dolmasına izin verdi ve (iddiaya göre) YouTube’dan veri kazındı platformun hizmet şartlarına karşı çıkıyor ve yapay zekanın porno ve vahşet tasvirleri oluşturmasına izin verme isteğini dile getiriyor. Güvenlik kesinlikle şirkette arka planda kalmış gibi görünüyor ve giderek artan sayıda OpenAI güvenlik araştırmacısı, çalışmalarının başka yerlerde daha iyi destekleneceği sonucuna varıyor.

İşte son birkaç güne ait diğer AI hikayeleri:

- OpenAI + Reddit: Diğer OpenAI haberlerinde şirket, sosyal sitenin verilerini yapay zeka modeli eğitimi için kullanmak üzere Reddit ile anlaşmaya vardı. Wall Street anlaşmayı memnuniyetle karşıladı ancak Reddit kullanıcıları pek memnun olmayabilir.

- Google’ın yapay zekası: Google bu hafta yıllık I/O geliştirici konferansına ev sahipliği yaptı ve bu konferansta ilk kez sahneye çıktı. bir ton AI ürünleri. Video oluşturma Veo’dan Google Arama’daki yapay zeka tarafından düzenlenen sonuçlara ve Google’ın Gemini sohbet robotu uygulamalarına yapılan yükseltmelere kadar bunları burada topladık.

- Antropik Krieger’i işe alıyor: Instagram’ın kurucu ortaklarından biri ve son zamanlarda kişiselleştirilmiş haber uygulaması Artifact’in (TechCrunch kurumsal ana şirketi Yahoo’nun kısa süre önce satın aldığı) kurucu ortağı Mike Krieger, şirketin ilk baş ürün sorumlusu olarak Anthropic’e katılıyor. Şirketin hem tüketici hem de kurumsal çabalarını denetleyecek.

- Çocuklar için yapay zeka: Anthropic geçen hafta geliştiricilerin belirli kurallara uydukları sürece kendi yapay zeka modellerini temel alan çocuk odaklı uygulamalar ve araçlar oluşturmalarına izin vereceğini duyurmuştu. Özellikle Google gibi rakipler, yapay zekalarının genç yaşları hedef alan uygulamalara yerleştirilmesine izin vermiyor.

- AI film festivali: Yapay zeka girişimi Runway, bu ayın başlarında ikinci yapay zeka film festivalini düzenledi. Götürmek? Sergideki en güçlü anlardan bazıları yapay zekadan değil, daha fazla insan unsurundan geldi.

Daha fazla makine öğrenimi

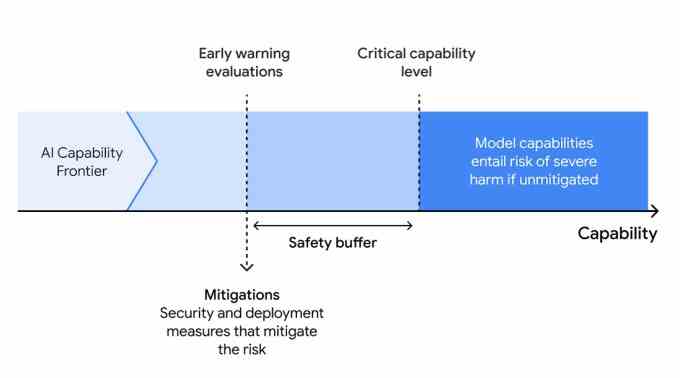

Bu hafta OpenAI’nin ayrılmasıyla birlikte yapay zeka güvenliği elbette ilk sırada yer alıyor, ancak Google Deepmind yoluna devam ediyor yeni bir “Sınır Güvenliği Çerçevesi” ile. Temel olarak bu, organizasyonun kontrolden çıkan yetenekleri tanımlama ve umarım önleme stratejisidir; AGI olması gerekmez, delirmiş bir kötü amaçlı yazılım oluşturucu veya benzeri olabilir.

Çerçevenin üç adımı vardır: 1. Bir modelin gelişim yollarını simüle ederek, potansiyel olarak zararlı yetenekleri belirleyin. 2. Bilinen “kritik yetenek seviyelerine” ulaştıklarını tespit etmek için modelleri düzenli olarak değerlendirin. 3. Dışarı sızmayı (başka biri tarafından veya kendisi tarafından) veya sorunlu konuşlandırmayı önlemek için bir azaltma planı uygulayın. Burada daha fazla ayrıntı var. Kulağa bir dizi bariz eylem gibi gelebilir, ancak bunları resmileştirmek önemlidir, yoksa herkes bir nevi kaçmaya çalışır. Kötü yapay zekayı bu şekilde elde edersiniz.

Oldukça farklı bir risk, ölü bir kişinin yüzeysel bir simulakrını sağlamak için ölü bir kişinin verileri üzerinde eğitilen sohbet robotlarının çoğalmasından haklı olarak endişe duyan Cambridge araştırmacıları tarafından tespit edildi. Siz de (benim gibi) bu kavramın tamamını iğrenç bulabilirsiniz, ancak eğer dikkatli olursak, yas yönetimi ve diğer senaryolarda kullanılabilir. Sorun şu ki dikkatli davranmıyoruz.

“Yapay zekanın bu alanı etik bir mayın tarlasıdır” baş araştırmacı Katarzyna Nowaczyk-Basińska dedi. “Artık dijital ölümsüzlüğün sosyal ve psikolojik risklerini nasıl azaltacağımızı düşünmeye başlamalıyız çünkü teknoloji zaten burada.” Ekip çok sayıda dolandırıcılığı, potansiyel kötü ve iyi sonuçları tespit ediyor ve kavramı genel olarak (sahte hizmetler dahil) tartışıyor. Felsefe ve Teknoloji’de yayınlanan makale. Black Mirror bir kez daha geleceği öngörüyor!

Yapay zekanın daha az ürkütücü uygulamalarında, MIT’deki fizikçiler Fiziksel bir sistemin aşamasını veya durumunu tahmin etmek için (onlar için) yararlı bir araç arıyorlar; normalde daha karmaşık sistemlerle zahmetli hale gelebilecek istatistiksel bir görev. Ancak bir makine öğrenimi modelini doğru veriler üzerinde eğitip onu bir sistemin bilinen bazı maddi özellikleriyle temellendirdiğinizde, bunu yapmanın çok daha etkili bir yoluna sahip olursunuz. ML’nin ileri bilimde bile nasıl uygun alanlar bulduğunun bir başka örneği.

CU Boulder’da yapay zekanın afet yönetiminde nasıl kullanılabileceği hakkında konuşuyorlar. Teknoloji, kaynaklara nerede ihtiyaç duyulacağının hızlı bir şekilde tahmin edilmesi, hasarın haritalanması, hatta müdahale ekiplerinin eğitilmesine yardımcı olmak için yararlı olabilir, ancak insanlar (anlaşılır şekilde) bunu ölüm kalım senaryolarında uygulamaktan çekiniyorlar.

Profesör Amir Behzadan “İnsan merkezli yapay zeka, ekip üyeleri, hayatta kalanlar ve paydaşlar arasında işbirliğini, anlayışı ve kapsayıcılığı teşvik ederek daha etkili afet müdahale ve kurtarma uygulamalarına yol açıyor” diyerek topu bu konuda ilerletmeye çalışıyor. Hala atölye aşamasındalar, ancak örneğin bir kasırgadan sonra yardım dağıtımını otomatikleştirmeye çalışmadan önce bu konu üzerinde derinlemesine düşünmek önemlidir.

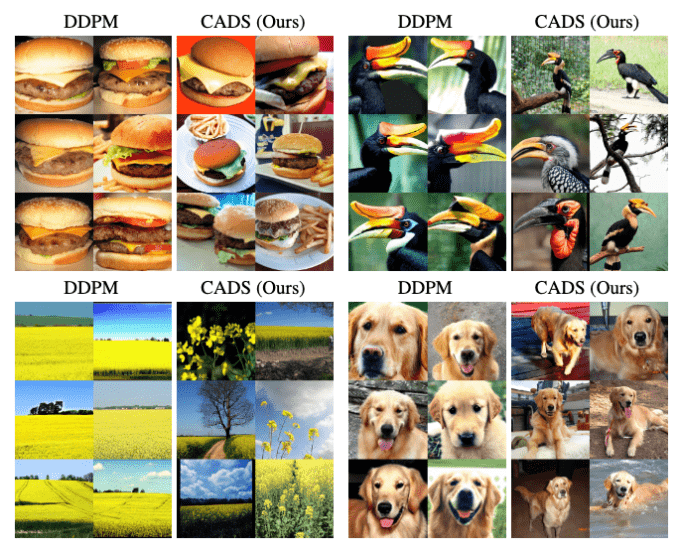

Son olarak Disney Research’ten bazı ilginç çalışmalar, bazı istemler için tekrar tekrar benzer sonuçlar üretebilen difüzyon görüntü oluşturma modellerinin çıktısının nasıl çeşitlendirileceğine bakıyordu. Çözümleri mi? “Örnekleme stratejimiz, çeşitliliği ve koşul hizalamasını dengelemek için çıkarım sırasında programlanmış, monoton olarak azalan Gauss gürültüsünü koşullandırma vektörüne ekleyerek koşullandırma sinyalini tavlıyor.” Ben şahsen bunu daha iyi ifade edemezdim.

Sonuç, görüntü çıktılarında açılar, ayarlar ve genel görünüm açısından çok daha geniş bir çeşitliliktir. Bazen bunu istersin, bazen istemezsin ama bu seçeneğe sahip olmak güzel.