Google ve Samsung’un öncülük ettiği yapay zeka hızla mobil deneyimimizin bir parçası haline geliyor. Ancak Apple, ekosistemindeki yapay zeka konusunda da önemli ilerlemeler kaydediyor. Son zamanlarda Cupertino teknoloji devi, hem metni hem de görüntüleri işleyebilen çok modlu bir büyük dil modeli (MLLM) olan MM1 olarak bilinen bir projeyi tanıttı. Şimdi, mobil ekran arayüzlerinin nüanslarını kavramak için tasarlanan yeni bir MLLM’yi ortaya çıkaran yeni bir çalışma yayınlandı. Kağıt, Cornell Üniversitesi tarafından yayınlanan ve öne çıkanlar Apple’ın İçeriği“Ferret-UI: Multimodal LLM’lerle Temellendirilmiş Mobil Kullanıcı Arayüzü Anlayışı”nı tanıtıyor.

Ferret-UI, yönlendirme, topraklama ve akıl yürütme yetenekleriyle donatılmış, mobil UI ekranlarının daha iyi anlaşılması için tasarlanmış yeni bir MLLM’dir.

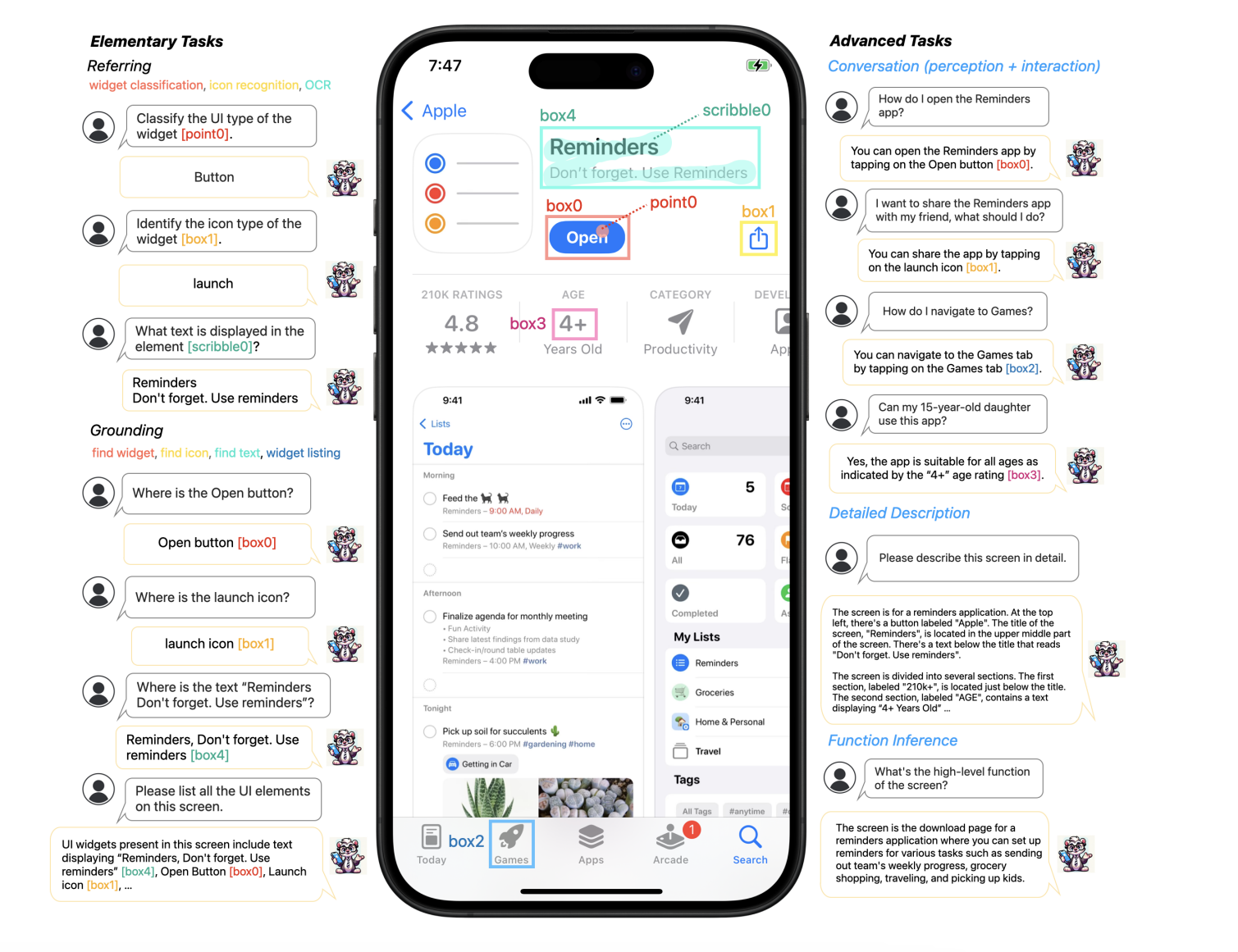

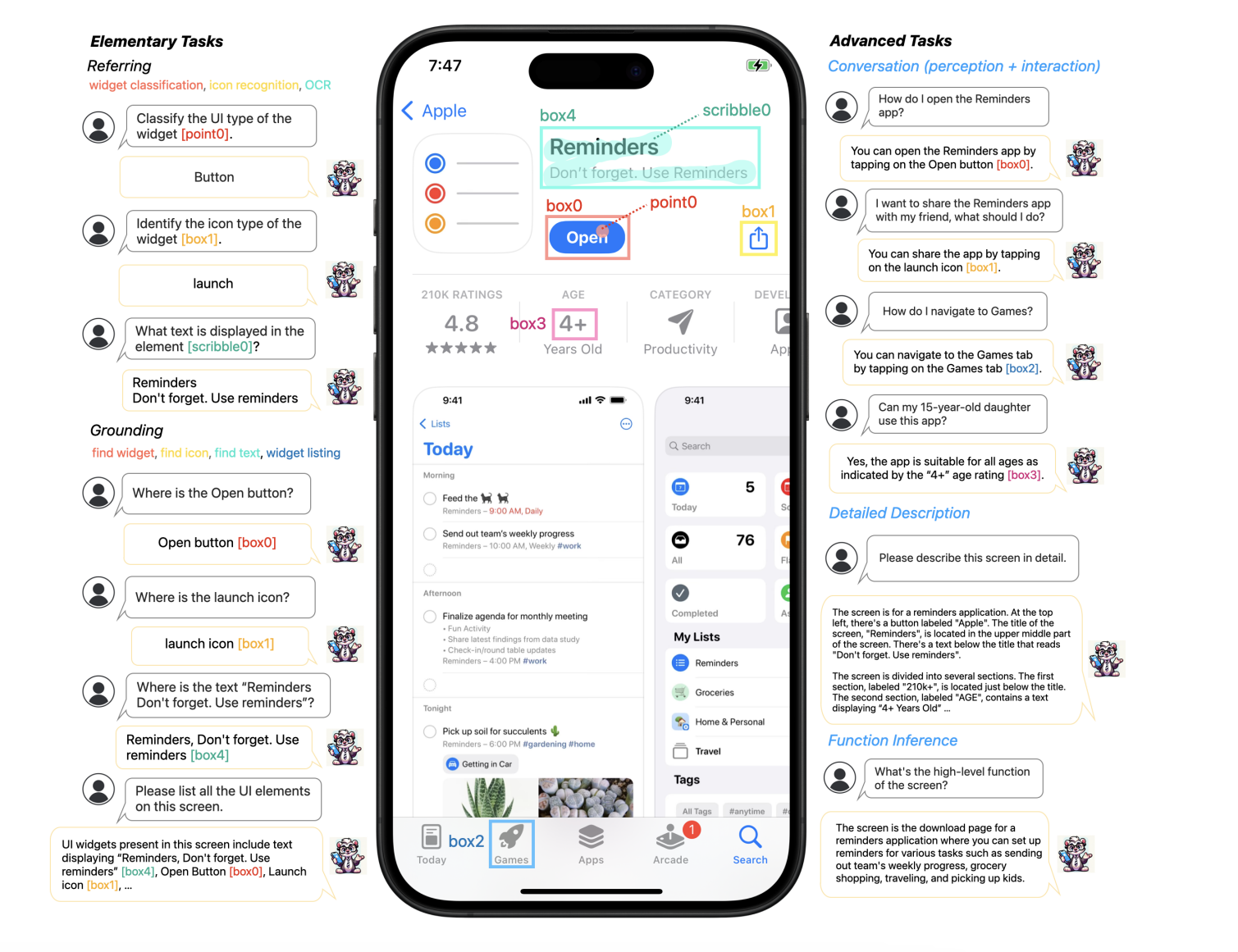

Ferret-UI çalışırken, bir iPhone’un ekranını analiz ediyor (Image Credit – Apple)

Bu sorunu çözmek için Ferret-UI, görüntüleri istenen herhangi bir çözünürlüğe yükselterek ekran öğelerinin okunabilirliğini artıran bir büyütme özelliği sunar. Bu yetenek, yapay zekanın mobil arayüzlerle etkileşiminde ezber bozan bir özelliktir.

Makaleye göre Ferret-UI, mobil ekranlardaki widget’ları, simgeleri ve metinleri tanıma ve kategorilere ayırma konusunda öne çıkıyor. İşaretleme, kutulama veya karalama gibi çeşitli giriş yöntemlerini destekler. Model, bu görevleri yerine getirerek görsel ve mekansal verileri iyi bir şekilde kavrar ve bu da farklı kullanıcı arayüzü öğelerini hassas bir şekilde ayırmasına yardımcı olur.

Ferret-UI’yi diğerlerinden ayıran şey, doğrudan ham ekran piksel verileriyle çalışabilmesi ve harici algılama araçlarına veya ekran görüntüleme dosyalarına olan ihtiyacı ortadan kaldırabilmesidir. Bu yaklaşım, tek ekran etkileşimlerini önemli ölçüde geliştirir ve cihaz erişilebilirliğini iyileştirmek gibi yeni uygulamalara yönelik olasılıkların önünü açar.

Araştırma makalesi, Ferret-UI’nin tanımlama, konum ve muhakeme ile ilgili görevleri yerine getirmedeki yeterliliğini öne çıkarıyor. Bu atılım, Ferret-UI gibi gelişmiş yapay zeka modellerinin, daha sezgisel ve verimli kullanıcı deneyimleri sunarak kullanıcı arayüzü etkileşiminde devrim yaratabileceğini gösteriyor.

Ferret-UI Siri’ye entegre olursa ne olur?

Ferret-UI’nin Siri’ye veya diğer Apple hizmetlerine entegre edilip edilmeyeceği doğrulanmasa da potansiyel faydaları ilgi çekici. Ferret-UI, mobil kullanıcı arayüzlerinin anlaşılmasını çok modlu bir yaklaşımla geliştirerek, Siri gibi sesli asistanları çeşitli şekillerde önemli ölçüde geliştirebilir.

Bu, Siri’nin, kullanıcıların uygulamalar içinde ne yapmak istediğini anlamada daha iyi hale geleceği, hatta belki daha karmaşık görevlerin üstesinden gelebileceği anlamına gelebilir. Ayrıca, ekrandakileri dikkate alarak Siri’nin sorguların bağlamını daha iyi kavramasına yardımcı olabilir. Sonuçta bu, Siri’nin kullanımını daha sorunsuz bir deneyim haline getirebilir, uygulamalar arasında gezinmek veya görsel olarak neler olduğunu anlamak gibi eylemleri gerçekleştirmesine olanak tanıyabilir.