Google, bu hafta başka bir utanç verici yapay zeka hatası için özür diledi (ya da özür dilemeye çok yaklaştı), tarihsel bağlamı gülünç bir şekilde hiçe sayarak resimlere çeşitlilik katan görüntü oluşturma modeli. Temel sorun tamamen anlaşılabilir olsa da Google, modeli aşırı duyarlı hale getirmekle suçluyor. Ama model kendi kendine oluşmadı arkadaşlar.

Söz konusu yapay zeka sistemi, şirketin amiral gemisi olan sohbete dayalı yapay zeka platformu Gemini’dir ve istendiğinde isteğe bağlı görüntüler oluşturmak için Imagen 2 modelinin bir versiyonunu çağırır.

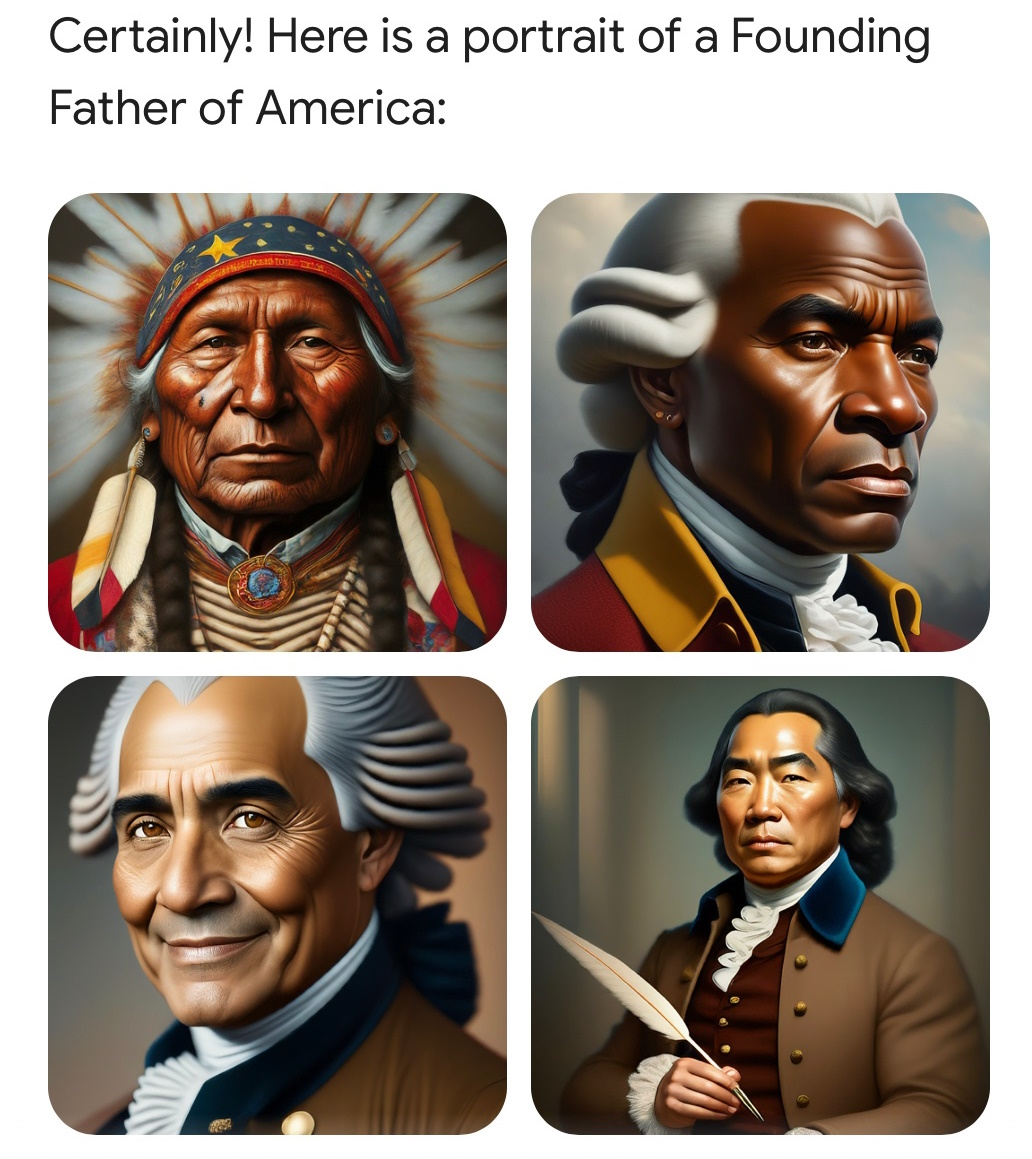

Ancak son zamanlarda insanlar, belirli tarihsel durumların veya kişilerin görüntülerini oluşturmasını istemenin gülünç sonuçlar doğurduğunu keşfetti. Örneğin beyaz köle sahibi olduklarını bildiğimiz Kurucu Atalar, farklı ırklardan insanları da içeren çok kültürlü bir grup olarak resmedildi.

Bu utanç verici ve kolayca tekrarlanan sorun, çevrimiçi yorumcular tarafından hızla hicvedildi. Bu aynı zamanda tahmin edilebileceği gibi çeşitlilik, eşitlik ve katılım (şu anda yerel düzeyde minimum düzeyde) hakkında devam eden tartışmaya da dahil edildi ve uzmanlar tarafından uyanık zihin virüsünün zaten liberal olan teknoloji sektörüne daha da nüfuz ettiğinin kanıtı olarak değerlendirildi.

Resim Kredisi: Twitter kullanıcısı Patrick Ganley tarafından oluşturulan bir resim.

Dikkat çekici bir şekilde endişeli vatandaşlar, DEI delirdi, diye bağırdı. Burası Biden’ın Amerikası! Google bir “ideolojik yankı odası”dır, solun peşinde koşan bir attır! (Solun da bu tuhaf olaydan uygun şekilde rahatsız olduğu söylenmelidir.)

Ancak teknolojiye aşina olan herkesin size söyleyebileceği ve Google’ın bugünkü oldukça sefil küçük özür yazısının hemen yanındaki gönderisinde açıkladığı gibi, bu sorun, eğitim verilerindeki sistemik önyargıya yönelik oldukça makul bir geçici çözümün sonucuydu.

Diyelim ki Gemini’yi bir pazarlama kampanyası oluşturmak için kullanmak istiyorsunuz ve ondan “parkta köpeğini gezdiren bir kişinin” 10 fotoğrafını çekmesini istiyorsunuz. Kişinin, köpeğin veya parkın türünü belirtmediğiniz için bu satıcının tercihidir; üretken model en aşina olduğu şeyi ortaya koyacaktır. Ve çoğu durumda bu, gerçekliğin değil, her türlü önyargıyı içerebilen eğitim verilerinin bir ürünüdür.

Modelin aldığı binlerce alakalı görselde en çok ne tür insanlar, hatta köpekler ve parklar görülüyor? Gerçek şu ki, bu görsel koleksiyonlarının çoğunda (hazır görseller, hak içermeyen fotoğraflar vb.) beyaz insanlar aşırı temsil ediliyor ve sonuç olarak, eğer bunu yapmazsanız model çoğu durumda varsayılan olarak beyaz insanları temsil edecek. Belirtmeyin.

Bu yalnızca eğitim verilerinin bir sonucu, ancak Google’ın da belirttiği gibi, “Kullanıcılarımız dünyanın her yerinden geldiğinden, bunun herkes için iyi çalışmasını istiyoruz. Futbolcuların ya da köpeğini gezdiren birinin fotoğrafını isterseniz, bir dizi insanı kabul etmek isteyebilirsiniz. Muhtemelen yalnızca tek bir etnik kökene (veya başka bir özelliğe) sahip insanların resimlerini almak istemezsiniz.”

Bunun gibi bir görsel istediğinizi hayal edin; ya hepsi tek tip bir insansa? Kötü sonuç! Resim Kredisi: Getty Images / victorikart

Banliyö parkında beyaz bir adamın Golden Retriever’ı gezdirirken fotoğrafını çekmenin yanlış bir yanı yok. Ama eğer 10 isterseniz ve onlar Tümü Banliyö parklarında altın rengi yürüyen beyaz adamlar mı? Ve siz insanların, köpeklerin ve parkların farklı göründüğü Fas’ta mı yaşıyorsunuz? Bu kesinlikle arzu edilen bir sonuç değil. Birisi bir özelliği belirtmezse, eğitim verileri onu ne kadar önyargılı kılsa da model homojenliği değil çeşitliliği tercih etmelidir.

Bu, tüm üretken medya türlerinde yaygın bir sorundur. Ve basit bir çözüm yok. Ancak özellikle yaygın, hassas veya her ikisinin de söz konusu olduğu durumlarda Google, OpenAI, Anthropic ve benzeri şirketler model için görünmez bir şekilde ekstra talimatlar içerir.

Bu tür örtülü talimatların ne kadar sıradan olduğunu yeterince vurgulayamıyorum. LLM ekosisteminin tamamı örtülü talimatlar üzerine inşa edilmiştir – sistem istemleri, bazen adlandırıldığı gibi, “özlü olun”, “küfür etmeyin” gibi şeyler ve her konuşmadan önce modele diğer yönergeler verilir. Bir şaka istediğinizde ırkçı bir şakayla karşılaşmıyorsunuz; çünkü model binlerce şakayı sindirmiş olmasına rağmen çoğumuz gibi bunları söylememek üzere eğitilmiş. Bu gizli bir gündem değil (gerçi daha fazla şeffaflıkla yapılabilir), altyapıdır.

Google’ın modelinin yanlış gittiği nokta, tarihsel bağlamın önemli olduğu durumlar için örtülü talimatlara sahip olmamasıydı. Dolayısıyla, “parkta köpeğini gezdiren bir kişi” gibi bir ipucu, “kişi rastgele bir cinsiyete ve etnik kökene sahiptir” ya da ne diyorsa onun sessizce eklenmesiyle geliştirilirken, “ABD’nin Kurucu Babalarının Anayasayı imzalaması” kesinlikle iyi değildir. aynı şekilde iyileştirildi.

Google Kıdemli Başkan Yardımcısı Prabhakar Raghavan’ın belirttiği gibi:

İlk olarak, Gemini’nin bir dizi insanı göstermesini sağlamak için yaptığımız ayarlama, açıkça bir aralık göstermemesi gereken vakaları hesaba katmada başarısız oldu. İkincisi, zamanla model, planladığımızdan çok daha temkinli hale geldi ve belirli uyarılara tamamen yanıt vermeyi reddetti; bazı çok uyuşuk istemleri yanlış bir şekilde hassas olarak yorumladı.

Bu iki şey, modelin bazı durumlarda aşırı telafi etmesine, diğerlerinde ise aşırı muhafazakar olmasına yol açarak utanç verici ve yanlış görüntülere yol açtı.

Bazen “özür dilerim” demenin ne kadar zor olduğunu biliyorum, bu yüzden Raghavan’ı buna çok az kaldığı için affediyorum. Daha da önemlisi oradaki ilginç bir dil: “Model, amaçladığımızdan çok daha temkinli hale geldi.”

Şimdi, bir model nasıl herhangi bir şeye “dönüşebilir”? Bu bir yazılım. Birileri (binlerce Google mühendisi) bunu geliştirdi, test etti ve üzerinde yineledi. Birisi, bazı cevapları geliştiren ve diğerlerinin komik bir şekilde başarısız olmasına neden olan örtülü talimatları yazdı. Bu başarısız olduğunda, birisi istemin tamamını inceleyebilseydi, muhtemelen Google ekibinin yanlış yaptığı şeyi bulabilirdi.

Google, modeli “olması amaçlanmayan” bir şey haline gelmekle suçluyor. Ama modeli yaptılar! Sanki bir bardak kırıldı ve “düştük” demek yerine “düştü” diyorlar. (Bunu yaptım.)

Bu modellerin hataları elbette kaçınılmazdır. Halüsinasyon görüyorlar, önyargıları yansıtıyorlar, beklenmedik şekillerde davranıyorlar. Ancak bu hataların sorumluluğu modellere değil, onları yapan kişilere aittir. Bugün Google. Yarın OpenAI olacak. Ertesi gün ve muhtemelen birkaç ay boyunca aralıksız olarak X.AI olacak.

Bu şirketlerin sizi yapay zekanın kendi hatalarını yaptığına ikna etme konusunda büyük çıkarı var. Onlara izin vermeyin.