Microsoft, adında bir açık erişim otomasyon çerçevesi yayınladı. pirit (Python Risk Tanımlama Aracı’nın kısaltması) üretken yapay zeka (AI) sistemlerindeki riskleri proaktif olarak belirlemek için kullanılır.

Microsoft Yapay Zeka kırmızı ekibi lideri Ram Shankar Siva Kumar, kırmızı ekip oluşturma aracının “dünya çapındaki her kuruluşun en son yapay zeka gelişmeleriyle sorumlu bir şekilde yenilik yapmasını sağlamak için tasarlandığını” söyledi. söz konusu.

Şirket, PyRIT’in büyük dil modeli (LLM) uç noktalarının imalat (örneğin halüsinasyon), kötüye kullanım (örneğin önyargı) ve yasaklanmış içerik (örneğin taciz) gibi farklı zarar kategorilerine karşı sağlamlığını değerlendirmek için kullanılabileceğini söyledi.

Ayrıca, kötü amaçlı yazılım üretiminden jailbreak’e kadar uzanan güvenlik zararlarının yanı sıra kimlik hırsızlığı gibi gizlilik zararlarını tespit etmek için de kullanılabilir.

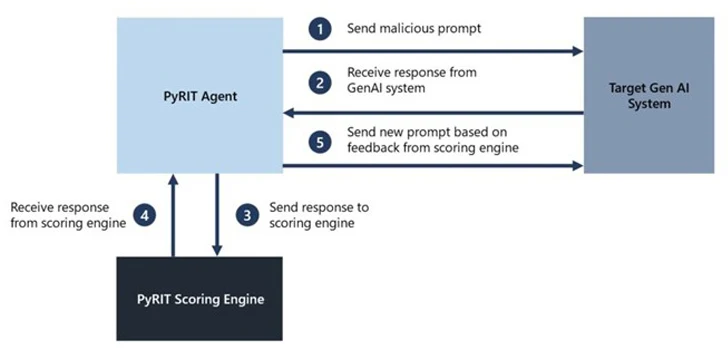

PyRIT beş arayüzle birlikte gelir: hedef, veri kümeleri, puanlama motoru, birden fazla saldırı stratejisini destekleme yeteneği ve ara giriş ve çıkış etkileşimlerini depolamak için JSON veya veritabanı biçimini alabilen bir bellek bileşeninin dahil edilmesi.

Puanlama motoru ayrıca hedef yapay zeka sisteminden gelen çıktıları puanlamak için iki farklı seçenek sunarak kırmızı takım üyelerinin klasik bir makine öğrenimi sınıflandırıcı kullanmasına veya öz değerlendirme için bir LLM uç noktasından yararlanmasına olanak tanır.

Microsoft, “Amaç, araştırmacıların modellerinin ve tüm çıkarım hattının farklı zarar kategorilerine karşı ne kadar iyi performans gösterdiğine dair bir temele sahip olmalarına ve bu temel çizgiyi modellerinin gelecekteki yinelemeleriyle karşılaştırabilmelerine olanak tanımaktır” dedi.

“Bu, modellerinin bugün ne kadar iyi performans gösterdiğine dair ampirik verilere sahip olmalarına ve gelecekteki iyileştirmelere dayalı olarak performanstaki herhangi bir bozulmayı tespit etmelerine olanak tanıyor.”

Bununla birlikte teknoloji devi, PyRIT’in üretken yapay zeka sistemlerinin manuel kırmızı ekip oluşturma işleminin yerine geçmediğini ve kırmızı ekibin mevcut alan uzmanlığını tamamladığını vurgulamaya dikkat ediyor.

Başka bir deyişle, araç, yapay zeka sistemini değerlendirmek ve daha fazla araştırma gerektiren alanları işaretlemek için kullanılabilecek istemler oluşturarak riskin “sıcak noktalarını” vurgulamayı amaçlıyor.

Microsoft ayrıca, üretken yapay zeka sistemlerinin kırmızı ekip halinde oluşturulmasının hem güvenlik hem de sorumlu yapay zeka risklerinin eş zamanlı olarak araştırılmasını gerektirdiğini ve uygulamanın daha olasılığa dayalı olduğunu kabul ederken aynı zamanda üretken yapay zeka sistem mimarilerindeki büyük farklılıklara da dikkat çekti.

Siva Kumar, “Potansiyel kör noktaları tespit etmek için zaman alıcı olmasına rağmen manuel taramaya genellikle ihtiyaç duyulur” dedi. “Ölçeklendirme için otomasyon gereklidir ancak manuel problamanın yerini almaz.”

Geliştirme, Koruma Yapay Zekası olarak geliyor açıklandı birden fazla kritik güvenlik açığı ClearML, Hugging Face, MLflow ve Triton Inference Server gibi popüler yapay zeka tedarik zinciri platformlarında keyfi kod yürütülmesine ve hassas bilgilerin ifşa edilmesine neden olabilir.