ABD Ulusal Standartlar ve Teknoloji Enstitüsü (NIST), son yıllarda yapay zeka (AI) sistemlerinin artan dağıtımının bir sonucu olarak ortaya çıkan gizlilik ve güvenlik sorunlarına dikkat çekiyor.

“Bu güvenlik ve gizlilik zorlukları arasında, eğitim verilerinin düşmanca manipülasyonu, yapay zeka sisteminin performansını olumsuz yönde etkileyecek şekilde model güvenlik açıklarının düşmanca kullanılması ve hatta kötü niyetli manipülasyonlar, modifikasyonlar veya temsil edilen kişiler hakkındaki hassas bilgileri sızdırmak için modellerle salt etkileşim potansiyeli yer alıyor. modelin kendisiyle ilgili veriler veya özel kurumsal veriler,” NIST söz konusu.

Yapay zeka sistemleri, kısmen OpenAI ChatGPT ve Google Bard gibi üretken yapay zeka sistemlerinin ortaya çıkmasıyla birlikte hızlı bir şekilde çevrimiçi hizmetlere entegre edildikçe, bu teknolojileri destekleyen modeller, makine öğrenimi operasyonlarının çeşitli aşamalarında bir dizi tehditle karşı karşıya kalıyor.

Bunlar arasında bozuk eğitim verileri, yazılım bileşenlerindeki güvenlik kusurları, veri modeli zehirlenmesi, tedarik zinciri zayıflıkları ve anlık enjeksiyon saldırıları sonucu ortaya çıkan gizlilik ihlalleri yer alıyor.

NIST bilgisayar bilimcisi Apostol Vassilev, “Yazılım geliştiricilerin çoğunlukla, ürünlerini daha iyi hale getirebilmek için daha fazla insanın kullanmasına ihtiyacı var” dedi. “Ancak maruz kalmanın iyi olacağının garantisi yok. Bir chatbot, dikkatle tasarlanmış bir dille istendiğinde kötü veya zehirli bilgiler yayabilir.”

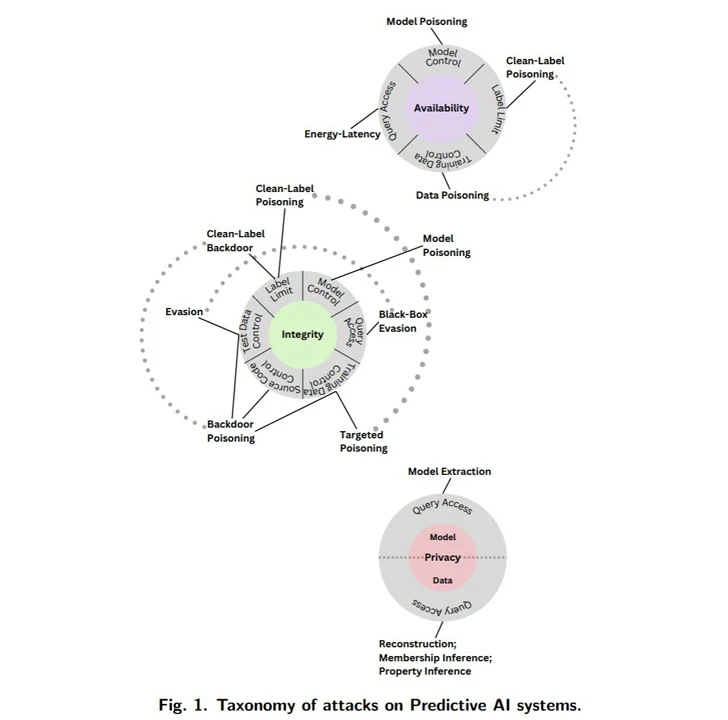

Kullanılabilirlik, bütünlük ve gizlilik üzerinde önemli etkileri olabilecek saldırılar genel olarak şu şekilde sınıflandırılıyor:

- Bir model konuşlandırıldıktan sonra rakip çıktı üretmeyi amaçlayan Kaçınma saldırıları

- Bozuk verileri sunarak algoritmanın eğitim aşamasını hedef alan zehirleme saldırıları

- Mevcut korkulukları aşan sorular sorarak sistem veya sistemin eğitim aldığı veriler hakkında hassas bilgiler toplamayı amaçlayan gizlilik saldırıları

- Sistemin kullanım amacını yeniden belirlemek için yanlış bilgi içeren bir web sayfası gibi meşru bilgi kaynaklarını ele geçirmeyi amaçlayan kötüye kullanım saldırıları

NIST’e göre bu tür saldırılar, tam bilgiye sahip (beyaz kutu), minimum bilgiye sahip (kara kutu) veya yapay zeka sisteminin bazı yönlerini kısmen anlayan (gri kutu) tehdit aktörleri tarafından gerçekleştirilebilir.

Ajans ayrıca, bu risklere karşı koymak için sağlam hafifletme önlemlerinin bulunmadığına dikkat çekerek, daha geniş teknoloji topluluğunu “daha iyi savunmalar bulmaya” çağırdı.

Bu gelişme, İngiltere, ABD ve diğer 16 ülkeden uluslararası ortakların güvenli yapay zeka (AI) sistemlerinin geliştirilmesine yönelik yönergeleri yayınlamasından bir aydan fazla bir süre sonra gerçekleşti.

Vassilev, “Yapay zeka ve makine öğreniminin kaydettiği önemli ilerlemeye rağmen, bu teknolojiler, korkunç sonuçlar doğurabilecek olağanüstü arızalara neden olabilecek saldırılara karşı savunmasızdır.” dedi. “Yapay zeka algoritmalarının güvenliğiyle ilgili henüz çözülmemiş teorik sorunlar var. Eğer biri aksini söylüyorsa, yılan yağı satıyorlar demektir.”