AMD’nin sahip olduğu yanıt verdi MI300X ile NVIDIA’nın H100 TensorRT-LLM rakamlarına ulaşıldı ve optimize edilmiş yazılım çalıştırılırken AI kıyaslamalarında bir kez daha lider oldu.

AMD ve NVIDIA, H100 ve MI300X Çipleri İçin Optimize Edilmiş Yazılım Yığınlarını Kullanarak Birbirine Karşı Yapay Zeka Üstünlüğünü İddia Eden Her İki GPU Üreticisiyle Şiddetli Bir Savaşa Giriyor

İki gün önce NVIDIA, Hopper H100 GPU’larının çiplerinin AMD’nin “Gelişen Yapay Zeka” etkinliği sırasında sergilediği performanstan çok daha iyi performans gösterdiğini göstermek için yeni kıyaslamalarını yayınladı. Kırmızı takım, yepyeni Instinct MI300X GPU’sunu, bir yıldan daha eski olmasına rağmen yapay zeka endüstrisindeki en popüler seçim olmaya devam eden Hopper H100 çipiyle karşılaştırdı. AMD tarafından kullanılan kıyaslama testleri, NVIDIA’nın yapay zeka çiplerine büyük bir destek sağlayan TensorRT-LLM gibi optimize edilmiş kitaplıkları kullanmıyordu.

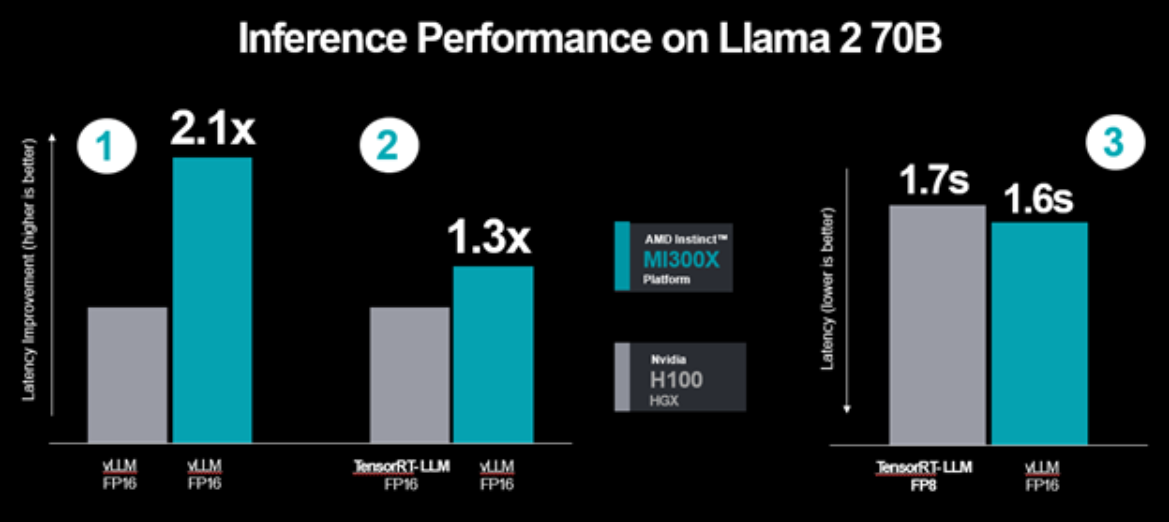

TensorRT-LLM’nin kullanılması, Hopper H100 GPU’nun AMD’nin Instinct MI300X GPU’suna göre neredeyse %50 performans artışı sağlamasıyla sonuçlandı. Şimdi AMD, Hopper H100 optimize edilmiş yazılım yığınını çalıştırırken bile MI300X’in H100’den daha hızlı performansı nasıl koruduğunu göstererek NVIDIA’ya tüm silindirleriyle ateş ediyor. AMD’ye göre NVIDIA’nın yayınladığı rakamlar:

- AMD kıyaslamalarında kullanılan vLLM yerine H100’de TensorRT-LLM kullanıldı

- AMD Instinct MI300X GPU’lardaki FP16 veri türünün performansı H100’deki FP8 veri türüyle karşılaştırıldı

- AMD tarafından yayınlanan performans verileri göreceli gecikme sayılarından mutlak iş hacmine dönüştürüldü

Bu nedenle AMD daha adil bir karşılaştırma yapmaya karar verdi ve en son rakamlara göre vLLM üzerinde çalışan Instinct MI300X’in TensorRT-LLM üzerinde çalışan Hopper H100’den %30 daha hızlı performans sunduğunu görüyoruz.

- Her ikisi için de vLLM kullanan MI300X’ten H100’e.

- Aralık başındaki lansman etkinliğimizde, eşdeğer veri türü ve kitaplık kurulumu kullanarak MI300X’in H100’e kıyasla 1,4 kat performans avantajını vurguladık. Yaptığımız son optimizasyonlarla bu performans avantajı 2,1 katına çıktı.

- vLLM’yi kullanıcı ve geliştirici topluluğunun geniş çapta benimsemesine dayanarak seçtik ve hem AMD hem de Nvidia GPU’larını destekliyoruz.

- vLLM kullanan MI300X ve Nvidia’nın optimize edilmiş TensorRT-LLM’sini kullanan H100

- Rakibimizin de belirttiği gibi H100 için TensorRT-LLM’yi ve MI300X için vLLM’yi kullanırken bile gecikmede hala 1,3 kat iyileşme görüyoruz.

- MI300X FP16 veri kümesi ile H100 arasındaki gecikme sonuçları TensorRT-LLM ve FP8 veri kümesi kullanılarak ölçüldü.

- MI300X, H100 ve H100 için daha düşük hassasiyetli FP8 ve TensorRT-LLM kullanırken bile mutlak gecikmeyi ölçerken performans avantajı göstermeye devam ediyor. vLLM ve MI300X için daha yüksek hassasiyetli FP16 veri türü.

- Popülerliği nedeniyle FP16 veri tipini kullanıyoruz ve bugün vLLM FP8’i desteklemiyor.

Bu sonuçlar, FP16 kullanan MI300X’in, FP8 ve TensorRT-LLM kullanırken bile Nvidia tarafından önerilen en iyi performans ayarlarıyla H100 ile karşılaştırılabilir olduğunu bir kez daha gösteriyor.

Elbette bu ileri geri rakamlar beklenmedik bir şey ancak yapay zekanın AMD, NVIDIA ve Intel gibi şirketler için ne kadar önemli hale geldiği göz önüne alındığında, gelecekte bu tür örneklerin daha fazla paylaşıldığını görmeyi bekleyebiliriz. Intel bile yakın zamanda tüm sektörün NVIDIA’nın sektördeki CUDA hakimiyetine son verme konusunda motive olduğunu belirtti. Şu an itibariyle gerçek şu ki, NVIDIA AI segmentinde uzun yıllara dayanan bir yazılım uzmanlığına sahip ve Instinct MI300X bazı korkunç özellikler sunarken, yakında H200 ve yakında çıkacak Blackwell B100 biçimindeki daha da hızlı bir Hopper çözümüyle rekabet edecek. 2024 yılında GPU’lar.

Intel ayrıca 2024’te Gaudi 3 hızlandırıcılarını piyasaya sürmeye hazır, bu da yapay zeka alanını daha da ısıtacak ancak bir bakıma bu rekabet, her satıcının yenilik yapmaya ve diğerine üstünlük sağlamaya devam ettiği canlı ve daha canlı bir yapay zeka endüstrisi yaratacak. müşterilere daha iyi yetenekler ve daha hızlı performans sunuyor. NVIDIA, yıllardır rekabet olmamasına rağmen bu segmentte yenilikler yapmaya devam etti ve AMD ile Intel’in yapay zeka üretim ve yazılımlarını artırmasıyla, onların da kendilerine ait daha iyi donanım/yazılımlarla karşılık vermelerini bekleyebiliriz.