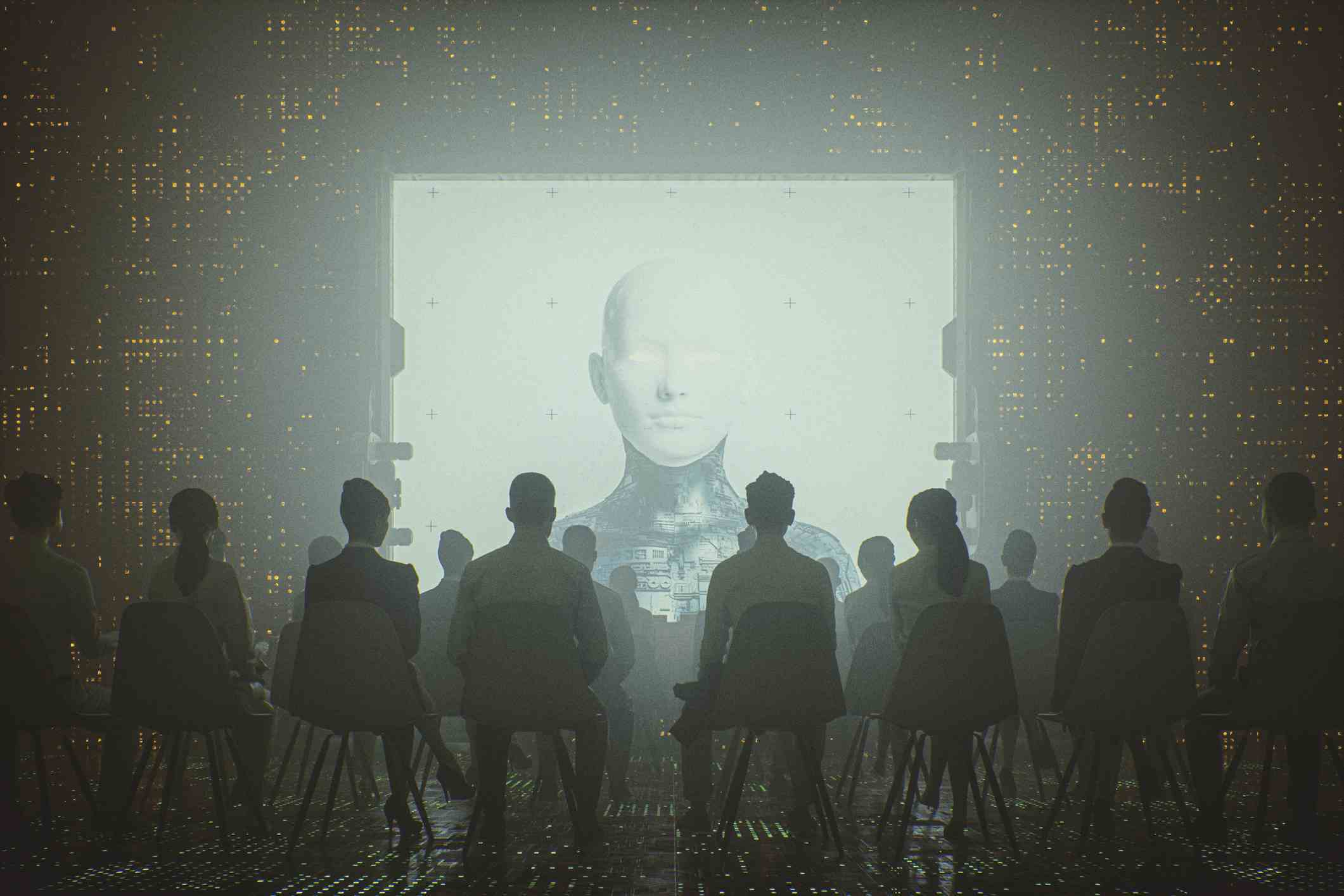

Resim: gremlin/Getty Images.

Yapay zeka modellerinin nasıl tasarlanacağına ilişkin bir deneyin ardından Toronto Üniversitesi ve MIT’den bilgisayar bilimi araştırmacılarından oluşan bir ekip şu uyarıda bulunuyor: Yapay zeka modellerinin tasarımı, hızlı bir şekilde düzeltilmezse insanlar için feci sonuçlara yol açabilecek bir sorun sunuyor.

Özetle, tüm yapay zeka modellerinin büyük miktarda veri üzerinde eğitilmesi gerekir. Ancak araştırmaları, mevcut iş yapma şeklinin derinden kusurlu olduğunu gösteriyor.

Yapay zeka zaten günlük yaşamlarımızı etkiliyor

Etrafınıza bakın ve yapay zekanın halihazırda nasıl olduğunu gözlemleyin tanıtıldı günlük yaşamımızda ve toplumda: Alexa size randevularınızı hatırlatır, makineler yorgunluğunuzun nedenini teşhis eder, algoritmalar hapis cezaları önerir vb. Bazı mesleklerin, örneğin banka kredisi başvurularını filtrelemek için yapay zeka araçlarını kullandığını unutmadan. 10 yıl içinde neredeyse yaptığımız her şey bir algoritma tarafından kontrol edilecek.

Yani, konaklama kiralamak için başvurular, kredi başvuruları gönderdiyseniz veya sizin için yapılan işlere başvuruda bulunduysanız ve yalnızca reddediliyorsanız, bu sadece kötü şans olmayabilir. Bu olumsuz sonuçların aslında yapay zeka algoritmalarının yetersiz eğitilmesinden kaynaklandığı düşünülebilir.

Daha spesifik olarak, Aparna Balagopalan, David Madras, David H. Yang, Dylan Hadfield-Menell, Gillian Hadfield ve Marzyeh Ghassemi’nin yazılarında işaret ettiği gibi madde ortaya çıkan BilimTanımlayıcı veriler üzerine eğitilmiş yapay zeka sistemleri, her zaman insanların vereceği kararlardan çok daha sert kararlar verir.

Ve eğer bu sonuçlar düzeltilmezse, bu yapay zeka sistemleri önemli karar alma süreçlerini içeren alanlarda büyük hasara yol açabilir.

Yargılamada dikkate değer bir fark

Normatif mi, tanımlayıcı mı?

Yapay zeka modellerinin tahminlerini nasıl doğruladığını araştıran bir projenin parçası olarak, adı geçen bilim insanları, çalışmadaki insanların bazen verileri tanımlayıcı veya normatif etiketlere atfetmeleri istendiğinde farklı cevaplar verdiklerini buldu.

A ” normatif iddia » Bir değer yargısını ima eder, çünkü ne olması gerektiğini belirtir. Örneğin: “Sınavını geçmek için daha çok çalışmalı. » Bir açıklama, olanı tanımladığı için nesneldir. Örneğin: “Gül kırmızıdır. »

Kafası karışan ekip, soruyu başka bir deneyle daha derinlemesine araştırmaya karar verdi; bu sefer daha fazla konfigürasyonu test etmek için dört veri seti topladı.

Bağlamı dikkate alan bir karar

Bilim adamları, veri kümeleri arasından köpeklerin fotoğraflarını ve saldırgan köpeklerin bir daireye girmesini yasaklayan bir düzenlemeyi içeren birini seçti. Daha sonra birkaç gruptan, verilerin nasıl oluşturulduğunu yansıtan bir süreç kullanarak normatif veya tanımlayıcı verileri etiketlemelerini istediler. İşlerin ilginçleştiği yer burası.

“Tanımlayıcı” etiketlerden sorumlu kişiler kendilerine belirli özelliklerin gerçek anlamda var olup olmadığı sorusunu sormak zorundaydı: saldırganlık, kötü hijyen vb. bağlamı bilmeden. Olumlu yanıt verilmesi durumunda bu kişiler farkında olmadan kuralın ihlal edildiğini ve köpeğin daireye girişinin yasaklandığını belirtmişlerdir. Aynı zamanda başka bir gruba, saldırgan köpek kuralı hakkında bilgi verildikten sonra aynı görsellere “normatif” etiketler uygulama görevi verildi.

Bu çalışmada, katılımcıların kurallardan habersiz olduklarında köpekleri kınama olasılıklarının daha yüksek olduğu ortaya çıktı.

Yargılama farkı da önemlidir. “Tanımlayıcı” etiketlere ayrılan grup, düzenlemeden haberdar olan gruba kıyasla (bilmeden) %20 daha fazla köpeği kınadı.

Eşitsizliklerin yeniden üretimine doğru mu?

Yapay zekaların önyargıları var…

Bu deneyin sonuçlarının günlük yaşamlarımız üzerinde, özellikle de daha az ayrıcalıklı olanlar için ciddi sonuçları olabilir. Yapay zekanın zaten bilinen önyargılarına bunu da eklersek daha da kötü olur.

Örneğin, hadi analiz edelim Doktora başvurularını değerlendirmek için tasarlanmış bir algoritmayı besleyen bir “makine öğrenimi döngüsü” tehlikesi. Önceki binlerce uygulamadan ve onu denetleyenler tarafından seçilen verilerden güç alan algoritma, genel olarak hangi aday profillerinin seçildiğini öğreniyor: iyi notlara sahip adaylar, iyi bir geçmiş, iyi bir okul… ve kimler beyaz.

Bu, algoritmanın ırkçı olduğu anlamına gelmiyor ancak onu eğitmek için kullanılan verilerin taraflı olduğu anlamına geliyor. Avukat Francisco de Abreu Duarte, krediyle karşı karşıya kalan yoksul insanların durumuyla bir paralellik kuruyor: “Yoksul insanlar yoksul oldukları için krediye erişemiyorlar. Kredi verilmediği için de yoksul kalıyorlar. »

Günümüzde bu Önyargı sorunu her yerde mevcut makine öğrenimini kullanan teknolojilerde. Bu sadece ırkçı olarak tanımlanabilecek önyargılarla ilgili değil, aynı zamanda örneğin cinsiyet, yaş veya engellilikle ilgili ayrımcılıkla da ilgili.

…ve daha sert bir şekilde yargılayın

“Yapay zeka ve makine öğrenimiyle ilgilenen çoğu araştırmacı, insan yargılarının taraflı olduğunu dikkate alıyor [car empreints de préjugés]ancak bu sonuç çok daha kötü bir şeyi ortaya koyuyor” Marzyeh Ghassemi’yi uyarmakMIT’de elektrik mühendisliği ve bilgisayar bilimleri alanında yardımcı doçent.

Eğer insan yargıları zaten önyargılıysa, bu modeller yalnızca zaten sorunlu olan önyargıları yeniden üretmekle kalmıyor, daha da ileri gidiyor. Aslında eğitildikleri veriler bir kusur barındırıyor: İnsanlar, görüşlerinin bir kararın parçası olarak kullanılacağını bildiklerinde, bir durumu veya kişiyi aynı şekilde nitelendirmezler.

Sonuçta yapay zekanın, önyargılarını da hesaba katsak bile, insanlardan çok daha sert olduğu ortaya çıkıyor. Bu nedenle verileri sınıflandırmak için kullanılması sonuçta saatli bir bomba olabilir. Özellikle yapay zeka modelleri uygun şekilde eğitilmediyse.

Kaynak : ZDNet.com