Bir kişiyi ekranın diğer tarafında başka bir insanın olduğuna gerçekten ikna edebilecek şekilde bir program tasarlamak, konseptin gerçekliğe doğru ilk adımlarını atmasından bu yana yapay zeka geliştiricilerinin bir hedefi olmuştur. Araştırma şirketi OpenAI geçtiğimiz günlerde amiral gemisi ürününü duyurdu. ChatGPT’nin gözleri, kulakları ve sesi olacak daha insani görünme arayışında. Şimdi, OpenAI’deki bir yapay zeka güvenlik mühendisi, doğaçlama bir terapi seansı yapmak için sohbet robotunun ses modunu kullandıktan sonra “oldukça duygulandığını” söylüyor.

OpenAI’nin güvenlik sistemleri başkanı Lilian Weng, bir tweet’te “Az önce ChatGPT ile ses modunda stres, iş-hayat dengesi hakkında oldukça duygusal, kişisel bir konuşma yaptım” dedi. gönderildi Dün. “İlginç bir şekilde duyulduğumu ve ısındığımı hissettim. Daha önce terapiyi hiç denemedim ama muhtemelen bu mu? Özellikle bunu genellikle yalnızca bir üretkenlik aracı olarak kullanıyorsanız deneyin.”

Weng’in bir OpenAI çalışanı olarak OpenAI ürününün faydalarını öne süren deneyimine kesinlikle şüpheyle yaklaşılması gerekiyor, ancak bu, Silikon Vadisi’nin yapay zekayı halk hayatımızın her köşesine yayılmaya zorlamaya yönelik son girişimlerini anlatıyor. Aynı zamanda yapay zekanın yükselişindeki bu anın eski olan her şeyin yeniden yeni olduğu havasına da değiniyor.

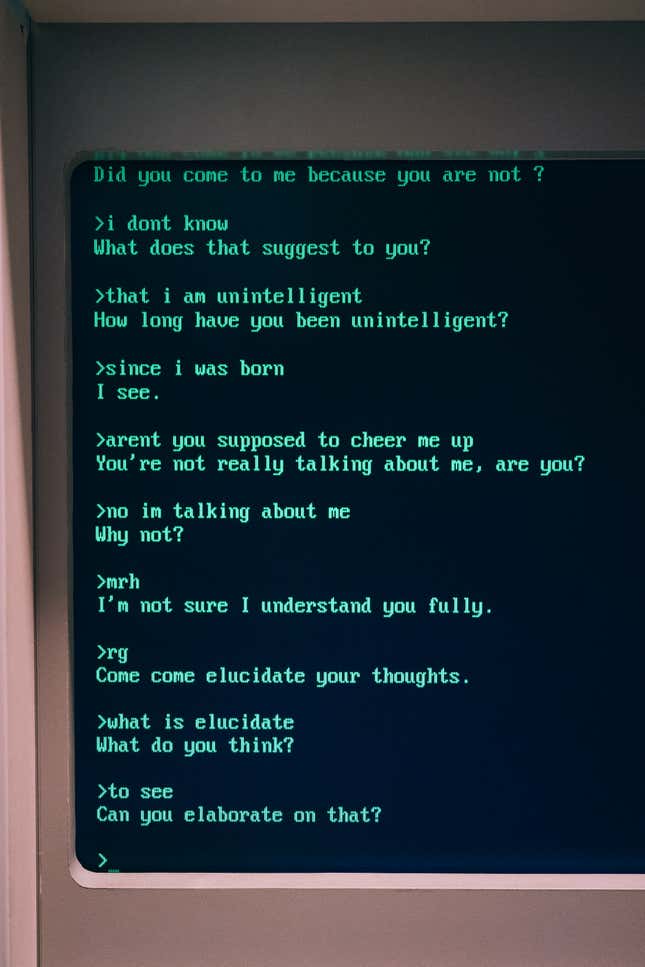

1960’ların teknolojik iyimserliği, bilgisayar kullanarak insanın düşünce süreçlerini taklit etme denemeleri olarak ortaya çıkan “AI” ile ilgili ilk deneylerden bazılarını besledi. Bu fikirlerden biri, doğal dil işleyen bir bilgisayar programıydı. ElizaMassachusetts Teknoloji Enstitüsü’nden Joseph Weizenbaum tarafından geliştirilmiştir.

Eliza, Doctor adında bir senaryoyu çalıştırdı ve bu senaryo şu şekilde modellendi: psikoterapist Carl Rogers’ın parodisi. İnsanlar damgalanmış hissetmek ve sıkıcı bir psikiyatr ofisinde oturmak yerine, en derin sorunlarına yardım almak için aynı derecede havasız bir bilgisayar terminalinin başına oturabilirler. Ancak Eliza o kadar da akıllı değildi ve senaryo, tıpkı Carl Rogers’ın yaptığı gibi, yalnızca belirli anahtar kelimelere ve cümlelere bağlanıyor ve bunları inanılmaz derecede basit bir şekilde kullanıcıya geri yansıtıyordu. Tuhaf bir şekilde Weizenbaum, Eliza kullanıcılarının programın temel çıktılarına duygusal olarak bağlandıklarını fark etmeye başladı; Weng’in kendi deyimiyle “dinlendiğini ve sıcak” hissettiklerini söyleyebilirsiniz.

Weizenbaum daha sonra 1976 tarihli kitabında şöyle yazmıştı: “Göreceli olarak basit bir bilgisayar programına son derece kısa süre maruz kalmanın, oldukça normal insanlarda güçlü sanrısal düşüncelere yol açabileceğini fark etmemiştim.” Bilgisayar Gücü ve İnsan Aklı.

Yapay zeka tedavisindeki daha yeni testlerin de çöktüğünü ve yandığını söylemek, bunu hafife almak olur. Eşler arası ruh sağlığı uygulaması Koko, danışman kılığına giren yapay zekayı denemeye karar verdi platformun 4.000 kullanıcısı için. Şirketin kurucu ortağı Rob Morris bu yılın başlarında Gizmodo’ya “gelecek bu olacak” dedi. Danışman rolündeki kullanıcılar, OpenAI’nin ChatGPT3 uygulaması olan Koko Bot’u kullanarak yanıtlar üretebiliyor ve bu yanıtlar daha sonra düzenlenebiliyor, gönderilebiliyor veya tamamen reddedilebiliyor. Araç kullanılarak 30.000 mesajın oluşturulduğu ve olumlu yanıtlar alındığı bildirildi, ancak Koko, sohbet robotunun kendisini kısır hissetmesi nedeniyle fişini çekti. Morris bu deneyimi Twitter’da paylaştığında (artık X olarak biliniyordu), halkın tepkisi aşılamazdı.

Olayların karanlık tarafında, bu yılın başlarında, Belçikalı bir adamın dul kadın kocasının dedi Kendini öldürmeye teşvik eden bir yapay zeka ile konuşmaya daldıktan sonra intihar ederek öldü.

Geçtiğimiz Mayıs ayında, Ulusal Yeme Bozukluğu Derneği, krizde olanların yardım isteyebileceği yeme bozukluğu yardım hattını kapatmak gibi cesur bir hamle yaptı. Burada, NEDA yardım hattı personelini bir chatbot ile değiştirmeyi seçti Tessa’nın adı. Toplu işten çıkarma, çalışanların sendikalaşmasından yalnızca dört gün sonra meydana geldi ve bundan önce de personelin yetersiz kaynaklara sahip olduğunu ve aşırı çalıştığını hissettiği bildirildi; bu, özellikle risk altındaki bir nüfusla bu kadar yakın çalışırken sarsıcı bir durum. Tessa’yı kullandıktan bir haftadan kısa bir süre sonra, NEDA kapandıchatbot’u çalıştırdım. Bir göre postalamak Kâr amacı gütmeyen kuruluşun Instagram sayfasında Tessa “zararlı ve programla ilgisi olmayan bilgiler vermiş olabilir.”

Kısacası, eğer hiç terapiye gitmediyseniz ve alternatif olarak chatbot’u denemeyi düşünüyorsanız, gitmeyin.