AMD merkezli bir Yüksek Lisans geliştiricisi, oldukça ilginç bir kısa videoda NVIDIA’nın AI GPU’larının azlığıyla alay etti. NVIDIA’nın AI GPU eksiklikleri, taleplerini karşılamak için diğer kamplara geçmeye başlayan AI startup’ları da dahil olmak üzere AI sektörü için önemli bir sorun haline geliyor.

Lamini CEO’su, NVIDIA AI GPU Eksikliklerini Doğru Şekilde Temsil Eden ve AMD Instinct GPU’ları Hazırlayan İlginç Kısa Video Yayınladı

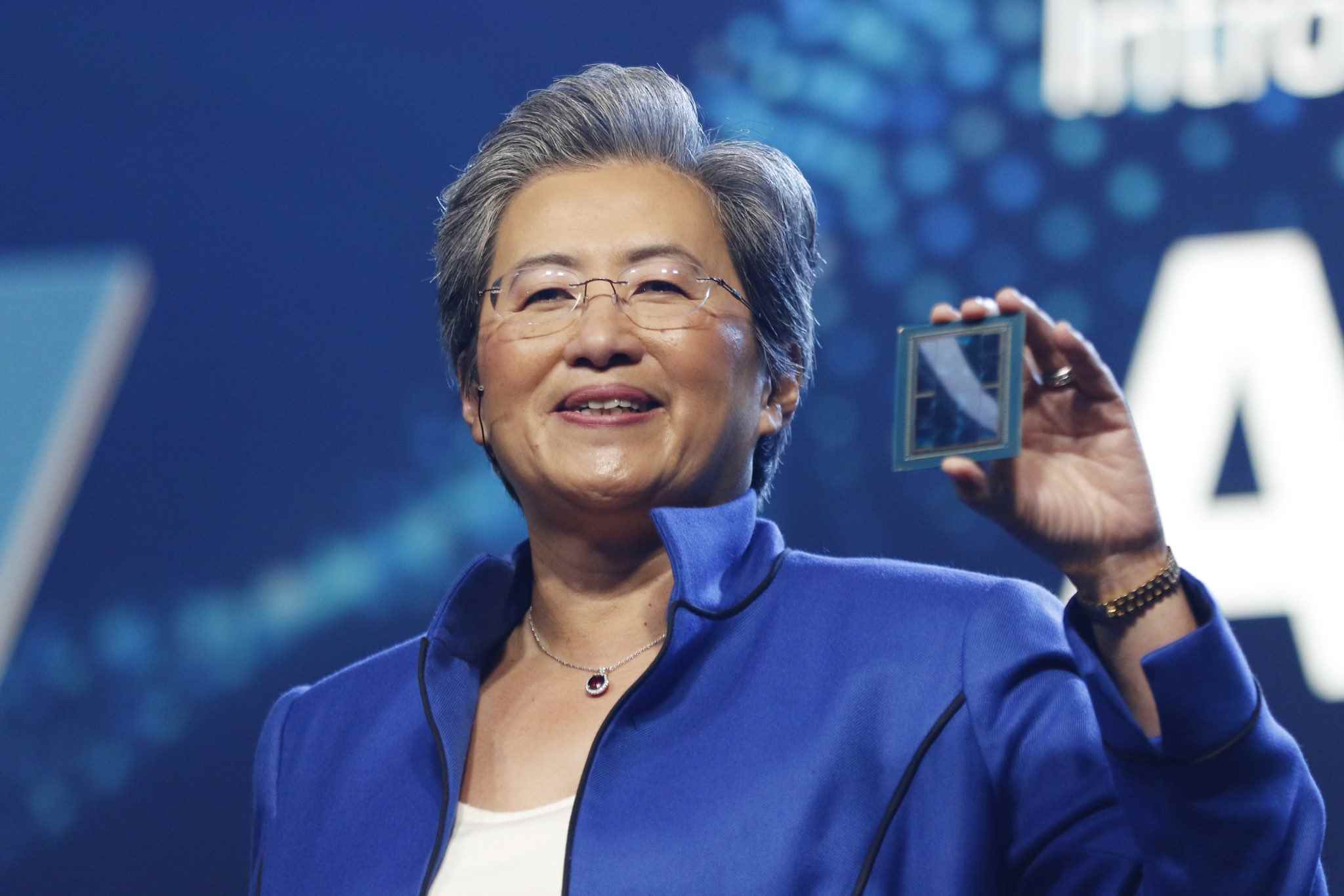

Lamini AI geliştirmeye odaklanan işletmeler ve geliştiriciler için Yüksek Lisans odaklı bir şirkettir. CEO’ları Sharon Zhou X, kısa ve eğlenceli bir video aracılığıyla kendileri de dahil olmak üzere çeşitli AI girişimlerinin NVIDIA AI GPU’larının bulunmamasından duyduğu hayal kırıklığını ifade etmek için geldi.

Sadece birkaç GPU’yu araştırıyorum 💁🏻♀️

İlk önce bunları pişirdiği için Jensen’a teşekkür ederiz https://t.co/4448NNf2JP pic.twitter.com/IV4UqIS7OR

— Sharon Zhou (@realSharonZhou) 26 Eylül 2023

Sharon bir yüksek lisans yapay zeka hızlandırıcısı bulmak için mutfağa (NVIDIA’nın CEO’su için oldukça ikonik bir ortam) girer ve “pişirilen” şeyin ne olduğunu görmek için bir fırın açar. Ancak fırında teslim süresi 52 haftaya kadar çıktı, ancak daha sonra ızgarasını kontrol etti ve AMD’nin Instinct hızlandırıcılarının kullanıma hazır olduğunu gördü.

Sharon’ın mevcut duruma ilişkin sunumu doğrudur, çünkü NVIDIA’nın AI GPU’ları, özellikle de H100’ler şu anda altı ayı aşan teslimat tarihleriyle birlikte büyük sipariş yığılmalarıyla karşı karşıyadır. AMD’nin burada bir avantajı var, çünkü şirketin Instinct AI hızlandırıcı siparişlerinin hacmi şu anda NVIDIA’nın yerine getirdiği siparişlerle karşılaştırıldığında hiçbir şey ifade etmiyor. Lamini bir süredir Yüksek Lisans’ta AMD’nin Instinct GPU’larını kullanıyor ve şirket, AMD ile kapsamlı bir işbirliğine kararlı.

Dahası, Lamini ile NVIDIA H100’lerin 52 haftalık teslim süresi konusunda endişelenmenize son verebilirsiniz. Lamini’yi özel olarak kullanarak kendi kurumsal LLM’lerinizi oluşturabilir ve bunları AMD Instinct GPU’larda üretime gönderebilirsiniz. Ve şşşt… Lamini, ChatGPT piyasaya sürülmeden önce bile tüm yıl boyunca üretimde yüzden fazla AMD GPU’yu gizlice çalıştırıyordu. Yani Lamini’yi denediyseniz AMD’yi denemişsinizdir.

Artık LLM’ye hazır GPU’ları daha fazla kişiye açacağımız için heyecanlıyız. LLM Superstation’ımız hem bulutta hem de şirket içinde mevcuttur. Lamini’nin kullanımı kolay kurumsal LLM altyapısını AMD Instinct MI210 ve MI250 hızlandırıcılarla birleştirir. Özel kurumsal LLM’ler için optimize edilmiştir ve özel verilerle büyük ölçüde farklılaştırılacak şekilde oluşturulmuştur.

Lamini, üretimde yalnızca AMD Instinct GPU’larda çalışan tek LLM platformudur. Kendi tescilli LLM’lerinizi gönderin! Kendi Llama 2-70B’nizi kutudan çıkar çıkmaz çalıştırmak için bir LLM Superstation siparişi vermeniz yeterli; şimdi mevcut ve cazip bir fiyat etiketiyle (AWS’den 10 kat daha ucuz).

Lamini aracılığıyla

Endüstri henüz AMD’nin Instinct GPU’larının geniş çapta benimsendiğini görmedi ve şimdilik NVIDIA’nın H100’lerinin “popülerlik” seviyesine ulaşamadılar. Performanstan bahsetmişken H100’lerin lider olduğunu hepimiz biliyoruz; ancak AMD, genel olarak daha yüksek bilgi işlem performansına yardımcı olan ROCm yazılım yığınındaki hızlı iyileştirmelerle buradaki boşluğu kapatıyor. Team Red, Instinct MI400 ve MI300X’i gelecekteki sürümler olarak planladı ancak henüz piyasaya çıkmadı; dolayısıyla bu konuda yorum yapamayız.

AMD’nin yararlanabileceği tek avantaj, NVIDIA’nın bu alanda geride kalması nedeniyle şirketin büyük siparişleri karşılayabilme yeteneğidir. NVIDIA H100’ler için bir yıllık bekleme süreleri nedeniyle, LLM girişimleri ve şirketleri eninde sonunda AMD ve Intel’e yönelecek; bu nedenle her teknoloji şirketi, 2024’e girerken yapay zeka geliştirmelerini muazzam bir şekilde hızlandırıyor.

Haber kaynağı: Tom’un Donanımı