Büyük dil modelleri (LLM’ler) genellikle en büyük ve en güçlü unvanını almak için mücadele ediyor gibi görünüyor, ancak bunların kullanımını izleyen birçok kuruluş, büyük dil modellerinin her zaman daha iyi olmadığını fark etmeye başlıyor.

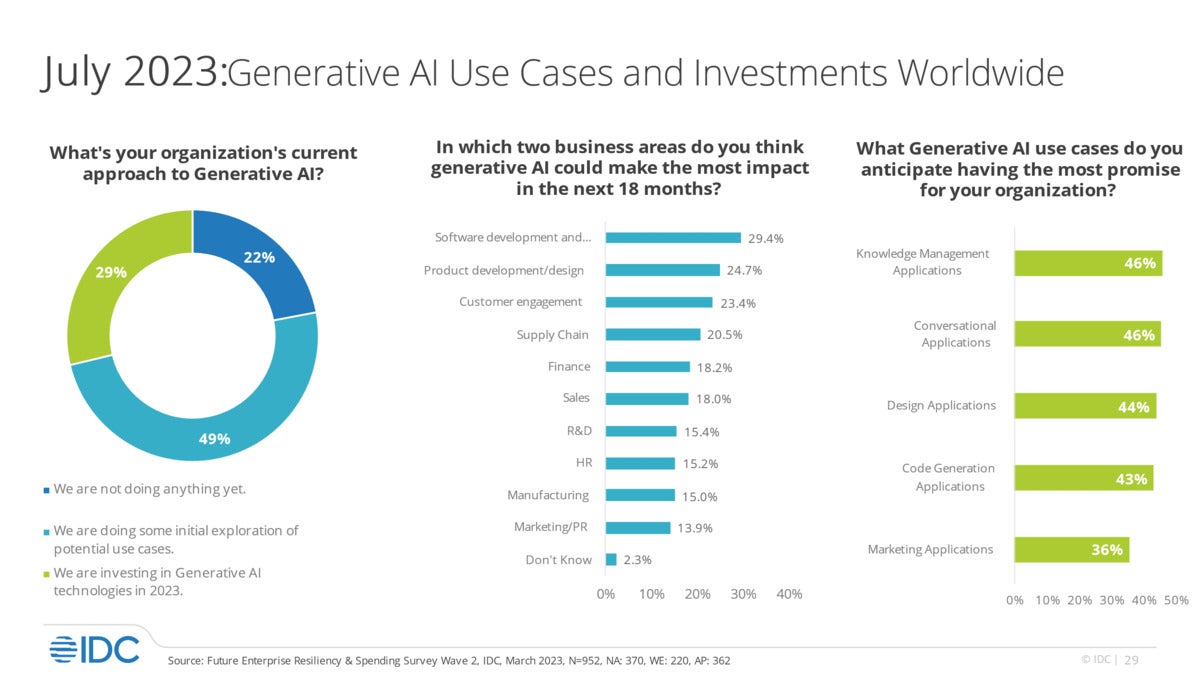

benimsenmesi üretken yapay zeka (genAI) araçları dik bir eğimde. IDC’nin 2.000’den fazla BT ve iş kolu karar vericisinin katıldığı bir ankete göre, kuruluşlar önümüzdeki bir buçuk yıl içinde yapay zeka girişimlerine 2022 takvim yılına kıyasla %10 ila %15 daha fazla yatırım yapmayı planlıyor.

Ve genAI halihazırda farklı sektörlerdeki işletmeler ve kuruluşlar üzerinde önemli bir etkiye sahip. IDC’nin bulgularına göre, ilk benimseyenler yapay zeka yatırımları sayesinde son üç yılda inovasyonda %35, sürdürülebilirlikte ise %33 artış olduğunu iddia ediyor.

Müşteri ve çalışan tutma oranı da %32 oranında arttı. IDC Yapay Zeka ve Otomasyon Araştırması grup başkan yardımcısı Ritu Jyoti, “Yapay zeka, önümüzdeki beş ila 10 yıl içinde müşterilere gerçek bir rekabet avantajı sağlamada bulut kadar önemli olacak” dedi. “Vizyoner olabilen organizasyonlar büyük bir rekabet avantajına sahip olacak.”

IDC

IDCYüz milyarlarca dolarlık genel amaçlı Yüksek Lisanslar veya trilyonlarca parametre bile Kulağa çok güçlü gelebilir ama aynı zamanda bilgi işlem döngülerini, ihtiyaç duydukları çiplerin üretilmesinden veya yükseltilmesinden daha hızlı tüketiyorlar; Bu, sunucu kapasitesini zorlayabilir ve gerçekçi olmayacak kadar uzun bir süre belirli bir iş kullanımına yönelik modelleri eğitmek.

Gartner Research’ün başkan yardımcısı seçkin analistlerinden Avivah Litan, “Eninde sonunda, GPU çiplerinin ölçeklendirilmesi model boyutundaki artışlara ayak uyduramayacak” dedi. “Yani modelleri giderek büyütmeye devam etmek geçerli bir seçenek değil.”

Ernst & Young’ın Küresel Yapay Zeka Danışmanlık Lideri Dan Diasio da aynı fikirde ve şu anda GPU siparişlerinde birikmiş bir iş olduğunu ekledi. Çip kıtlığı, yalnızca Yüksek Lisans yapan teknoloji firmaları için değil, aynı zamanda modellerde ince ayar yapmak veya kendi özel Yüksek Lisans’larını oluşturmak isteyen kullanıcı şirketleri için de sorun yaratıyor.

Diasio, “Sonuç olarak, ince ayar yapma ve uzmanlaşmış bir kurumsal LLM oluşturmanın maliyetleri oldukça yüksektir, bu da bilgi geliştirme paketlerine ve uzmanlık bilgisi içeren bilgi istemleri kütüphaneleri oluşturmaya yönelik eğilimi artırıyor” dedi.

Bunlara ek olarak, daha fazla veriyle eğitilmiş, alana özgü daha küçük modeller en sonunda OpenAI’nin GPT 4’ü, Meta AI’nın LLaMA 2’si veya Google’ın PaLM 2’si gibi günümüzün önde gelen LLM’lerinin hakimiyetine meydan okuyacak.

Daha küçük modellerin belirli kullanım durumları için eğitilmesi de daha kolay olacaktır.

Her büyüklükteki Yüksek Lisans’lar, hızlı mühendislik olarak bilinen bir süreç aracılığıyla eğitilir; sorguları ve modellere doğru yanıtları besler, böylece algoritma daha doğru yanıt verebilir. Bugün, bilgi istemlerinin listeleri için pazar yerleri bile var. ChatGPT için en iyi 100 istem.

Ancak LLM’lere ne kadar çok veri alınırsa, kötü ve hatalı çıktı olasılığı da o kadar artar. GenAI araçları temel olarak sonraki kelime tahmincileridir; bu, onlara beslenen hatalı bilgilerin hatalı sonuçlar doğurabileceği anlamına gelir. (LLM’ler zaten bazı yüksek profilli hatalar yaptı ve yeni nesil motorların raydan çıkıp tuhaf tepkiler ürettiği “halüsinasyonlar” üretebilirler.)

Dikey endüstriler veya özel kullanım için, OpenAI’nin GPT 4’ü veya Meta AI’nın LLaMA’sı gibi devasa genel amaçlı LLM’ler, milyarlarca veya daha fazlasını içerseler bile hatalı ve spesifik olmayabilir. trilyonlarca parametre. Parametre, bir LLM’nin sorgulara verebileceği farklı yanıtlar arasında karar vermesine yardımcı olan bir şeydir.

Litan, “mega LLM’lerin” iyi anlaşılmış teknoloji kullanmasına ve gelişmeye devam etmesine rağmen, bunların yalnızca yeterli kaynak, para ve beceriye sahip teknoloji devleri tarafından geliştirilip sürdürülebileceğini savundu.

“Bu, yüksek lisansların gücünü birkaç baskın oyuncuyla pekiştiriyor ve merkezileşme başlı başına büyük bir risk” dedi. “Muazzam teknolojik gücün sadece bir avuç oyuncu arasında merkezileştirilmesi her zaman kötü bir fikirdir. Bu şirketlerde anlamlı bir kontrol ve denge yoktur. Ve çip endüstrisi buna ayak uyduramıyor. GPU inovasyonu, model boyutlarının genişletilmesinden ve büyümesinden daha yavaş ilerliyor. Donanımın değişmesi her zaman yazılıma göre daha yavaştır.”

Belirli organizasyonel kullanım için LLM’lerin eğitimi

GPT 4 gibi modeller internetten ve diğer kaynaklardan alınan büyük miktardaki bilgilerle önceden doldurulmuş ve eğitilmiş olsa da, hızlı mühendislik, genAI kullanıcılarının özel veya sektöre özel bilgileri kullanarak yanıtları ayarlamasına olanak tanır. Örneğin, bir kullanıcı kuruluşu ChatGPT’yi yerel API’lerle arka uç uygulamalarına ve veritabanlarına bağlayabilir; genAI aracı daha sonra işletmeye özgü daha fazla kullanım için bu özel şirket bilgilerinden yararlanabilir.

Buna göre yeni bir anket Deloitte’un 115 CFO’sundan %42’si şirketlerinin genAI ile deneyler yaptığını ve %15’i bunu stratejilerine dahil ettiğini söyledi. Ankete katılan CFO’ların yaklaşık üçte ikisi, gelecek yılın bütçesinin yüzde 1’inden azının gen yapay zekaya harcanacağını söylüyor ve CFO’ların yaklaşık üçte biri, gelişen teknolojiye yüzde 1 ila yüzde 5 oranında gitmeyi öngörüyor.

CFO’ların %63’ü için genAI’nın benimsenmesi ve devreye alınmasının önündeki en büyük engeller yetenek kaynakları ve yetenekleridir. Dahili yetenek eksikliğinin ışığında, giderek artan sayıda teknoloji firması, iş görevlerini otomatikleştirebilen veya kullanıcıların gereksiz veya tekrarlanan görevleri yerine getirmesine yardımcı olabilecek LLM’leri temel alan genAI araçlarını tanıttı.

Mart ayında Salesforce GPT tabanlı bir chatbot yayınlama planlarını duyurdu CRM platformuyla birlikte kullanılmak üzere. Aynı ay Microsoft, GPT-4 tabanlı sürümünü duyurdu. Dynamics 365 Yardımcı PilotuBazı CRM ve ERP görevlerini otomatikleştirebilen. Diğer genAI platformları, kod yazmaya veya iş başvurusunda bulunanları en iyiden en kötüye doğru sıralamak veya terfi için çalışanlara tavsiyede bulunmak gibi İK işlevlerini yerine getirmeye yardımcı olabilir.

Büyük LLM yaratıcıları da modellerini belirli endüstri kullanımlarına göre uyarlamaya başlıyor.

Örneğin, Google artık alana özel iki model sunuyor: Med-PaLM 2tıbbi olarak ayarlanmış versiyonu PaLM 2önümüzdeki ay sağlık ve yaşam bilimleri sektöründe daha fazla müşteriye ön izleme olarak sunulacak ve Sec-Palm, güvenlik kullanımları için ince ayar yapılmış bir sürüm. İkincisi, Google’ın tehdit ortamına ilişkin görünürlüğü ve Mandiant’ın güvenlik açıkları, kötü amaçlı yazılımlar, tehdit göstergeleri ve davranışsal tehdit aktörü profilleri hakkındaki ön saf istihbaratı gibi güvenlik istihbaratını içerir.

Shutterstock/Robert Way

Shutterstock/Robert Way Google ayrıca şunları sunuyor: Vertex AIPaLM 2 LLM’yi veya iddia ettiği herhangi bir üçüncü taraf veya açık kaynaklı modeli özelleştirmek için kullanılan bir dizi ayarlama metodolojisi.

Bir Google sözcüsü, bir e-posta yanıtında şunları söyledi: “Müşterilerimiz bu ayarlama yöntemlerini, kendi kullanım durumları, iş hedefleri ve bütçeleri için hangi yaklaşımın en iyi olduğu konusunda rehberlik sağlarken, belirli iş kullanım durumlarına göre özelleştirme yapmak ve kendi kurumsal verilerinden yararlanmak için kullanıyor.” ile Bilgisayar Dünyası.

Vertex AI, aşağıdaki gibi özelleştirme özellikleri sunar: hızlı ayarlama ve adaptör ayarlama, Sözcü, bunun daha büyük bir eğitim veri seti (yüzlerce ila binlerce örnek) ve eğitmek için az miktarda bilgi işlem gücü gerektirdiğini söyledi.

Aynı zamanda, Vertex AI işlem hatlarını kullanarak modeli ayarlamak için çıktılar hakkında insan geri bildirimlerini alan “insan geri bildirimiyle takviyeli öğrenme” olanağı da sunuyor.

Startup’lar da bu mücadeleye katılıyor, sektöre özel LLM’ler yaratıyor veya müşterileri için ince ayar modelleri yaratıyor.

yazarörneğin, işletmeler için tam kapsamlı bir genAI platformu sunan bir girişim; iş operasyonlarını, ürünleri, satışları, insan kaynakları operasyonlarını ve pazarlamayı destekleyebilir. Şirket teklif ediyor çeşitli dil modelleri belirli sektörlere hitap ediyor. Şirketin en küçük modeli 128 milyon parametreye sahip, en büyüğü ise Palmyra-X’in 40 milyar parametresi var.

Writer’ın kurucu ortağı ve CEO’su May Habib, “Temel modellerimizde sektör dikeylerini destekleyecek şekilde ince ayar yapıyoruz” dedi.

Örneğin, sağlık hizmetleri odaklı bir model olan Palmyra-Med’i oluşturmak için Writer, temel modeli olan Palmyra-40B’yi aldı ve uyguladı. talimat ince ayarı. Bu süreç aracılığıyla şirket, yüksek lisans eğitimlerini halka açık iki kaynaktan alınan seçilmiş tıbbi veri kümeleri konusunda eğitti; PubMedQA Ve MedQA.

Litan’a göre “Daha küçük modeller, bugün birçok araştırmacı ve son kullanıcı için geçerli seçenekler haline geliyor ve yapay zeka ‘zenginliğini’ etrafa yaymak, kontrol ve çözüm açısından iyi bir fikir.” çok daha fazla veri (örneğin, beş ila 10 kat daha fazla) veya seçilmiş veriler üzerinde eğitilmiş daha küçük modelleri gösteren deneyler ve yenilikler, mega LLM’lerin performansına yaklaşabilir.”

Şubat ayında Facebook’un ana şirketi Meta, kendi sürümünün sürümlerini yayınladı. LLaMa Yüksek Lisans Yedi ila 65 milyar parametre arasında değişen boyutlarda, önceki modellere göre çok daha küçük. Ayrıca 13 milyar parametreli LLaMA modelinin çoğu kıyaslamada çok daha büyük GPT-3 modelinden daha iyi performans gösterdiğini iddia etti. Meta, daha küçük LLM’nin “demokratikleştirmek“yeni yaklaşımları test etmek, başkalarının çalışmalarını doğrulamak ve yeni kullanım senaryolarını keşfetmek için daha az bilgi işlem gücü ve kaynağı” gerektirerek genAI’ye erişim.

Stanford’da, Nvidia’da ve John Hopkins gibi akademik kurumlarda başka yenilikler de yapılıyor. BabyLM mücadelesi Neredeyse en büyük LLM’ler kadar iyi olan, önemli ölçüde daha küçük modeller yaratmak. Litan, “Tüm bunların hâlâ araştırma laboratuvarlarının ötesinde kendilerini kanıtlaması gerekiyor, ancak ilerleme ilerliyor” dedi.

Daha büyük bir model ekosisteminin parçası olarak belirli işler için daha küçük alt modellerin eğitilmesini içeren teknikler de dahil olmak üzere test edilen başka teknikler de vardır.

“İşletmelerin GPT veya PaLM gibi bir modeli kullanma konusundaki endişelerini görüyoruz çünkü bunlar çok büyük ve model sağlayıcılar tarafından barındırılmak zorunda. Yapay zeka destekli kurumsal arama motoru sağlayıcısı Glean’ın CEO’su Arvind Jain, “Bir bakıma verileriniz bu sağlayıcılardan geçiyor” dedi.

Glean’ın arama motoru, kullanıcı sorgularını veri veya dahili belge aradıkları kuruluşla eşleştirmek için büyük ölçüde GPT 4, PaLM 2 ve LLaMA 2 gibi LLM’lere güveniyor.

Bulut tabanlı LLM’lerle ilgili devam eden endişeler arasında güvenlik, gizlilik ve telif hakkı ihlali sorunları yer almaktadır. Google’ın eski seçkin mühendislerinden Jain, OpenAI ve Google’ın artık müşteri verilerini yüksek lisanslarını daha iyi özelleştirmek için kötüye kullanmayacaklarına dair güvence sunduğunu söyledi. Jain, işletmelerin bu güvenceleri kabul ettiğini söyledi.

Bu doğrultuda OpenAI, kuruluşlara şifreleme ve tek oturum açma teknolojisi aracılığıyla daha fazla güvenlik ve gizlilik sunan ChatGPT Enterprise uygulamasını kısa süre önce yayınladı.

Uçtan uca yazılım geliştirme ve dağıtım üretmek için yapay zekayı kullanan bir hizmet olan Digital.ai’nin CEO’su Derek Holt, daha küçük, daha iyi uyarlanmış LLM’lerin aşağıdaki gibi girişimlerden ortaya çıktığını söyledi: pryon Bu, kuruluşların kendi LLM’lerini hızlı bir şekilde oluşturmalarına olanak tanır. Holt, “Fikir şu: ‘Kurumlarımızın verileri bağlamında bir tane oluşturacağız” dedi.

Matt Jackson, sistem entegrasyonu hizmetleri sağlayıcısının küresel CTO’su İçgörü Şirketleri, bazı kullanıcılar için daha “odaklı” bir Yüksek Lisans eğitiminin kesin avantajları olduğunu söyledi. Örneğin sağlık ve finansal hizmetler endüstrileri, belirli veri kümeleri üzerinde eğitilmiş daha küçük modeller üzerinde denemeler yapıyor.

Amazon da kendi ürününü piyasaya sürüyor Yüksek Lisans pazarı Daha küçük modellerle kuruluşlar kendi kurumsal verilerini kullanarak eğitim verebilirler.

“Çoğu kişi için kendi modelini eğitmek muhtemelen doğru bir yaklaşım değil. Birlikte çalıştığımız çoğu şirket ChatGPT, Langchain veya Microsoft’un bilişsel arama motorunu kullanmaya son derece uygundur. LLM önceden eğitilmiş bir kara kutudur. Jackson, “Bunun kendi verilerinize erişmesine izin verebilirsiniz” dedi.

Özel bir LLM oluşturmak zor ve pahalıdır

Şu anda yüzlerce açık alanlı LLM bulunmaktadır. Github gibi çevrimiçi geliştirici depoları. Ancak modeller, yerleşik teknoloji satıcılarının modellerinden çok daha küçük olma eğilimindedir ve bu nedenle çok daha az güçlü veya daha az uyarlanabilirdir.

Bunun da ötesinde, tescilli LLM’ler oluşturmak zorlu bir iş olabilir; Jain, teknolojiyi denemeye devam etmelerine rağmen bunu başarıyla gerçekleştiren tek bir müşteriye rastlamadığını söyledi.

“Şu anda gerçek şu ki, açık alandaki modeller çok güçlü değil. Kendi deneylerimiz, GPT 4 veya PaLM 2’den aldığınız kalitenin açık alan modellerinden çok daha üstün olduğunu gösterdi” dedi Jain. “Dolayısıyla genel amaçlı uygulamalar için kendi modellerinizi oluşturup eğitmek şu anda doğru strateji değil.”

Telif Hakkı © 2023 IDG Communications, Inc.