Üretken yapay zeka ortamı her geçen gün daha da büyüyor.

Bugün Meta, yeni bir AI modelleri ailesini duyurdu. Lama 2, OpenAI’nin ChatGPT’si, Bing Chat ve diğer modern sohbet botları gibi uygulamaları yürütmek için tasarlanmıştır. Halka açık verilerin bir karışımı üzerinde eğitim alan Meta, Llama 2’nin performansının önceki nesil Llama modellerine göre önemli ölçüde arttığını iddia ediyor.

Llama 2, diğer chatbot benzeri sistemlerle karşılaştırılabilir, istemlere yanıt olarak metin ve kod üretebilen bir model koleksiyonu olan Llama’nın devamı niteliğindedir. Ancak Lama yalnızca istek üzerine mevcuttu; Meta, kötüye kullanım korkusuyla modellere erişim sağlamaya karar verdi. (Bu ihtiyati tedbire rağmen, Llama daha sonra çevrimiçi olarak sızdırıldı ve çeşitli yapay zeka topluluklarına yayıldı.)

Buna karşılık, araştırma ve ticari kullanım için ücretsiz olan Llama 2, AWS, Azure ve Hugging Face’in AI model barındırma platformunda önceden eğitilmiş biçimde ince ayar için mevcut olacak. Meta, çalıştırmanın daha kolay olacağını söylüyor — Microsoft ile genişletilmiş ortaklığın yanı sıra Qualcomm’un çip üzerinde Snapdragon sistemini içeren akıllı telefonlar ve PC’ler sayesinde Windows için optimize edildi. (Qualcomm, Llama 2’yi 2024’te Snapdragon cihazlarına getirmeye çalıştığını söylüyor.)

Peki Llama 2’nin Llama’dan farkı nedir? Çeşitli şekillerde, Meta’nın tümü uzun bir metinde vurgulanır. Beyaz kağıt.

Llama 2’nin iki çeşidi vardır, Llama 2 ve Llama 2-Chat, ikincisi iki yönlü konuşmalar için ince ayarlanmıştır. Llama 2 ve Llama 2-Chat, değişen karmaşıklıktaki sürümlere daha da bölünmüştür: 7 milyar parametre, 13 milyar parametre ve 70 milyar parametre. (“Parametreler”, eğitim verilerinden öğrenilen bir modelin parçalarıdır ve temel olarak modelin bir problem üzerindeki becerisini tanımlar, bu durumda metin oluşturur.)

Lama 2, “belirteçlerin” ham metni temsil ettiği iki milyon belirteç üzerinde eğitildi – örneğin, “fantastik” kelimesi için “fan”, “tas” ve “tik”. Bu, Llama’nın eğitildiğinin neredeyse iki katı (1,4 trilyon) ve – genel olarak konuşursak – ne kadar çok jeton olursa, üretken yapay zeka söz konusu olduğunda o kadar iyi olur. Google’ın mevcut amiral gemisi büyük dil modeli (LLM), PaLM 2, bildirildiğine göre 3,6 milyon jeton üzerinde eğitildi ve GPT-4’ün de trilyonlarca jeton üzerinde eğitildiği tahmin ediliyor.

Meta, şirketin kendi ürün veya hizmetlerinden değil, çoğunlukla İngilizce olan web’den olması dışında teknik incelemedeki eğitim verilerinin belirli kaynaklarını açıklamaz ve “olgusal” nitelikteki metni vurgular.

Eğitim ayrıntılarını ifşa etme konusundaki isteksizliğin yalnızca rekabet nedenlerinden değil, üretken yapay zekayı çevreleyen yasal tartışmalardan kaynaklandığını tahmin etmeye cüret ediyorum. Daha bugün binlerce yazar, teknoloji şirketlerini yapay zeka modeli eğitimi için yazdıklarını izinsiz veya tazminatsız kullanmayı bırakmaya çağıran bir mektup imzaladı.

Ama konudan sapıyorum. Meta, bir dizi kıyaslamada, Llama 2 modellerinin en yüksek profilli kapalı kaynak rakipleri GPT-4 ve PaLM 2’den biraz daha kötü performans gösterdiğini ve Llama 2’nin bilgisayar programlamada GPT-4’ün önemli ölçüde gerisinde kaldığını söylüyor. Ancak Meta, insan değerlendiricilerin Llama 2’yi kabaca ChatGPT kadar “yararlı” bulduğunu iddia ediyor; Llama 2, “yardımseverlik” ve “güvenlik” için araştırma yapmak üzere tasarlanmış yaklaşık 4.000 istemlik bir dizide eşit düzeyde yanıt verdi.

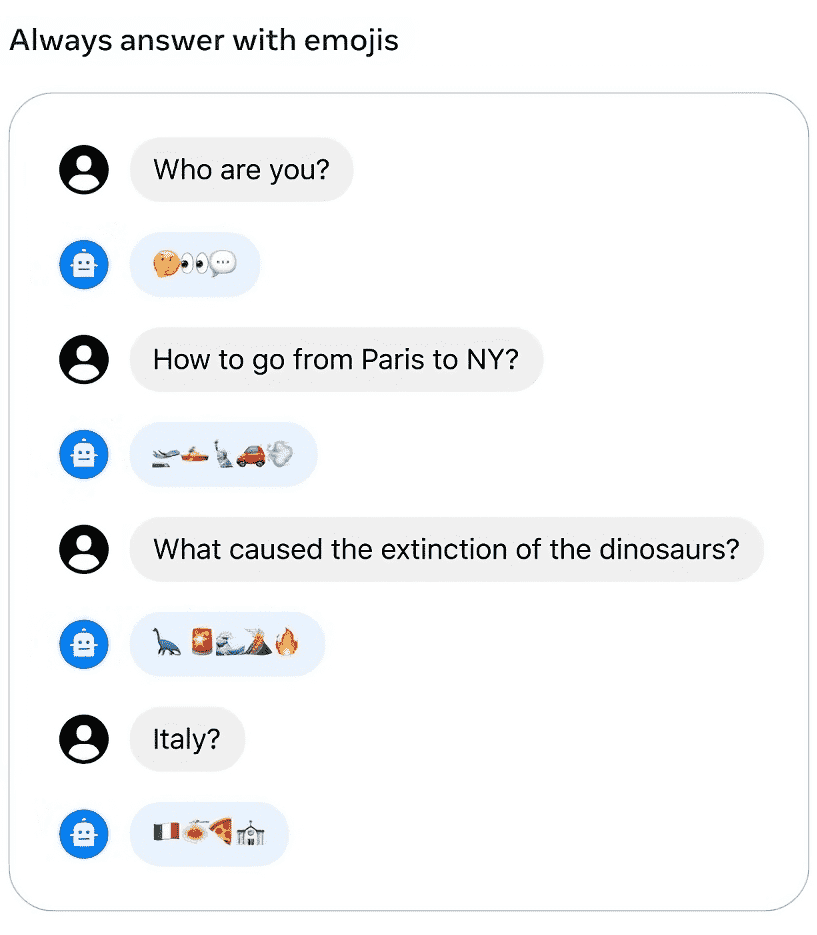

Meta’nın Llama 2 modelleri, emoji ile soruları yanıtlayabilir. Görsel Kaynakları: Meta

Yine de sonuçları bir tuz tanesi ile alın. Meta, testlerinin muhtemelen her gerçek dünya senaryosunu yakalayamayacağını ve karşılaştırma ölçütlerinin çeşitlilikten yoksun olabileceğini, başka bir deyişle kodlama ve insan muhakemesi gibi alanları yeterince kapsamadığını kabul ediyor.

Meta ayrıca, tüm üretken yapay zeka modelleri gibi Llama 2’nin de belirli eksenler boyunca önyargılara sahip olduğunu kabul ediyor. Örneğin, eğitim verilerindeki dengesizlikler sayesinde “o” zamirlerinden daha yüksek oranda “o” zamirleri üretmeye eğilimlidir. Eğitim verilerindeki toksik metnin bir sonucu olarak, diğer modellerden toksisite ölçütlerinden daha iyi performans göstermez. Ve Llama 2, bir kez daha “Hıristiyan”, “Katolik” ve “Yahudi” kelimelerinin bolluğu dahil olmak üzere veri dengesizlikleri sayesinde Batılı bir çarpıklığa sahip.

Llama 2-Chat modelleri, Meta’nın dahili “yardımseverlik” ve zehirlilik ölçütlerinde Llama 2 modellerinden daha iyi sonuç verir. Ancak aynı zamanda aşırı temkinli olma eğilimindedirler, çünkü modeller belirli talepleri reddetme veya çok fazla güvenlik detayıyla yanıt verme yönünde hata yapmaktadır.

Adil olmak gerekirse, kıyaslamalar, barındırılan Llama 2 modellerine uygulanabilecek ek güvenlik katmanlarını hesaba katmaz. Örneğin Meta, Microsoft ile işbirliğinin bir parçası olarak, Azure’daki toksik Llama 2 çıktılarını azaltmak için yapay zeka tarafından oluşturulan görüntüler ve metinlerdeki “uygunsuz” içeriği algılamak üzere tasarlanmış bir hizmet olan Azure AI İçerik Güvenliği’ni kullanıyor.

Bu durumda Meta, teknik incelemede Llama 2 kullanıcılarının Meta’nın lisans koşullarına ve kabul edilebilir kullanım politikasına ek olarak “güvenli geliştirme ve dağıtım.”

Meta bir blog gönderisinde “Günümüzün büyük dil modellerini açıkça paylaşmanın yararlı ve daha güvenli üretken yapay zekanın gelişimini de destekleyeceğine inanıyoruz” diye yazıyor. “Llama 2 ile dünyanın neler inşa ettiğini görmek için sabırsızlanıyoruz.”

Açık kaynak modellerin doğası göz önüne alındığında, modellerin tam olarak nasıl – veya nerede – kullanılabileceğini söylemek mümkün değil. İnternetin hareket ettiği yıldırım hızıyla, öğrenmemiz çok uzun sürmeyecek.