Genellikle OpenAI’nin ChatGPT’si gibi büyük dil modellerinin (LLM’ler) bir kara kutu olduğu söylenir ve kesinlikle bunda bazı gerçekler vardır. Veri bilimcileri için bile, bir modelin neden her zaman olduğu gibi yanıt verdiğini bilmek zordur, örneğin tüm kumaştan gerçekler icat etmek gibi.

LLM’lerin katmanlarını soymak için OpenAI, bir LLM’nin hangi bölümlerinin hangi davranışlarından sorumlu olduğunu otomatik olarak belirleyen bir araç geliştiriyor. Arkasındaki mühendisler erken aşamalarda olduğunu vurguluyor, ancak onu çalıştıracak kod bu sabah itibariyle GitHub’da açık kaynak olarak mevcut.

“Biz yapmaya çalışıyoruz [develop ways to] OpenAI yorumlanabilirlik ekibi yöneticisi William Saunders, bir telefon görüşmesinde TechCrunch’a verdiği demeçte, bir AI sistemindeki sorunların ne olacağını tahmin edin. “Modelin ne yaptığına ve ürettiği cevaba güvenebileceğimizi gerçekten bilmek istiyoruz.”

Bu amaçla, OpenAI’nin aracı, diğer, mimari açıdan daha basit LLM’lerin bileşenlerinin işlevlerini, özellikle de OpenAI’nin kendi GPT-2’sini anlamak için (ironik bir şekilde) bir dil modeli kullanır.

OpenAI’nin aracı, bir LLM’deki nöronların davranışlarını simüle etmeye çalışır.

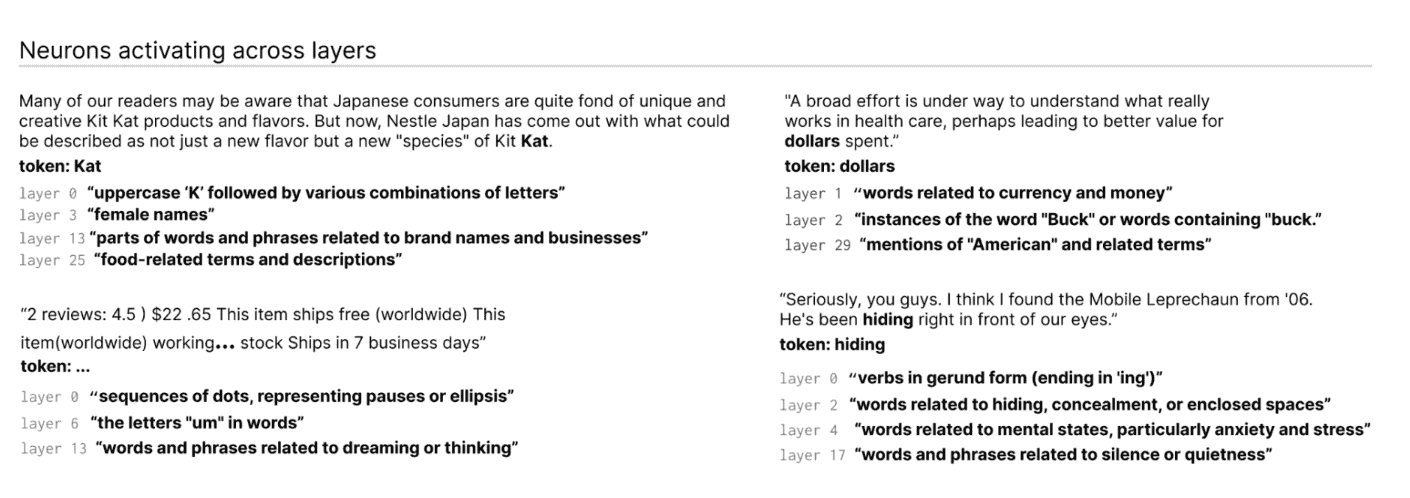

Nasıl? İlk olarak, arka plan için LLM’ler hakkında hızlı bir açıklayıcı. Beyin gibi, onlar da genel modelin bir sonraki “söylediğini” etkilemek için metindeki belirli bir modeli gözlemleyen “nöronlardan” oluşur. Örneğin, süper kahramanlar hakkında bir soru verildiğinde (örn. “Hangi süper kahramanlar en kullanışlı süper güçlere sahip?”), bir “Marvel süper kahraman nöronu”, modelin Marvel filmlerinden belirli süper kahramanları adlandırma olasılığını artırabilir.

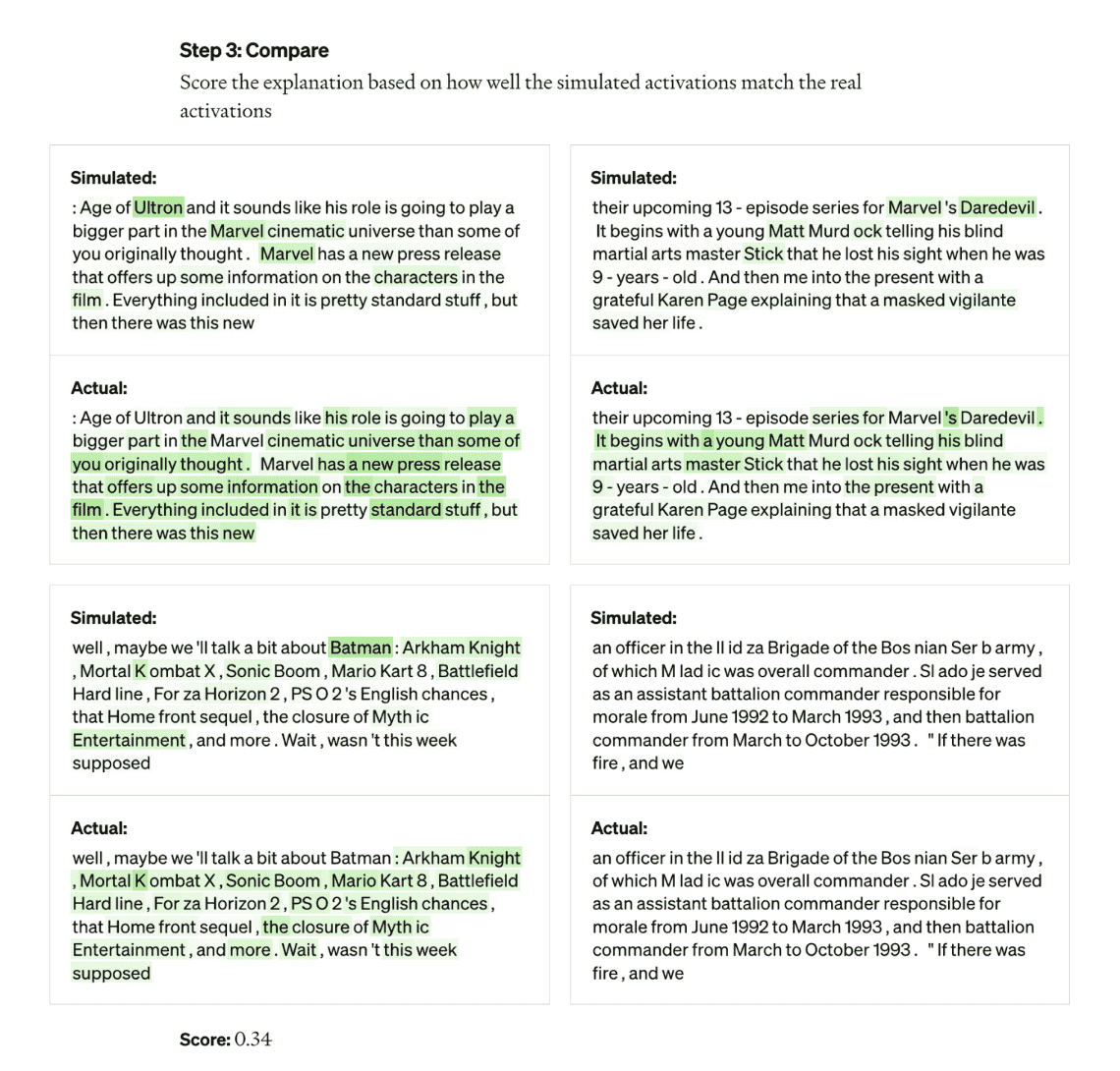

OpenAI’nin aracı, modelleri kendi bireysel parçalarına ayırmak için bu kurulumdan yararlanır. İlk olarak araç, değerlendirilmekte olan model aracılığıyla metin dizilerini çalıştırır ve belirli bir nöronun sık sık “etkinleştiği” durumları bekler. Ardından, OpenAI’nin en son metin üreten AI modeli olan GPT-4’ü, bu oldukça aktif nöronları “gösterir” ve GPT-4’ün bir açıklama oluşturmasını sağlar. Açıklamanın ne kadar doğru olduğunu belirlemek için araç, GPT-4’e metin dizileri sağlar ve nöronun nasıl davranacağını tahmin etmesini veya simüle etmesini sağlar. Daha sonra simüle edilmiş nöronun davranışını gerçek nöronun davranışıyla karşılaştırır.

Jeff Wu, “Bu metodolojiyi kullanarak, temelde, her bir nöron için, onun ne yaptığına dair bir tür ön doğal dil açıklaması bulabilir ve ayrıca bu açıklamanın gerçek davranışla ne kadar iyi eşleştiğine dair bir skor elde edebiliriz.” OpenAI’deki ölçeklenebilir hizalama ekibi, dedi. “Bir nöronun ne aradığına dair açıklamalar üretme sürecinin bir parçası olarak GPT-4’ü kullanıyoruz ve ardından bu açıklamaların yaptığı şeyin gerçekliğiyle ne kadar iyi eşleştiğini puanlıyoruz.”

Araştırmacılar, araç koduyla birlikte yayınlanan bir veri setinde derledikleri GPT-2’deki 307.200 nöronun tümü için açıklamalar üretebildiler.

Araştırmacılar, bunun gibi araçların bir gün bir LLM’nin performansını iyileştirmek için kullanılabileceğini söylüyor – örneğin önyargıyı veya toksisiteyi azaltmak için. Ancak, gerçekten yararlı olabilmesi için kat etmesi gereken uzun bir yol olduğunu kabul ediyorlar. Araç, toplamın küçük bir kısmı olan bu nöronların yaklaşık 1000’i için açıklamalarında kendinden emindi.

Alaycı bir kişi, GPT-4’ün çalışması için gerekli olduğu göz önüne alındığında, aracın esasen GPT-4 için bir reklam olduğunu iddia edebilir. Diğer LLM yorumlanabilirlik araçları, DeepMind’s gibi ticari API’lere daha az bağımlıdır. Tracrprogramları sinir ağı modellerine çeviren bir derleyici.

Wu, durumun böyle olmadığını – aracın GPT-4’ü kullanmasının yalnızca “tesadüfi” olduğunu ve tam tersine, GPT-4’ün bu alandaki zayıflıklarını gösterdiğini söyledi. Ayrıca ticari uygulamalar göz önünde bulundurularak oluşturulmadığını ve teorik olarak GPT-4’ün yanı sıra LLM’leri kullanmak için uyarlanabileceğini söyledi.

Araç, LLM’deki katmanlar arasında etkinleşen nöronları tanımlar.

Wu, “Açıklamaların çoğu oldukça düşük puan alıyor veya gerçek nöronun davranışlarının çoğunu açıklamıyor” dedi. “Örneğin, nöronların çoğu, neler olup bittiğini anlamanın çok zor olduğu bir şekilde aktiftir – sanki beş veya altı farklı şey üzerinde aktif hale gelirler, ancak fark edilebilir bir model yoktur. Bazen orada dır-dir fark edilebilir bir model, ancak GPT-4 onu bulamıyor.”

Bu, daha karmaşık, daha yeni ve daha büyük modellerden veya bilgi için web’de gezinebilen modellerden bahsetmek anlamına gelmez. Ancak bu ikinci noktada Wu, web’de gezinmenin aracın altında yatan mekanizmaları pek değiştirmeyeceğine inanıyor. Nöronların neden belirli arama motoru sorguları yapmaya veya belirli web sitelerine erişmeye karar verdiğini anlamak için basitçe ayarlanabileceğini söylüyor.

Wu, “Bunun, başkalarının geliştirebileceği ve katkıda bulunabileceği otomatik bir şekilde yorumlanabilirliği ele almak için umut verici bir yol açacağını umuyoruz” dedi. “Sadece nöronların neye tepki verdiğine değil, genel olarak bu modellerin davranışlarına, ne tür devreleri hesapladıklarına ve belirli nöronların diğer nöronları nasıl etkilediğine dair gerçekten iyi açıklamalarımız olmasını umuyoruz.”