Oldukça kısa hikaye Nvidia’nın Çin’deki yüksek performanslı bilgi işlem donanımına yönelik yoğun talep, Nvidia’nın Çin pazarı için yapılmış gizemli A800 bilgi işlem GPU’sunun performansını ortaya çıkardı. MyDrivers’a göre A800, A100 GPU’ların %70 hızında çalışırken, Nvidia’nın ne kadar işlem gücü satabileceğini sınırlayan katı ABD ihracat standartlarına uyuyor.

Şu anda üç yaşında olan Nvidia’nın A100’ü oldukça başarılı: HPC için 9,7 FP64/19,5 FP64 Tensor TFLOPS ve yapay zeka iş yükleri için 624 adede kadar BF16/FP16 TFLOPS (seyreklik ile) sunuyor. Yaklaşık %30 oranında azaltılsa bile, bu rakamlar yine de müthiş görünecek: 6,8 FP64/13,7 FP64 Tensor TFLOPS ve ayrıca 437 BF16/FP16 (seyrek).

MyDrivers’ın belirttiği gibi “hadım etme”ye (performans sınırları) rağmen, Nvidia’nın A800’ü, bilgi işlem yetenekleri açısından tamamen gelişmiş Çin merkezli Biren’in BR104 ve BR100 hesaplama GPU’larına karşı oldukça rakip. Bu arada, Nvidia’nın bilgi işlem GPU’ları ve CUDA mimarisi, müşterileri tarafından çalıştırılan uygulamalar tarafından büyük ölçüde desteklenirken, Biren’in işlemcilerinin henüz benimsenmesi gerekiyor. Ve Biren bile en son düzenlemeler nedeniyle tam teşekküllü bilgi işlem GPU’larını Çin’e gönderemiyor.

| Satır 0 – Hücre 0 | Biren BR104 | Nvidia A800 | Nvidia A100 | Nvidia H100 |

| Form faktörü | FHFL Kartı | FHFL Kartı (?) | SXM4 | SXM5 |

| Transistör Sayısı | ? | 54,2 milyar | 54,2 milyar | 80 milyar |

| düğüm | N7 | N7 | N7 | 4N |

| Güç | 300W | ? | 400W | 700W |

| FP32 TFLOPS | 128 | 13.7 (?) | 19.5 | 60 |

| TF32+ TFLOPS | 256 | ? | ? | ? |

| TF32 TFLOPS | ? | 109/218* (?) | 156/312* | 500/1000* |

| FP16 TFLOPS | ? | 56 (?) | 78 | 120 |

| FP16 TFLOPS Tensörü | ? | 218/437* | 312/624* | 1000/2000* |

| BF16 TFLOPS | 512 | 27 | 39 | 120 |

| BF16 TFLOPS Tensörü | ? | 218/437* | 312/624* | 1000/2000* |

| INT8 | 1024 | ? | ? | ? |

| INT8 TFLOPS Tensörü | ? | 437/874* | 624/1248* | 2000/4000* |

* Seyreklik ile

Amerika Birleşik Devletleri tarafından Ekim 2021’de uygulanan ihracat kuralları, 41.600 fit küp (1.178 metreküp) veya daha az bir alanda 100 FP64 PetaFLOPS veya 200 FP32 PetaFLOPS’u aşan süper bilgisayarlara izin veren Amerikan teknolojilerinin Çin’e ihraç edilmesini yasaklıyor. İhracat sınırlamaları, Çin merkezli bir varlığa satılan her bir bilgi işlem GPU’sunun performansını özel olarak sınırlamamakla birlikte, aktarım hızlarına ve ölçeklenebilirliklerine sınırlar koyar.

Yeni kuralların yürürlüğe girmesinden sonra Nvidia, ultra üst düzey A100 ve H100 bilgi işlem GPU’larını, alınması zor olan bir ihracat lisansı olmadan Çin’deki müşterilere satma yeteneğini kaybetti. Çinli hiper ölçekleyicilerin gerektirdiği performans talebini karşılamak amacıyla şirket, A100 GPU’sunun A800 olarak adlandırılan küçültülmüş bir sürümünü piyasaya sürdü. Şimdiye kadar, bu GPU’nun ne kadar yetenekli olduğu net değildi.

Yapay zekanın hem tüketiciler hem de işletmeler arasında kullanımı arttıkça, uygun iş yüklerini kaldırabilen yüksek performanslı donanımların popülaritesi de artıyor. Nvidia, AI mega trendinden en çok faydalananlar arasında yer alıyor, bu nedenle GPU’ları o kadar yüksek talep görüyor ki, küçültülmüş A800 bile Çin’de tükendi.

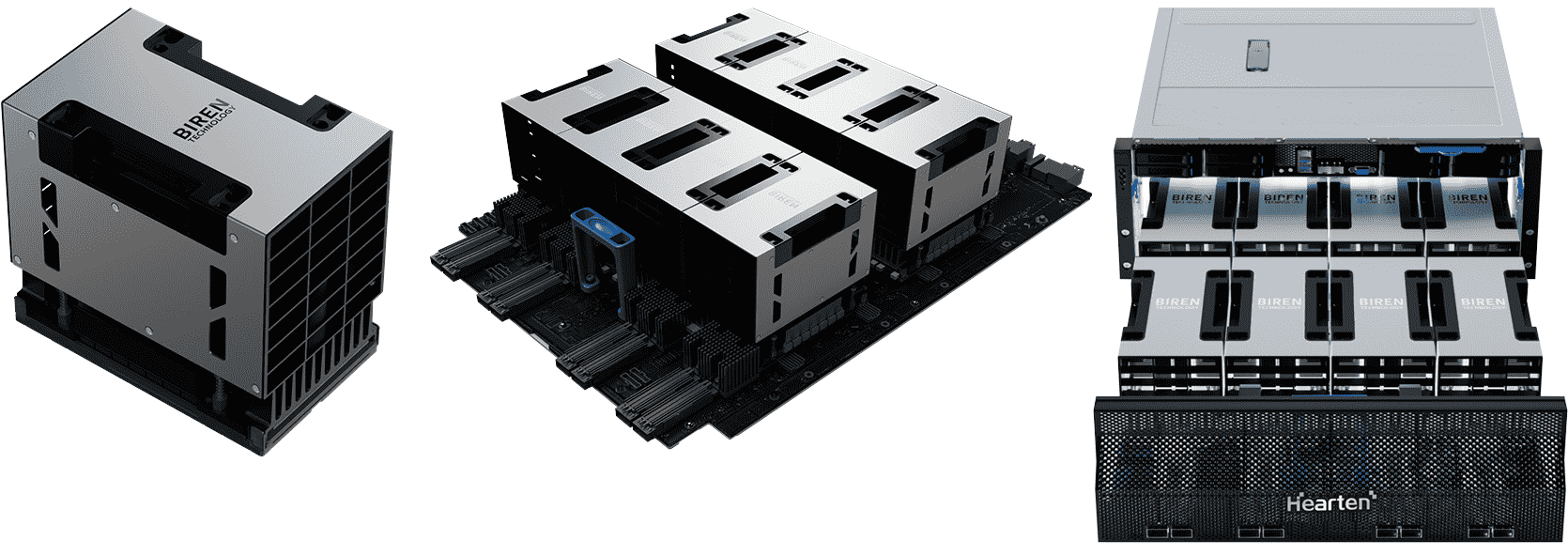

Biren’in BR100’ü OAM form faktöründe sunulacak ve 550W’a kadar güç tüketecek. Çip, şirketin sistem başına sekiz adede kadar BR100 GPU kurulumuna izin veren tescilli 8 yollu BLink teknolojisini destekler. Buna karşılık, 300W BR104, bir FHFL çift geniş PCIe kart form faktöründe gönderilecek ve 3 yollu çoklu GPU yapılandırmasını destekleyecektir. Her iki yonga da, hızlandırıcılar için üstte CXL protokolü bulunan bir PCIe 5.0 x16 arabirimi kullanıyor, raporlar EETrend (aracılığıyla VideoCardz).

Biren, her iki yongasının da TSMC’nin 7nm sınıfı fabrikasyon süreci kullanılarak yapıldığını söylüyor (N7, N7+ veya N7P kullanıp kullanmadığını ayrıntılandırmadan). Daha büyük olan BR100, yine TSMC’nin N7 düğümlerinden biri kullanılarak yapılan Nvidia A100 ile 54,2 milyardan daha ağır basan 77 milyar transistörü bir araya getiriyor. Şirket ayrıca, TSMC’nin ağ boyutunun getirdiği sınırlamaların üstesinden gelmek için yonga tasarımını ve dökümhanenin CoWoS 2.5D teknolojisini kullanması gerektiğini söylüyor; bu, Nvidia’nın A100’ü bir ağ boyutuna yaklaştığı ve BR100’ün eşit olması gerektiği için tamamen mantıklı. daha yüksek transistör sayısı göz önüne alındığında daha büyük.

Spesifikasyonlar göz önüne alındığında, geliştirici bunu resmi olarak onaylamasa da, BR100’ün temelde iki BR104 kullandığını tahmin edebiliriz.

Biren, BR100 OAM hızlandırıcısını ticarileştirmek için Inspur ile 2022’nin 4. çeyreğinden itibaren örnekleme yapacak 8 yollu bir yapay zeka sunucusu üzerinde çalıştı. Baidu ve China Mobile, Biren’in bilgi işlem GPU’larını kullanan ilk müşteriler arasında olacak.